LRN(Local Response Normalization)

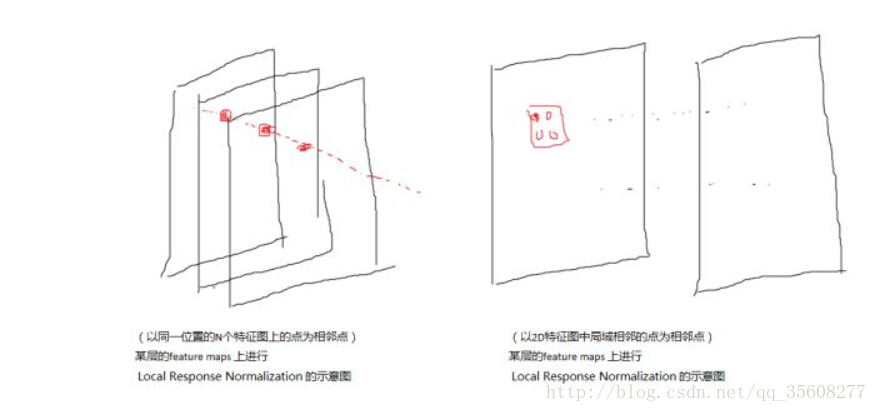

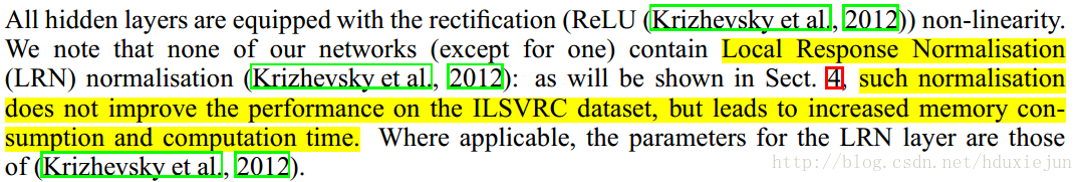

作用:将不同卷积核RELU后的feature归一化,平滑处理,能增加泛化能力。

原因:生物方面,玄学

Alexnet提出

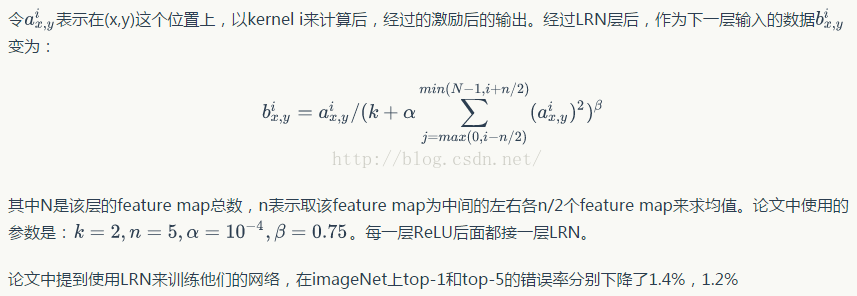

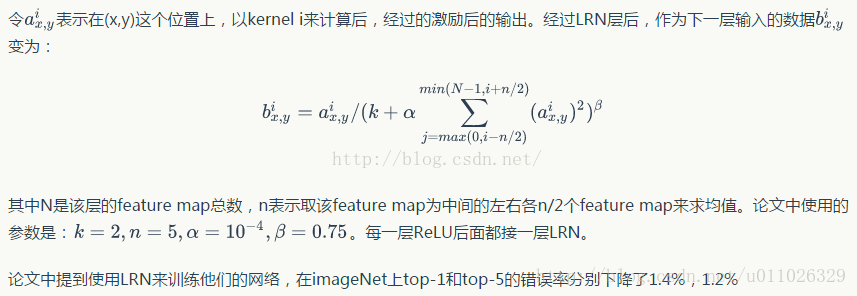

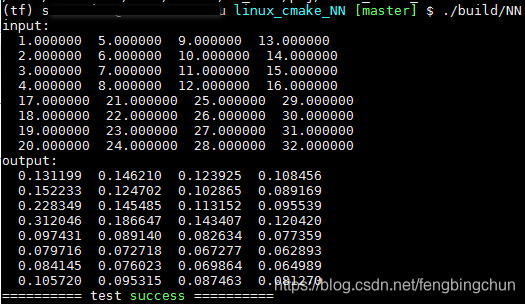

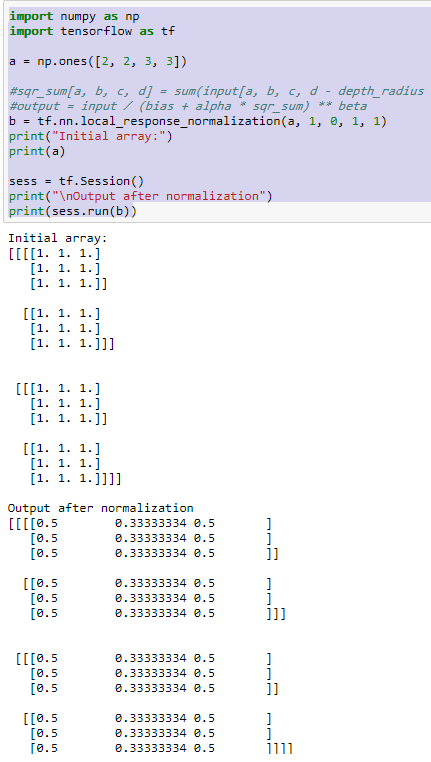

公式:

其中i代表第i个卷积核

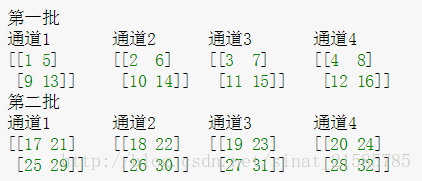

a x , y i , 表 示 第 i 个 卷 积 核 在 x , y 处 的 R E L U 后 结 果 n 表 示 规 范 化 范 围 k , α , β , n 为 超 参 数 , 一 组 取 值 为 2 , 10 e − 4 , 0.75 a^{i}_{x,y},表示第i个卷积核在x,y处的RELU后结果 n 表示规范化范围 k,\alpha,\beta,n为超参数,一组取值为2,10e-4,0.75 ax,yi,表示第i个卷积核在x,y处的RELU后结果n表示规范化范围k,α,β,n为超参数,一组取值为2,10e−4,0.75

后来实验发现,LRN层似乎没什么用-_-