最近,OpenAI推出的ChatGPT火了。

60天月活破亿,迅速狂飙出圈。ChatGPT不仅刷爆了星尘君的朋友圈,也炸醒了国内外的科技圈、创投圈。

有人说ChatGPT相当于AI版瓦特蒸汽机,有人说ChatGPT让我们看到AI的未来,连微软联合创始人比尔·盖茨都说,ChatGPT的意义不亚于计算机和互联网的诞生,英伟达CEO黄仁勋更盛赞其诞生堪比iPhone问世。

在国外,微软宣布将向OpenAI追加数十亿美元投资,旗下产品将全线整合ChatGPT;谷歌紧急推出Bard对标ChatGPT;苹果、亚马逊、Meta等海外科技巨头纷纷透露将积极布局AIGC、ChatGPT相关技术。

在国内,百度、阿里、腾讯、京东、网易、360、科大讯飞等相继官宣要做中文版ChatGPT;就连已退休三年的美团网创始人王慧文也在朋友圈官宣携5000万美元入坑......

ChatGPT是由OpenAI训练的一个大型语言模型,它使用了深度学习算法中的Transformer模型,通过对数十亿个语言文本进行学习,可以与人类进行自然对话,并尽可能准确地回答用户的问题。作为突破性的AIGC(人工智能生成内容)技术,ChatGPT为AI 行业带来了全新的想象力,由它引爆的“全球AI大战”火速拉开帷幕。

一、抢占先机,大模型是必由之路

值得注意的是,追赶ChatGPT的大厂,都在提及"大模型"。

百度文心一言将基于文心大模型推出;谷歌“Bard”由大模型LaMDA提供支持;360称自家布局ChatGPT类产品的优势在于数据和语料,在预训练大模型方面还存在短板。

出门问问CEO李志飞则表示,「2023年是AI大模型时代元年,此波变幅堪比2010年左右开始的移动互联网,听到最多的词是all in,许多人跃跃欲试要搞中国版的OpenAI/ChatGPT。如果把这个比作一场运动竞赛,那2023年Q1是报名阶段,目前的报名费是5000万美金起。」

可见,想要追上ChatGPT,离不开大模型。

但事实上,大模型并不是什么新鲜事物。

以下是「NLP领域大模型发展历程和重要突破」:

2017年,Google提出了Transformer架构,为大型模型奠定了基础。

2018年,Google推出基于Transformer架构的大型语言模型——BERT,成为当时最先进的自然语言处理模型。

2019年,OpenAI发布了语言模型GPT-2,该模型是一个大型的生成模型,能够自动生成高质量的文本,并且能够在多个NLP任务上实现零样本学习。

2020年,OpenAI发布了语言模型GPT-3,该模型是迄今为止最大的自然语言处理模型,拥有1750亿个参数。

2022年底,OpenAI发布基于GPT-3.5训练而成的ChatGPT,引发行业关注。

2017年,谷歌提出的Transformer架构为大语言模型发展奠定了基础,大模型由来已久。

很多人会有疑问,既然ChatGPT的核心架构Transformer最初是由谷歌提出的,并且谷歌在大模型技术上的积累可以说不弱于OpenAI,他们也不缺算力和数据,为什么会被ChatGPT打的措手不及呢?

这就必须来说说在算法和算力都是现成的情况下,ChatGPT在数据和反馈策略上的精妙之处。

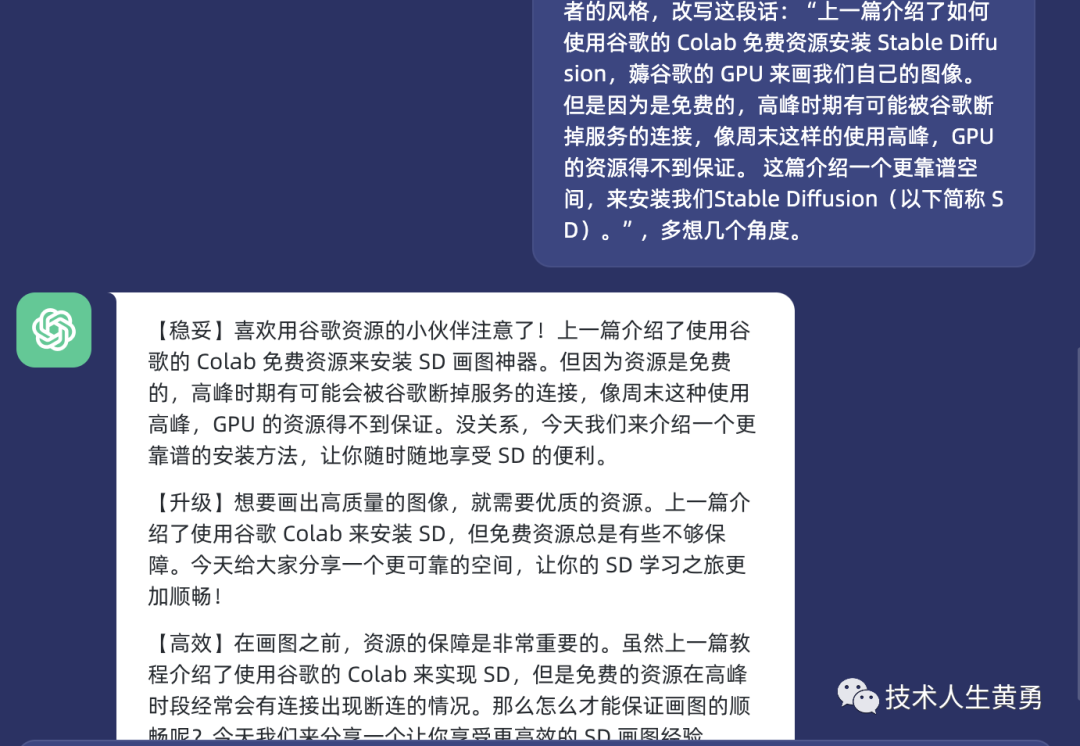

二、RLHF基于人类反馈的强化学习,ChatGPT大力出奇迹

对于大模型训练来说,数据是其根本。但是想要训练一个类似ChatGPT的大模型,有足够的数据还不够,还需要有效的数据标注策略。

因为大规模的数据集早已存在,但是随着数据量的增加,杂讯也会增多,提取有效数据内容和知识的难度也呈指数级增加,对技术团队的数据工程化实现能力要求非常高,训练成本也极高。

如何降低数据成本,使用有效的数据策略引入人类反馈,形成数据和模型的反馈闭环,从而保证大模型不输出有害内容,并输出有用、符合人类偏好的内容,是大语言模型训练的重中之重。

ChatGPT能够突破难点大力出奇迹的核心就在于:Open AI在ChatGPT训练过程中设计了一套精巧的数据反馈链路策略——Reinforcement Learning with Human Feedback (RLHF,基于人类反馈的强化学习)。

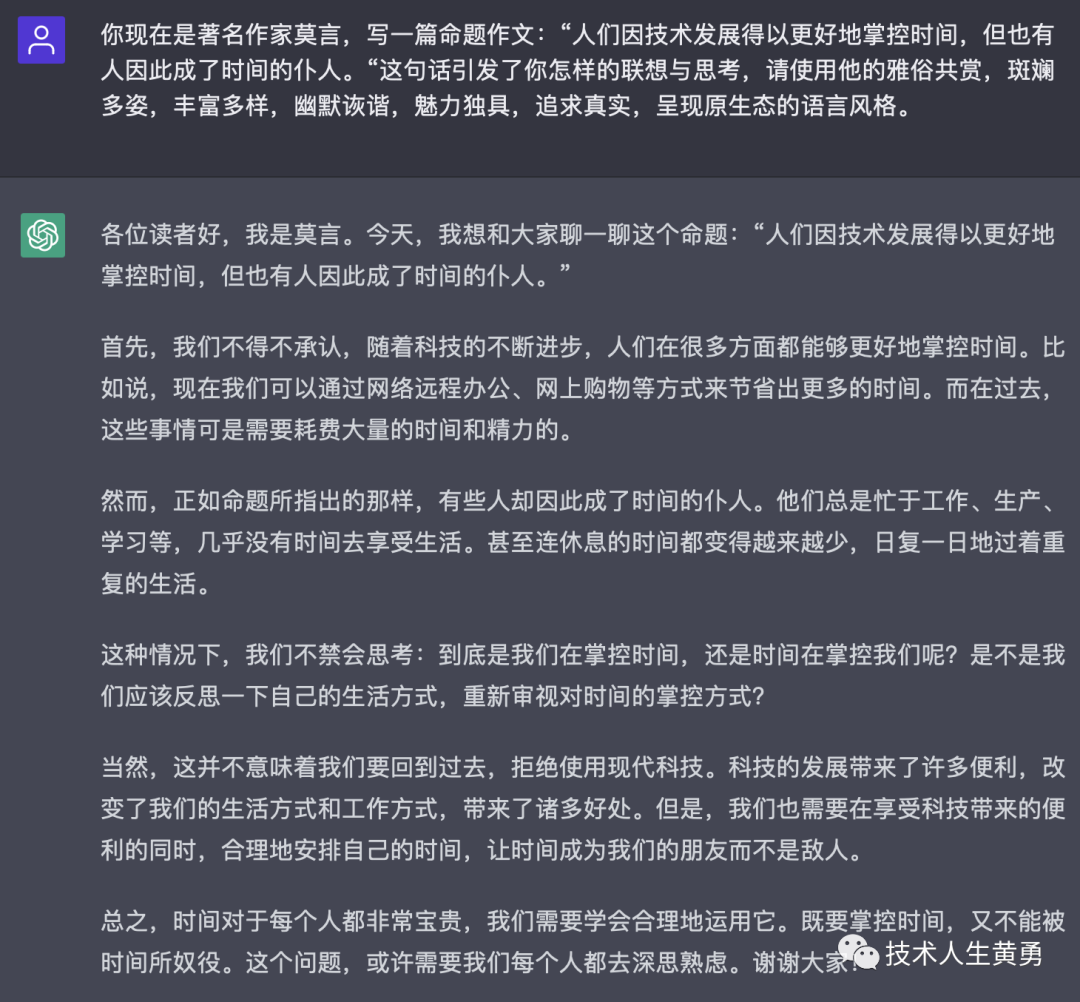

图:RLHF基于人类反馈的强化学习基本原理

ChatGPT由GPT-3.5系列大型语音模型微调而成,通过RLHF基于人类反馈的强化学习,ChatGPT可以在人的动态反馈和指导下生成内容,因此具备了堪称“上知天文、下知地理”的能力,可以进行多轮对话、精准问答,生成编程代码、电子邮件、论文、小说。

可以这样理解,此前的大模型是在海量数据上自由奔跑,因为见识多,所以能预测,但会乱说话,有风险。RLHF数据反馈策略的加入,让ChatGPT在“自由奔跑”的基础上,用少量数据学会了遵循人的指令,揣摩人的喜好,不乱说话,说有用的话。

下面我们来看看RLHF数据反馈策略是如何实现的:

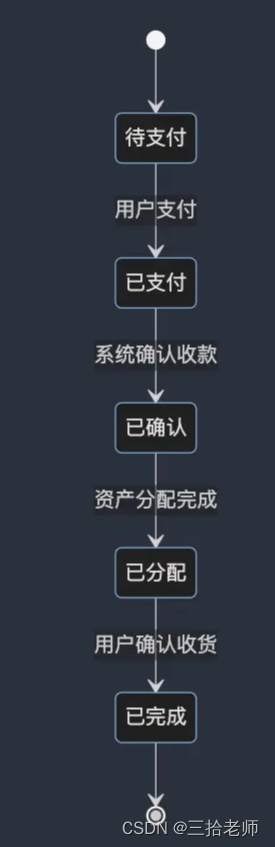

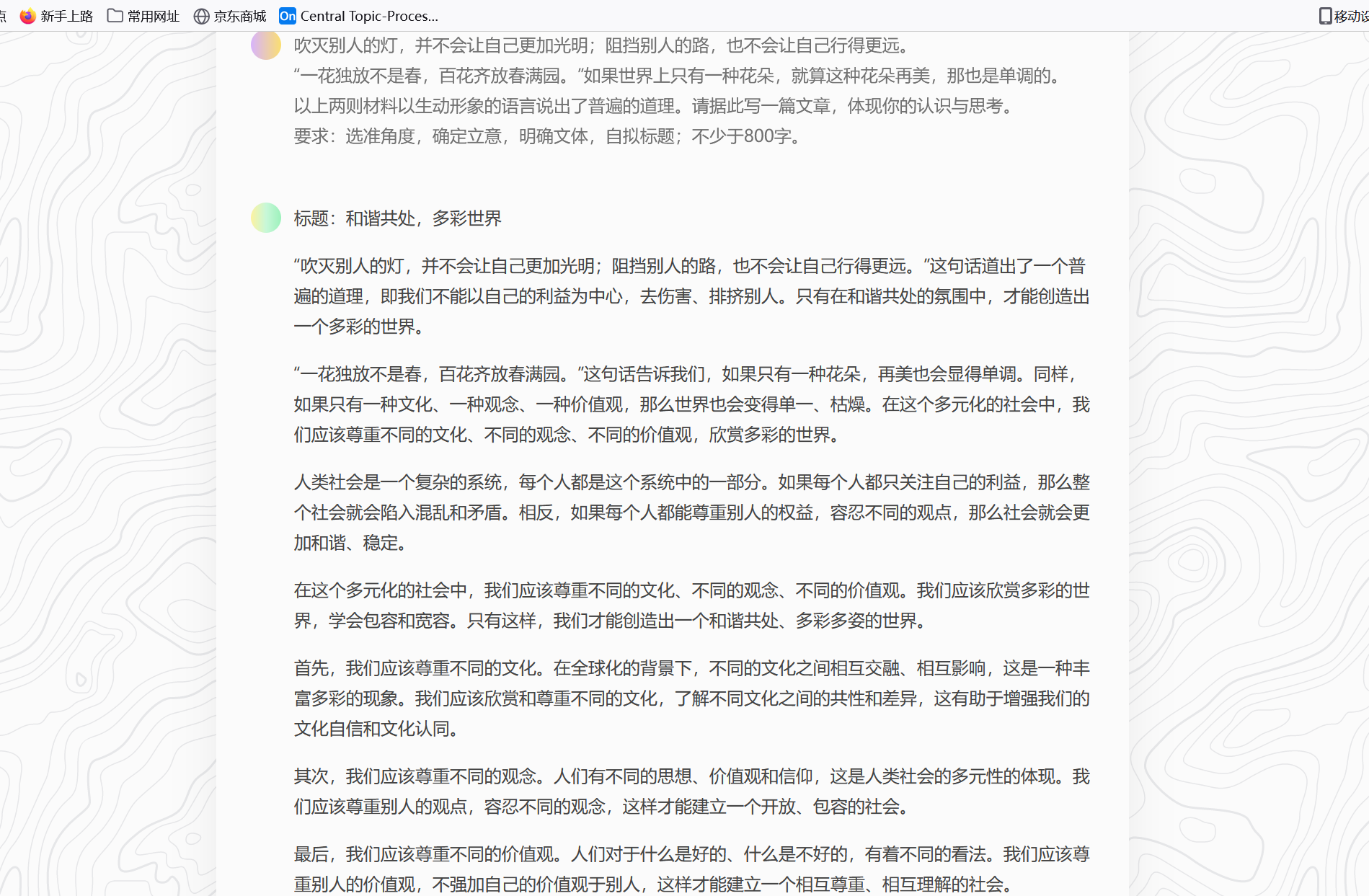

ChatGPT的训练分为四步:

(图片来源:OpenAI官网)

1、预训练(自监督学习):预备一个GPT-3.5模型

可以理解为预备一个在海量数据基础上自由奔跑过的模型,它具备了随机生成内容的能力,但生成的内容可能有毒有害,人类无法控制,所以需要强大的反馈策略来有效辅助。

2、微调(有监督学习):人类撰写少量的典型问题和标准答案形成标准语料库,微调GPT-3.5模型

这一步,相当于人类老师为GPT-3.5模型提供了一本标准习题册,学习了这本习题册后,GPT-3.5初步学习了如何输出人类期望的回答,说的话还不一定符合标准答案,此时模型根据「问答对」进行了微调。这一步最关键的是使用的「问答对」足够全面、精确,能够涵盖方方面面的基础问答,起到类似百科全书一样的地基作用,让无监督的模型迅速在监督反馈下有效的进行问题的回答。

3、人类反馈——用人类老师的打分结果训练一个反馈模型

在这一步,微调后的GPT-3.5输出多个答案后,人类老师将对答案进行价值排序,用强化学习训练一个全新的反馈模型。这时,人工反馈策略的加入,成为OpenAI在数据反馈策略上的重要创新,仅需要少量反馈数据就能显著提升模型的输出结果。这一步最重要的是需要一套数据闭环系统,能够将人类反馈接入大模型,并将人类反馈和大模型接入同一个平台,形成人类反馈+模型迭代的数据闭环。

4、RLHF(基于人类反馈的强化学习)——用反馈模型对微调后的GPT-3.5进行强化学习

最后,人类反馈形成的反馈模型代替人类老师继续为GPT-3.5的输出结果打分,并不断对它进行强化学习,形成最终的ChatGPT。这一步RLHF基于人类反馈的强化学习数据策略设计,直接让ChatGPT在算力和算法现成的基础上,形成了模型和数据的动态反馈闭环,带来惊艳的效果。

有业内人士指出,这种超大规模训练,并不依靠算法本身,硬件和数据才是王道,纯自然语言数据,网上公开的到处都是,也没有什么门槛,但是ChatGPT有一个巨大的先发优势,就是它通过抢先开始公测,收集了大量的用户的使用数据,这是更加宝贵的数据,而这部分数据只有他们家有。

其实,这套精妙的数据反馈策略在此前的InstructGPT(https://arxiv.org/pdf/2203.02155.pdf)中已经披露,ChatGPT采用的是和InstructGPT相同的数据策略。

过去,由Transformer带来了一次深度学习的范式转变,BERT类模型实现了从纯粹监督学习,转向了“预训练+微调”的范式。而今天ChatGPT的成功,带给我们的启示是,一个好的模型,需要经历:

“预训练”来学习广泛知识

“微调”来保证合理的输出方式

“强化学习”来保证有效的人类反馈能进一步提高模型效果

业内普遍认为,RLHF基于人类反馈的强化学习引入,带来了NLP乃至AI领域研究范式的转换。这种新的范式,有可能成为第三阶段人工智能的核心驱动技术,即基于自监督预训练的大模型,再结合基于人类反馈强化学习的数据标注策略,形成模型和数据的闭环反馈,获得进一步的技术突破。

由此可见,GPT这个大模型之所以知识渊博,是因为摄入了数以亿计的语料库内容;而ChatGPT之所以“聪明”,是通过精妙的数据策略,加入了人类老师的指导。而这背后离不开大量的数据标注。如果缺乏有效的数据反馈,各大厂商想要训练一个类似ChatGPT的大语言模型也只是纸上谈兵。星尘数据在数据增强、数据反馈策略、数据闭环产品方面正好有着很多的积累。

三、星尘数据推出国内首个基于RLHF交互式数据标注业务,助力ChatGPT中国赛开卷

2023年1月,星尘数据正式对外发布了基于人类反馈的强化学习标注服务(Human Feedback as a Service)。星尘数据的闭环数据策略已应用于众多实验室项目,达到国际领先水平。同样的标注成本下,星尘的RLHF人类反馈强化学习闭环数据策略,可以帮助客户得到更多的有效数据,并动态反馈给客户的大语言模型。

星尘数据CEO章磊指出,有效的大模型=算法策略+数据策略+人类反馈(标注)。作为国内首家提供数据策略专家服务的数据标注公司,星尘将为中文ChatGPT的研发和数据策略制定提供最强辅助。

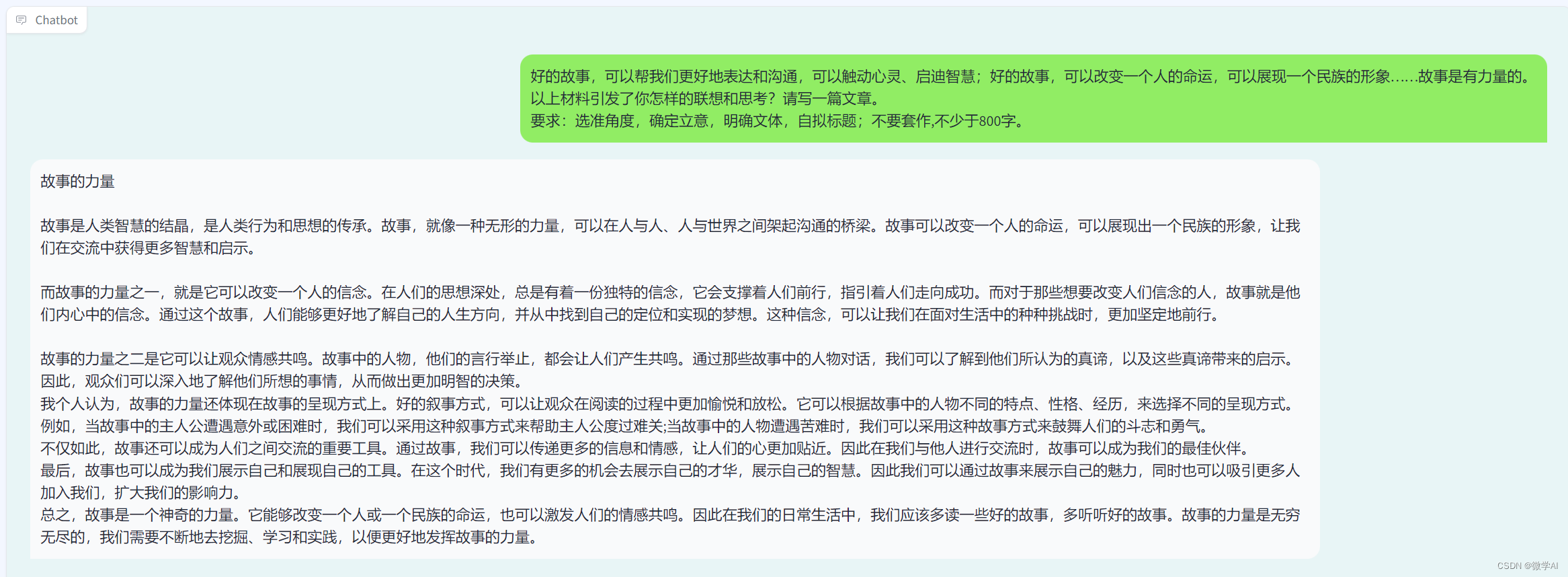

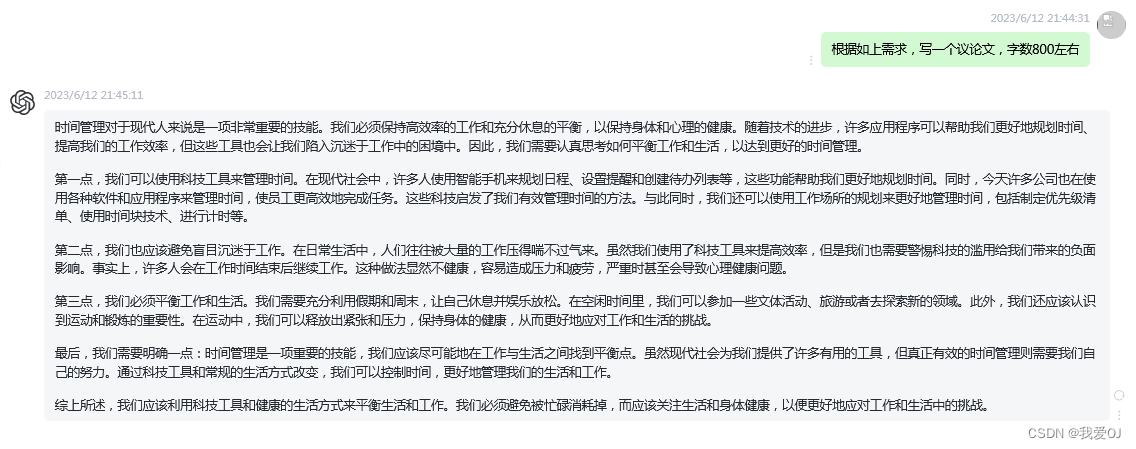

图:星尘数据Rosetta平台交互式数据标注服务(HFS)

通过星尘的Rosetta3.0数据标注系统,客户可以快速将语言模型接入系统,并实时将结果通过API显示在标注平台上,星尘专属基地的NLP标注员可以快速给出反馈。奖励强化模型实时接收到反馈并进行训练,可以实现模型的高效训练并及时发现难例和缺陷。

为什么星尘能够成为国内首家提供基于人类反馈的强化学习标注服务(HFS)的公司呢?

其实在ChatGPT大火之前,国内外就有多家实验室进行了深入的人机互动方向研究。星尘在服务这些前沿科研需求的同时,也积累了大量的强化学习、人机互动、语言文本方面的经验和服务能力。

斯坦福视觉实验室:人类交互行为和意图识别,星尘通过对人类和环境的交互行为进行准确标注,协助研究探索了人和环境的交互关系,为机器如何更好地在虚拟空间中给人类指令提供反馈的课题奠定了基础。

国家媒体重点实验室:星尘和国家媒体实验室共同完成了多项语言语义方面的科研项目,在人机问答(QA)、语义推理(NLI)、文本摘要(Summarization)、语义检错(Gramma Correction)、情感分析(Sentiment Analysis)、语义关系挖掘(Relation Extraction)等方面均通过星尘专业的数据策略经验和数据标注服务,极大提高了模型在基准测试中的得分。

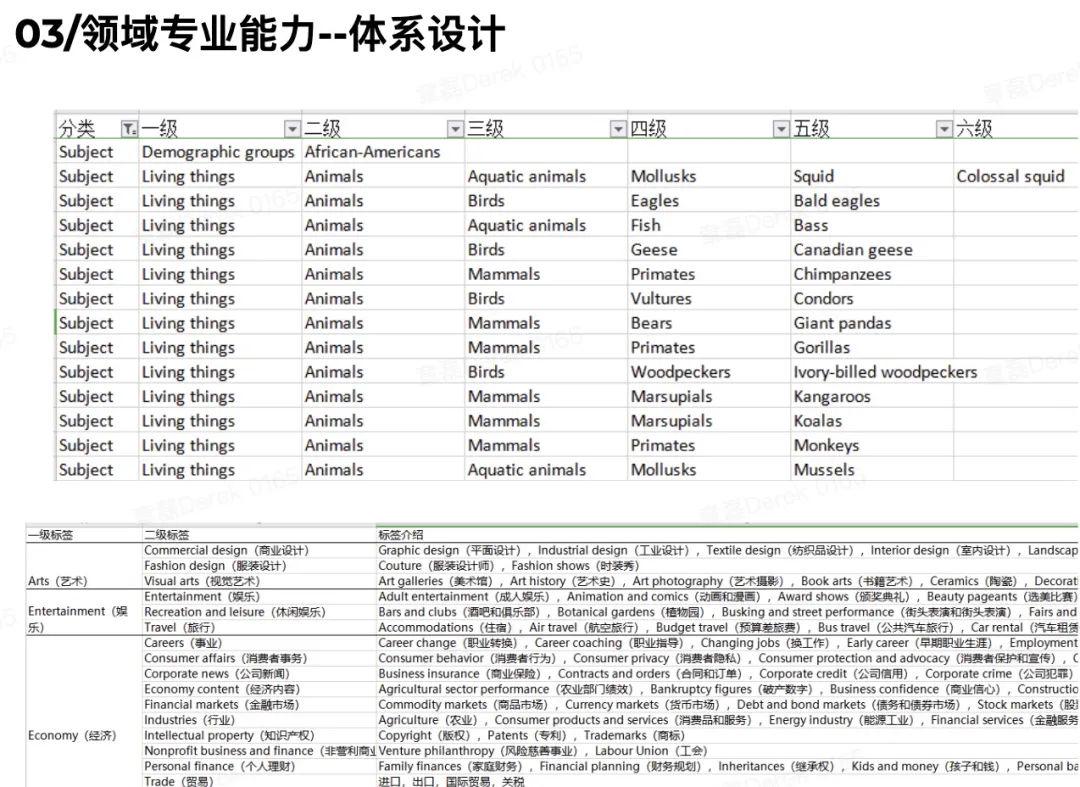

科研院所:星尘还和国内外多家科研院所共同合作,在前沿人机交互和语义理解方向进行了深入探索。在合作中,星尘数据的数据策略专家和学者就语言模型、知识图谱、领域问答等方向共同进行研究。星尘通过提供数据标注的体系设计、反馈闭环工程化实现、训练实验反馈等工作让学术研究可以更快得到结果,模型训练在相同数据成本下可以更快收敛达到预期效果。

值得一提的是,在科研工作中星尘也参与到研究所的文献paper撰写和消融实验中,通过数据增强的方式,让联合研发的算法在国际NLP顶会的workshop中以第一名的成绩脱颖而出。

四、结语

可以预见,未来几年的AI大模型竞争将非常激烈,还未入局的玩家,或将面临淘汰。我们期待中国版ChatGPT的诞生,也将助力AI大模型的快速落地和应用。

ChatGPT等通用语言大模型一直被理解为“三高”,即“算力要求高”、“数据要求高”、“人才要求高”。实际上,星尘发现通过良好的反馈闭环系统和数据策略设计,仅需要三十分之一的模型大小就可以实现甚至超越GPT-3的1750亿模型参数量的模型效果。

星尘在语言模型和人机交互方面的丰富经验,积累下来的不仅仅是标注高质量数据的能力,更是数据策略的设计能力,以及不断打磨并符合科研需求的一整套数据闭环产品。

在大模型领域,我们不仅仅需要通用语言模型能够解决聊天、问答、信息检索等需求,更会在客服、金融、出行、工业制造、生物医药、农业等垂直领域对大模型有更加明确并可预期的落地效果。希望星尘数据在这方面积累的经验和产品,能够助力客户在各个领域快速打磨出一套够用、好用的交互体验算法,快速建立起行业领先优势。

如果您正在训练类似ChatGPT的大语言模型,需要优质的语料库资源和RLHF基于人类反馈的强化学习数据策略,星尘数据将竭诚为您服务。

*文中部分图片来自网络