LRN(local response norm)局部归一

AlexNet本文出自NIPS2012,作者是大神Alex Krizhevsky,属于多伦多大学Hinton组。当年取得了ImageNet最好成绩,也是在那年之后,更多的更深的神经网路被提出,比如优秀的vgg,GoogleLeNet.

结构比较简单易于理解,可以看论文和文末博客回顾。

在第一二层卷积层中用了LRN。

ReLU 不需要输入归一化解决饱和问题。只要ReLU的输入大于0就可以学习。但是 局部正则模式( local normalization scheme )有利于增加泛化能力。(后期其他网络VGG、GOOGLENET、YOLO等放弃了这个LRN层,认为效果并不显著。)

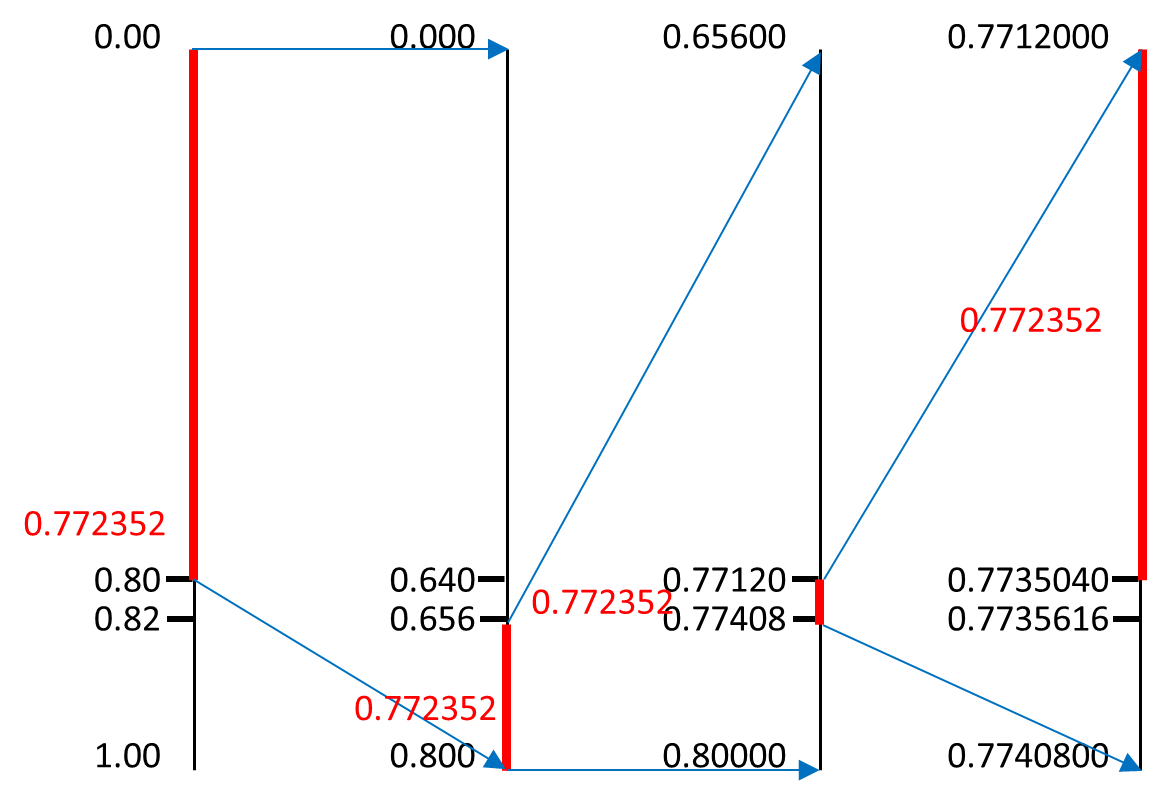

局部归一的动机:在神经生物学有一个概念叫做 侧抑制(lateral inhibitio),指的是 被激活的神经元抑制相邻神经元。归一化(normalization)的目的是“抑制”,

局部响应归一化就是借鉴 侧抑制 的思想来实现局部抑制,使得其中响应大的值变得相对更大(自我感觉类似softmax的比例),并抑制其他较小反馈的神经元,增强了泛化能力(指训练好的模型在未见过的数据上的表现)。

尤其当我们使用ReLU 的时候这种“侧抑制”很管用。因为ReLU的响应结果是无界的(可以非常大)所以需要归一化。

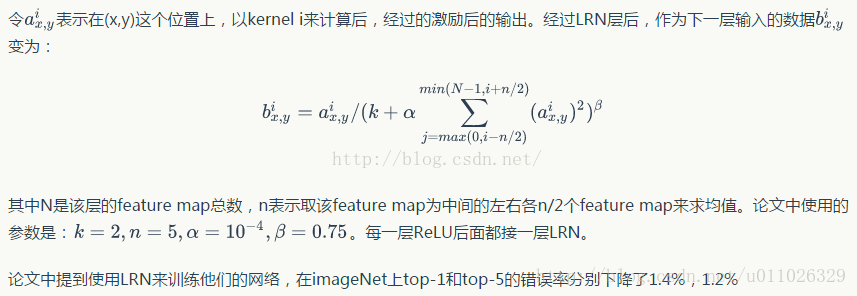

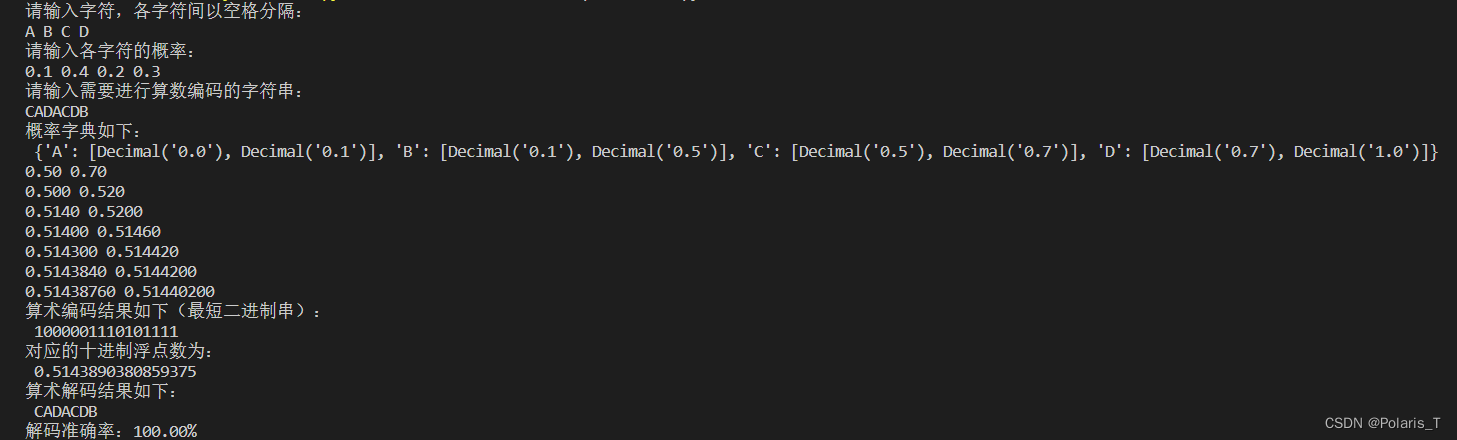

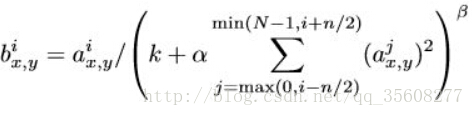

k,n,α,β都是超参数,本文由验证集确定为k=2,n=5,α=10−4,β=0.75。

- a_{x,y}^{i}表示 首先应用第i个核 在位置(x,y) 然后运用ReLU非线性化 再 响应归一化 的神经元输出,

- b_{x,y}^{i} 表示局部响应归一化,

- N是该层中的核的总数,

- 求和是在相同空间位置处第i个核的n个“相邻”核映射上运行。

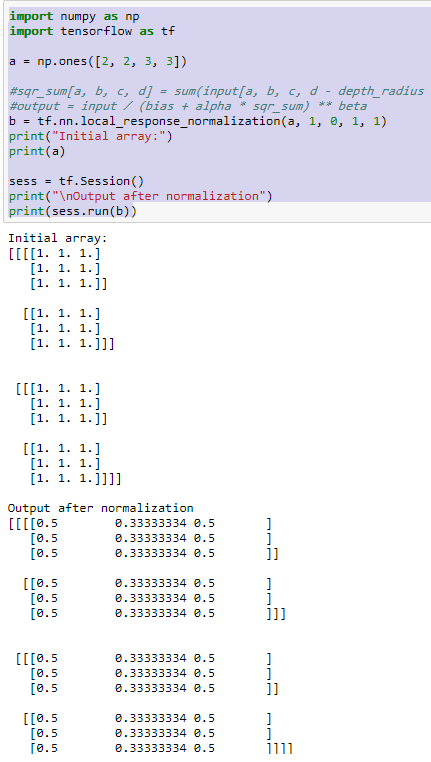

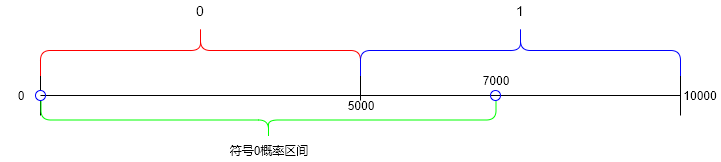

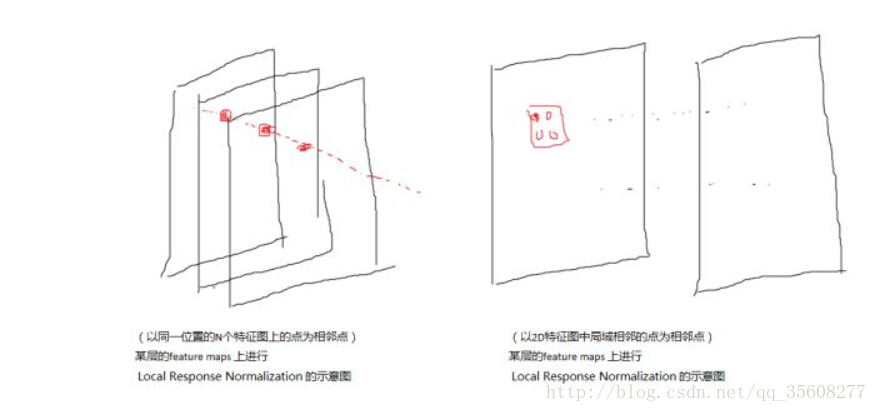

其中LRN又存在两种模式:

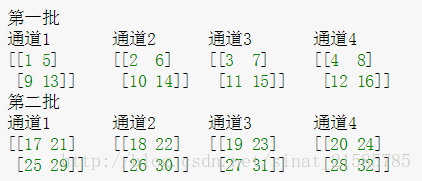

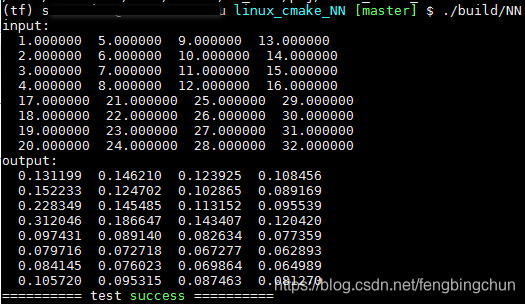

源码默认的是ACROSS_CHANNELS ,跨通道归一化(这里我称之为弱化),local_size:5(默认值),表示局部弱化在相邻五个特征图间中求和并且每一个值除去这个和.

局部归一不改变输入的尺寸

conv2和conv1不同,conv2中使用256个5*5大小的过滤器filter对96*27*27个特征图,进行进一步提取特征,但是处理的方式和conv1不同,过滤器是对96个特征图中的某几个特征图中相应的区域乘以相应的权重,然后加上偏置之后所得到区域进行卷积,比如过滤器中的一个点X11 ,如X11*new_X11,需要和96个特征图中的1,2,7特征图中的X11,new_X11 =1_X_11*1_W_11+2_X_11*2_W_11+7_X_11*7_W_11+Bias,经过这样卷积之后,然后在在加上宽度高度两边都填充2像素,会的到一个新的256个特征图.特征图的大小为:

(【27+2*2 - 5】/1 +1) = 27

Reference

https://prateekvjoshi.com/2016/04/05/what-is-local-response-normalization-in-convolutional-neural-networks/

http://papers.nips.cc/paper/4824-imagenet-classification-with-deep-convolutional-neural-networks.pdf

https://zhuanlan.zhihu.com/p/23511063