原理:

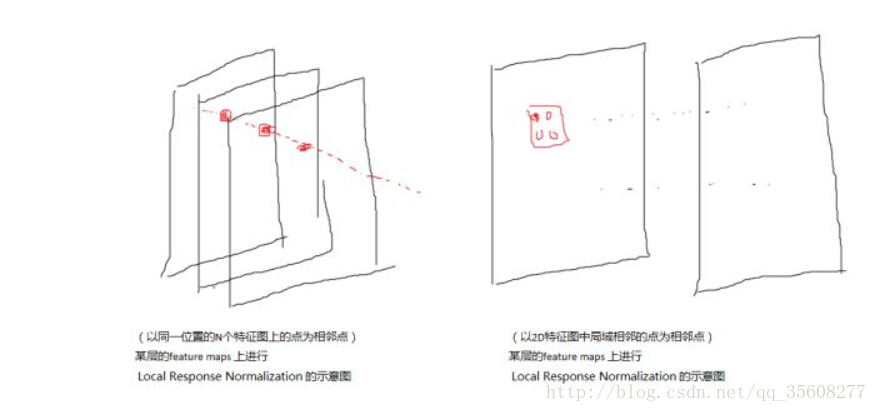

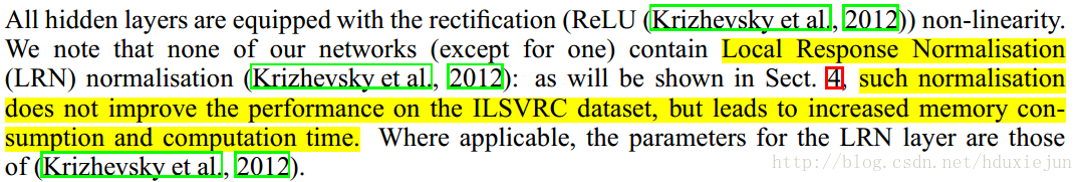

LRN层模仿了生物神经系统的“侧抑制”机制,对局部神经元的活动创建竞争环境,使得其中响应比较大的值变得相对更大,并抑制其他反馈较小的神经元,增强模型的泛化能力。

LRN对于ReLU这种没有上限边界的激活函数会比较有用,因为它会从附近的多个卷积核的响应中挑选比较大的反馈,但不适合Sigmoid之中有固定边界并且能抑制过大值的激活函数。

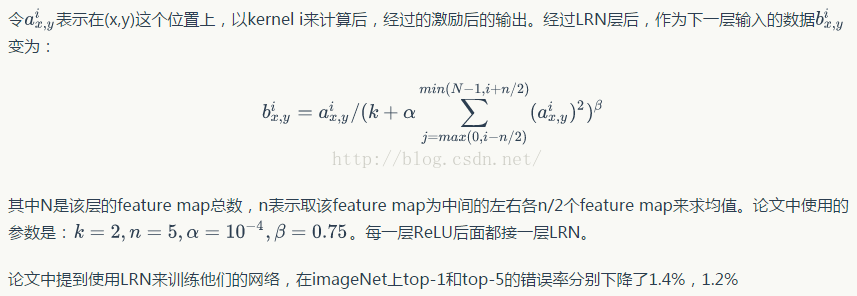

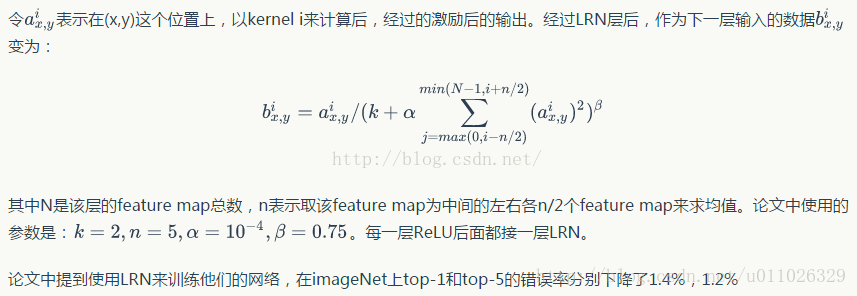

- b x , y i b_{x,y}^i bx,yi是归一化后的值。

- a x , y i a_{x,y}^i ax,yi表示第i个核位置(x,y)运用ReLU非线性化神经元输出。

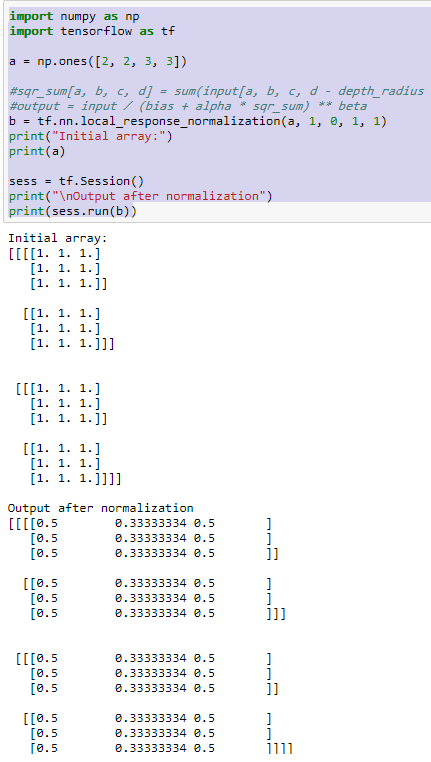

总的来说,上述公式是输入除以一个系数来达到归一化的目的,公式的核心在于该系数的计算,该系数的意义是不同通道(feature

map)的累加平方和。

该层还需要参数:

- n: 临近的feature map 数目,用于表示局部区域的大小,注意,这里的区域指的是一维区域,区别于图像中某像素点的临近像素。

- N:通道(featrure map)总数(这里的通道不是图像的通道,而是指不同的kernal生成的feature map)

- α \alpha α: 缩放因子

- β \beta β:指数项

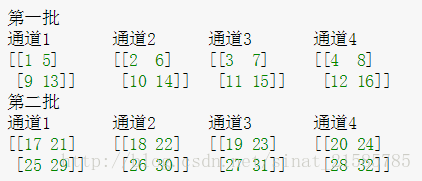

例如:

i i i = 10, N N N= 96, n n n = 4.

当求第10个卷积核在位置x,y处特征为a,那么该处的局部响应为a除以第8,9,10,11,12个卷积核在x,y处特征平方和。