文章目录

- MapReduce 编程实例:词频统计

- 一,准备数据文件

- (1)在虚拟机上创建文本文件

- (2)上传文件到HDFS指定目录

- 二,使用IDEA创建Maven项目

- 三,添加相关依赖

- 四,创建日志属性文件

- (1)在resources目录里创建log4j.properties文件

- (2)log4j.properties文件添加内容

- 五,创建词频统计映射器类

- (1)创建net.army.mr包

- (2)在net.army.mr包下创建WordCountMapper类

- (3)为了更好理解Mapper类的作用,在map()函数里暂时不进行每行文本分词处理,直接利用context输出key和value

- 六,创建词频统计驱动器类

- (1)在net.army.mr包里创建WordCountDriver类

- (2)注意导包

- 七,运行词频统计驱动器类,查看结果

MapReduce 编程实例:词频统计

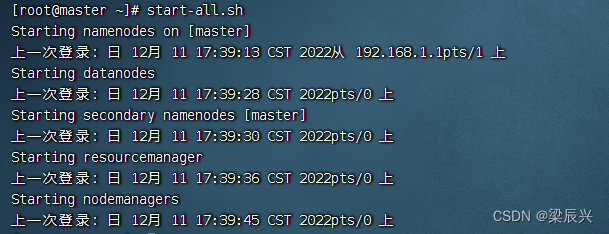

启动hadoop服务,输入命令:start-all.sh

一,准备数据文件

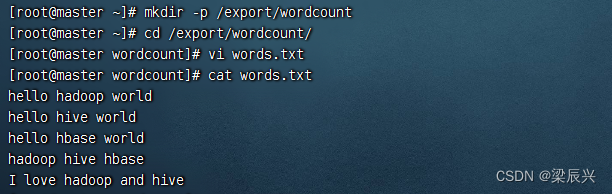

(1)在虚拟机上创建文本文件

在export目录下,创建wordcount目录,在里面创建words.txt文件,向words.txt输入下面内容。

输入内容:

输入内容:

hello hadoop world

hello hive world

hello hbase world

hadoop hive hbase

I love hadoop and hive

(2)上传文件到HDFS指定目录

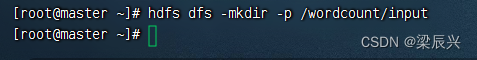

创建/wordcount/input目录,执行命令:hdfs dfs -mkdir -p /wordcount/input

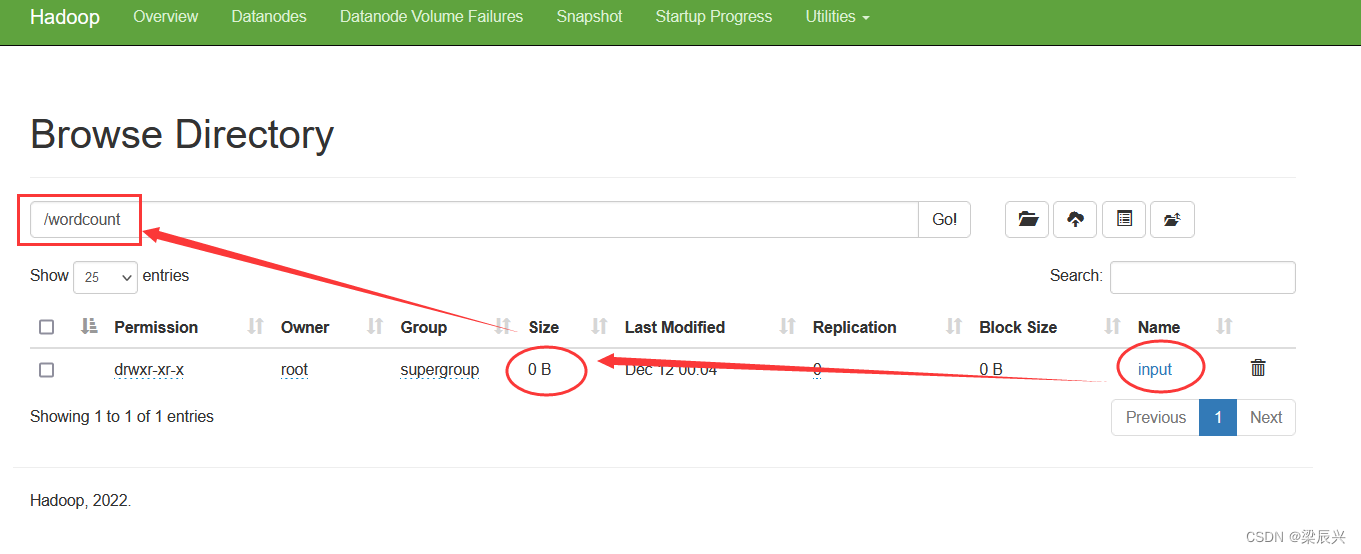

在Hadoop WebUI界面上查看目录是否创建成功

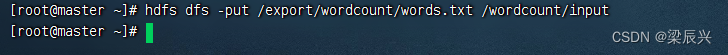

将在本地/export/wordcount/目录下的words.txt文件,上传到HDFS的/wordcount/input目录,输入命令:hdfs dfs -put /export/wordcount/words.txt /wordcount/input

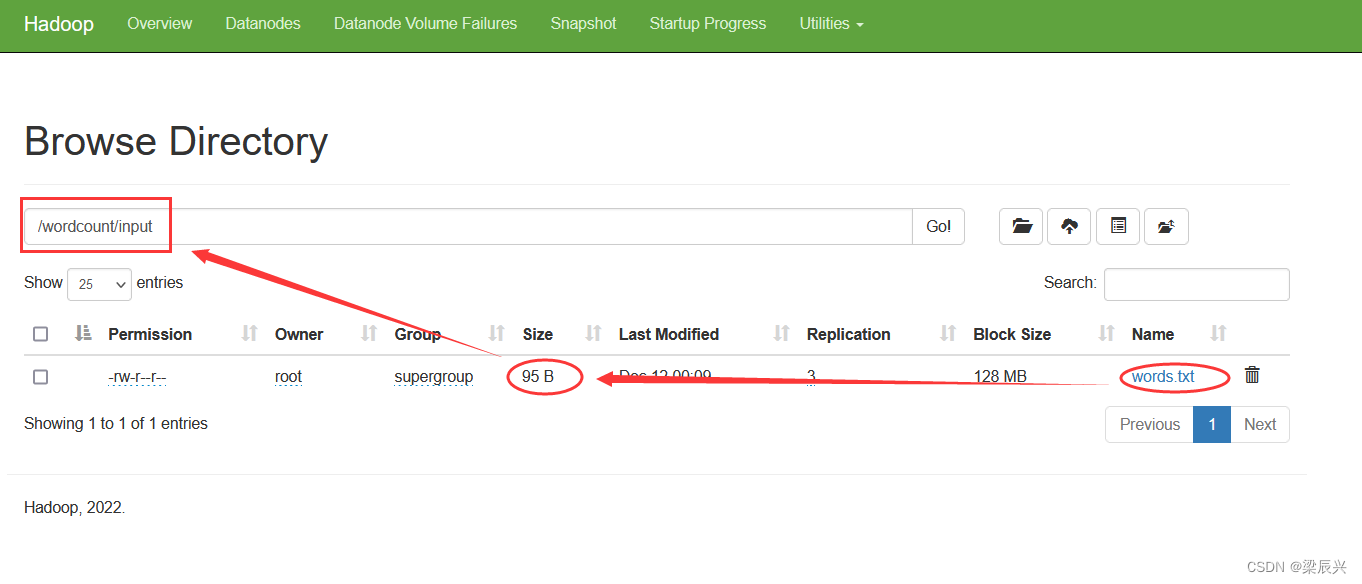

在Hadoop WebUI界面上查看words.txt文件是否上传成功

二,使用IDEA创建Maven项目

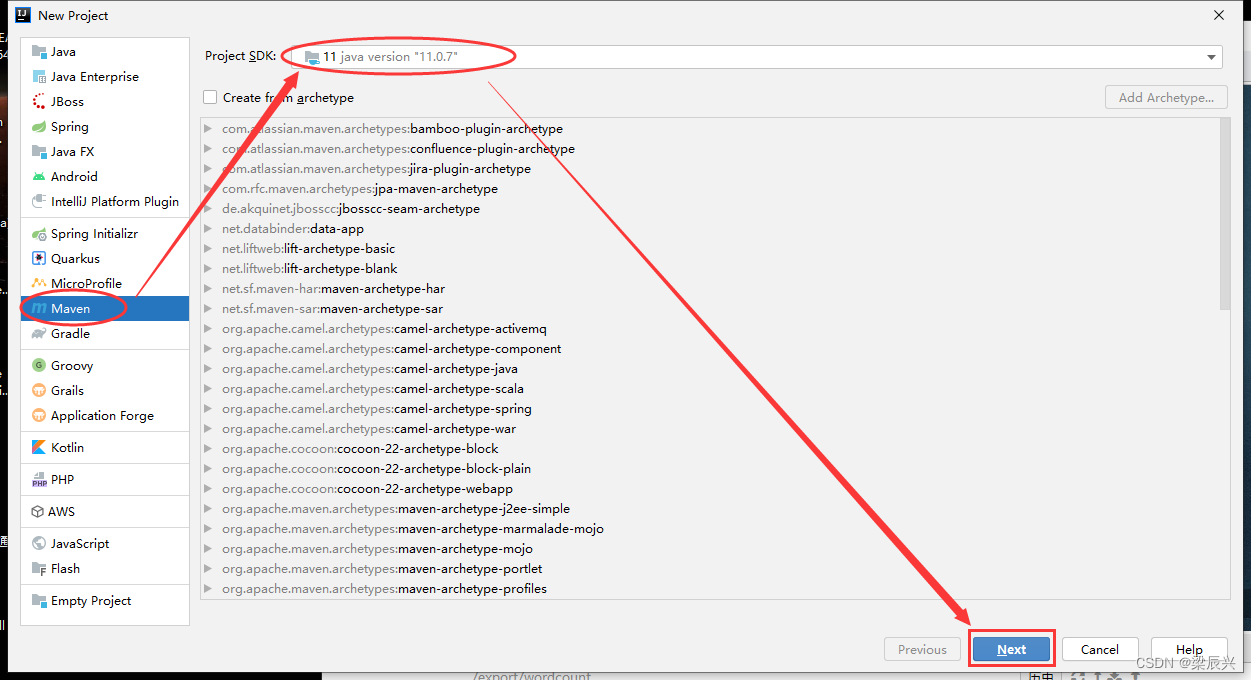

1.选择【Maven】,选择【jdk】版本,单击【Next】按钮

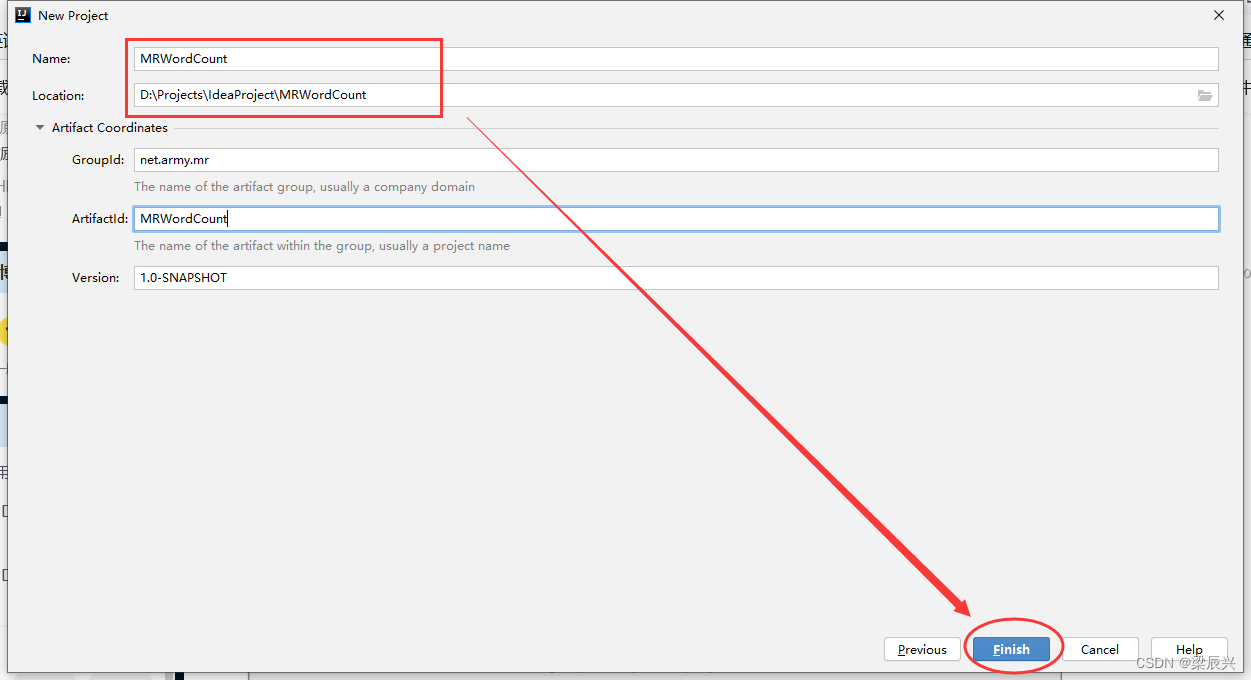

2.输入项目名称为:MRWordCount,单击【Finish】按钮

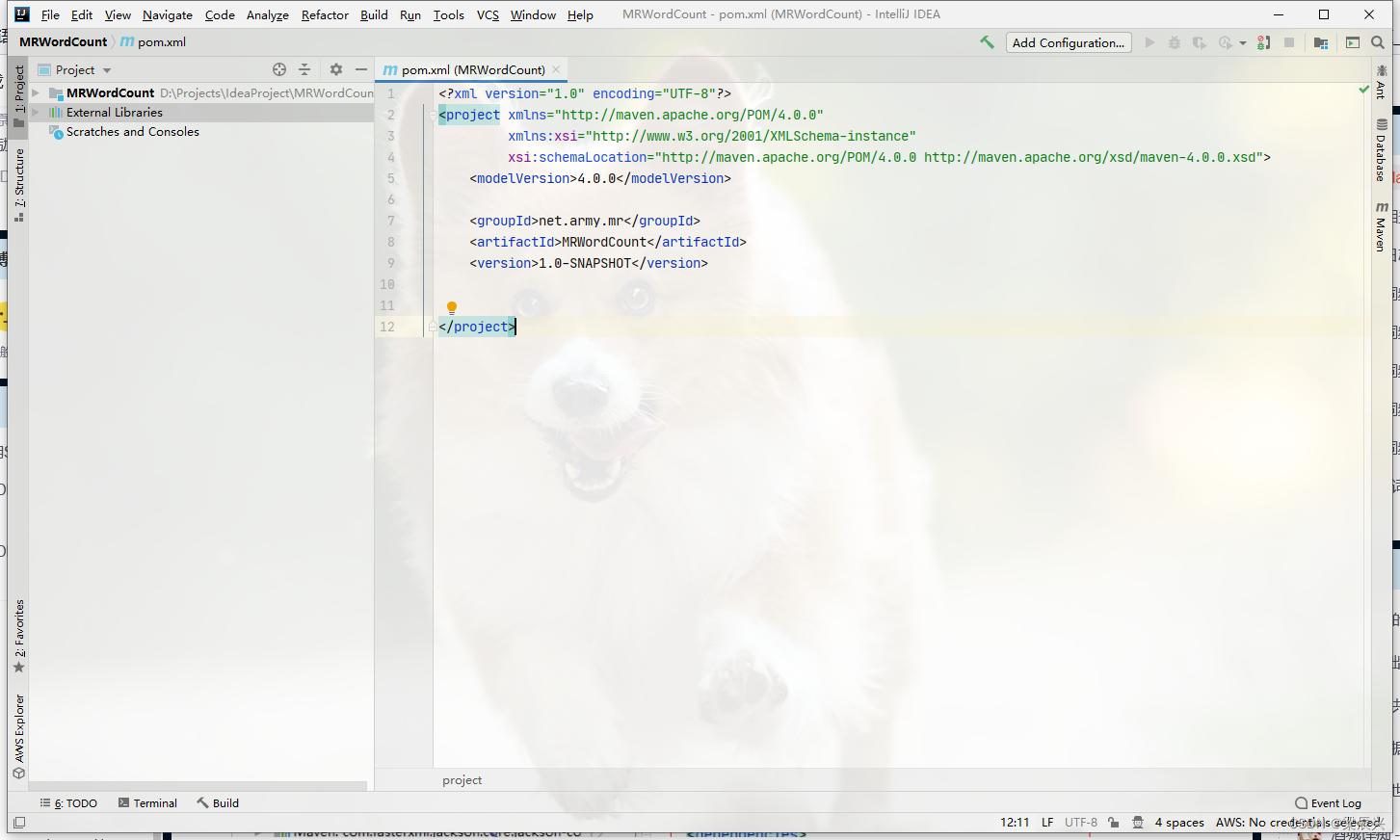

3.创建成功,弹出如下界面

3.创建成功,弹出如下界面

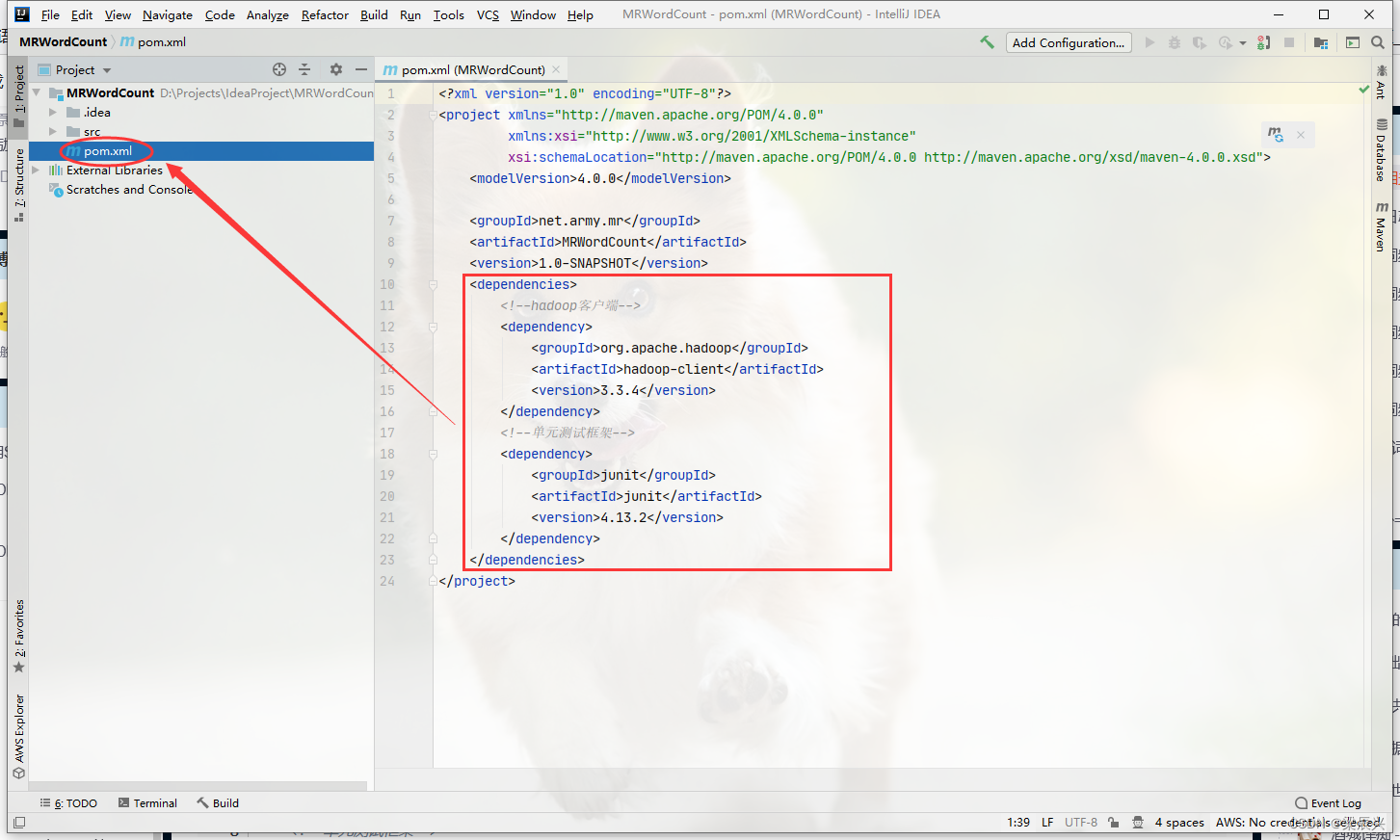

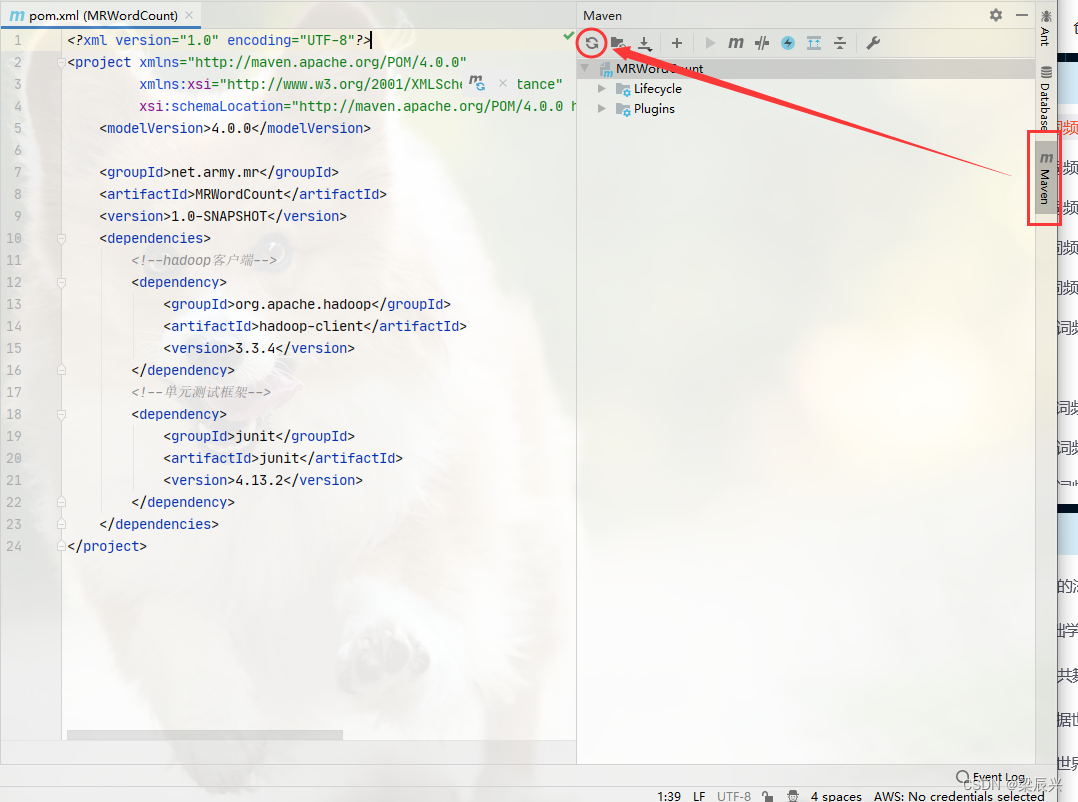

三,添加相关依赖

1.在pom.xml文件里添加hadoop和junit依赖,内容为:

<dependencies> <!--hadoop客户端--> <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-client</artifactId> <version>3.3.4</version> </dependency> <!--单元测试框架--> <dependency> <groupId>junit</groupId> <artifactId>junit</artifactId> <version>4.13.2</version> </dependency>

</dependencies>

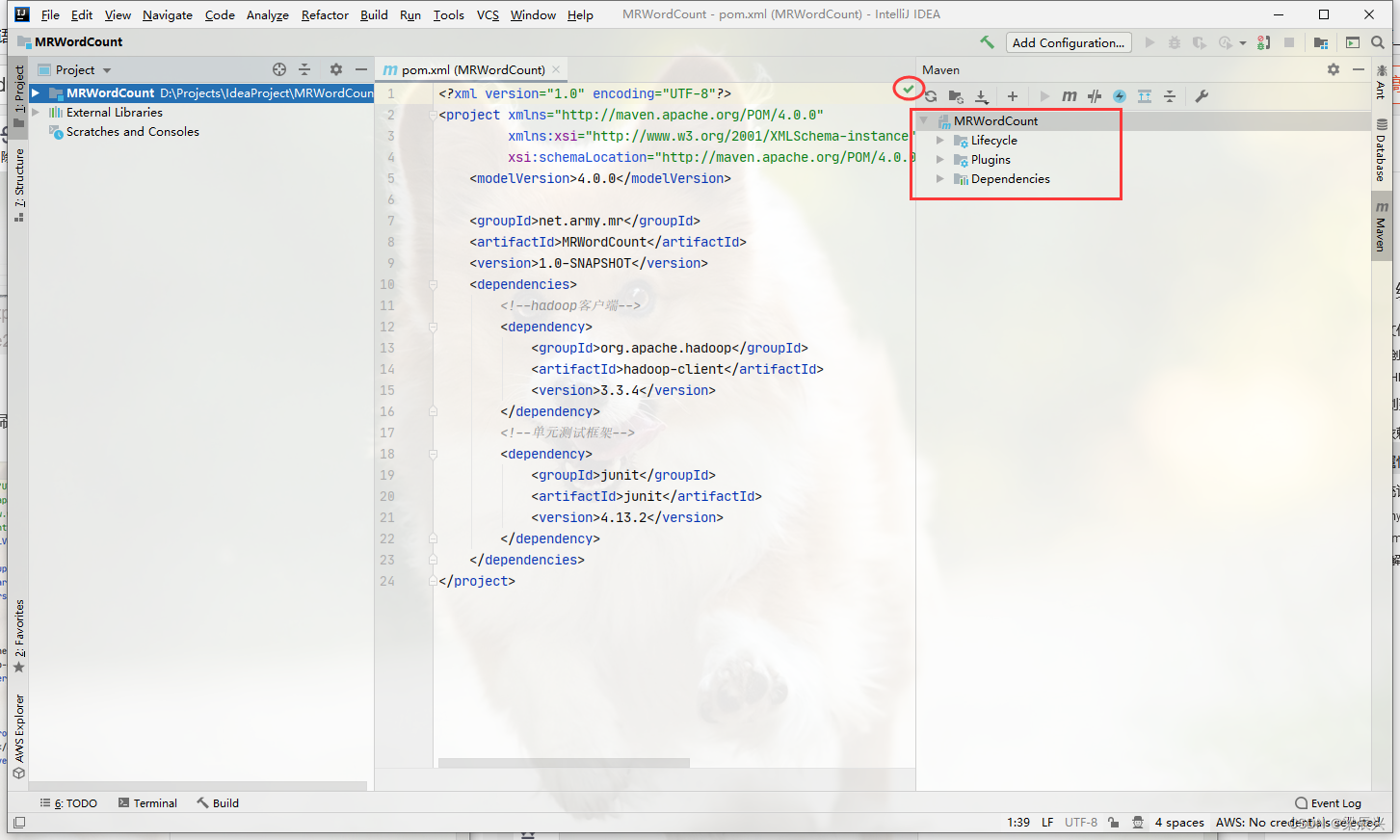

2.单击【maven】,单击那个刷新按钮,它会自动下载相关依赖

3.下载完成后,那个红色的感叹号会变成勾

注:maven的下载和配置可以参考:《在IDEA中配置Maven》

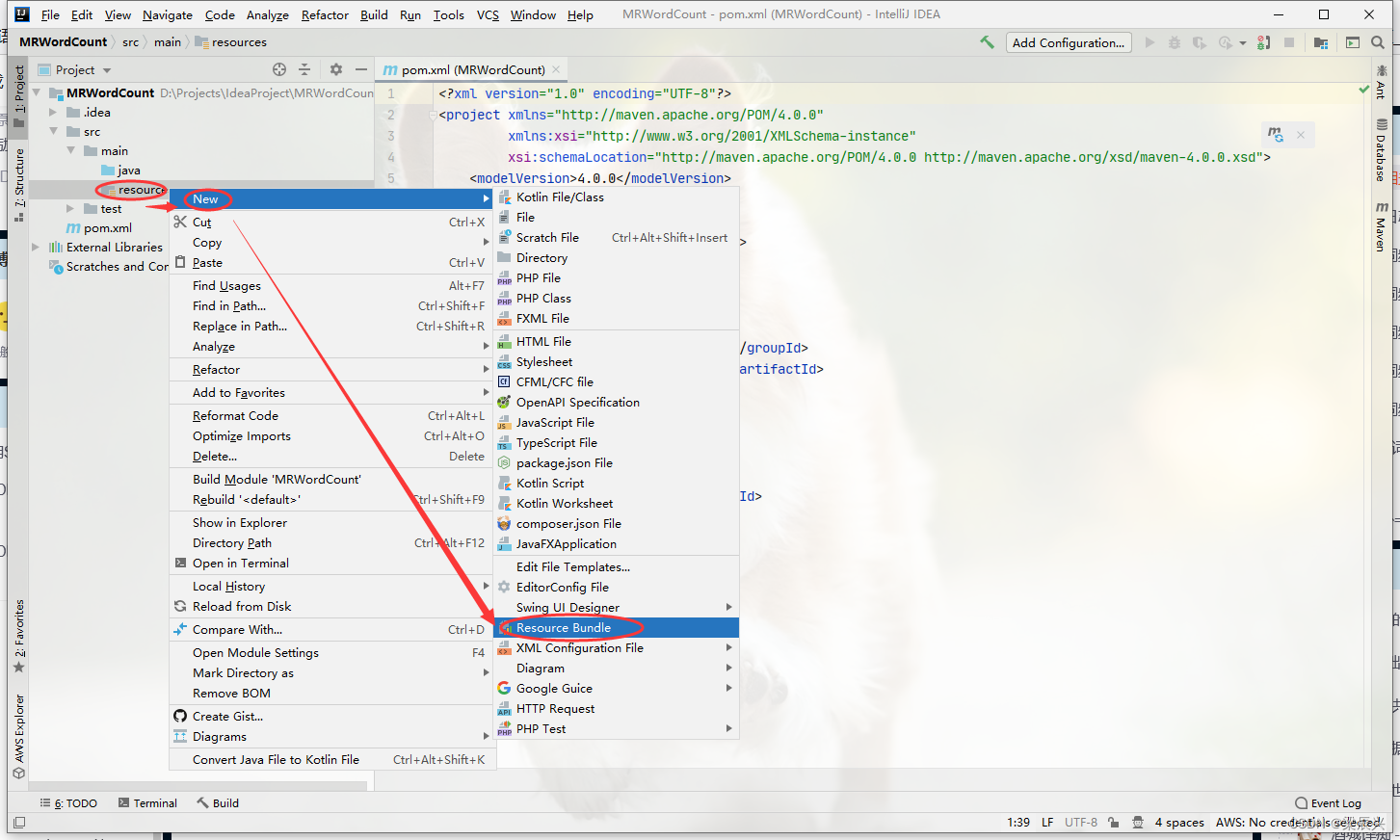

四,创建日志属性文件

(1)在resources目录里创建log4j.properties文件

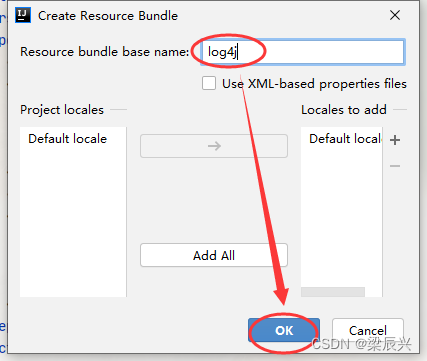

1.右击resources目录,单击【new】选择【resources bundle】,弹出下图界面输入log4j,单击【ok】按钮

2.在弹出的【Create Resource Bundle】对话框中输入:log4j,单击【OK】按钮

2.在弹出的【Create Resource Bundle】对话框中输入:log4j,单击【OK】按钮

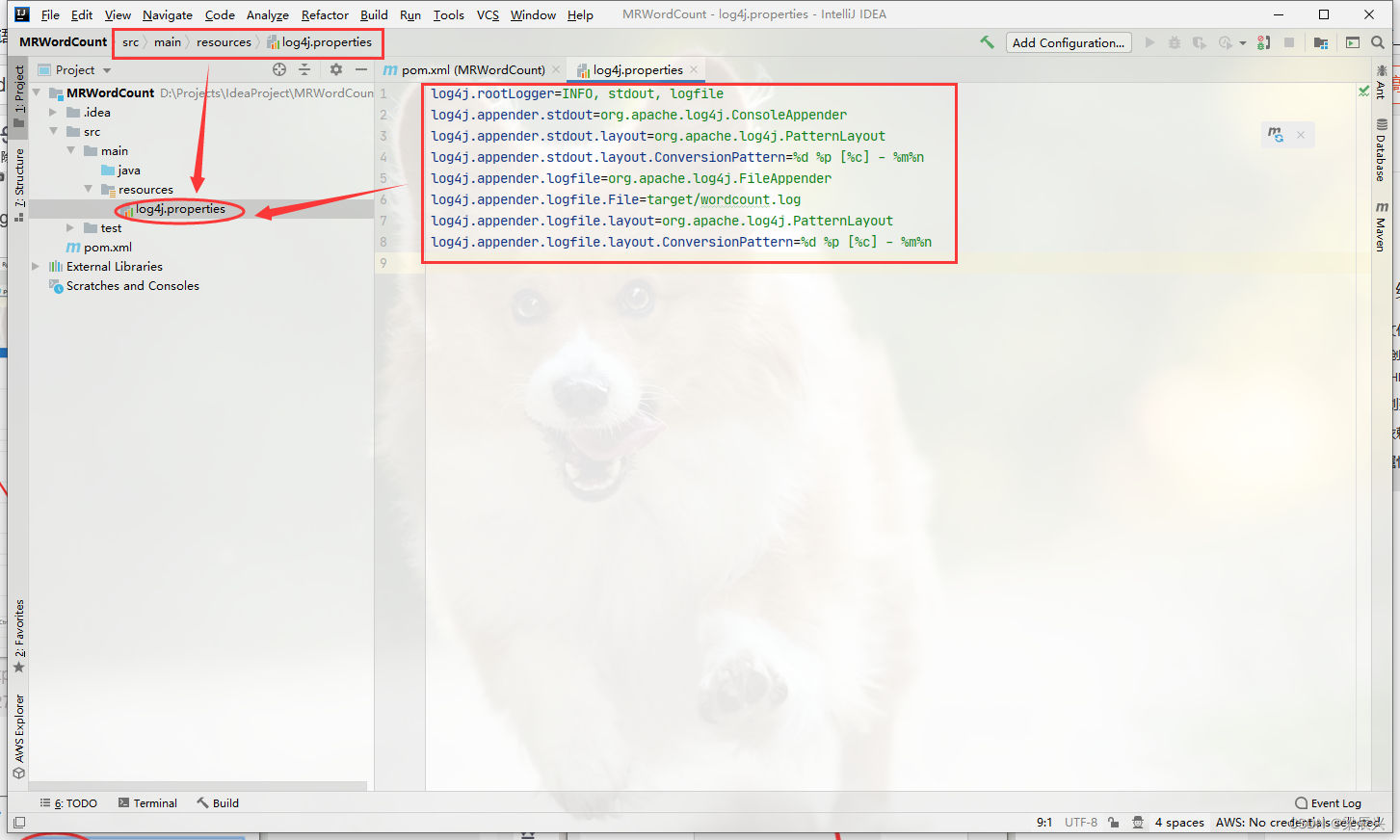

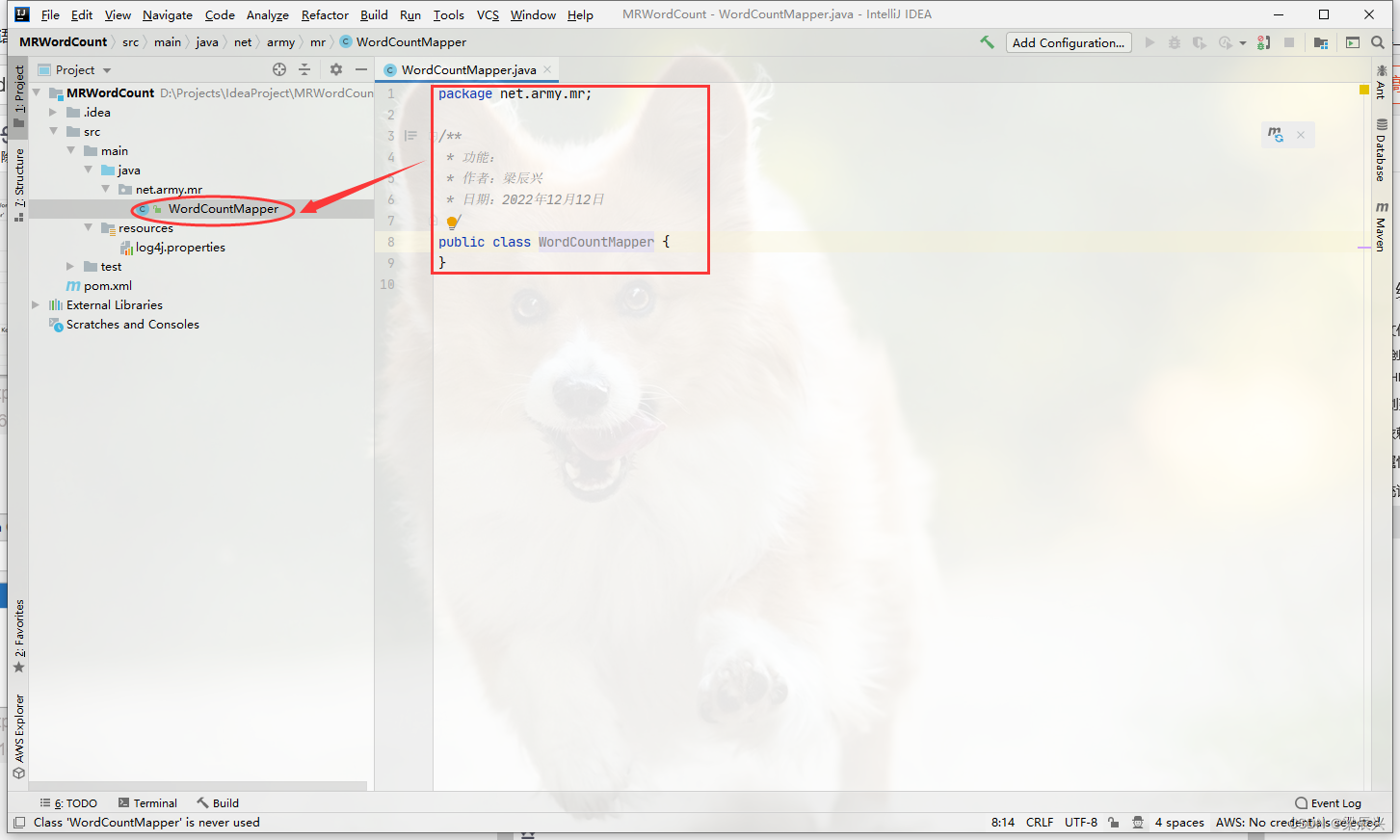

(2)log4j.properties文件添加内容

1.添加如下内容

log4j.rootLogger=INFO, stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/wordcount.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

2.添加完成实例图

五,创建词频统计映射器类

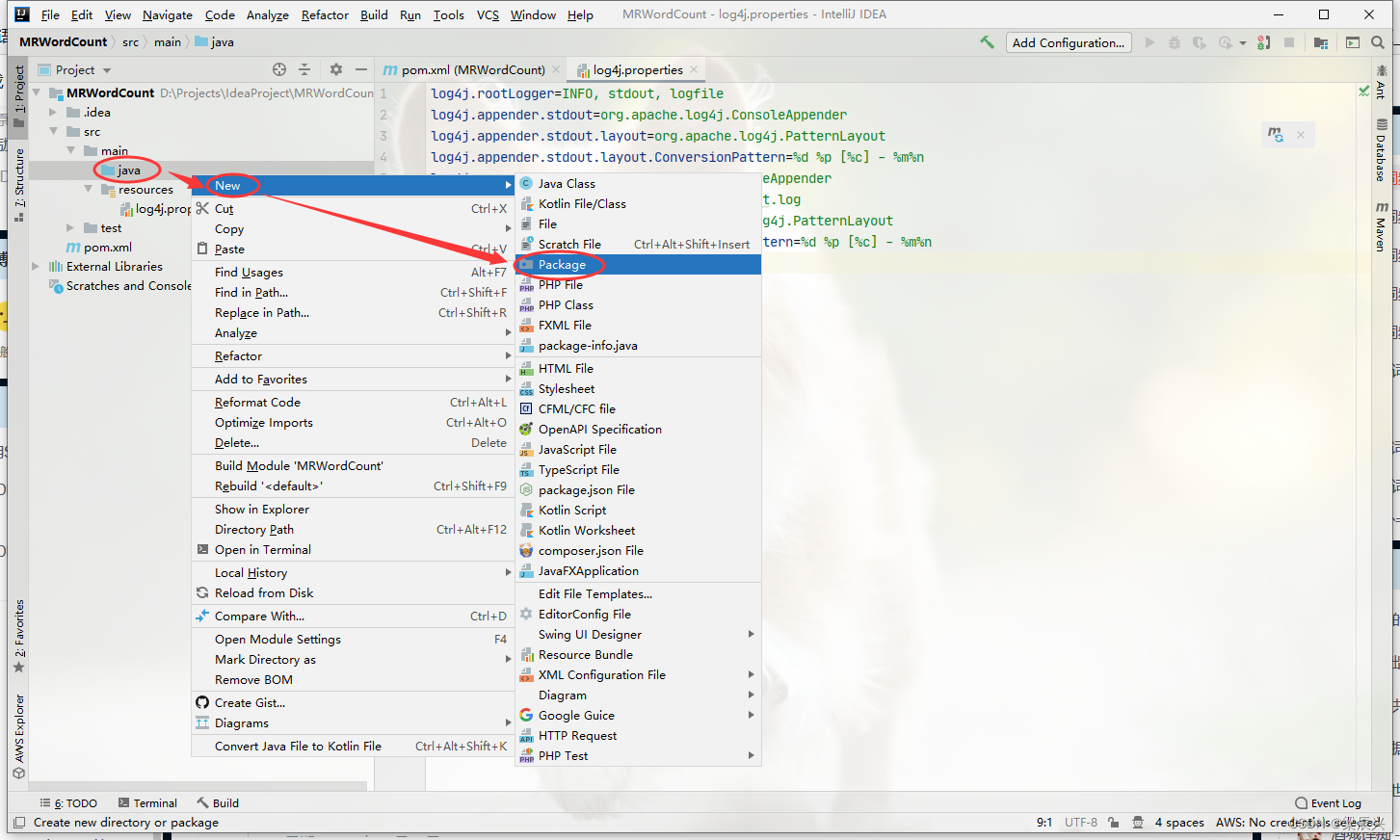

(1)创建net.army.mr包

1.右击【java】选择【new】单击【package】

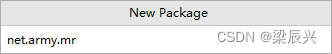

2.在弹出的【new package】对话框中输入net.army.mr,按下回车键

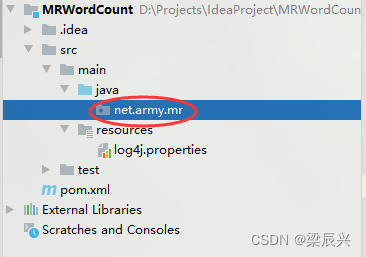

3.成功创建

(2)在net.army.mr包下创建WordCountMapper类

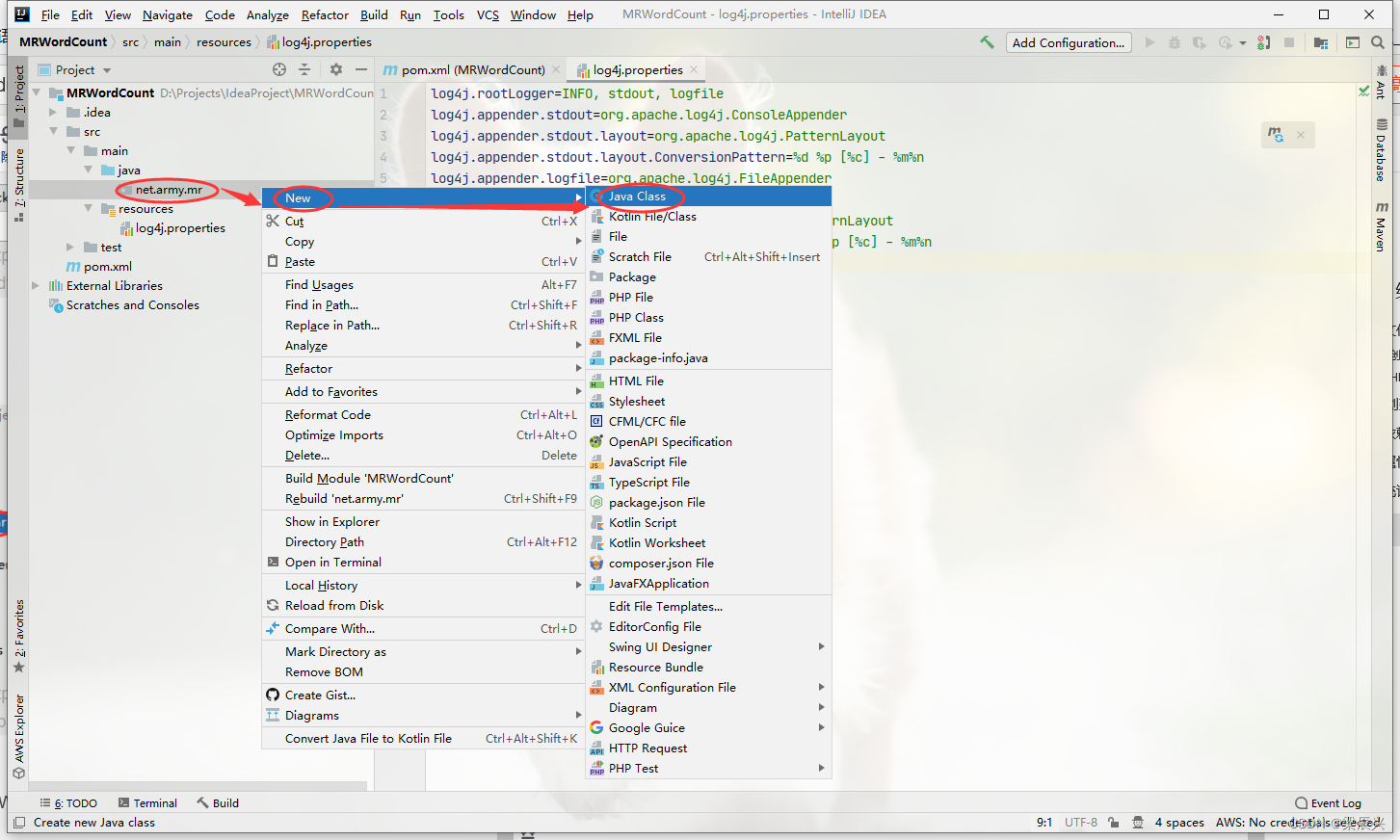

1.右击【net.army.mr】包,选择【new】,单击【java class】

2.在弹出的对话框输入WordCountMapper,按下回车键

2.在弹出的对话框输入WordCountMapper,按下回车键

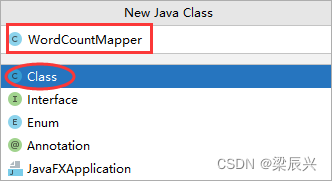

3.成功创建示例图如下

(3)为了更好理解Mapper类的作用,在map()函数里暂时不进行每行文本分词处理,直接利用context输出key和value

源码

package net.army.mr;import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;import java.io.IOException;/*** 功能:词频统计映射器类* 作者:梁辰兴* 日期:2022年12月12日*/public class WordCountMapper extends Mapper<LongWritable, Text, LongWritable, Text> {@Overrideprotected void map(LongWritable key, Text value, Context context)throws IOException, InterruptedException {// 直接将键值对数据传到下一个阶段context.write(key, value);}

}

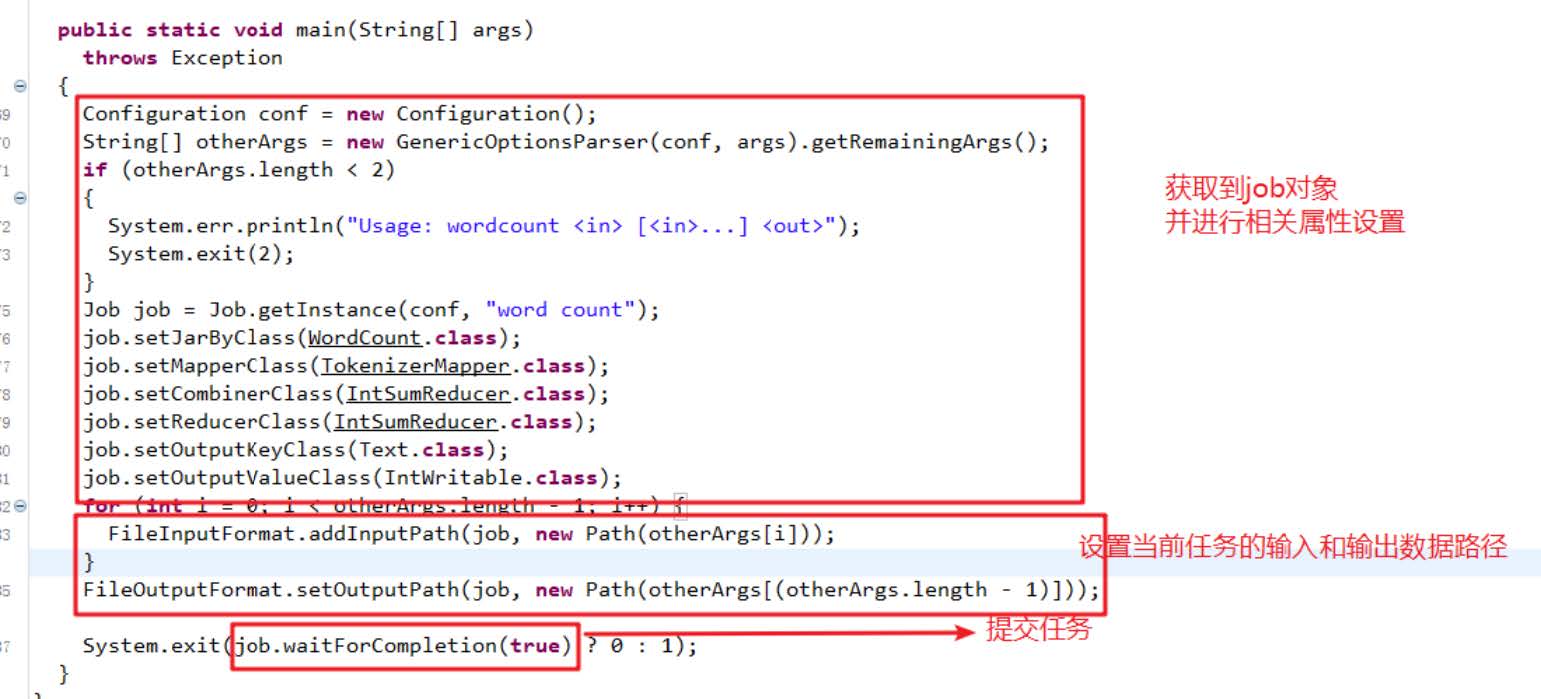

六,创建词频统计驱动器类

(1)在net.army.mr包里创建WordCountDriver类

1.在弹出的对话框中输入WordCountDriver

2.向WordCountDriver类中添加以下代码:

package net.army.mr;import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;import java.net.URI;/*** 功能:词频统计驱动器类* 作者:梁辰兴* 日期:2022年12月12日*/

public class WordCountDriver {public static void main(String[] args) throws Exception {// 创建配置对象Configuration conf = new Configuration();// 设置数据节点主机名属性conf.set("dfs.client.use.datanode.hostname", "true");// 获取作业实例Job job = Job.getInstance(conf);// 设置作业启动类job.setJarByClass(WordCountDriver.class);// 设置Mapper类job.setMapperClass(WordCountMapper.class);// 设置map任务输出键类型job.setMapOutputKeyClass(LongWritable.class);// 设置map任务输出值类型job.setMapOutputValueClass(Text.class);// 定义uri字符串String uri = "hdfs://master:9000";// 创建输入目录Path inputPath = new Path(uri + "/wordcount/input");// 创建输出目录Path outputPath = new Path(uri + "/wordcount/output");// 获取文件系统FileSystem fs = FileSystem.get(new URI(uri), conf);// 删除输出目录(第二个参数设置是否递归)fs.delete(outputPath, true);// 给作业添加输入目录(允许多个)FileInputFormat.addInputPath(job, inputPath);// 给作业设置输出目录(只能一个)FileOutputFormat.setOutputPath(job, outputPath);// 等待作业完成job.waitForCompletion(true);// 输出统计结果System.out.println("======统计结果======");FileStatus[] fileStatuses = fs.listStatus(outputPath);for (int i = 1; i < fileStatuses.length; i++) {// 输出结果文件路径System.out.println(fileStatuses[i].getPath());// 获取文件系统数据字节输入流FSDataInputStream in = fs.open(fileStatuses[i].getPath());// 将结果文件显示在控制台IOUtils.copyBytes(in, System.out, 4096, false);}}

}

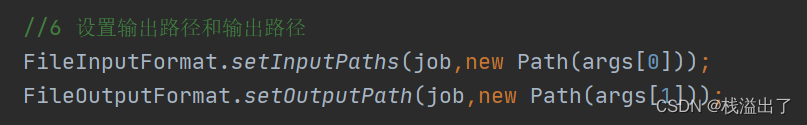

(2)注意导包

1.注意导包问题

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;import java.net.URI;

2.不要导成org.apache.hadoop.mapred包下的FileInputFormat与FileOutputFormat了

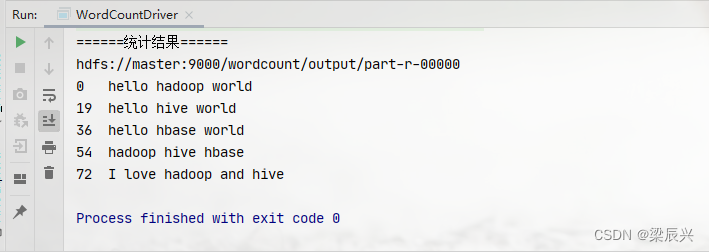

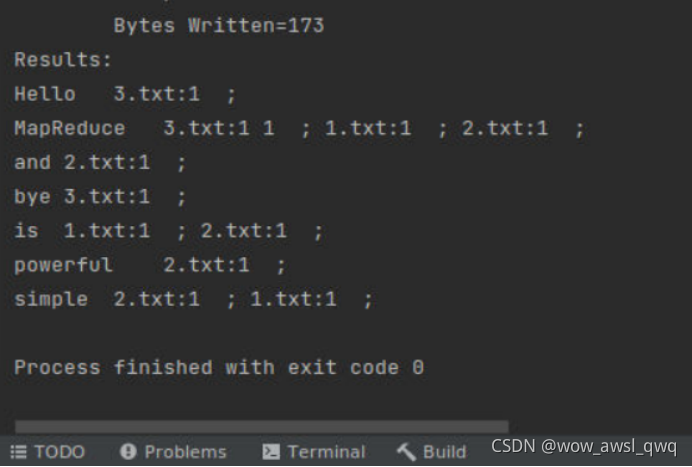

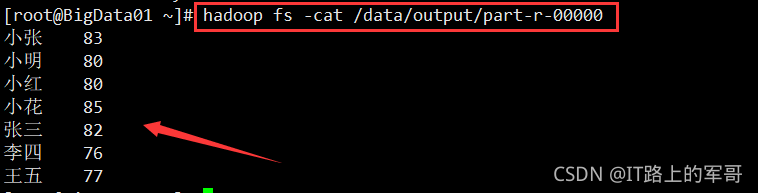

七,运行词频统计驱动器类,查看结果

统计结果之前会显示大量信息,如果不想看到统计结果之前的大堆信息,可以修改log4j.properties文件,将INFO改为ERROR

运行WordCountDriver程序,查看结果

运行WordCountDriver程序,查看结果