MapReduce编程规范

用户编写的程序分成三个部分:Mapper,Reducer,Driver(提交运行mr程序的客户端)

Mapper阶段继承Mapper类

(1)用户自定义的Mapper要继承自己的父类

(2)Mapper的输入数据是KV对的形式(KV的类型可自定义)

(3)Mapper中的业务逻辑写在map()方法中

(4)Mapper的输出数据是KV对的形式(KV的类型可自定义)

(5)map()方法(maptask进程)对每一个<K,V>调用一次

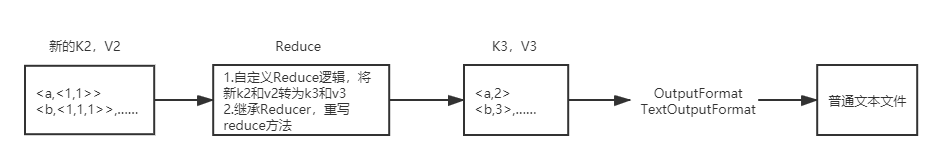

Reducer阶段继承Reducer类

(1)用户自定义的Reducer要继承自己的父类

(2)Reducer的输入数据类型对应Mapper的输出数据类型,也是KV

(3)Reducer的业务逻辑写在reduce()方法中

(4)Reducetask进程对每一组相同k的<k,v>组调用一次reduce()方法

Driver阶段使用Driver模板

整个程序需要一个Drvier来进行提交,提交的是一个描述了各种必要信息的job对象

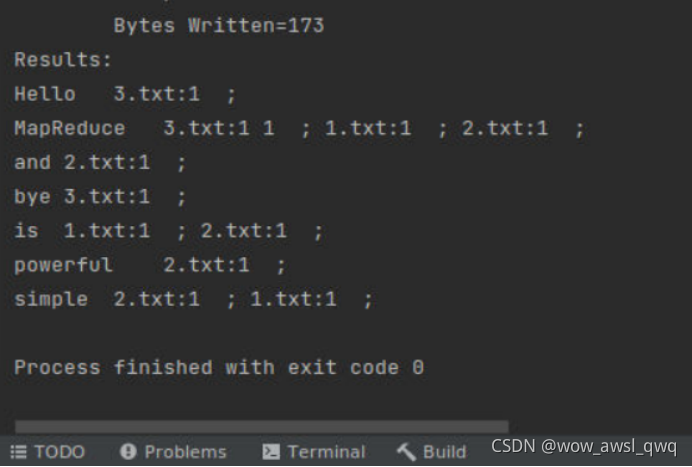

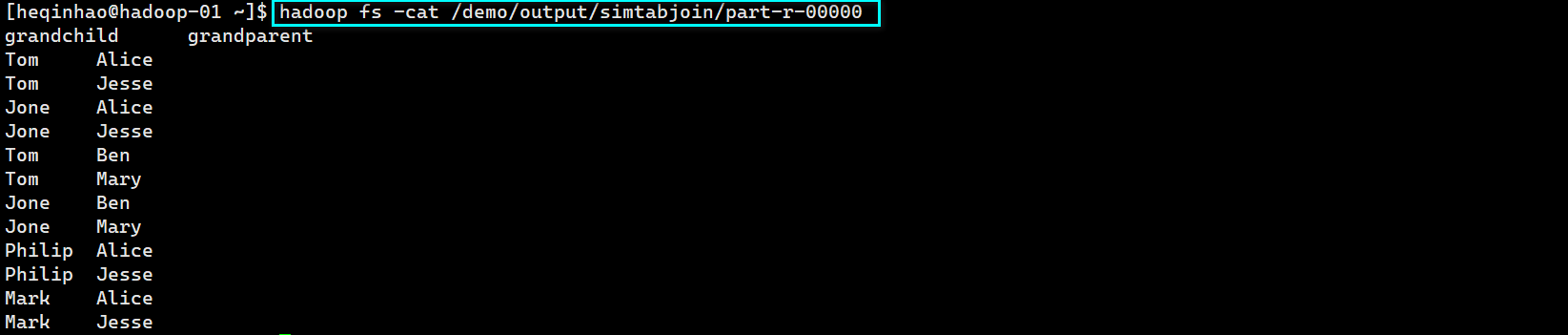

案例实操

1.需求分析

在给定的文本文件中统计输出每一个单词出现的总次数

(1)输入数据 hello.txt

dev1 dev1

ss ss

cls cls

jiao

banzhang

xue

hadoop

(2)期望输出数据

dev1 2

banzhang 1

cls 2

hadoop 1

jiao 1

ss 2

xue 1

2.开发步骤

按照MapReduce编程规范,分别编写Mapper,Reducer,Driver

》》1输入数据

hadoop hdfs

mr mr

》》2输出数据

hadoop 1

hdfs 1

mr 2

》》3 Mapper

3.1 将MapTask传给我们的文本内容先转换成String

3.2 根据空格将这一行切分成单词

3.3 将单词输出为<单词,1>

》》4 Reducer

4.1 汇总各个key的个数

4.2 输出该key的总次数

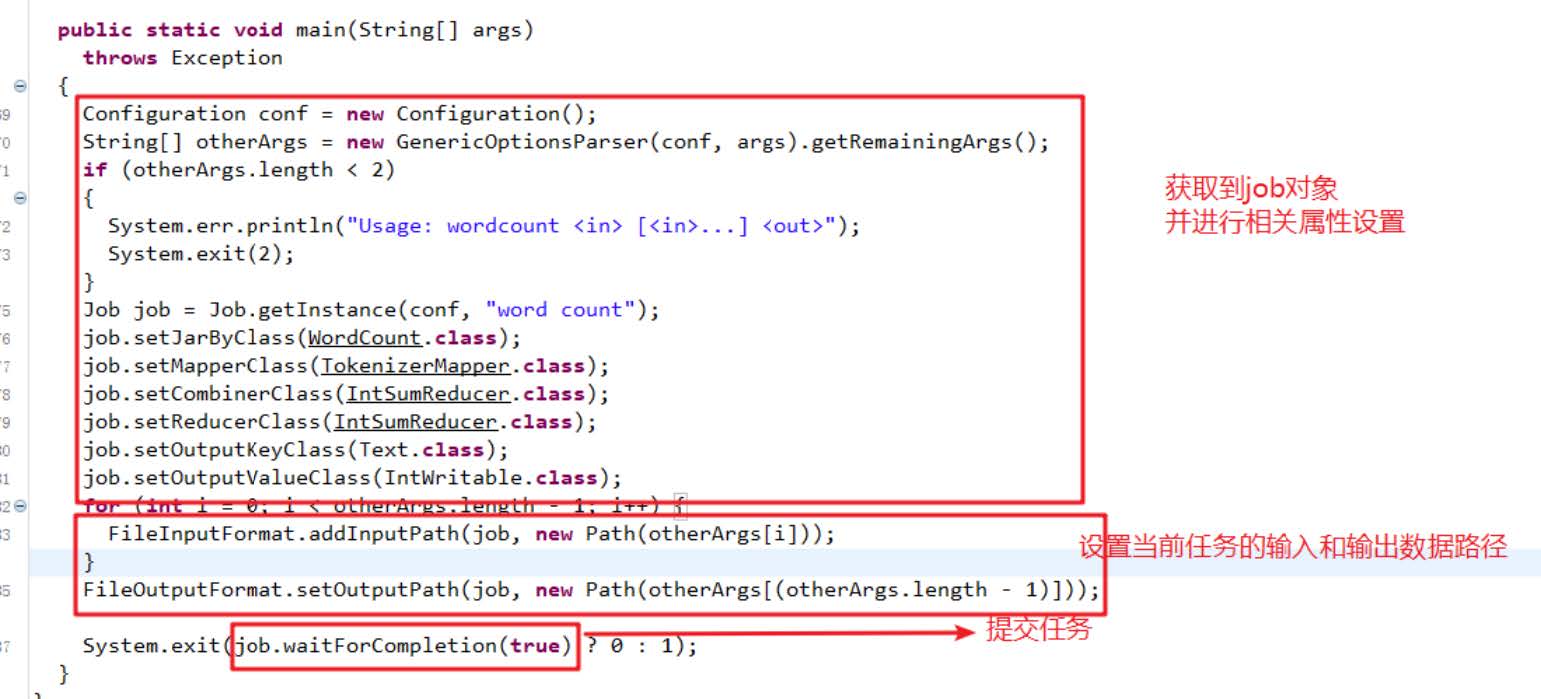

》》5 Driver

5.1 获取配置信息,获取job对象实例

5.2 指定本程序的jar所在的路径

5.3 关联Mapper/Reducer的业务类

5.4 指定Mapper输出数据的kv类型

5.5 指定最终输出的数据的kv类型

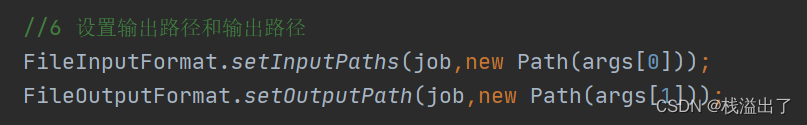

5.6 指定job的输入原始文本所在目录

5.7 指定job的输出结果所在目录

5.8 提交作业

3 项目搭建

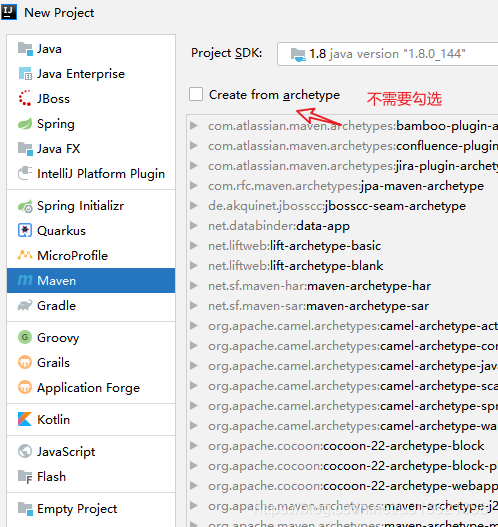

(1)Idea 创建maven工程

(2)在pom.xml文件中添加如下依赖

<dependencies><dependency><groupId>junit</groupId><artifactId>junit</artifactId><version>RELEASE</version></dependency><dependency><groupId>org.apache.logging.log4j</groupId><artifactId>log4j-core</artifactId><version>2.8.2</version></dependency><dependency><groupId>org.apache.hadoop</groupId><artifactId>hadoop-common</artifactId><version>2.7.2</version></dependency><dependency><groupId>org.apache.hadoop</groupId><artifactId>hadoop-client</artifactId><version>2.7.2</version></dependency><dependency><groupId>org.apache.hadoop</groupId><artifactId>hadoop-hdfs</artifactId><version>2.7.2</version></dependency>

</dependencies>

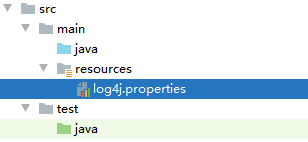

(2)在项目的resources目录下,新建一个文件,命名为"log4j.properties",在文件中填入。

log4j.rootLogger=INFO, stdout

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spring.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

4.编写程序

(1)编写Mapper类

package com.dev1.wordcount;

import java.io.IOException;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;public class WordcountMapper extends Mapper<LongWritable, Text, Text, IntWritable>{Text k = new Text();IntWritable v = new IntWritable(1);@Overrideprotected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {// 1 获取一行String line = value.toString();// 2 切割String[] words = line.split(" ");// 3 输出for (String word : words) {Text k = new Text();k.set(word);context.write(k, v);}}

}

(2)编写Reducer类

package com.dev1.wordcount;

import java.io.IOException;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;public class WordcountReducer extends Reducer<Text, IntWritable, Text, IntWritable>{int sum;

IntWritable v = new IntWritable();@Overrideprotected void reduce(Text key, Iterable<IntWritable> values,Context context) throws IOException, InterruptedException {// 1 累加求和sum = 0;for (IntWritable count : values) {sum += count.get();}// 2 输出v.set(sum);context.write(key,v);}

}

(3)编写Driver驱动类

package com.dev1.wordcount;

import java.io.IOException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;public class WordcountDriver {public static void main(String[] args) throws IOException, ClassNotFoundException, InterruptedException {// 1 获取配置信息以及封装任务Configuration configuration = new Configuration();Job job = Job.getInstance(configuration);// 2 设置jar加载路径job.setJarByClass(WordcountDriver.class);// 3 设置map和reduce类job.setMapperClass(WordcountMapper.class);job.setReducerClass(WordcountReducer.class);// 4 设置map输出job.setMapOutputKeyClass(Text.class);job.setMapOutputValueClass(IntWritable.class);// 5 设置最终输出kv类型job.setOutputKeyClass(Text.class);job.setOutputValueClass(IntWritable.class);// 6 设置输入和输出路径FileInputFormat.setInputPaths(job, new Path(args[0]));FileOutputFormat.setOutputPath(job, new Path(args[1]));// 7 提交boolean result = job.waitForCompletion(true);System.exit(result ? 0 : 1);}

}

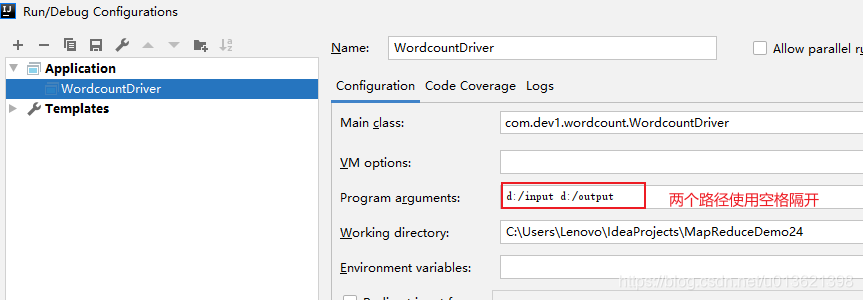

5.本地测试

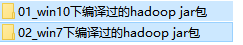

(1 )如果电脑系统是win7的就将win7的hadoop jar包解压

如果电脑系统是win10的就将win10的hadoop jar包解压

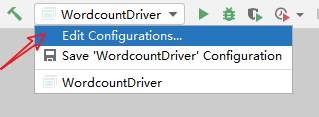

(2)在Eclipse/Idea上运行程序

运行前必须设置参数

在图中给定两个路径

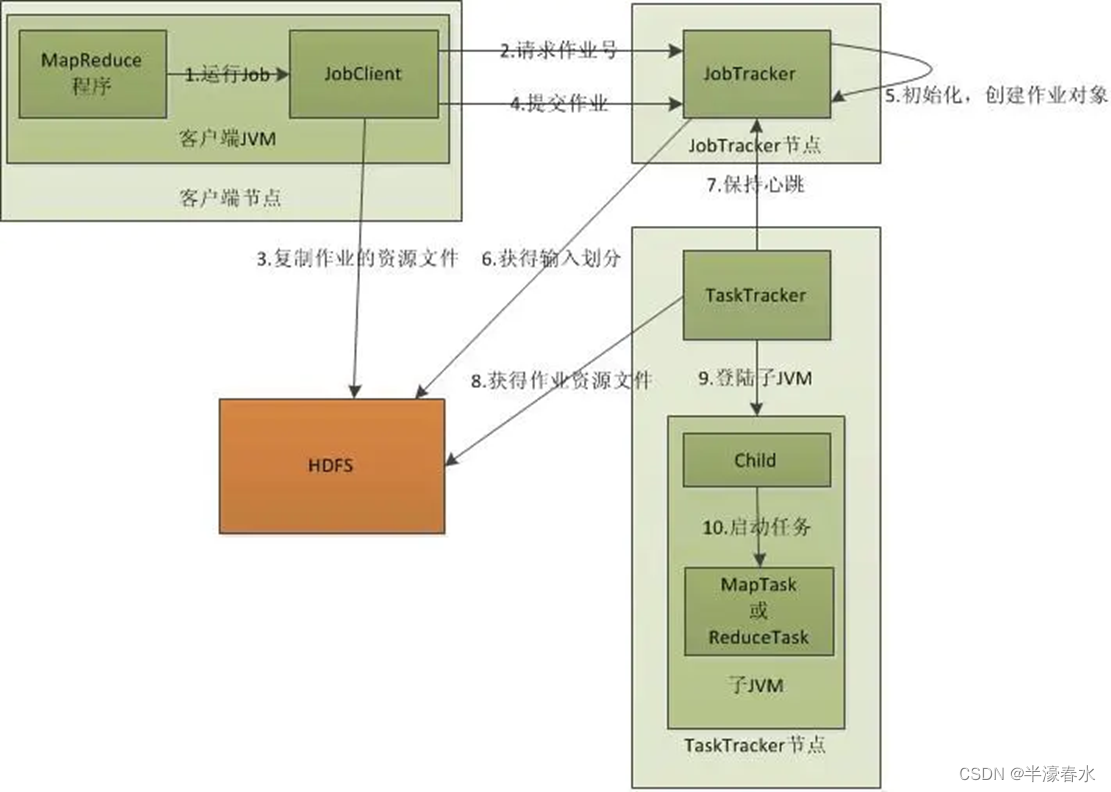

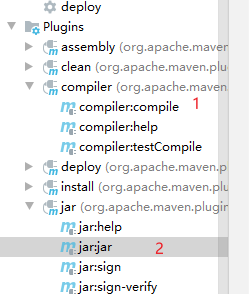

6.集群上测试

(0)用maven打jar包,需要添加的打包插件依赖

注意:标记红颜色的部分需要替换为自己工程主类

<build><plugins><plugin><artifactId>maven-compiler-plugin</artifactId><version>2.3.2</version><configuration><source>1.8</source><target>1.8</target></configuration></plugin><plugin><artifactId>maven-assembly-plugin </artifactId><configuration><descriptorRefs><descriptorRef>jar-with-dependencies</descriptorRef></descriptorRefs><archive><manifest><mainClass>com.dev1.wordcout.WordcountDriver</mainClass></manifest></archive></configuration><executions><execution><id>make-assembly</id><phase>package</phase><goals><goal>single</goal></goals></execution></executions></plugin></plugins></build>

(1)将程序打成jar包。

修改不带依赖的jar包名称为wc.jar,并拷贝该jar包到Hadoop集群。

(2)启动Hadoop集群

在hadoop102上

start dfs.sh

在hadoop103上

start-yarn.sh

(3)上传文本文件到 input文件夹

hdfs dfs -mkdir -p /user/dev1/input

cd /opt/module/hadoop-2.7.2

hdfs dfs -put ./words.txt /user/dev1/input

input文件夹下只能有文本文件

(4)执行WordCount程序

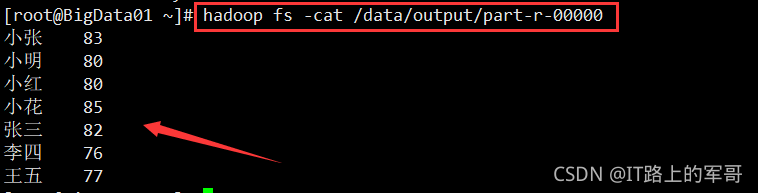

hadoop jar wc.jar com.dev1.wordcount.WordcountDriver /user/dev1/input /user/dev1/output