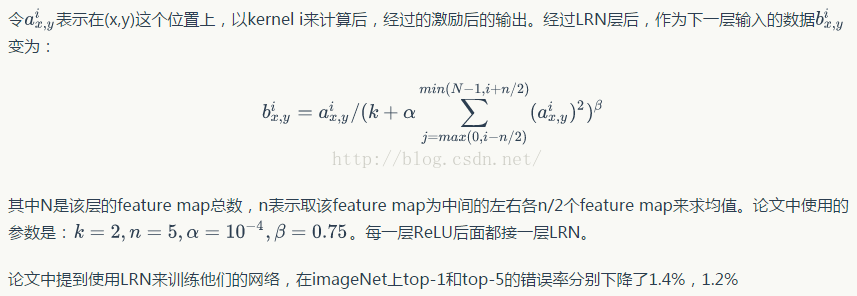

最近写论文刚上手了Latex,因为有模板,所以用起来还是很方便的。

但是在实际使用中,由于论文是双栏的,因此比较长的公式在排版时会比较困难。下面对Latex中的公式排版方法做一些记录。

公式的编写方法在此不再赘述。可以选择网页版的Latex公式编辑器。

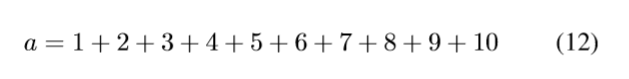

一开始使用了align方法,代码如下所示,该方法优点在于比较简单,且可以自动编号

\begin{align}

a=(1+2+3+4+5+6+7+8+9+10) %你的公式代码

\end{align}

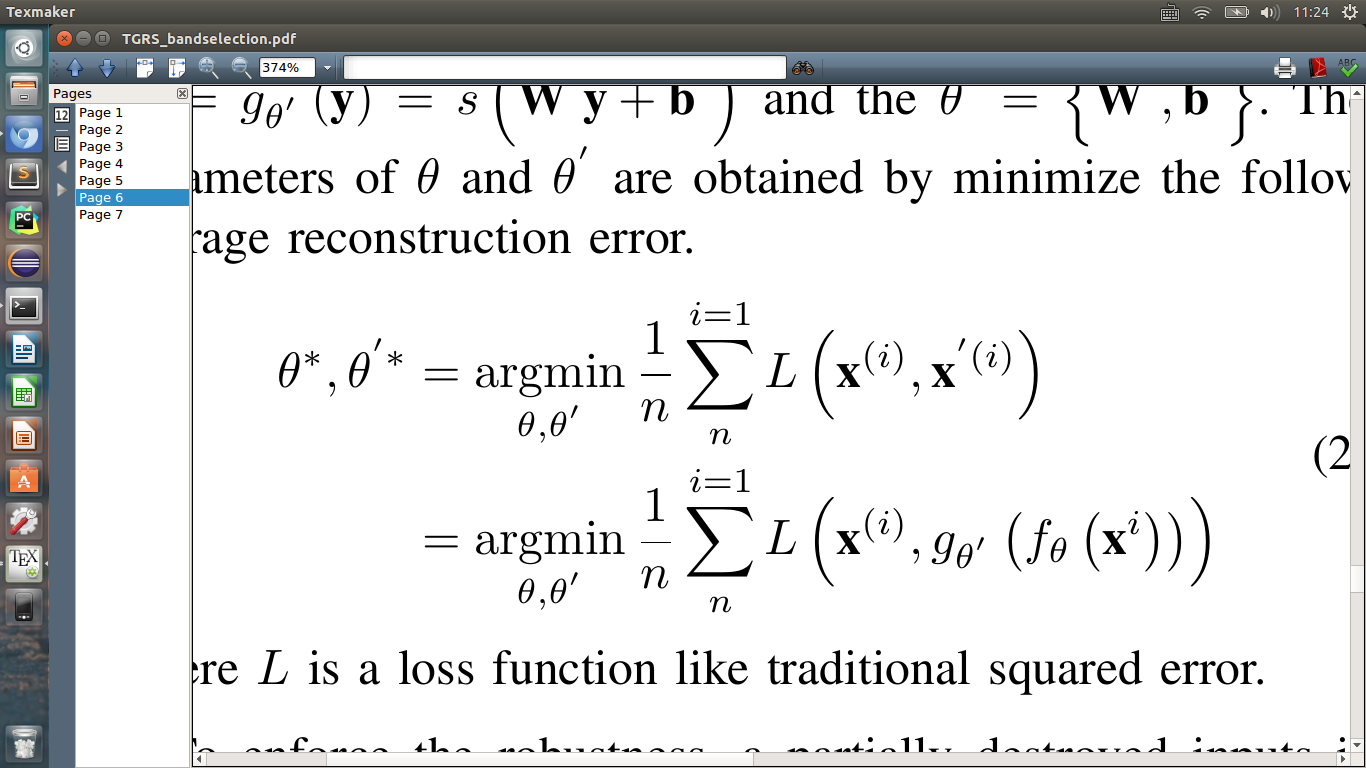

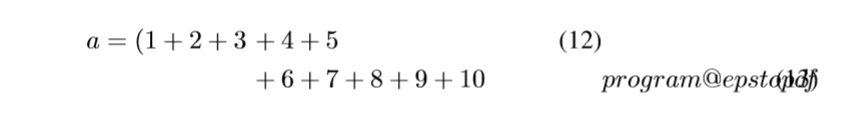

效果如下:

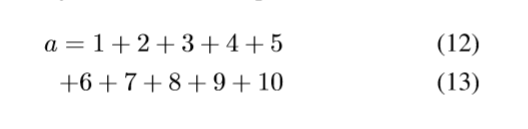

但是当公式很长时,公式可能会从一栏侵入另一栏,这就需要我们对公式换行,使用“\”指令进行换行:

\begin{align}

a=1+2+3+4+5

\\+6+7+8+9+10

\end{align}

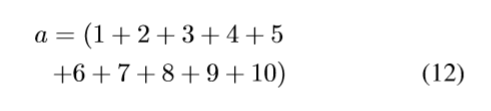

效果如下:

该方法会自动对齐,如需手动设置对齐位置,可以在相应位置前加上“&”指令。另外,换行还会带来编号的增加,如果只想在这个公式块设置一个编号,可以在换行前加上“\notag”指令:

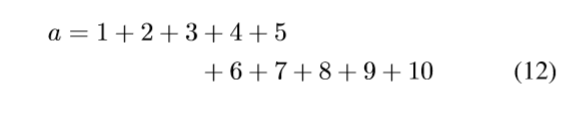

\begin{align}

a=1+2+3&+4+5

\notag

\\&+6+7+8+9+10

\end{align}

这样这个代码块就仅有一个编号,而且也按照代码,4和6前面的+进行了对齐。

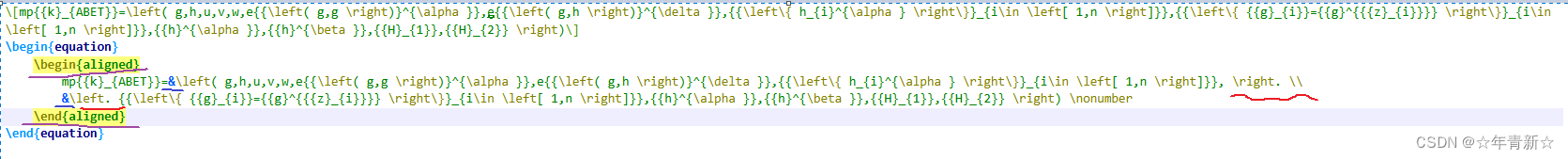

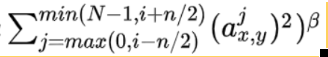

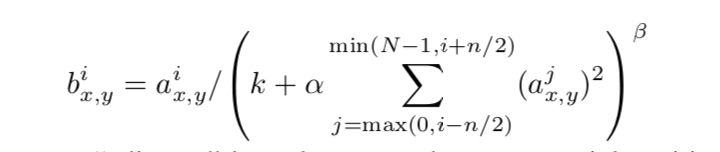

最后一个问题,在许多大型公式中,是需要在括号中进行换行,如:

单纯的使用“\”是不够的,还需要加上”\right.“和“\phantom{=\;\;}\left.”指令:

\begin{align}

a=\left(1+2+3+4+5

\notag\right.

\\

\phantom{=\;\;}

\left.+6+7+8+9+10\right)

\end{align}

这样就可以很好的实现括号内换行啦。

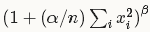

另外,也可采用以下模块代替align模块

\begin{equation}

\begin{aligned}\end{aligned}

\end{equation}

与align模块使用方法类似。