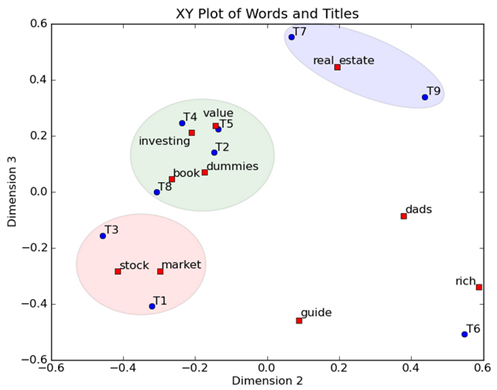

原文地址:http://www.bfcat.com/index.PHP/2012/03/svd-tutorial/

SVD分解(奇异值分解),本应是本科生就掌握的方法,然而却经常被忽视。实际上,SVD分解不但很直观,而且极其有用。SVD分解提供了一种方法将一个矩阵拆分成简单的,并且有意义的几块。它的几何解释可以看做将一个空间进行旋转,尺度拉伸,再旋转三步过程。

首先来看一个对角矩阵,

|  |  |

对于另一个矩阵

|  |  |

这样一个变化并不是很好描述,然而当我们将坐标系旋转45度后,我们可以看出

|  |  |

这时,我们发现这个新的网格上发生的变化和网格在对角阵下发生变化的效果相似。

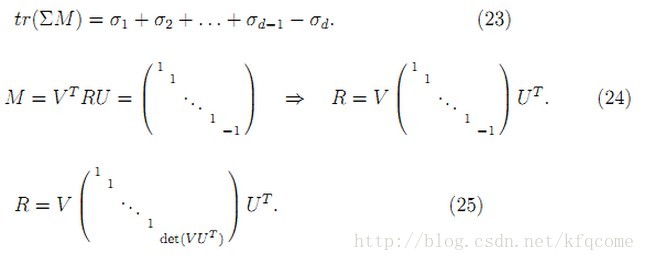

这是一个对称矩阵的例子,可以看出,对称矩阵经过旋转后,其作用就和对角阵类似了。数学上,对于一个对称矩阵 M, 我们可以找到一组正交向量 vi 从而 Mvi 相当于 vi上的标量乘积; 也就是

对于更广泛的情况,我们看看是否能从一个正交网格转换到另一个正交网格. 考虑一个非对称矩阵:

|  |  |

这个矩阵将网格在水平方向拉伸了,而垂直方向没有变化。如果我们将网格旋转大约58度,这两个网格就又会都变为正交的了。

|  |  |

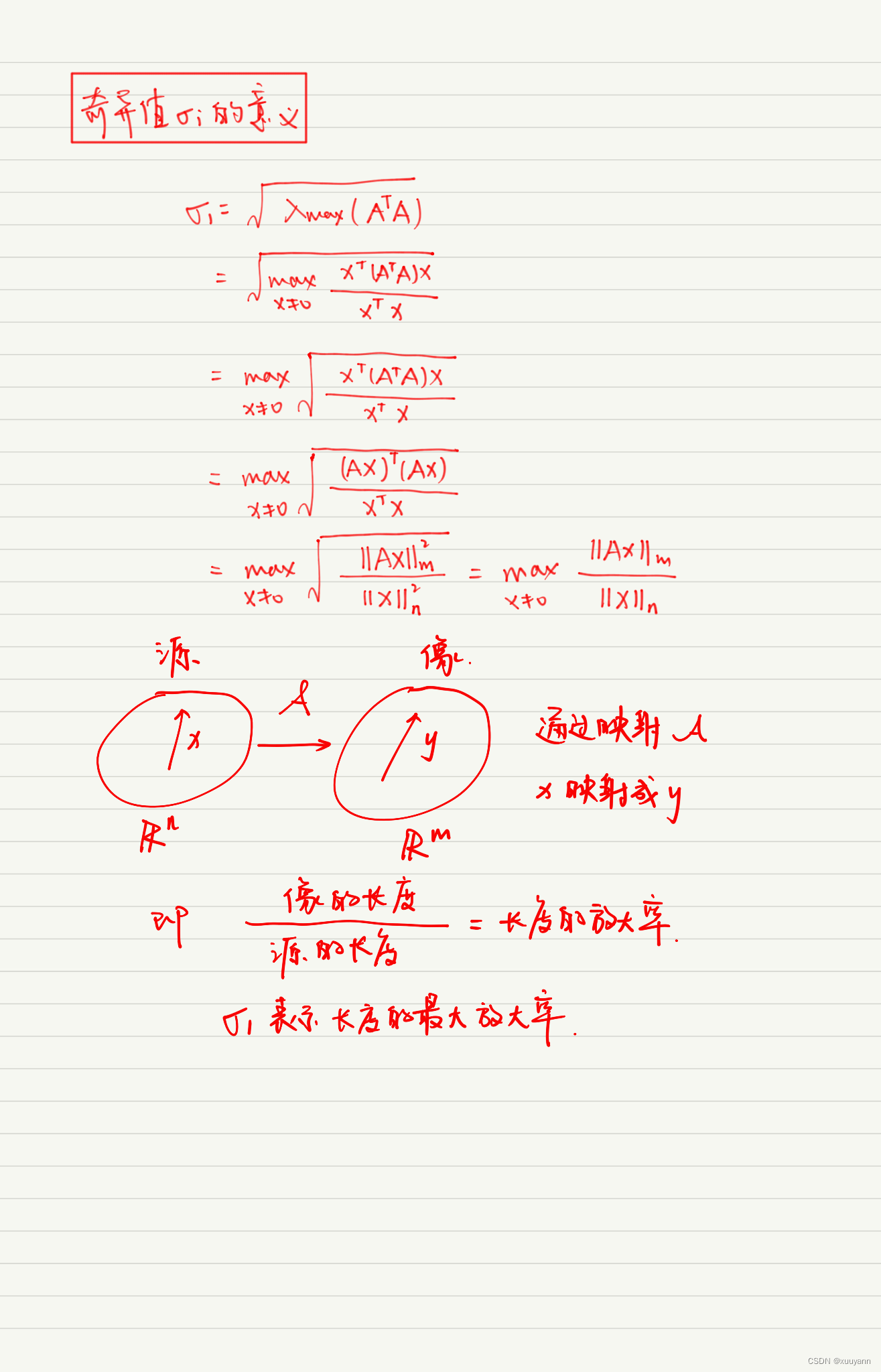

奇异值分解:

考虑一个 2 *2 矩阵, 我们可以找到两组网格的对应关系。用向量表示,那就是当我们选择合适的单位正交向量 v1 和v2, Mv1 和 Mv2 也是正交的.

|  |  |

我们使用 u1 和 u2 代表 Mv1 和 Mv2的方向. Mv1 和 Mv2 的长度表示为 σ1 和 σ2,也就是网格在每个方向的拉伸.这两个拉伸值叫做M的 奇异值(sigular value)

Mv1 = σ1u1

Mv2 = σ2u2

我们一直讨论的 v1 和 v2 是一对正交向量, 对于一般的向量 x,我们有这样的投影关系

x) v1 + ( v2

x) v1 + ( v2  x) v2

x) v2

x) M v1 + ( v2

x) M v1 + ( v2  x) M v2

x) M v2

x

) σ

1

u1

+ (

v2

x

) σ

1

u1

+ (

v2 x

) σ

2

u

x

) σ

2

u

即

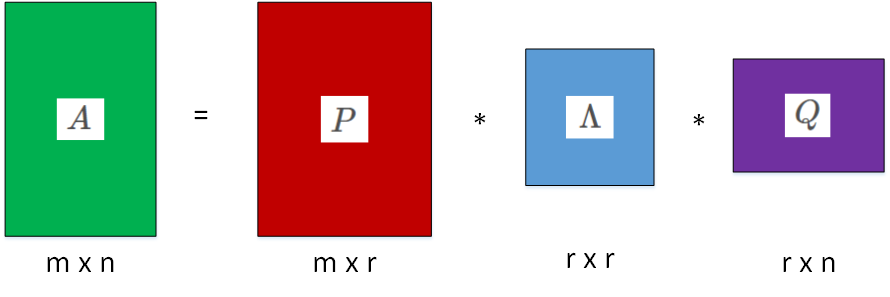

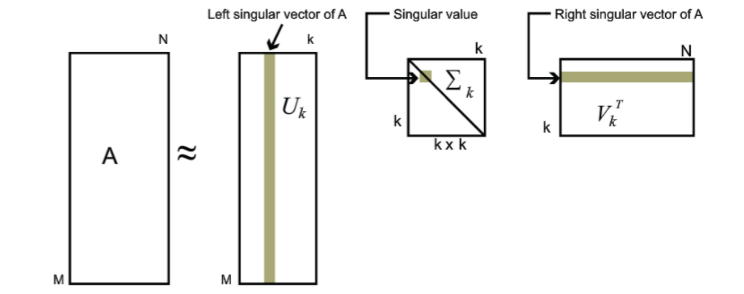

Mx = u1σ1 v1Tx + u2σ2 v2Tx ---> M = u1σ1 v1T + u2σ2 v2T

这个关系可以写成矩阵形式

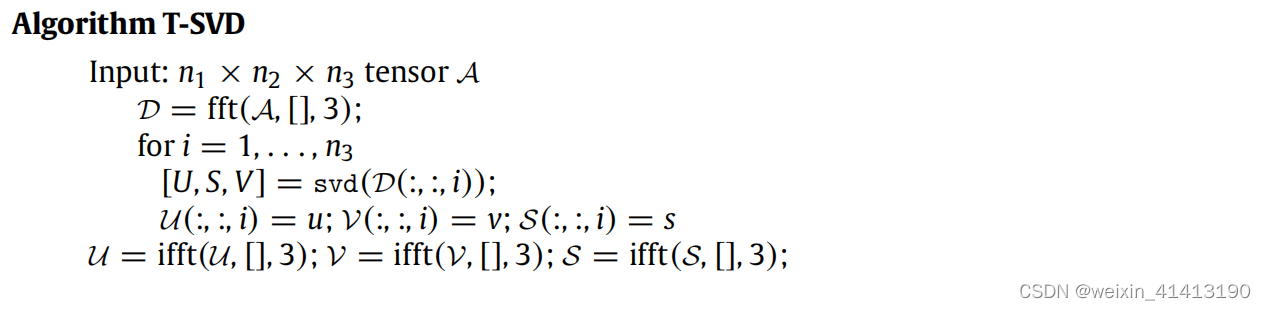

寻找奇异值分解

奇异值分解可以应用于任何矩阵,对于前面的例子,如果我们加上一个圆,那它会映射成一个椭圆,椭圆的长轴和短轴定义了新的域中的正交网格,可以被表示为Mv1 and Mv2。

|  |  |

|  |  |

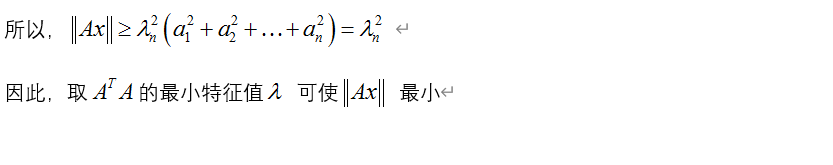

换句话说,单位圆上的函数 |Mx| 在 v1 取得最大值,在 v2取得最小值. 这将单位圆上的函数优化问题简化了。可以证明,这个函数的极值点就出现在MTM的特征向量上,这个矩阵一定是对称的,所以不同特征值对应的特征向量vi是正交的.

σi = |Mvi|就是奇异值, ui 是 Mvi方向的单位向量.

M vj = vi T M T M vj = vi

M vj = vi T M T M vj = vi  M T M vj = λ j vi

M T M vj = λ j vi  vj = 0.

vj = 0.

M vj = σ iσ j ui

M vj = σ iσ j ui  uj = 0

uj = 0

另一个例子

我们来看一个奇异矩阵(秩为1,或只有一个非零奇异值)

|  |  |

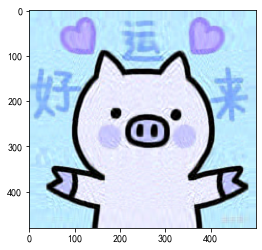

在这个例子中,第二个奇异值为0,所以 M = u1σ1 v1T. 也就是说,如果有奇异值为0,那么这个矩阵就有降维的效果。因为0奇异值对应的维度就不会出现在右边。这对于计算机科学中的数据压缩极其有用。例如我们想压缩下面的15  25 像素的黑白图像

25 像素的黑白图像

25 的矩阵,总共有 375 个元素.

25 的矩阵,总共有 375 个元素.

也就是说我们用三个长度为15的向量vi,三个长度为25的向量ui,以及三个奇异值,总共123个数字表示了这个375个元素组成的矩阵。奇异值分解找到了矩阵中的冗余信息实现了降维。

可以看出,奇异值分解捕获了图像中的主要信息。因此,又假设上一个例子里引入了噪声,

u 1σ 1 v 1 T + u 2σ 2 v 2 T + u 3σ 3 v 3 T

u 1σ 1 v 1 T + u 2σ 2 v 2 T + u 3σ 3 v 3 T

我们就实现了图像的降噪。

| Noisy image | Improved image |

|  |