目录

- 矩阵相关术语

- 共轭矩阵(Hermite阵)

- 特征值

- 相似矩阵

- A^H^

- A^H^A

- 酉矩阵

- 酉相抵(正交相抵)

- 奇异值

- 奇异值分解式

- 特征分解

- 奇异值分解

- python代码实现

- 验证结果 np.linalg.svd

- 利用Python进行SVD分解对图像压缩

矩阵相关术语

共轭矩阵(Hermite阵)

当A = (ai,j)为复矩阵时,用 a ‾ \overline{a} a表示a的共轭复数,记 A ‾ \overline{A} A = ( a i j ‾ \overline{aij} aij),则 A ‾ \overline{A} A为A的共轭矩阵。

埃尔米特矩阵是相对其主对角线以复共轭方式对称,且Hermite阵主对角线上的元素必须是实数,实对称阵是Hermite阵的特例。如:

特征值

定义:设 A 是n阶方阵,如果存在数λ和非零n维列向量 x,使得 Ax=λx 成立,则称 λ 是矩阵A的一个特征值,x是矩阵A对应特征值λ的特征向量。

式Ax=λx也可写成( A-λE)X=0。这是n个未知数n个方程的齐次线性方程组,它有非零解的充分必要条件是系数行列式| A-λE|=0。系数行列式|A-λE|称为A的特征多项式。

- 性质

- n阶方阵A=(aij)的所有特征根为λ1,λ2,…,λn(包括重根):

- 若λ是可逆阵A的一个特征根,x为对应的特征向量,则1/λ 是A的逆的一个特征根,x仍为对应的特征向量。

- 若 λ是方阵A的一个特征根,x为对应的特征向量,则λ 的m次方是A的m次方的一个特征根,x仍为对应的特征向量。

- 设λ1,λ2,…,λm是方阵A的互不相同的特征值。xj是属于λi的特征向量( i=1,2,…,m),则x1,x2,…,xm线性无关,即不相同特征值的特征向量线性无关

- 特征值与特征向量的求法

- 利用| A-λE| = 0,求出特征值λ

- 根的维数一般是一维。即kξ(ξ为基础解系),如果重根,则维数是特征根的重数,k1ξ1+k2ξ2+…

相似矩阵

设A,B都是n阶矩阵,若存在可逆矩阵P,使P(-1)AP=B,则称B是A的相似矩阵, 并称矩阵A与B相似,记为A~B。

- 性质

- 反身性:A~ A

- 对称性:若A~ B,则 B~ A

- 传递性:若A~ B,B~ C,则A~ C

- 若A~ B,则r(A)=r(B),|A|=|B|,tr(A)=tr(B),两者拥有同样的特征值,尽管相应的特征向量一般不同

- 若A~ B,且A可逆,则B也可逆,且B~ A。

AH

AH表示A(A是一个复矩阵)的共轭转置(对每个元素取共轭,然后对整个矩阵转置).

如果A是实矩阵,AH = AT。

- 性质

- xH AH = (Ax)H

AHA

定理:矩阵Am,n,R(A) = r,则AHA与AAH的特征值都是非负实数,所以其所有特征的算术平方根为矩阵A的奇异值。

- 证明

x是n阶矩阵AHA的对应于特征值λ的特征向量,可得AHAx=λx,

xHAHAx = λxHx 即 (Ax,Ax) = λ(x,x)

因为(Ax,Ax)>= 0,(x,x)>= 0,所以特征值λ>=0。

- 性质

- m×n矩阵A的奇异值的个数等于列数n(因AHA的阶数为n)

- A的非零奇异值的个数等于rankA(因rank(AHA)=rank(A))

酉矩阵

定义:若n阶复矩阵A满足AHA=AAH=E,则称A为酉矩阵。相对于实数矩阵,酉矩阵相当于正交矩阵,ATA=AAT=E

- 性质

- AH = A−1(酉矩阵)

- |A| = 1 行列式为1

- 充分条件是矩阵A的n个列向量是两两正交的单位向量。

酉相抵(正交相抵)

定理:酉相抵的矩阵有相同的奇异值。

- 证明

矩阵Am,n和矩阵Bm,n,若存在m阶酉矩阵U和n阶酉矩阵V,使得A = UBVH。由于UH=U-1,VH=V-1,所以可得:

AHA = VBHUHUBVH = V(BHB)V-1

所以可得 AHA与BHB是相似矩阵,即有相同的特征值。于是A与B有相同的奇异值。

- 什么是酉相抵?

矩阵Am,n和矩阵Bm,n,若存在m阶酉矩阵U和n阶酉矩阵V,使得A = UBVH,则称矩阵A与B酉相抵。

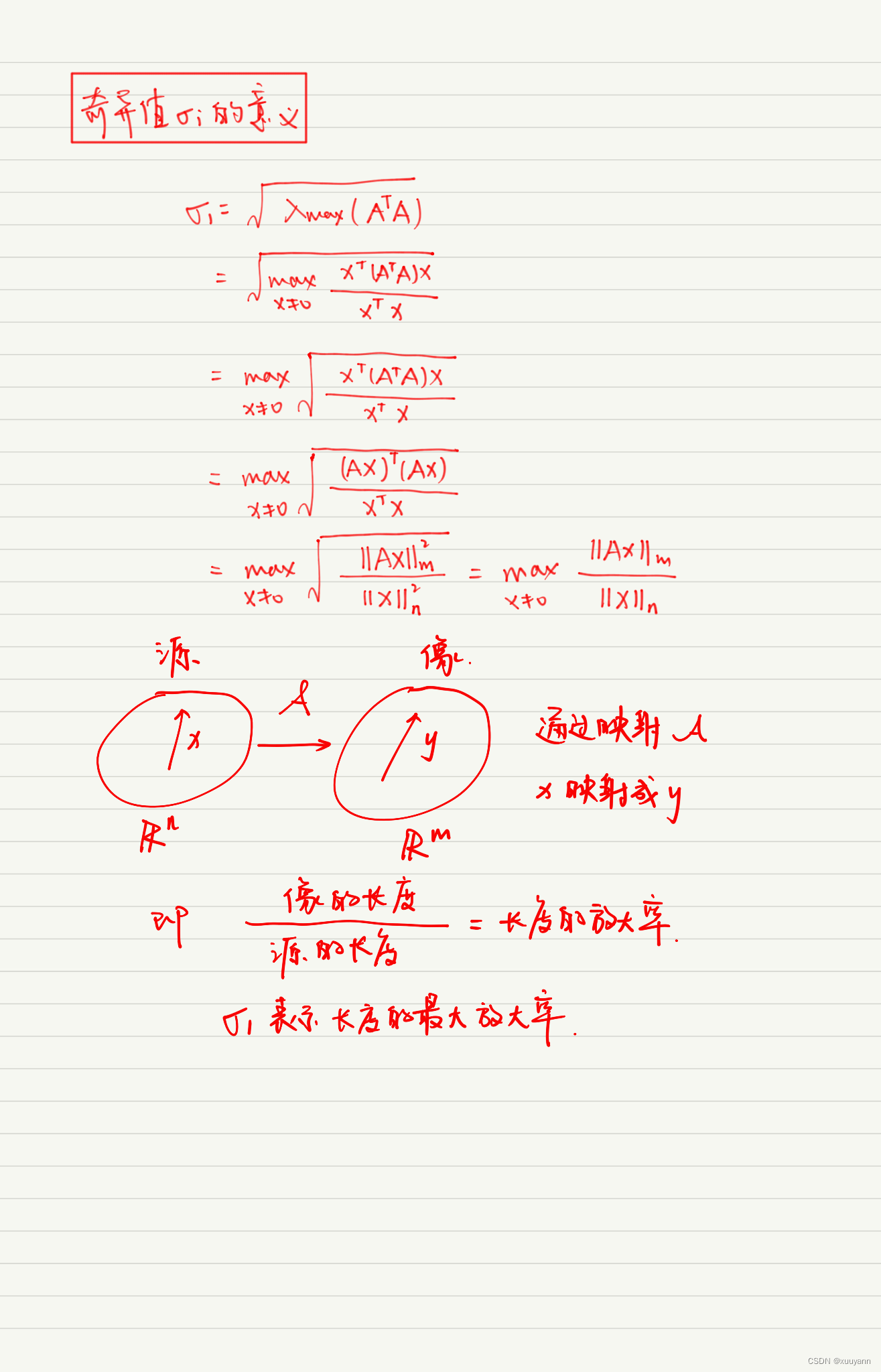

奇异值

奇异值是矩阵里的概念,一般通过奇异值分解定理求得。设A为m*n阶矩阵,q=min(m,n),A*A的q个非负特征值的算术平方根叫作A的奇异值。

奇异值分解式

矩阵Am,n,rank(A) = r,则存在m阶酉矩阵U和n阶酉矩阵V,使得:

其中Σ=diag(σ1,σ 2,…,σr),且σ 1≥σ 2≥…≥σr>0,而σi(i=1,2,…,r)为矩阵A的正奇异值。

A的奇异值由A唯一确定,但酉矩阵U和V一般不唯一,故矩阵A的奇异值分解一般不是唯一的。

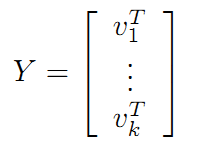

特征分解

对方阵 A 求取特征值和特征值对应的特征向量可以将方阵 A 进行特征分解为:

证明:假设方阵 A 有 n 个线性无关的特征向量 v1, v2, v3, … , vn,对应的特征值为 λ1, λ2, λ3, … , λn,令 V = ( v1, v2, v3, … , vn)

在进行特征分解时,一般将 V 的这 n 个特征向量标准化,即使得 V 中 n 个特征向量为标准正交基,满足:

VT = V-1 ,VTV = I

所以方阵 A 的特征分解公式为:

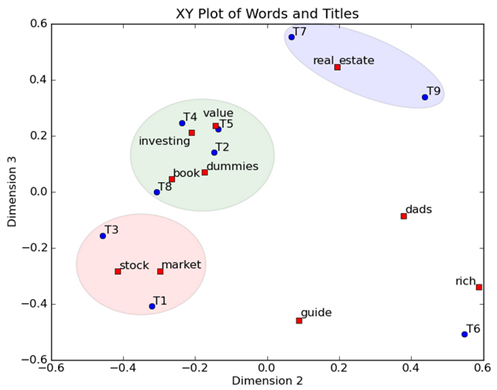

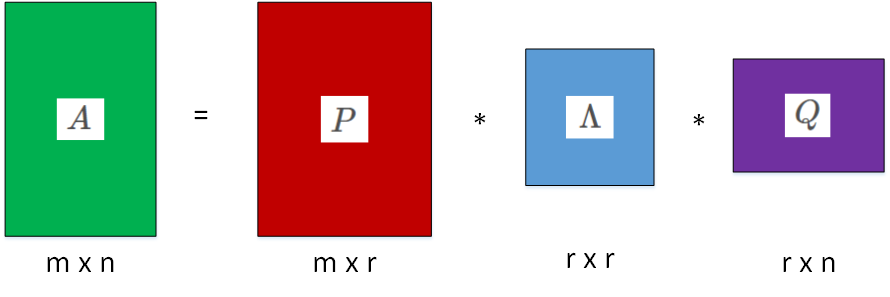

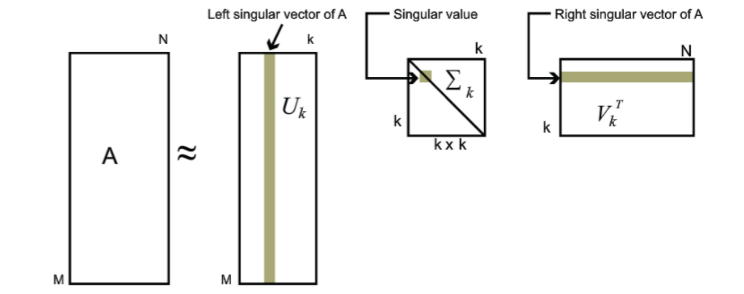

奇异值分解

矩阵的特征分解要求矩阵必须为方阵,那么对于不是方阵的矩阵而言则可以使用 SVD 进行分解,假设 A 是一个 m * n 的矩阵,则存在一个分解使得:

其中 U 为左奇异值矩阵,Λ 为矩阵 A 奇异值,除了主对角线上的元素以外全为0,V 为右奇异值矩阵

- 求右奇异值矩阵

虽然矩阵 A 不是方阵,但是 ATA 是一个 n * n 的方阵,于是对 ATA 这个方阵进行特征值和特征向量计算则有:

ATA = VΛVT

上式的V也就是 SVD 公式中的 V 矩阵。

- 求左奇异值矩阵

类似的,通过计算 AAT 方阵的特征值和特征向量可以得到 SVD 中的 U 矩阵。

AAT = (UΛVT)(UΛVT)T = UΛVTVΛTUT = UΛ2UT

可以看到 AA T的特征向量就是 SVD 中的 U矩阵。

- 求奇异值

可以看到 ATA 的特征向量就是 SVD 中的 V 矩阵,同时可以得到特征值矩阵等于奇异值矩阵的平方,也就是说特征值 λ 和奇异值 σ 存在如下关系:

python代码实现

- 求右奇异值矩阵

import numpy as np

a = np.array([[1,0,1],[0,1,1],[0,0,0]],dtype = np.float)

np.set_printoptions(precision=4, suppress=True)

w,v = np.linalg.eigh(a.T.dot(a)) #w特征值、v特征向量

w_index = np.argsort(w)[::-1] #返回逆序后的下标

w = np.sort(w)[::-1]

v = v[:,w_index] #正交矩阵V

v.T

array([[-0.4082, -0.4082, -0.8165],

[ 0.7071, -0.7071, 0. ],

[ 0.5774, 0.5774, -0.5774]])

- 求左奇异值矩阵

w,u = np.linalg.eigh(a.dot(a.T)) #w特征值、v特征向量

w_index = np.argsort(w)[::-1] #返回逆序后的下标

w = np.sort(w)[::-1]

u = u[:,w_index] #正交矩阵V

u

array([[ 0.7071, -0.7071, 0. ],

[ 0.7071, 0.7071, 0. ],

[ 0. , 0. , 1. ]])

- 求奇异值矩阵

w,u = np.linalg.eigh(a.dot(a.T)) #w特征值、v特征向量

w_index = np.argsort(w)[::-1] #返回逆序后的下标

w = np.sort(w)[::-1]

np.diag(np.sqrt(w))

array([[1.7321, 0. , 0. ],

[0. , 1. , 0. ],

[0. , 0. , 0. ]])

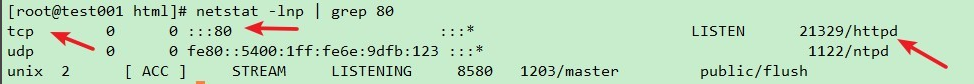

验证结果 np.linalg.svd

np.linalg.svd(a)

(array([[ 0.7071, -0.7071, 0. ],

[ 0.7071, 0.7071, 0. ],

[ 0. , 0. , 1. ]]),

array([ 1.7321, 1. , -0. ]),

array([[ 0.4082, 0.4082, 0.8165],

[-0.7071, 0.7071, 0. ],

[ 0.5774, 0.5774, -0.5774]]))

利用Python进行SVD分解对图像压缩

import numpy as np

import os

from PIL import Image

import matplotlib.pyplot as plt

A = Image.open("01.jpg", 'r') #(510, 320, 3)

a = np.array(A)

# 图片有RGB三原色组成,所以有三个矩阵

u_r, sigma_r, v_r = np.linalg.svd(a[:, :, 0]) # 奇异值分解 (510, 510) 、(320,) 、 (320, 320)

u_g, sigma_g, v_g = np.linalg.svd(a[:, :, 1])

u_b, sigma_b, v_b = np.linalg.svd(a[:, :, 2])

def restore(sigma, u, v, K): # 奇异值、左特征向量、右特征向量m = len(u) #高n = len(v[0]) #宽a = np.zeros((m, n)) #510, 320for k in range(K):uk = u[:, k].reshape(m, 1) # 取矩阵U的第k+1列数据 (510,) 转为 (510,1)vk = v[k].reshape(1, n) # 取矩阵V转置的第k+1行数据 (320,)转为 (1,320)a += sigma[k] * np.dot(uk, vk) # 前 第k+1 个奇异值 ,且 k * U * Va = a.clip(0, 255)return np.rint(a).astype('uint8')# 仅使用前1个,2个,...,50个奇异值的结果

K = 20

j = 1

plt.figure(figsize=(15,8))

for k in range(1, K+1,2):R = restore(sigma_r, u_r, v_r, k)G = restore(sigma_g, u_g, v_g, k)B = restore(sigma_b, u_b, v_b, k)I = np.stack((R, G, B), axis=2) # 将矩阵叠合在一起,生成图像i = Image.fromarray(I)plt.subplot(2,5,j)plt.imshow(i)plt.title('K ={} '.format(k))j +=1

plt.show()