1、特征值分解(EVD)

实对称矩阵

在理角奇异值分解之前,需要先回顾一下特征值分解,如果矩阵是一个

的实对称矩阵(即

),那么它可以被分解成如下的形式

其中为标准正交阵,即有

,

为对角矩阵,且上面的矩阵的维度均为

。

称为特征值,

是

的(特征矩阵)中的列向量,称为特征向量。

(注:在这里表示单位阵,有时候也用

表示单位阵。式(1-1)的具体求解过程就不多叙述了,可以追忆一下美好的大学时光的线性代数,简单地有如下关系:

)

一般矩阵

上面的特征值分解,对矩阵有着较高的要求,它需要被分解的矩阵,它需要被分解的矩阵为实对称矩阵,但是现实中,我们所遇到的问题一般不是是对称矩阵。那么当我们碰到一般性的矩阵,即有一个

的矩阵

,它是否能被分解成上面的式(1-1)的形式呢?当然是可以的,这就是我们下面要讨论的内容。

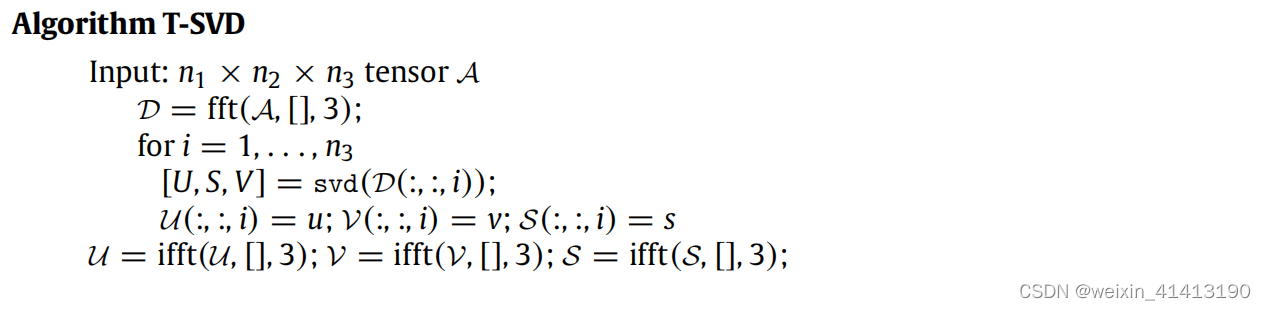

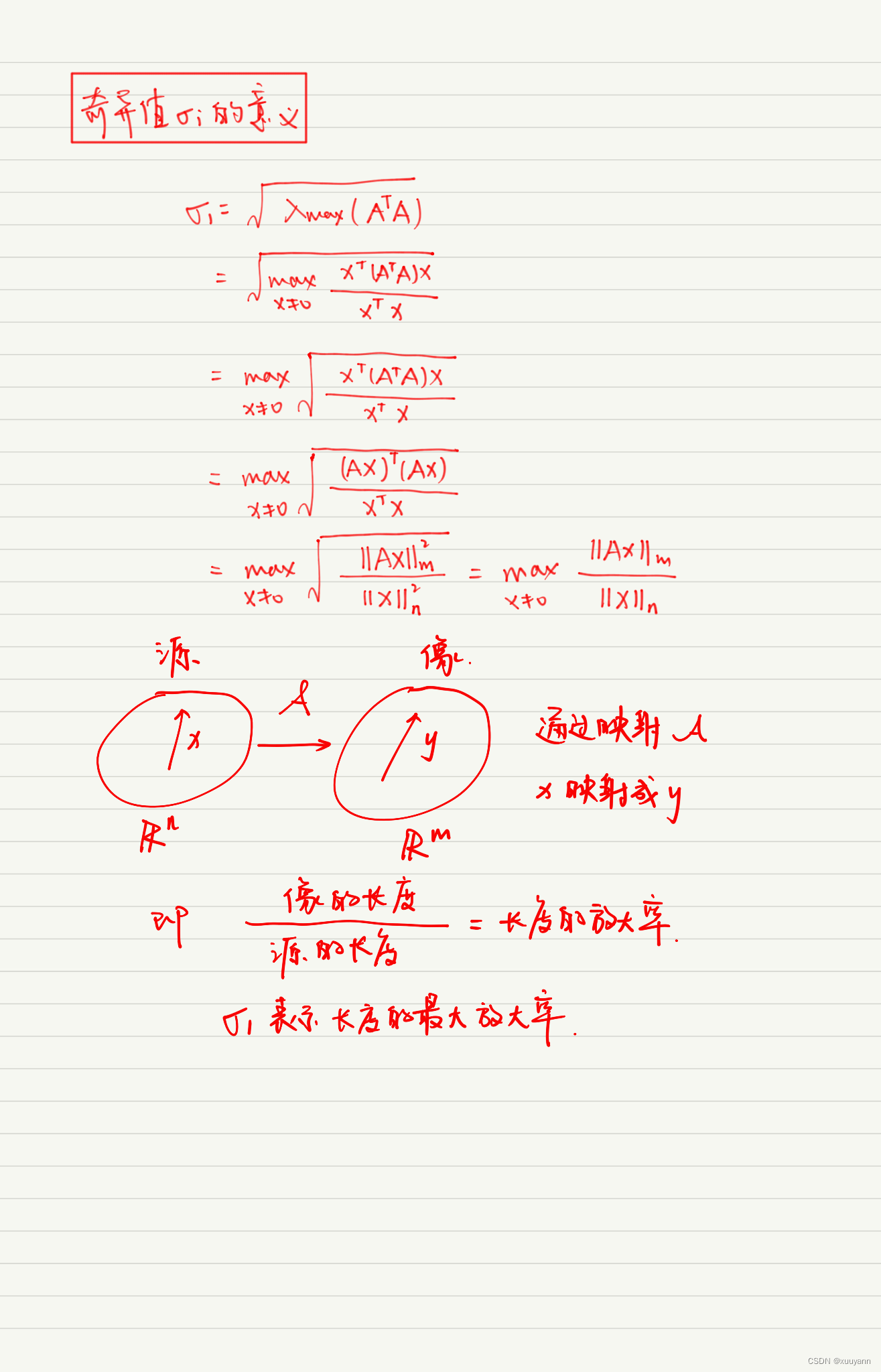

2、奇异值分解(SVD)

2.1 奇异值分解定义

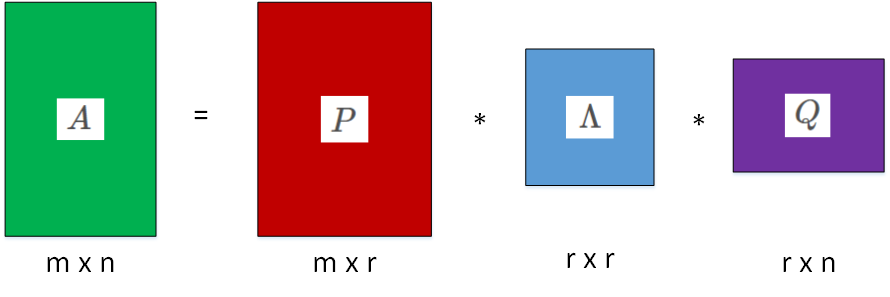

有一个的实数矩阵

,我们想要把它分解成如下的形式

其中和

均为单位正交阵,即有

和

,

称为左奇异矩阵,

称为右奇异矩阵,

仅在主对角线上有值,我们称它为奇异值,其他元素均为0。上面矩阵的维度分别为

。

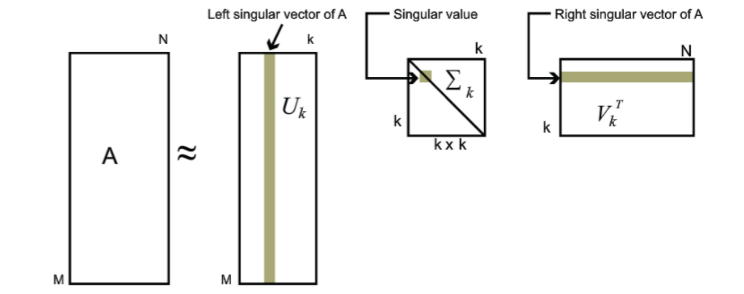

一般地有如下形式(这里是4*5)

图1-1 奇异值分解

对于奇异值分解,我们可以利用上面的图形象表示,图中方块的颜色表示值的大小,颜色越浅,值越大。对于奇异值矩阵ΣΣ,只有其主对角线有奇异值,其余均为0。

2.2 奇异值求解

正常求上面的不便于求,我们可以利用如下性质

(注:需要指出的是,这里与

在矩阵的角度上来说,它们是不相等的,因为它们的维数不同

,而

,但是他们在主对角线的奇异值是相等的,即有

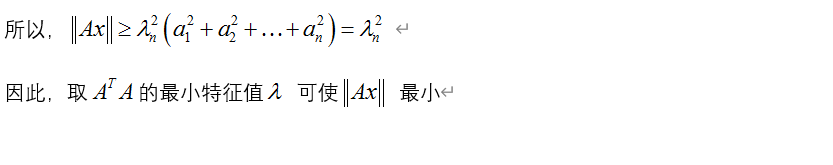

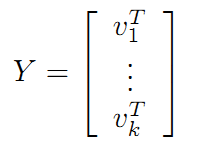

可以看到式(2-2)与式(1-1)的形式非常相同,进一步分析,我们可以发现和

也是对称矩阵,那么可以利用式(1-1),做特征值分解。利用式(2-2)特征值分解,得到的特征矩阵即为

;利用式(2-3)特征值分解,得到的特征值矩阵即为

;对

或

的特征值开方,可以得到所有的奇异值。

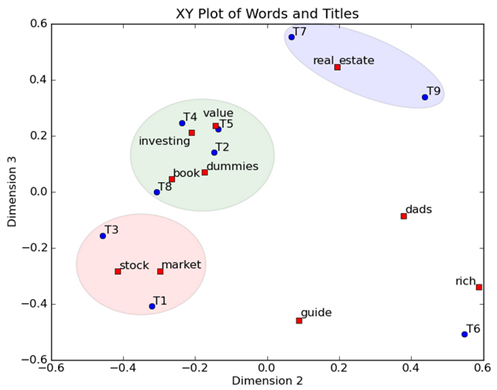

3、奇异值分解应用

3.1 纯数学例子

假设我们现在有矩阵,需要对其做奇异值分解,已知

那么可以求出和

,如下

分别对上面做特征值分解,得到如下结果

U =

[[-0.55572489, -0.72577856, 0.40548161],[-0.59283199, 0.00401031, -0.80531618],[-0.58285511, 0.68791671, 0.43249337]]V =

[[-0.18828164, -0.01844501, 0.73354812, 0.65257661, 0.06782815],[-0.37055755, -0.76254787, 0.27392013, -0.43299171, -0.17061957],[-0.74981208, 0.4369731 , -0.12258381, -0.05435401, -0.48119142],[-0.46504304, -0.27450785, -0.48996859, 0.39500307, 0.58837805],[-0.22080294, 0.38971845, 0.36301365, -0.47715843, 0.62334131]]

奇异值=Diag(18.54,1.83,5.01)