一年一度的1024来啦!

今年是我的第6个1024.

在这个专属节日里,我想随性记录一下当下的心境吧:

从2016年接触编程以来,自己各方面都有成长,可是不变的是从最初知道自己是小白到现在知道自己还是小白,笑死。

没有了当时的初生牛犊不怕虎,不知天高地厚的自信。

到现在只觉得自己太菜。

实在敲了又删,删了又敲,不知道写什么好,很多想说,又感觉不连贯,那我就随便写写吧,大伙就随便看看,就当我就是个随性的人,

我没有想到暑假期间的文章能给我带来这么多粉丝量,属实在我的预料之外,确实学习了一下别人关于那种长文章案例类的选择粉丝可看再发布可以收获不少粉丝量,这数字摆在这里确实给了我不少信息,怎么说呢,之前的文章都是涨阅读量、点赞量、收藏量,粉丝量涨的有些几乎平底,最近这两个月直接double,确实很高兴。

对于未来的迷茫,其实从未消减,甚至愈演愈烈,敢问路在何方,路在脚下,可是未来的路在岔路口我该怎么选,岔路口有哪些选择?当然了,这些都是未来的事,我现在能做的,大概就是走好脚下的路。

有人说,现在的人大多是活在当下,因为当下已经焦头烂额了,根本没有心思去想太远,可是,话 又说人无远虑必有近忧,当下的焦头烂额就是因为没有长远的目标和规划,才会特别在意当下的得失与感受,这也是为什么很多人很难再坚持去做一件延迟满足的事了,大多喜欢即时满足。

那么怎样去平衡想长远以及活在当下呢?我目前的状态大概是想着,有长远目标,并且珍惜每一个今天,其实两者并不冲突,我们大可以过好每一个今天踏向未来,享受今天的成长与进步与悲欢。

长远的目标太远,我也不知道未来几何,当下的选择大概是当下看似最好的选择,就像我们常说的最优解,但是其实人生的乐趣就在每一个解如果长远来看都未必是最优解,但是变数又是我们可以通过自己的努力把这个解创造成最优解。

前三年大概是每天都在奋斗中,鞭策自己要如何努力,但是今年开始我开始“慵懒”起来,大概也说不上是颓废,不再像之前那样每天早早起床,而是每天满足自己的睡眠,睡醒再说。这有一个极大的弊端就是作息不太规律,同时感觉每天的可用时间变少了。

近年来,感觉学习新知识的速度变慢了、遗忘的速度变快了。

人生路上的长河中,是不是怎样选择都会有遗憾呀?我们能做的大概就是努力让自己不后悔。

突然 对于遗憾和后悔两个词有点感觉:

遗憾,汉语词汇,汉语拼音为 yí hàn,英语是 regret,指不满意、悔恨、不甘心的事情,由无法控制的或无力补救的情况所引起的后悔。

后悔是一个汉语词语,读音:hòu huǐ,意思是对以前没有做的事情或做错了的事情感到难以释怀,心中总是惦记着,想着怎么自己当初没有去做或未做对而不断地感到埋怨和懊恼。

遗憾和后悔又有什么区别呢?

斗志低迷,何去何从?

也没有太多的迷茫不迷茫,未来有大致的方向,每一个今天都在奔向未来。

很多不太重要的事情,不过是生命中一片淡淡的云,一条浅浅的河,飘过了,经过了,也就忘记了。

放眼未来,活在当下,不断成长,不问归期。

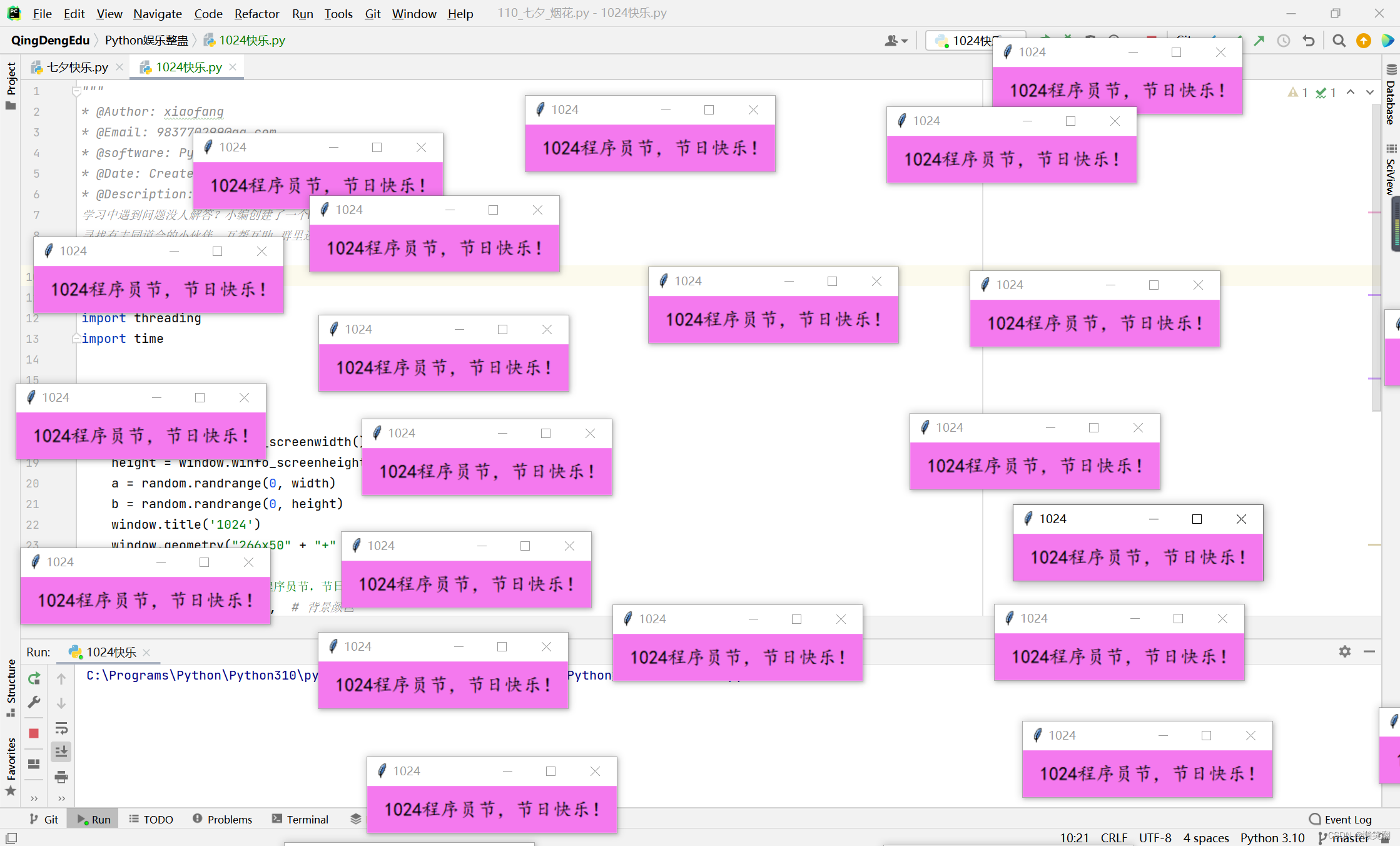

祝大家1024程序员节,节日快乐,前程似锦!!!

import tkinter as tk

import random

import threading

import timedef dow():window = tk.Tk()width = window.winfo_screenwidth()height = window.winfo_screenheight()a = random.randrange(0, width)b = random.randrange(0, height)window.title('1024')window.geometry("266x50" + "+" + str(a) + "+" + str(b))tk.Label(window,text=' 1024程序员节,节日快乐!', # 标签的文字bg='#F479EE', # 背景颜色font=('楷体', 15), # 字体和字体大小width=266, height=12 # 标签长宽).pack() # 固定窗口位置window.mainloop()threads = []

for i in range(24): # 需要的弹框数量t = threading.Thread(target=dow)threads.append(t)time.sleep(0.1)threads[i].start()

2022年10月24日

在长沙