1024,鸽了1024篇博文的我。。。

最近,硕士研究生刚开学,鉴于小菜鸡的我刚开始我的“填坑”之路,很忙,对,真的!!!

我在忙什么?

忙于脑网络的学习,还有神经网络架构方面的研究摸索。。。那么本文会很干嘛?不,没有,莫得时间写“硬干”文,所以这篇博客给大家分享一些我收藏的不错的网站。

| 不想听菜鸡废话的→ | 直接截图↓ |

|---|---|

| 超分辨率、原创、二次元、三次元壁纸网站 | https://wallhaven.cc/latest?page=2 |

| 超分辨率、高速稳定的电影&追剧网站 | https://ddrk.me// |

| 日更、连载、高速稳定的追番网站 | http://www.zzzfun.com/ |

| 全球实时摄像头(罗马、伦敦、纽约…) | https://www.skylinewebcams.com/ |

| 一个可以在线制作换脸视频的网站 | https://myvoiceyourface.com/ |

| 领略数学公式的图形之美,在线DIY体验的网站 | https://www.desmos.com/?lang=zh-CN |

| 感受数字媒体交互艺术之美,非常惊艳的网站 | https://www.desmos.com/?lang=zh-CN |

| P5.js制作的动态数字媒体艺术 | https://wangyasai.github.io/designtools.html |

第一个,超清,二次元,三次元,无马,绝美的壁纸网站-https://wallhaven.cc/latest?page=2

大家尽管冲吧,里面所有的图片都是免费无版权,可以直接使用的,至于可不可以商用不清楚。

第二个网站,超清,典藏,小众,精品,无马的高质量电影以及追剧网站,https://ddrk.me//。(速度快,清晰度高,适合收藏)

第三个网站,对于资深动漫二次元的老司机们的必备神站—http://www.zzzfun.com/。

不想多说,直接冲吧,帅小伙们,搞起!!!∑(゚Д゚ノ)ノ

第四个网站,在我们学习乏力,身体疲惫的时候,就看看这个有趣的网站,看看这个世界上不同角落的景色—https://www.skylinewebcams.com/(全球实时摄像头,记录世界的眼睛)

第五个网站,一个可以在线制作换脸视频的网站,搞起!——https://myvoiceyourface.com/

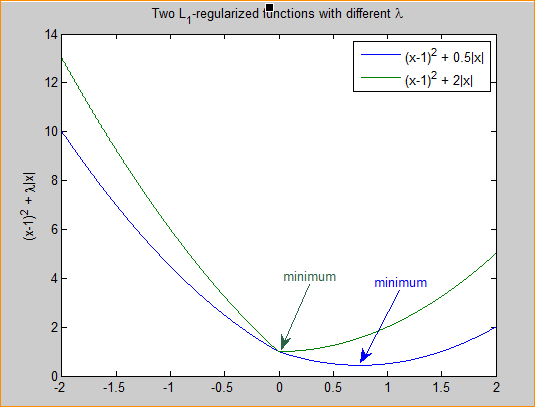

第六个网站,领略数学公式的图形之美,在线体验—https://www.desmos.com/?lang=zh-CN

第七个网站,感受数字媒体交互艺术之美,非常惊艳,你值得拥有——https://www.desmos.com/?lang=zh-CN

第八个网站,P5.js 制作的 动态数字媒体艺术 ——https://wangyasai.github.io/designtools.html

鸽了你们很多文章的菜鸡,不知何时能够填上这些坑,但愿,我们一起努力,加油,点赞过100,就更新我平时学习使用的各大视频资源网站及资料收集网站、还有提问网站。

祝大家1024快乐,要开心,要健康,要头发,要本子─(━ _ ─━✧)!!!