写在前面:博主是一只经过实战开发历练后投身培训事业的“小山猪”,昵称取自动画片《狮子王》中的“彭彭”,总是以乐观、积极的心态对待周边的事物。本人的技术路线从Java全栈工程师一路奔向大数据开发、数据挖掘领域,如今终有小成,愿将昔日所获与大家交流一二,希望对学习路上的你有所助益。同时,博主也想通过此次尝试打造一个完善的技术图书馆,任何与文章技术点有关的异常、错误、注意事项均会在末尾列出,欢迎大家通过各种方式提供素材。

- 对于文章中出现的任何错误请大家批评指出,一定及时修改。

- 有任何想要讨论和学习的问题可联系我:zhuyc@vip.163.com。

- 发布文章的风格因专栏而异,均自成体系,不足之处请大家指正。

又一年1024 - 我们在路上!

本文关键字:1024、程序员节、技术社区、个人成长

文章目录

- 又一年1024 - 我们在路上!

- 一、那年今日

- 1. 杨帆起航

- 2. 笔耕不辍

- 二、我的故事

- 1. 心路历程

- 2. 我与平台

- 三、厚积薄发

本来好不容易有时间可以更新一篇技术博客,但是十分不巧,又赶上了一年一度的程序员节,只能再随笔一篇文章了,我真是太难(开)受(心)了,竟然忍不住笑出了声。。。噗哈哈哈哈。

粉丝甲乙丙丁:我信你个鬼!!!再不更新干货信不信我差评、取关、举报,让你感受别样的三连???

咳。。。在下写文章的时候需要绝对的专注,嗯,对,就是这样,所以先溜了哈。。。

一、那年今日

时间真的过的好快,转眼间一年就这样过去了,还记得那年今日立下的Flag,要在CSDN打下一片江山,如今看来也算是做到了,更重要的是能够因此帮到很多人也很开心~

1. 杨帆起航

还记得当初信心满满,还特意为自己做了一张海报,以壮声势~如今看来还是有些自我了,从江河进入大海,才会感觉到自己的渺小,但是也正是因为这样,我们才会看到更为广阔的世界。

话不多说了,去年1024的文章链接在此,主要是对自己的介绍和在CSDN开宗立派的宣言:1024 - 在这里起航!

2. 笔耕不辍

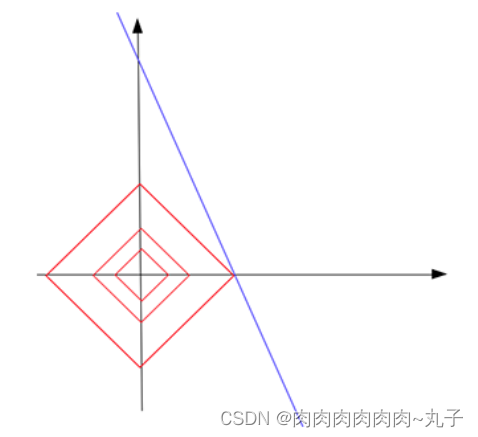

那么,现在来检讨一下自己,为什么要检讨呢,先看一下这张图:

虽然每个月都有更新,但是不算稳定,这个确实是自己太忙了,而且后面开始为博客配视频也要花很多精力,都是利用空闲时间。客观上好像也说的过去。。。但是看了这些数据真的觉得对不起大家:

虽然目前在CSDN只是一个小博主,但是几十篇文章就得到两千多个赞对我真的是很大的鼓励。当然,这里也有我分享文章帮大家解决问题之后厚着脸皮要的赞,实锤实锤,我是一头厚脸皮的猪。所以在接下来的时间里,一定给大家带来更成体系,更优质的文章,有必要也会进行翻新。

二、我的故事

这篇文章会继续为大家讲述我个人成长的经历,希望对大家有所启发,当然,如果是说过的内容就请大家进入传送门啦~

1. 心路历程

大家在开头的介绍中应该对我的职场生涯有了一定了解,最初是以一个开发者的身份踏入职场,从事Java开发,后来读研回炉重造,推开了大数据领域的大门,继续从事了一段开发工作后,最终实现了儿时的梦想,如愿的成为了一名讲师,具体的故事大家可以进传送门:从开发者到讲师的心路历程(结尾有彩蛋)。那么这一篇文章主要是想和大家分享一下,开发者、讲师与平台的关系,可以做怎样的经营。

2. 我与平台

在讲述之前,有必要先给自己浇上一大盆冰水,先客观的说明一下自己当前的情况。从我自己个人来说,也只不过是一个默默无闻的平凡者,每天幸运的做着喜欢的事,所以接下来想和大家分享的也许是我发自心底的快乐~

- 意气风发

有人说成长就是不断跌倒和爬起的过程,多年以后我自己也认识到了这句话。之所以跌倒是因为不够脚踏实地或能力不足,但适当的跌倒可以让我们更快速的成长。

最初,在学习和掌握了很多技术以后,就觉得自己可以独立作出很多东西,做一些自己独创的小玩意儿,做一个自己的博客网站,这些想法是抑制不住的。经过了很多的尝试也踩了很多技术的坑,域名、服务器/虚拟主机、开发部署,最后也只是满足了自己的热情和好奇心,开始思考做这些东西的意义是什么,毕竟学生时代本身就没有多少银子。

如果想做一个自己的技术社区,那么说到底这并不是一个产出原创文章和博客网站技术升级的问题,重点还是在于营造一个氛围和有一定的活跃。当然,如果你并不关心这些,只是单纯想做一个自己喜欢的东西或自己学到的东西分享于众那就另当别论。就算是做给自己心仪的小朋友,直接一个链接丢过去,说:This is only for you!想来也是棒棒的~

在云服务商白吃了自己几年费用之后发现,自己做的东西除了花费时间和金钱并没有太大的收获,当然主要原因还是因为自己太菜,毕竟只是平凡的大多数。按照自己之前的想法,入驻到平台并没有专属感,但其实是忽略了自己是更加渺小的这一事实,所以为什么不借个势呢?

- 按部就班

刚开始只是作为一个普通的使用者,遇到技术问题摆摆渡,鼓鼓鸽,时不时就会看到不少博客链接的地址。有的高频问题阅读量爆棚,尽管可能只有寥寥的几句话,但是却能直接解决问题。之前也有很多小伙伴儿一起探讨如何能写出大家爱看的文章?

其实对于这个问题每个人都有不同的看法,但是我觉得只要从结果出发:只要这是一篇能让人学到东西、解决问题、有所收获的文章,那就是好文章。每个人写出的文章都有各自的风格,在保证结果的情况下,去让文章的结构尽量清晰,内容尽量细致,语言尽量凝练,相信会有相应的读者喜欢的。不得不说,这个时候讲师的职业病总算起了点好作用。。。

所以在一开始的时候并不需要考虑太多,按部就班的去做,即使阅读量并不怎么样,即使看到大佬的爆文羡慕的流口水,但是想要收获结果总是要有一定的坚持,付出一定的时间,并且这些对自己都是有好处的,后文再表。

- 心有波澜

等你真正开始写文章或者发布自己的课程,你就会发现自己的关注点有了些些的变化。之前看到别人的文章主要看的是内容,现在就忍不住先瞟一眼粉丝数、文章阅读量,然后再回头看看自己的,忍不住去想如果自己来写这个问题会怎么写,原来大家爱看的是这样的文章吗?

有的时候想写一篇文章,也在考虑,要不要也来个“吊打XXX系列”、“深夜不睡觉竟然在厕所看XXX系列”?但是想想,一来自己技术达不到,吊打不了;二来也没有那个讲故事的能力,标题党估计是不可能标题党了,还是老老实实的编织自己的文章体系吧。

毛毛躁躁的过了一段时间,后来发现自己也是有够搞笑,为什么要有意无意的去比较呢,本来是一件分享知识的事情却变得顾虑重重,所谓功到自然成,这里希望刚刚开始写博客的小伙伴能保持住向上的势头,最后一定会收获满满。

- 受益匪浅

最后就来说说在各大平台的收获吧,在之前的文章中也有过一些涉及。首先就是写作的平台,我选择CSDN是因为有排名、奖章和各种激励机制,其他的方面就是可以及时的反应诉求,有一种和平台一起成长的感觉。

对于写作本身,一个是最为笔记的记录,另外一点就是可以提升自己总结归纳的能力,无形中也能锻炼思维能力,这是直接作用在本体上的好处。除此之外,博客也能丰富你的简历,让面试官看到你的技术积淀和技术栈,但是文章数量如果还比较少的话就不建议添加了。

在收获了一定的流量之后,也会带来各种合作的机会,如平台约稿,偶尔也许还可以恰个饭,无论是项目开发还是产品博文都是可以比较轻松获得的收入,在吃泡面的时候潇洒的给自己加个蛋是绝对没有问题的。

最重要的,可以以点带面,以此为基础可以打通你认为可以互通的平台,比如B站,在CSDN的文章中可以方便的嵌入(也可以以此为基础扩展到视频教程录制)。达到了一定的规模,就可以考虑变现的问题或者考虑发展为副业,并不需要投入太多的精力就可以获得收入。

三、厚积薄发

那么最后还是说说我自己吧,我一直觉得“博观而约取,厚积而薄发”很有道理,可能又是因为讲师的职业病吧。。。无论是学习技术还是知识的分享都应该是谨慎的态度,做自己喜欢的事情更值得用心去浇灌~这不,全新的社区已经内测上线了,感觉自己又可以大展拳脚了。

在这里各位小伙伴儿可以直接发帖提问呢~还可以看到博主发表的博客、上传的资源、发布的视频(后续会添加)。同时,作为提前进行变身测试的在下获得了和运营小姐姐直接对线的机会,大家有任何的问题也可以积极反馈哦(有图有真相)!

扫描下方二维码,加入官方粉丝微信群,可以与我直接交流,还有更多福利哦~