小米手机怎么截屏?手机的截屏其实都是差不多的,基本上都是三指向下滑动而达到截屏效果的,但基本都是全屏截图。小米手机区域截屏怎么做?如果想要做到任意位置的那种区域块截屏的话,该怎么做?下面就来看看吧!

首先想要做到这个的话,先要查看一下你的区域截屏的唤起方式,马上进入操作!

第1步:点开小米手机中的【设置】后,找到“更多设置”这个选项,(一般会在“应用设置”的下方);

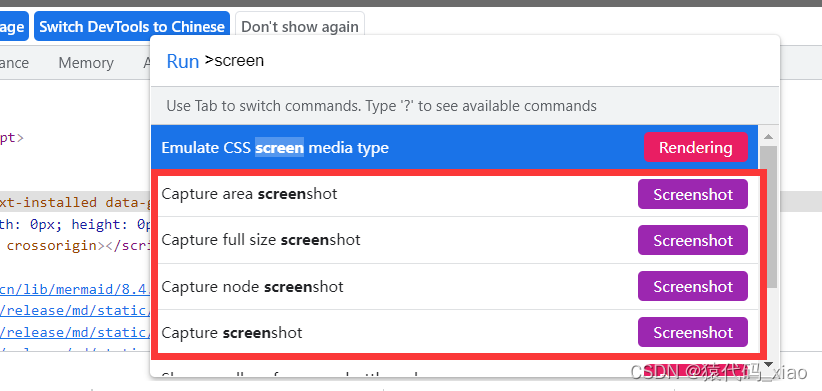

第2步:然后进入“按键快捷方式”选项,在里面可以看到一个“区域截屏”的设置,正常情况下是默认三指长按,但是你也可以设置自己喜欢的方式哦!

第3步:知道了或者重新设置了区域截屏的操作方式,现在就来试试效果吧!唤醒区域截屏后,可以看到整个屏幕的光线会暗淡下来,而且右上角可以选择自己喜欢的区域截屏形状,截图完成后发现效果还是比较好的。

是不是很简单?那么大家学会了吗?本期小米手机怎么截屏就到这里了,小米手机区域截屏更加灵活哦!做到了电脑上拥有的效果。如果大家喜欢本文技能分享的话记得给小编点赞、关注哦!任何疑问都可留言!

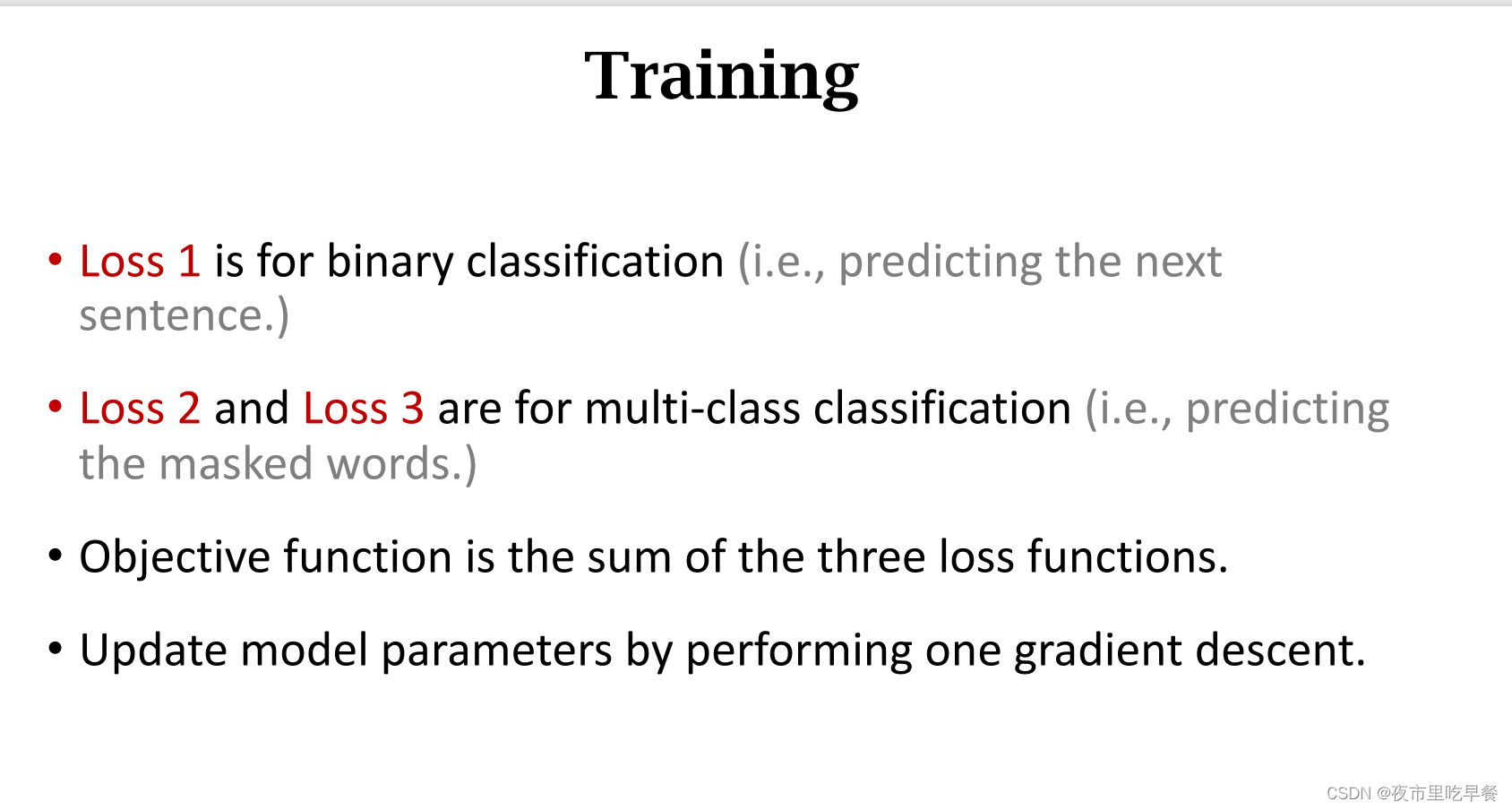

![[NLP自然语言处理]谷歌BERT模型深度解析](https://img-blog.csdn.net/20181021135853817?watermark/2/text/aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3FxXzM5NTIxNTU0/font/5a6L5L2T/fontsize/400/fill/I0JBQkFCMA==/dissolve/70)