前两篇博文主要介绍了torch如何构建全连接前馈神经网络,本篇博客主要针对经典卷积神经网络LeNet5进行复现。

卷积神经网络的基本结构

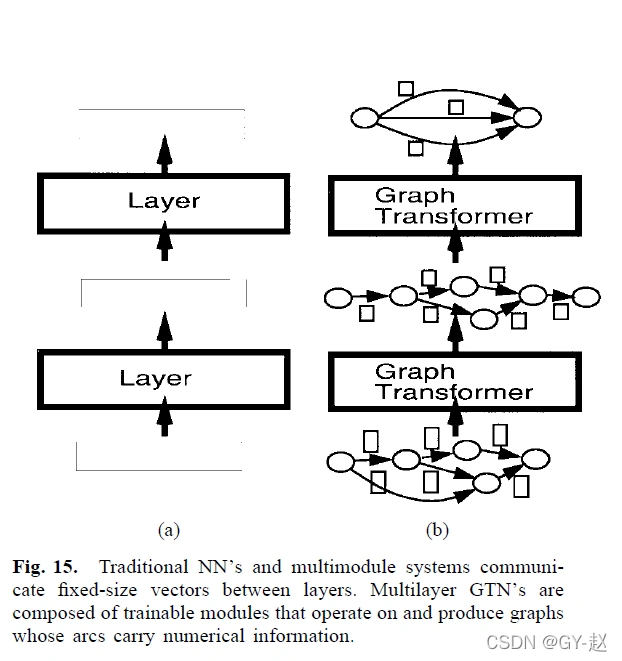

相信不少人都看过不少博客,也都对卷积神经网络的大致结构了解一点,这里本人站在神经元的角度来描述卷积神经网络的结构。先看一张图:

这就是神经元视角上卷积神经网络的大致结构,其中神经元x与神经元s之间构成卷积层;s神经元与u神经元之间构成池化/采样层;u神经元与v神经元之间构成全连接层,v与输出神经元o之间还有一层softmax用于归一化概率。可以看到,相较于全连接前馈神经网络来说,其差异是很明显的,这也体现出来了卷积神经网络的特点:稀疏性、参数共享性、等变性。

- 稀疏性,是指卷积层的两层神经元之间并非各个相连,而只是部分连接。例如上图的x1与s2之间就没有像全连接网络那样进行连接;

- 参数共享性,是指卷积层相连接的神经元之间参数是共享。例如上图中x2、x3与s2之间虚线相连,其中的参数便可以与参数a,b之间进行共享。

- 等变性,是指图片经线性变换后再卷积和卷积之后在进行线性变换,其结果是一样的。

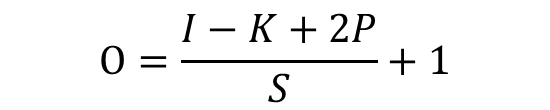

一张图片经过卷积层之后,输出图片的大小可以由下面的公式计算得到:

其中I(input)指的是输入图片的维度,K(kernel)是卷积核的维度,S(stride)是卷积核每次移动的步长,P(padding)代表卷积时填充方式(指在图像四周填充一定量的像素),此值一般在模型中用不着,所以一般设置为0。

既然如此,读者们可否通过此公式来推断出上面卷积神经网络中卷积核的大小和输入维度的大小呢?

Pytorch中如何表示卷积层

torch中也是通过其中的nn模块来表示卷积层的,对应于类nn.ConvXd(),其中X可以取1,2,3,X的选择与卷积核维度个数有关,例如X取1时,所选择的卷积核为一维的向量,X取2时,所选择的卷积核为二维的矩阵。LeNet5论文中给出的模型是输入一张灰度图,这里我们选择函数nn.Conv2(),让我们先看看类nn.Conv2d()构造方法的参数列表:

def __init__(self, in_channels, out_channels, kernel_size, stride=1,padding=0, dilation=1, groups=1,bias=True, padding_mode='zeros'):

构造方法中有些参数是缺省的,这里我们只看前三个参数。

其中in_channels和out_channels指的是输入张量所具有的的通道数和输出张量所具有的的通道数,显然这个参数需要通过输入输出张量的维度进行判断;kernel_size就是指卷积核的大小。

LeNet5模型的整体结构

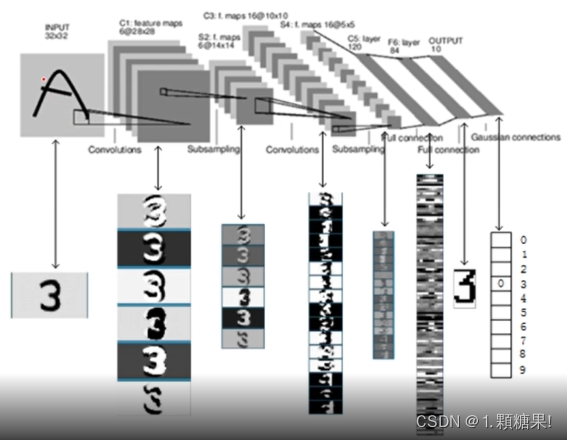

以下便是LeNet5模型的整体结构,此图片来源于提出LeNet模型的论文《Gradient-Based Learing Applied to Document Recognition》:

可以看到,LeNet5由两个卷积层构成,每个卷积层后都跟有2*2大小的池化层。经过卷积操作之后,便进入三个全连接层进行分类预判,此时的工作与全连接前馈神经网络类似。

这里我给出我目前实现的较为实用的模型代码:

class LeNet5(nn.Module):def __init__(self):super(LeNet5, self).__init__()self.conv1 = nn.Sequential(nn.Conv2d(1, 6, 5, 1), nn.ReLU(), nn.MaxPool2d(2))self.conv2 = nn.Sequential(nn.Conv2d(6, 16, 5, 1), nn.ReLU(), nn.MaxPool2d(2))self.fc1 = nn.Sequential(nn.Linear(5*5*16, 120), nn.BatchNorm1d(120), nn.ReLU())self.fc2 = nn.Sequential(nn.Linear(120, 84), nn.BatchNorm1d(84), nn.ReLU())self.output = nn.Sequential(nn.Linear(84, 10), nn.BatchNorm1d(10))def forward(self, input):out = self.conv1(input)out = self.conv2(out)out = out.view(out.shape[0], -1)out = self.fc1(out)out = self.fc2(out)out = self.output(out)out = torch.nn.functional.softmax(out, dim=1)return out

可以看到,模型中除了卷积层,还有最大值池化层nn.MaxPool2d和批归一化操作层nn.BatchNorm1d。代码中的nn.MaxPool2d(2)意思是最大值池化层是二维的2*2矩阵;nn.BatchNorm1d归一化的结构是使得一维的向量以近乎正态分布的形式存在于对应的矩阵中,其主要的摸底是防止训练时出现梯度爆炸以及损失函数波动较大的问题,此函数我们会在后面的效果展示环节看看其实际作用。

代码设计的思路整体上就是参照论文中所描述的架构进行的,其实只要掌握torch基本的用法,构造模型的代码是很好写的~

准备数据集

建议个人在复现此模型时自己去下载对应的mnist数据集,本人在此直接给各位读者下载地址:

链接:https://pan.baidu.com/s/1u16Hwf4WVD7RnXUv_hMdlw 提取码:nii8

文件包解压之后就可以直接使用了,解压之后要记住minst_data文件夹的路径!

接着就是对数据的预处理了,这里先给出代码:

def load_data():transform = transforms.Compose([transforms.Grayscale(num_output_channels=1),transforms.Resize([32, 32]),transforms.ToTensor(),transforms.Lambda(lambda x: x.repeat(1, 1, 1)),transforms.Normalize((0.1307, ), (0.3081, ))])trainset = ImageFolder("F:/DataSet/mnist_data/mnist_train_jpg/", transform=transform)testset = ImageFolder("F:/DataSet/mnist_data/mnist_test_jpg/", transform=transform)trainbatch = DataLoader(dataset=trainset, batch_size=60, shuffle=True)testbatch = DataLoader(dataset=testset, batch_size=100, shuffle=False)return trainbatch, testbatch

这里面的代码涉及torch对图像的变换和将图像打包成批。

- “transforms”是torchvision中的模块,torchvision是torch在图像处理运用中的库,transforms.Compose表示将对图像的所有步骤依次压缩抽象成为一个类,当传递此类的对象时,程序就会依次对图像进行Compose中的操作,例如,对象transforms就依次包含对图像灰度图读入(Grayscale)、大小变换(Resize)、张量转化(ToTensor)、维度调整(Lambda)、数据归一化(Normalize)五个操作;

- ImageFolder指的是去指定的文件路径下读取图像,并对图像进行上述的五步处理,最终返回的值就是用于测试的数据集;

- DataLoader指的是将数据集打包分批次,参数batch_size指的是每批次图片的个数,shuffle指的是分批次时图片的顺序是否打乱。DataLoader最终返回的是一个列表,列表中的每个元素包含某批次的图像张量和数据标签Label。

网络训练

这里先给出代码:

def train():if model.is_file():net = torch.load('../model/LeNet5.cpkt')net.eval()else:net = LeNet5()times, loss_list = 20, []optimizer = optim.SGD(net.parameters(), lr=0.01)loss_func = nn.CrossEntropyLoss()for epoch in range(times):for batch, (image, label) in enumerate(trainbatch):optimizer.zero_grad()yhat = net(image)loss = loss_func(yhat, label)loss.backward()optimizer.step()if batch % 100 == 0:print("epoch=%d, %d batches(60/batch) images passed, loss==%.8f" % (epoch, batch, loss))loss_list.append(loss)torch.save(net, '../model/LeNet5.cpkt')return loss_list

卷积神经网络的训练流程和全连接网络相同,都是使用BP算法进行训练,程序一开始判断是否已有之前训练过的模型,如果有就载入继续训练。由于是分类问题,所以这里的损失函数设为交叉熵损失CrossEntropyLoss。由于我们是进行批量处理的算法,所以严格来说这里的梯度下降算法是批量梯度下降(BGD)。epoch指的是所有批次迭代的轮数,迭代的轮数越多,模型参数越好。程序的最后保存了训练好的模型结构,以及返回每一批次损失函数的值形成的列表loss_list。

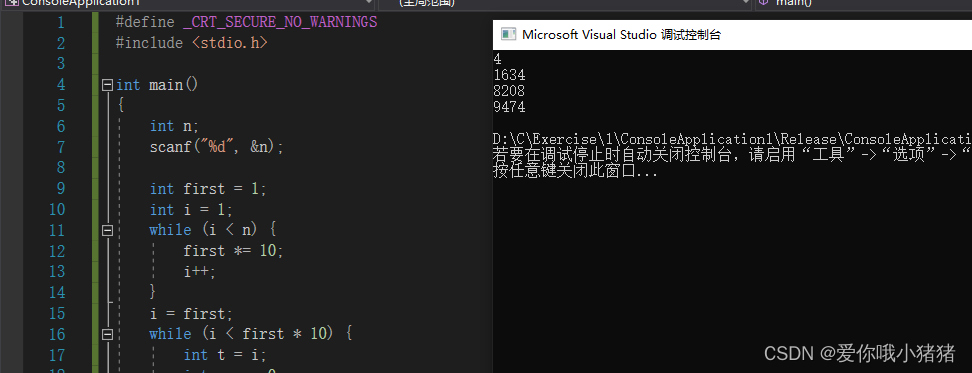

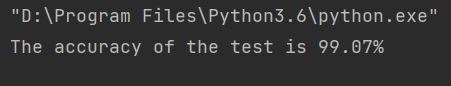

这里展示一下训练的结果:

上面是未进行网络输出归一化(nn.BatchNorm1d),得到的交叉熵损失变化曲线。可以看到,未进行归一化时,曲线波动很大,参数很不稳定,虽然最终走向了收敛,但是测试的正确率应该不算很高(97.64%)。训练时,设置的迭代轮数为20。

上面的图是进行网络输出归一化之后的曲线。可以看到,此曲线相较于上一张图,波动明显减少,最终测试的正确率也很高。

模型测试

这里直接给出测试代码,不解释:

def test():trainbatch, testbatch = load_data()network = torch.load('../model/LeNet5.cpkt')network.eval()correct, total = .0, .0for image, label in testbatch:yhat = network(image)_, prediction = torch.max(yhat, 1) # Get the result of classificationtotal += label.size(0)correct += (label==prediction).sum() # Record the correct numbersreturn float(correct) / float(total)print("The accuracy of the test is %2.2f%%" % (test()*100))

在进行网络输出归一化之后,测试的正确率如下:

后续

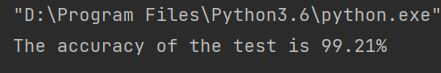

之后我又对网络进行的训练,同样也是迭代20轮,得到的交叉熵损失曲线如下:

再迭代20轮,又得到交叉熵损失曲线图:

可以看到,网络批量梯度下降350次后交叉熵损失就基本上保持在1.47上下了,也就是说此时网络模型最优参数基本到达了。最终测试集测试的正确率如下:

99.21%,确实蛮高的(测试集包含10000张手写数字图像)。

代码整合

LeNet5代码复现

此链接里面没有mnist那70000张手写数字图像的数据集,请读者们自行去我上面提到的百度网盘链接里下载。

作业

读者们可以尝试一下自己去网上寻找物体分类的数据集,自己搭建一个CNN模型进行训练。如果你能顺利完成,说明你对卷积神经网络已经又初步的认识了。