文章目录

- 前言

- 一、deepin是什么?

- 二、安装deepin

- 总结

前言

今天原本打算安装ubuntu20.04,一时兴起顺便安装一下国产os,感觉使用体验很不错,国产系统看见了希望,所以写这篇文章记录“深度linux”这个国产os的安装过程,同时得到爷爷患癌症去世的消息,心里很不是滋味,所以读者们还是要以自身健康为第一位,该文章参考了如下链接:安装Ubuntu 20.04 系统

之前安装过双系统的点击这里删除系统与EFI引导分区

提示:以下是本篇文章正文内容,下面案例可供参考

一、deepin是什么?

deepin(Linux Deepin深度操作系统)由深之度科技有限公司在Debian基础上开发的Linux操作系统

2019年,华为开始销售预装有deepin操作系统的笔记本电脑。

系统采用了Kernel 5.4和Kernel 5.7双内核机制,同时用户操作界面也得到了大幅度的调整 ,所以使用体验比ubuntu流畅许多 。deepin是好用的,友好的,方便的

UOS是Linux在中国的商业发行版,主要开发工作由Deepin团队完成,Deepin是社区版,不会被UOS取代,UOS只用于商业用途

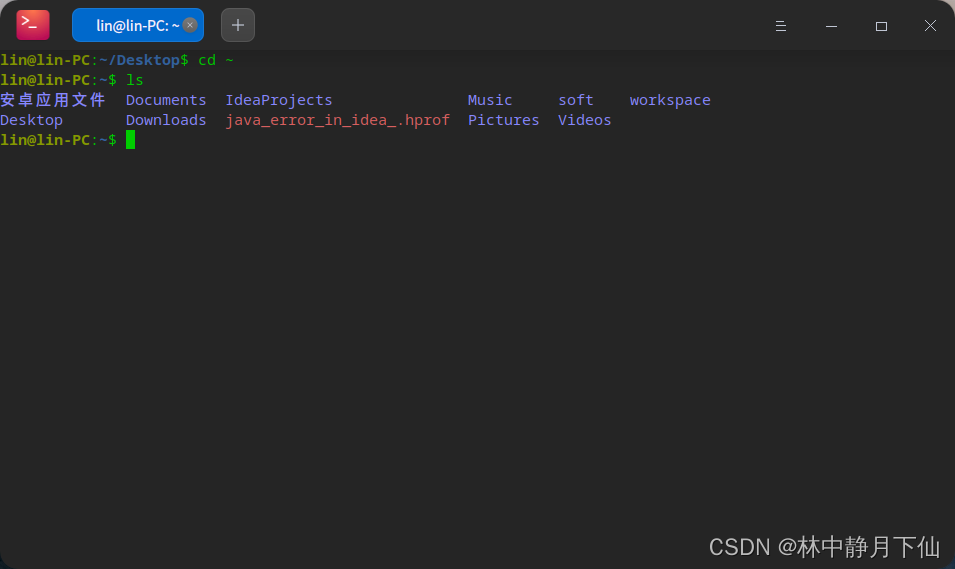

二、安装deepin

| 1:从官网下载镜像与启动盘制作工具 | http://www.deepin.org/download/ |

|---|---|

| 2:制作启动盘 | 1:选择镜像文件 2: 选择U盘 //U盘最好大于4G,U盘需要提前格式化为fat32  制作完成后,拔掉U盘即可 |

| 3:划分磁盘空间给deepin系统使用 | 1:win+x进入磁盘管理 2:删除卷(删掉你不用的磁盘分区)  |

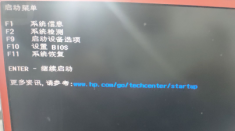

| 4:安装deepin系统 | 1:把U盘插入电脑 2:电脑关机,重启电脑,一直按ESC按键,弹出如下所示:  3:选择F9启动设备选项,选择你的U盘进行UEFI启动 4:设置语言  5:设置安装位置(这个地方重要!!!!!)   6:点击下一步等待安装完成。后面按照提示点击就ok! |

| 5:将deepin设置为开机启动 |  |

| 安装后的效果图展示 |    |

总结

1:deepin使用卡顿关掉窗口特效

2:安装wine版本的QQ应用会非常卡顿,谁叫鹅厂应用不适配linux系统,这个没办法,linux-for-qq可以讲究用一下

3:如何自己选择启动哪个系统

答:开机按esc,在启动设备里面选择你想要启动双系统的哪一个系统