简介

深度操作系统(deepin)是一个致力于为全球用户提供美观易用、安全稳定服务的Linux发行版,同时也一直是排名最高的来自中国团队研发的Linux发行版,下面我们开始从下载镜像到安装系统一步步进行讲解。

系统下载

Deepin Desktop 20.3 最新的版本20.5装好几次都失败了,不建议使用最新

系统安装

通过系统镜像工具制作成U盘启动安装盘,重启电脑选择闪存启动即可

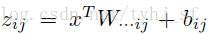

1. 开始安装

选择第一项启动图形化安装

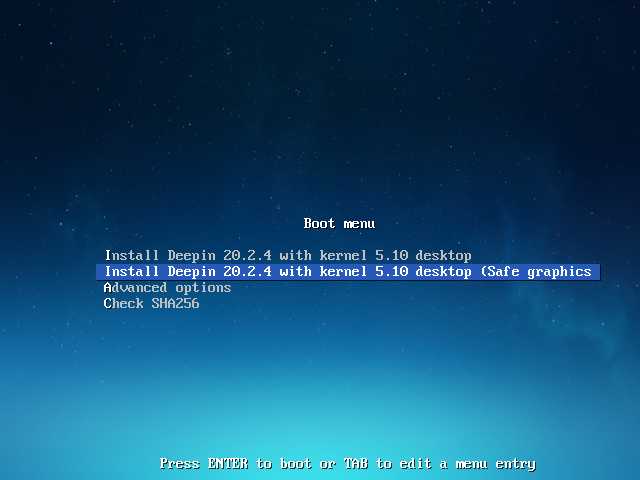

2. 选择语言

安装界面语言选择

选择 简体中文 并勾选 我已仔细阅读并同意

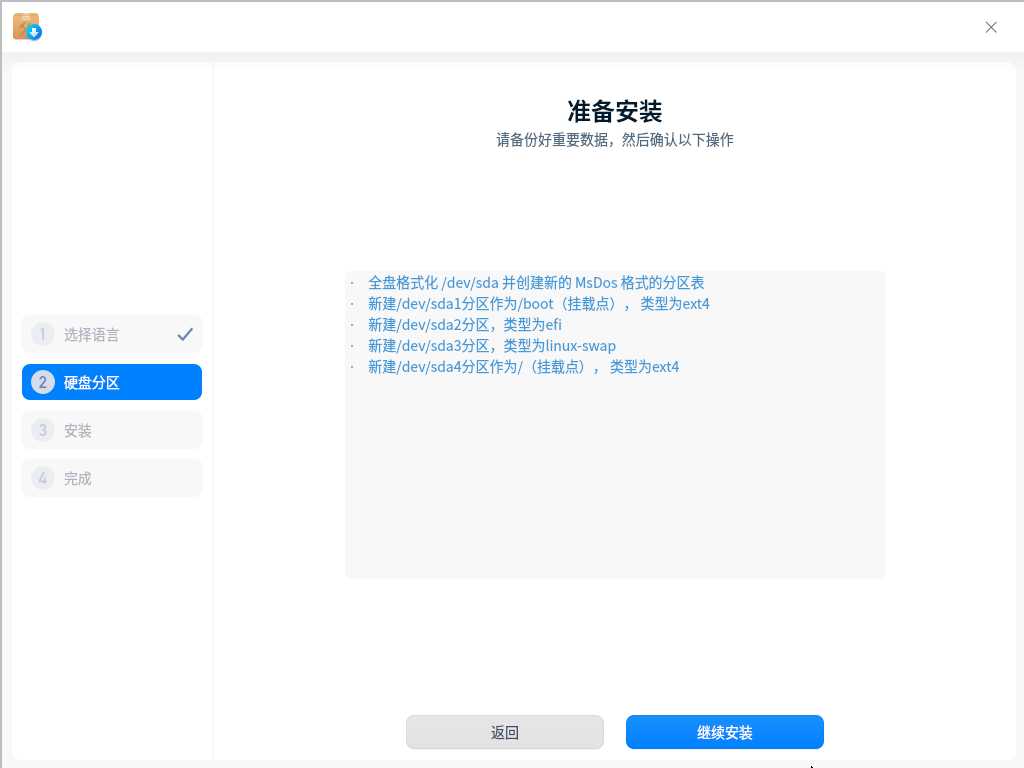

3. 硬盘分区

自动分区

没什么重要东西就选择全盘安装,系统会自动分区,点击下一步继续安装

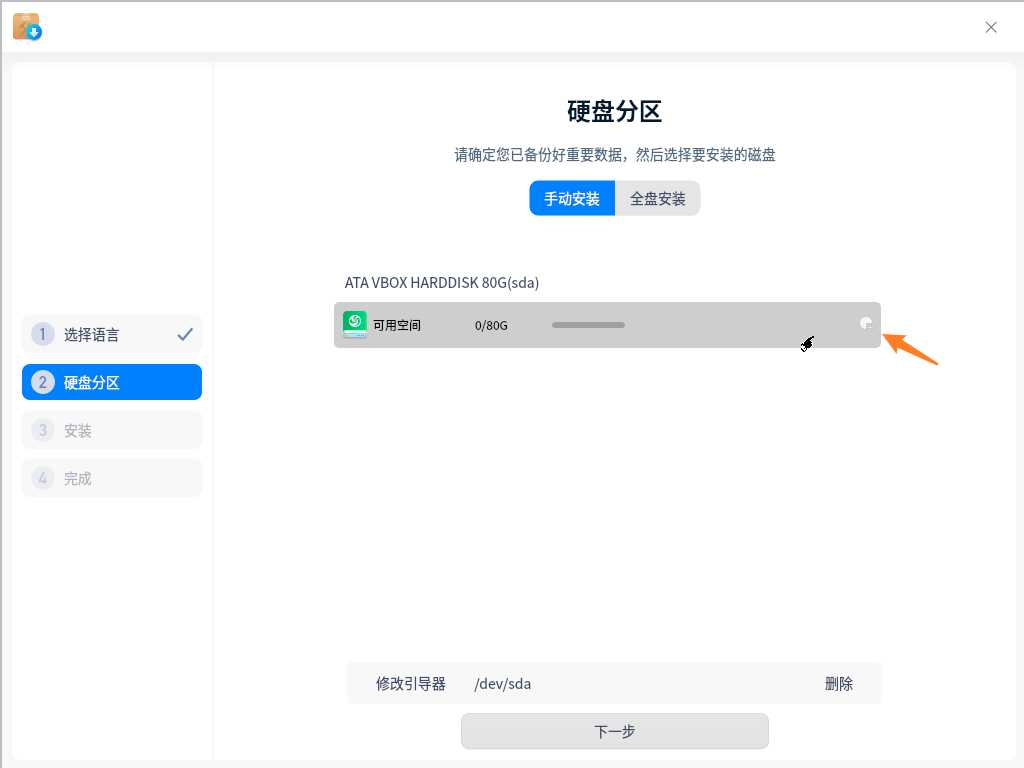

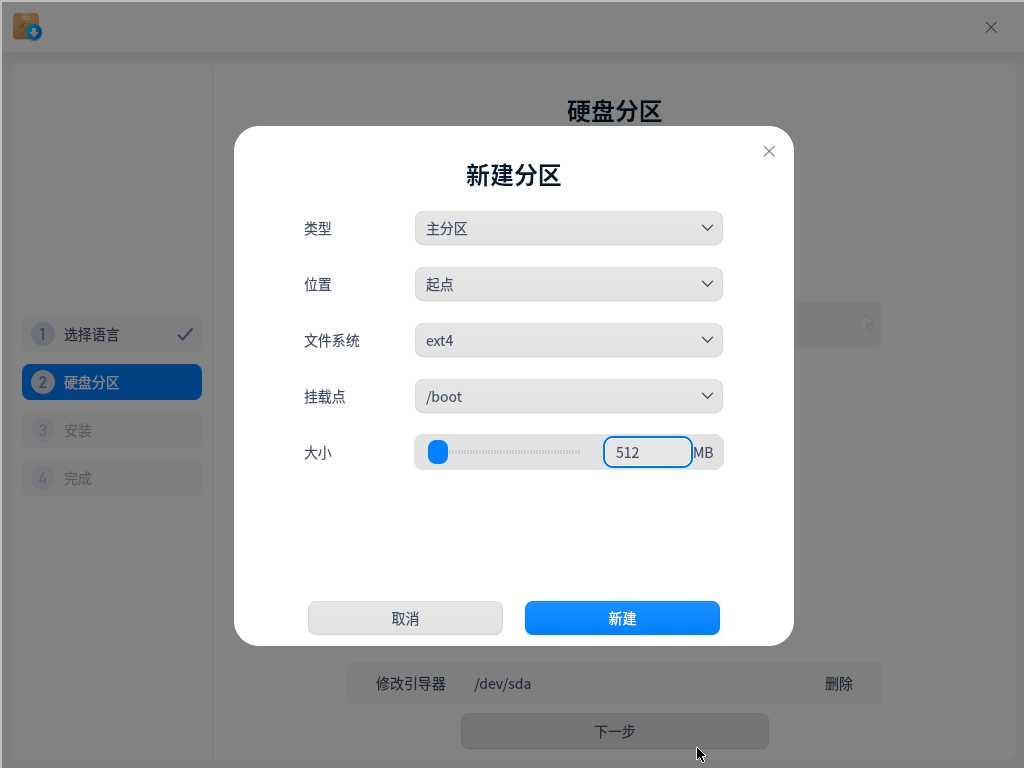

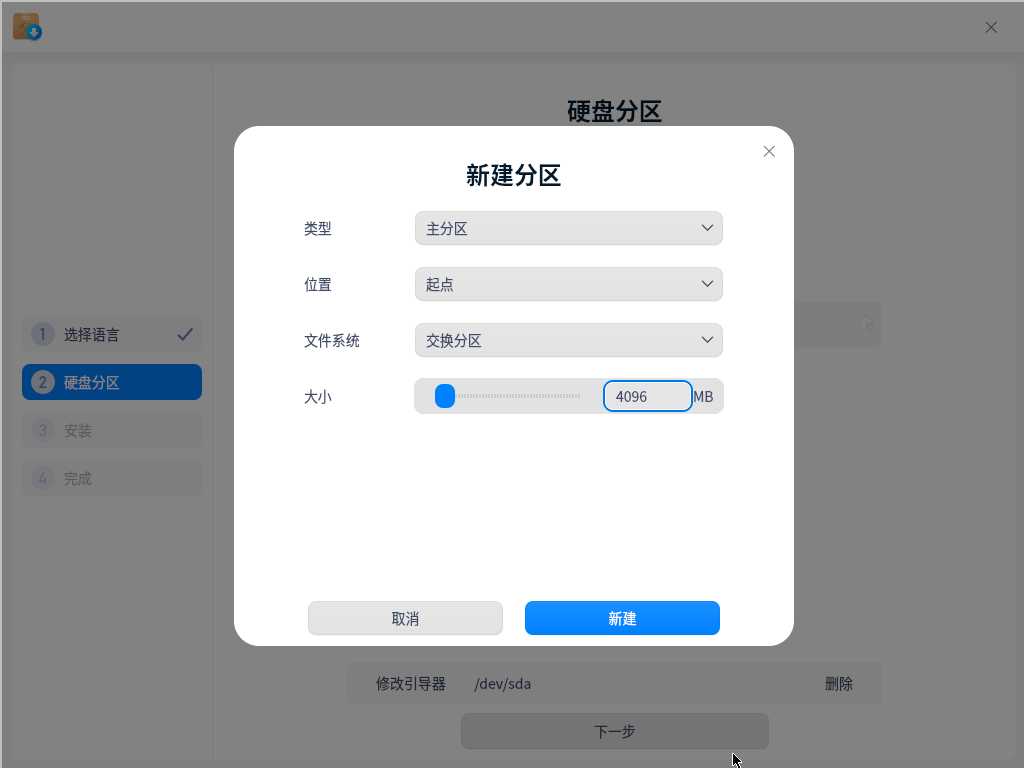

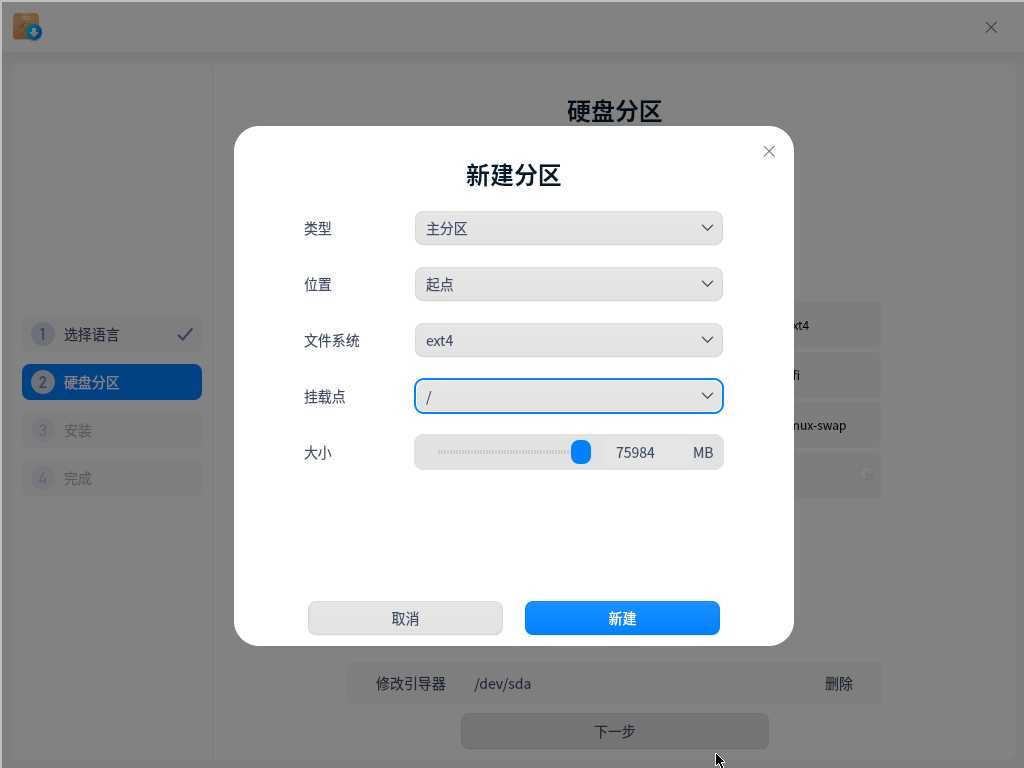

手动分区

选择磁盘右边分配键

启动分区 /boot 500M

交换分区 Linux-swap一般设置4-8G

根分区 / 将剩余磁盘空间都给它

如果需要Efi的 配置 efi 默认300M

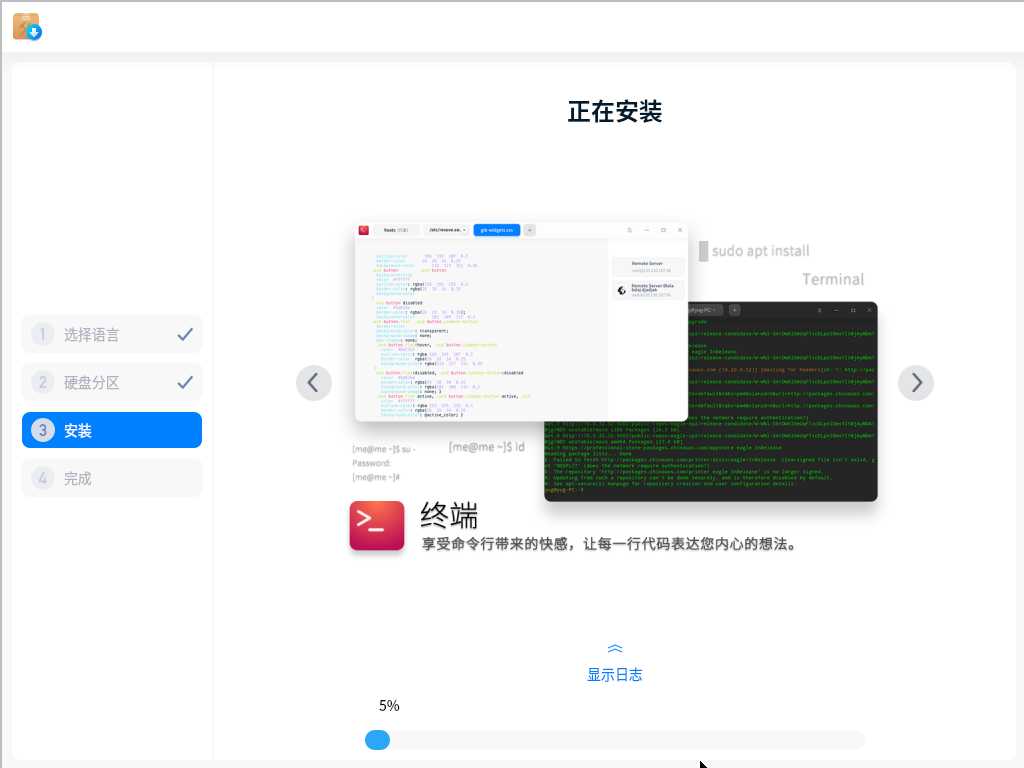

4. 开始安装

安装过程需要耐心等待,可以看下系统介绍。

也可以点开日志查看安装状态。

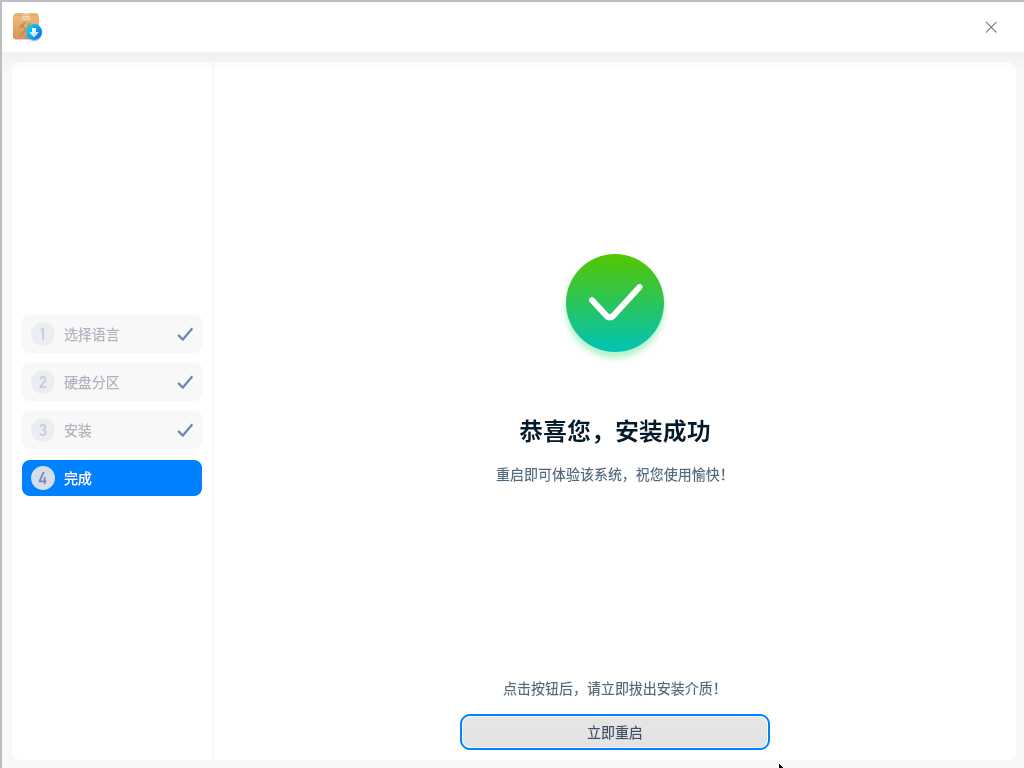

5. 完成安装

点击 立即重启 将系统重新启动

开始使用

1. 登录系统

选择第一项进入系统,也可稍等片刻后自动进入系统。

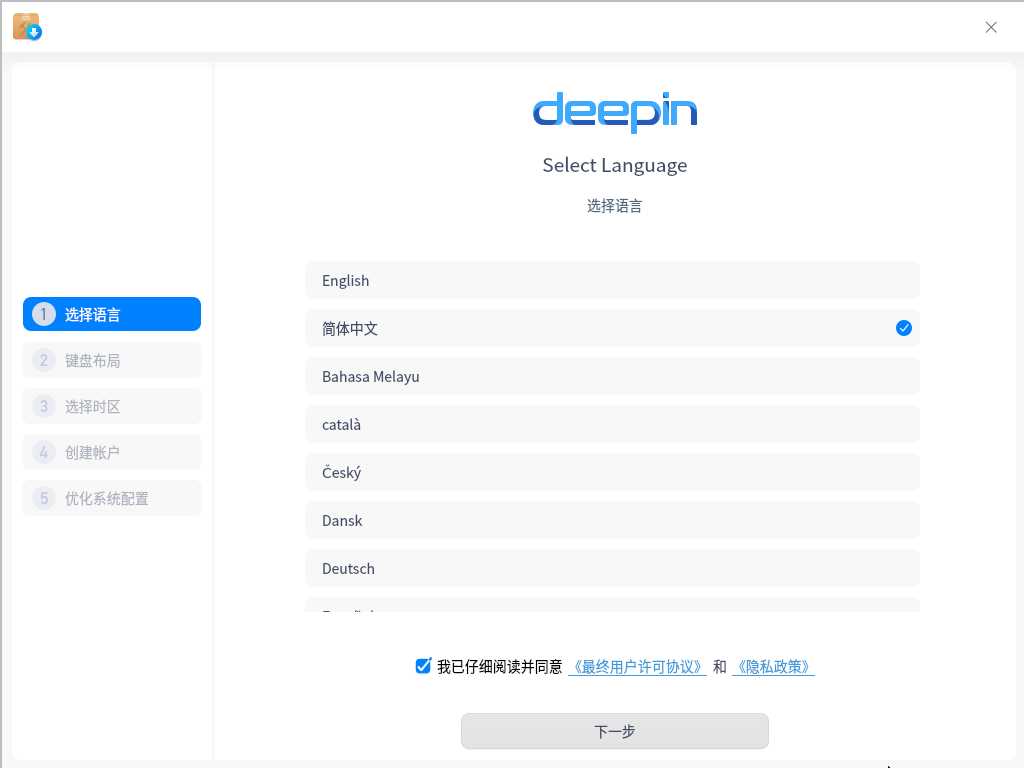

2. 选择语言

选择系统语言,简体中文

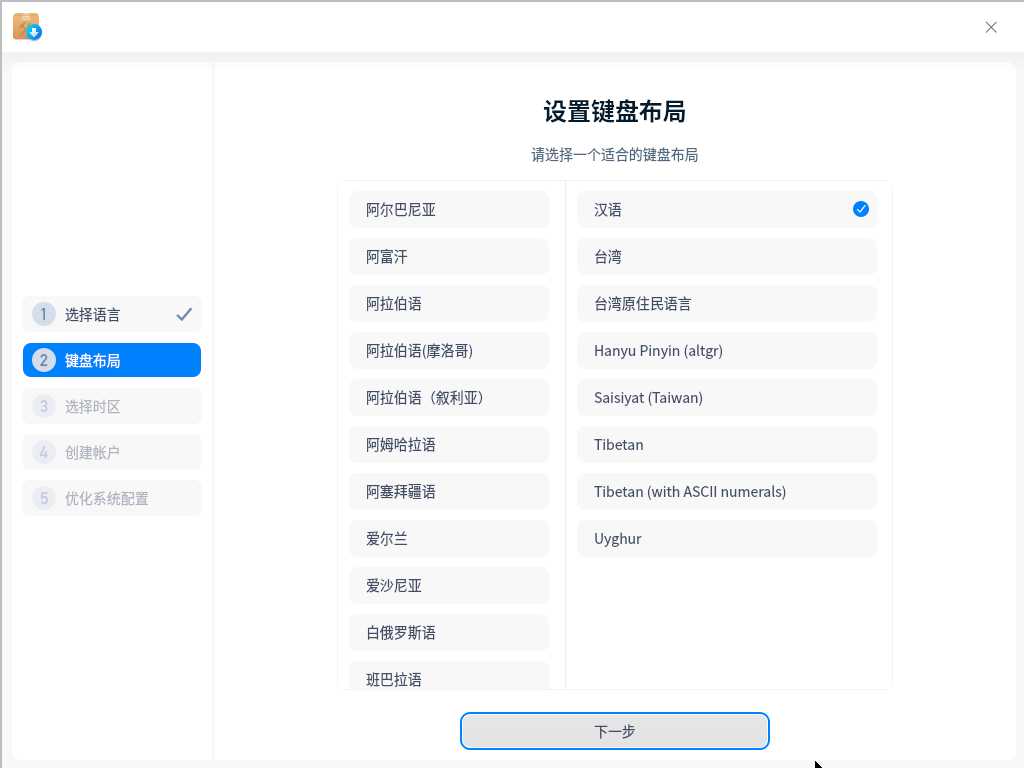

3. 键盘布局

选择 汉语

4. 选择时区

时区选择 上海

5. 创建账户

设置用户名称、计算机名以及登录密码

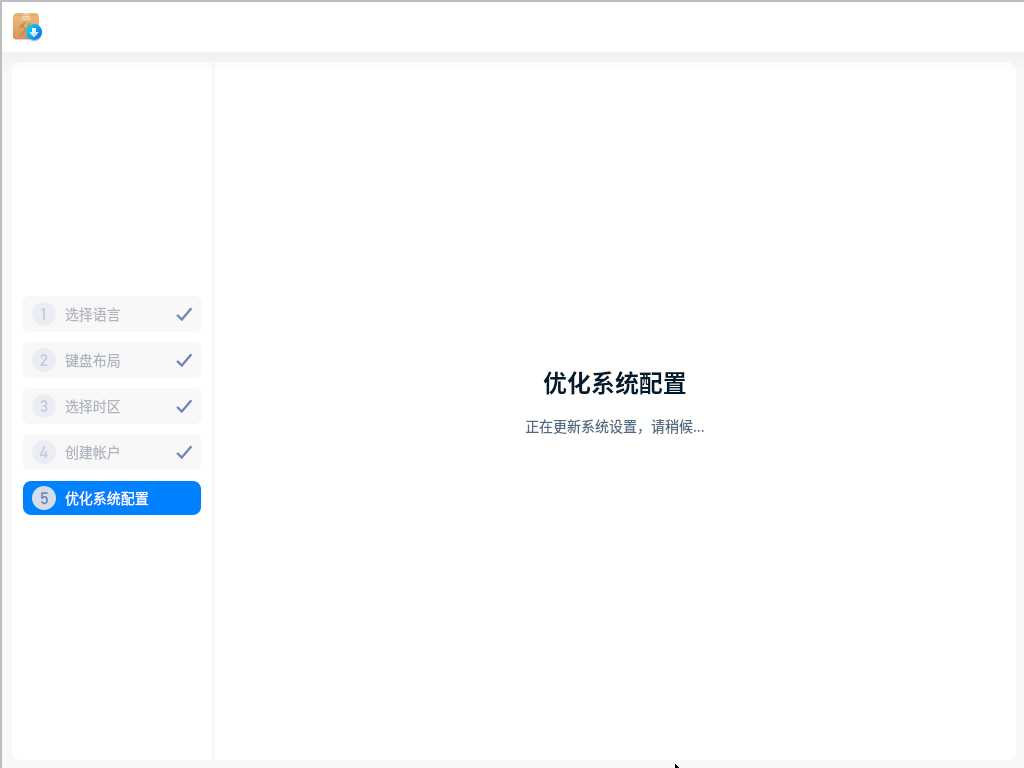

6. 优化系统配置

稍等片刻,等优化完成。

桌面

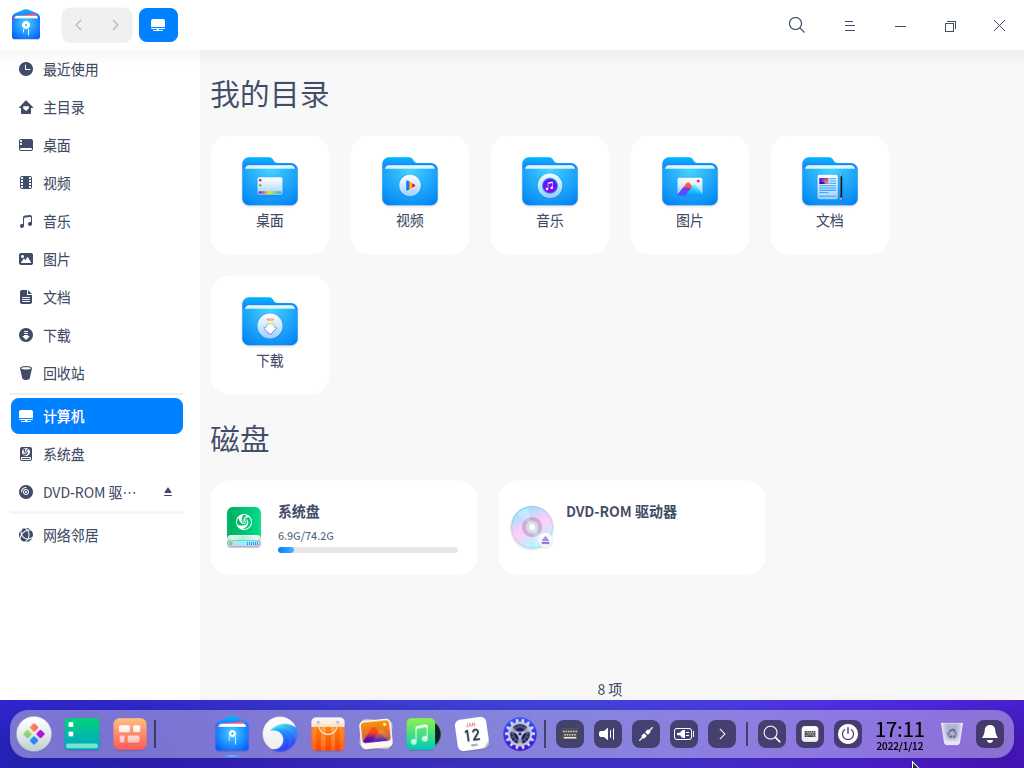

资源管理器

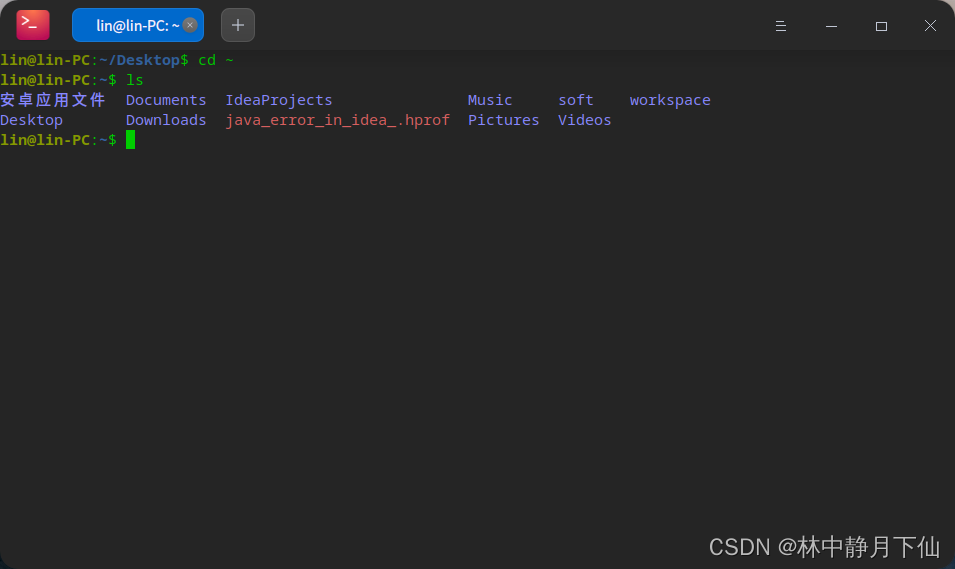

终端