本篇文章主要讲解 python报错提示 无效语法 SyntaxError: invalid syntax 的原因及解决办法

日期:2022年2月18日

作者:任聪聪

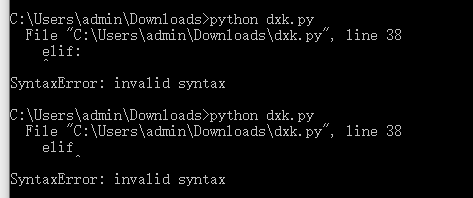

报错现象

python报错如下,但是没有发现那里不对。

造成报错的原因汇总

如上报错的代码行 elif 后,经过细心排查,造成的原因是由于空格和":"[中文的]。而此类报错实际上是提示语法错误,因为python对编码的格式、语句等都有严格的要求,如果语法不对或者语法缺胳膊少腿,就会报这个错误。

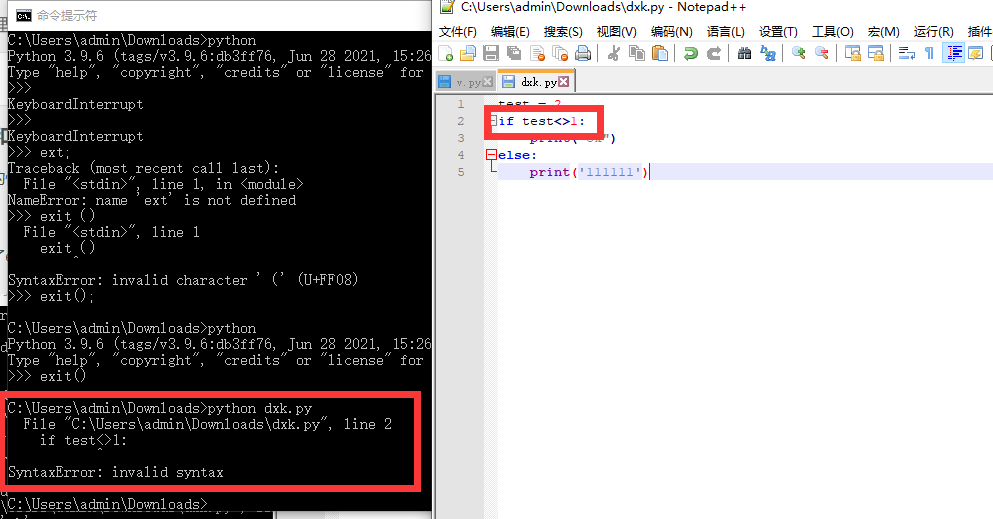

解决和排查方式

SyntaxError: invalid syntax 实际意思是:语法错误:无效语法,所以这个根本不是什么大的问题,不必担心。

归根:只是单纯的语法错误,细节问题。

1.语句错误的情况,多为版本问题,如不用加 “<>”,现在加的情况,那么就会报错。

解决办法:升级版本或者降低版本,或者调整语句