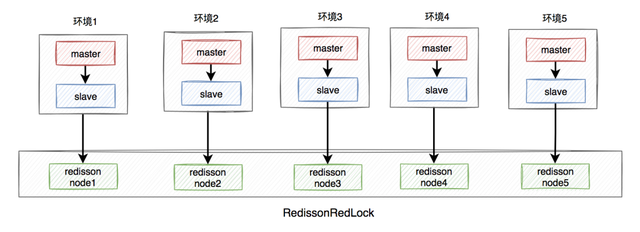

在程序运行过程中创建、实例化对象物体需要用到Object类中的 Instantiate 函数,例如,我们场景中有一个物体A:

现在我们想要在场景中创建五个该物体,则用Instantiate函数将该物体作为参数传入:

现在我们想要在场景中创建五个该物体,则用Instantiate函数将该物体作为参数传入:

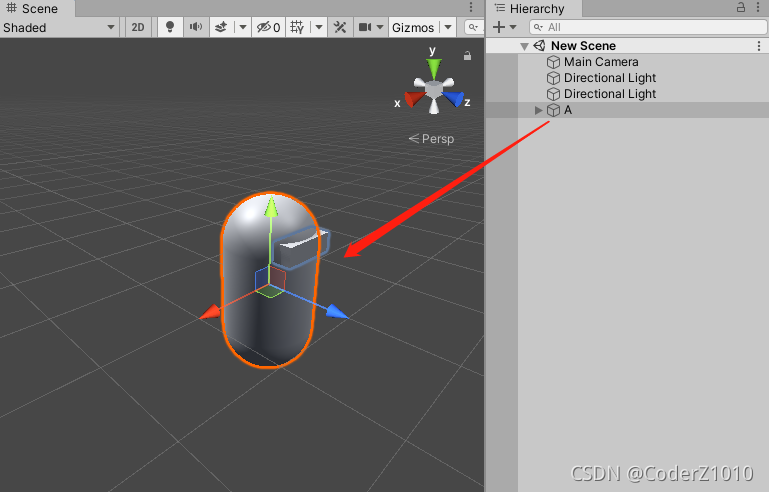

using UnityEngine;public class Foo : MonoBehaviour

{public GameObject A;private void Start(){for (int i = 0; i < 5; i++){Instantiate(A);}}

}

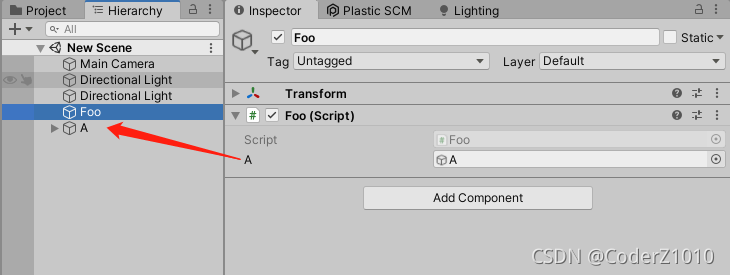

运行效果:

场景中多出的五个A(Clone)物体即为我们创建的物体。