1.什么是模板匹配

在OpenCV教程中这样解释模板匹配:

模板匹配是一项在一幅图像中寻找与另一幅模板图像最匹配(相似)部分的技术。这里说的模板是我们已知的小图像,模板匹配就是在一副大图像中搜寻目标。模板就是我们已知的在图中要找的目标,且该目标同模板有相同的尺寸、方向和图像,通过一定的算法可以在图中找到目标,确定其坐标位置。

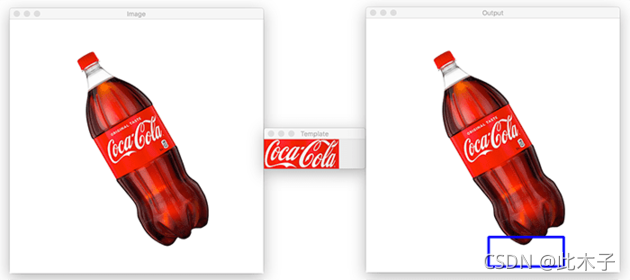

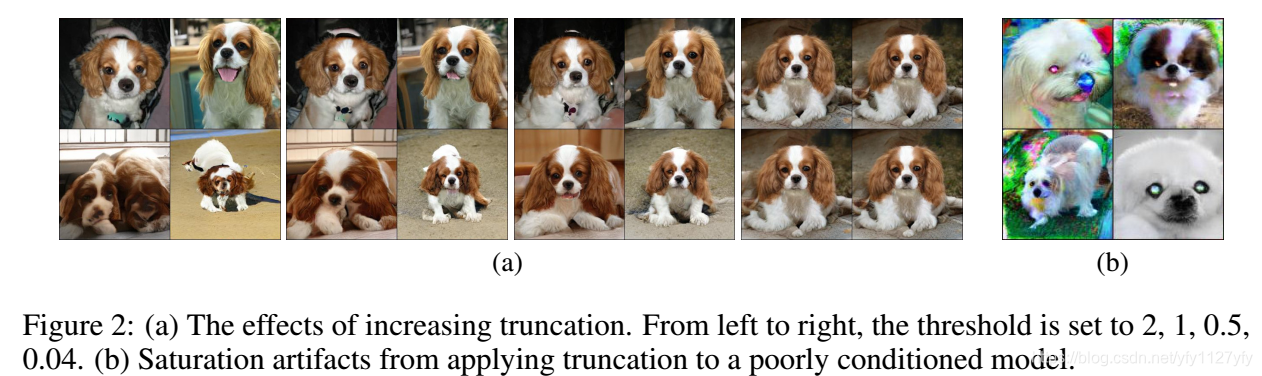

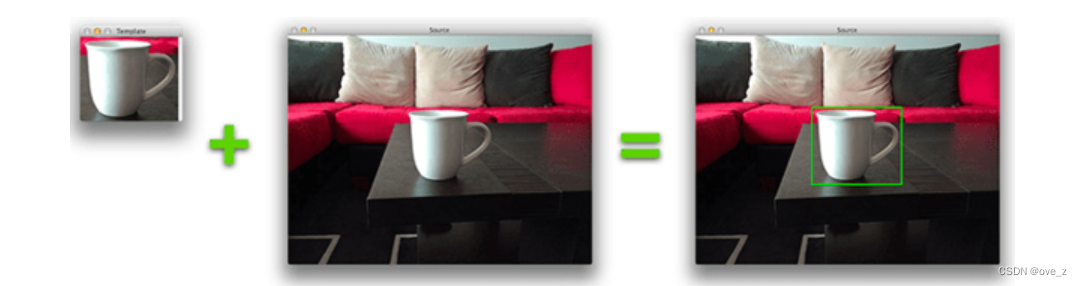

表示成一张图大概就是这个样子:

模板匹配可以看作是对象检测的一种非常基本的形式。使用模板匹配,我们可以使用包含要检测对象的“模板”来检测输入图像中的对象。

基本上来说,这意味着我们需要两个图像来应用模板匹配:

1. 源图像:这是我们希望在其中找到与模板匹配的图像。

2. 模板图像:我们在源图片中搜索的“对象图像块” 。

2.模板匹配的原理

模板匹配的过程,是将数据集中源图像通过索引与库中模板依次进行比较,在匹配过程中将模板与图像比较计算结果存储在矩阵中,通过评分算法给出模板在数据集中估计的最佳位置。

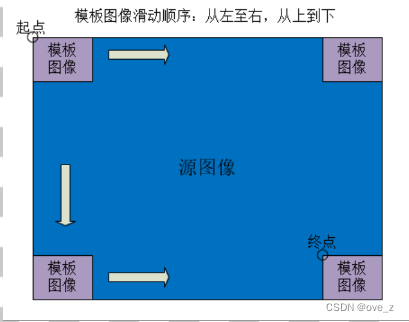

简单来讲,就是在要检测的图像上,从左到右,从上到下遍历这一幅图像,从上到下计算模板与重叠子图像的像素匹配度,如果匹配的程度越大,这说明相同的可能性越大。

实现过程:

①:准备两幅图像:

1. 图像 (I): 在这幅图像里,我们希望找到一块和模板匹配的区域

2. 模板 (T): 将和原图像比照的图像块

②:确定目标匹配的区域:为了确定匹配区域, 我们滑动模板图像和原图像进行比较

③:使用模板遍历图像:

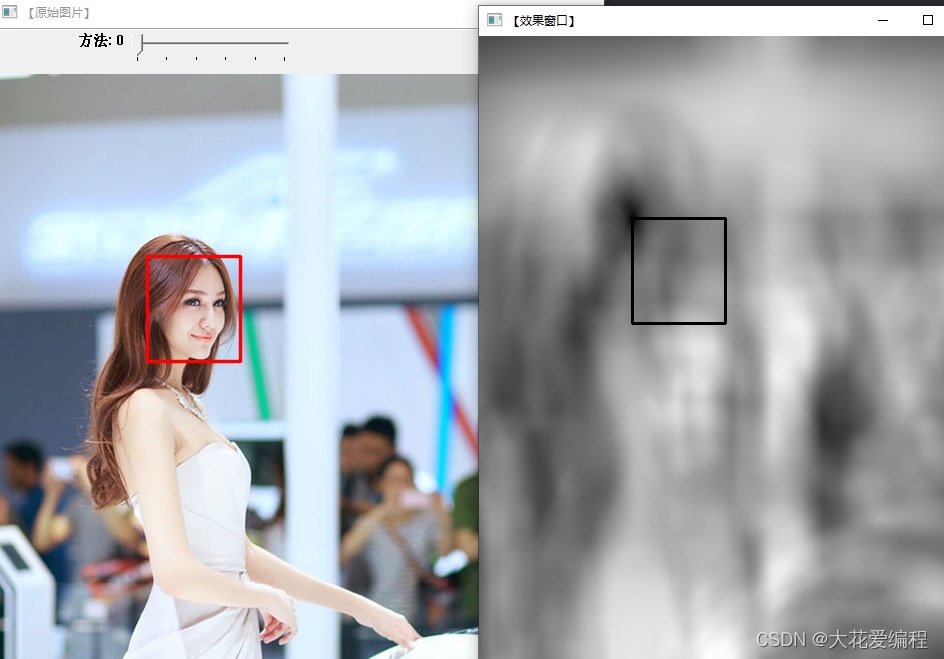

通过滑动, 从左往右,从上往下. 在每一个位置, 都进行一次度量计算来表明模板和原图像的特定区域的相似性。对于T (模板)覆盖在 I(图像) 上的每个位置,把度量值保存到结果图像矩阵(R) 中. 在R中的每个位置 (x,y) 都包含匹配度量值。

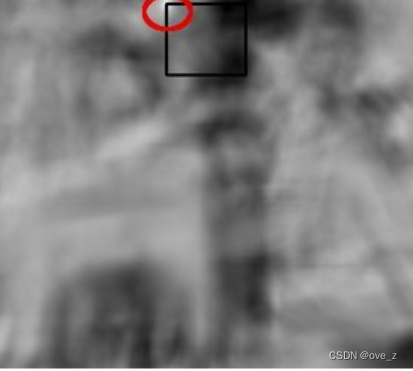

上图是使用标准相关匹配(TM_CCORR_NORMED)方法处理后的结果图像R .最白的位置代表最高的匹配. 红色椭圆框住的位置很可能是结果图像矩阵中的最大数值, 所以这个区域 (以这个点为顶点,长宽和模板图像一样大小的矩阵) 被认为是匹配的。

3.模板匹配在opencv中的实现

OpenCV通过函数[matchTemplate]()实现了模板匹配算法,可用的方法有6个:

一、基于灰度值的模板匹配:

基于灰度值的模板匹配是最经典的模板匹配算法,也是最早提出来的模板匹配算法。这种算法的根本思想是,计算模板图像与检测图像之间的像素灰度差值的绝对值总和(SAD方法)或者平方差总和(SSD方法)。

其原理是:首先选择一块ROI(感兴趣区域)作为模板图像,生成基于灰度值的模板。然后将检测图像与模板图像进行粗匹配,在检测图像与模板图像中任选一点,采取隔点搜索的方式计算二者灰度的相似性,这样粗匹配一遍得到粗相关点。接下来进行精匹配,将得到的粗相关点作为中心点,用最小二乘法寻找二者之间的最优匹配点。

由于这种方法是利用模板图像的所有灰度值进行匹配,但在光照发生变化的情况下灰度值会产生强烈的变化**,因此该方法**不能适应光照发生变化的情况,也不能用于多通道图像的匹配,一般只用于简单图像的匹配。**

灰度匹配算子原型如下:

create_template(Template : : FirstError, NumLevel, Optimize, GrayValues : TemplateID)

代码如下:

dev_clear_window ()

read_image (Image, 'xxxxxx')

rgb1_to_gray (Image, GrayImage)

gen_circle (ROI_0, 84, 180, 20)

reduce_domain (GrayImage, ROI_0, ImageReduced)

create_template (ImageReduced, 5, 4, 'sort', 'original', TemplateID)

threshold (GrayImage, Region, 128, 255)

connection (Region, ConnectedRegions)

select_shape (ConnectedRegions, SelectedRegions, 'area', 'and', 1000, 50000)add_channels (SelectedRegions, GrayImage, GrayRegions)

best_match (GrayRegions, TemplateID, 40, 'false', Row, Column, Error1)

tuple_gen_const (|Row|, 20, Radius)

dev_set_line_width (3)

gen_circle_contour_xld (Circles, Row, Column, Radius, 0, 6.28318, 'positive', 1)dev_display(GrayImage)

dev_display(Circles)这种方法**适用于目标图像光照比较稳定的情况**,多数情况下还是优先考虑基于相关性的匹配和基于形状的匹配。只有针对极少数的**简单图像**,才会考虑基于灰度值的匹配。

二、基于相关性的模板匹配

基于相关性的模板匹配其实是另一种基于灰度值的匹配,不过它的特点是使用一种归一化的互相关匹配(Normalized Cross Correlation,NCC)来衡量模板图像和检测图像之间的关系,因此,在光照方面受的影响比较小。与经典的基于灰度值的匹配算法不同的是,它的速度要快很多。与基于形状模板的匹配算法相比,它的优势是对一些形状有细微变化的、纹理复杂的或者是聚焦模糊的检测图像都能检索得到。

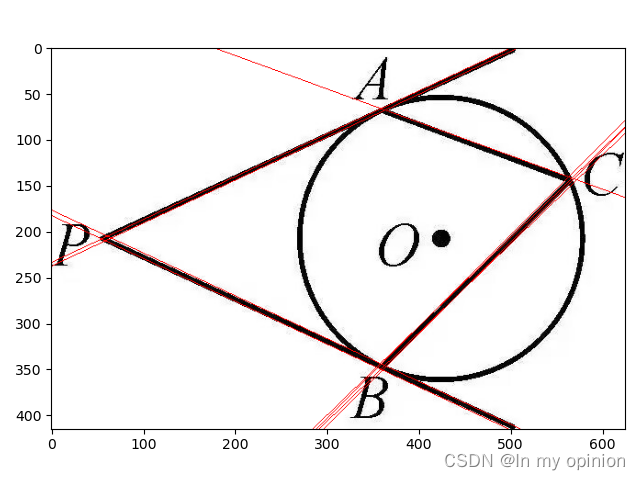

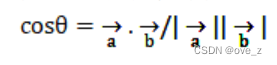

其原理是:把模板图像中的所有像素按列顺序组成一个行向量a,即模板的特征向量,然后在检测图像上寻找与模板最匹配的区域b,通过计算两个向量的夹角,来衡量匹配的概率,如下面所示:

举个例子:

代码如下:

read_image (Image, 'xxxxxxx')

dev_close_window ()

dev_open_window_fit_image (Image, 0, 0, -1, -1, WindowHandle)

set_display_font (WindowHandle, 16, 'mono', 'true', 'false')

dev_update_off ()

gen_circle (Circle, 246, 336, 150)

area_center (Circle, Area, RowRef, ColumnRef)

reduce_domain (Image, Circle, ImageReduced)

create_ncc_model (ImageReduced, 'auto', 0, 0, 'auto', 'use_polarity', ModelID)

dev_set_draw ('margin')

dev_display (Image)

dev_set_color ('yellow')

dev_display (Circle)

disp_message (WindowHandle, 'Trained NCC model', 'window', 12, 12, 'black', 'true')

disp_continue_message (WindowHandle, 'black', 'true')

stop ()

Rows := []

Cols := []

for J := 1 to 10 by 1read_image (Image, 'cap_exposure/cap_exposure_' + J$'02')find_ncc_model (Image, ModelID, 0, 0, 0.5, 1, 0.5, 'true', 0, Row, Column, Angle, Score)Rows := [Rows,Row]Cols := [Cols,Column]dev_display (Image)dev_display_ncc_matching_results (ModelID, 'green', Row, Column, Angle, 0)disp_message (WindowHandle, 'Found NCC model', 'window', 12, 12, 'black', 'true')if (J < 10)disp_continue_message (WindowHandle, 'black', 'true')endifstop ()

endfor

选取一块圆形区域作为模板图像,并根据其灰度值创建模板。当检测图像亮度和形状变化很大还是能够匹配得到。

该方法不但能适应光照变化,对小范围的遮挡和缺失也同样适用,同时还适用于聚焦不清的图像和形状变形,因此在实际应用中比较广泛。但是,该方法也有其局限性,如果与参考图像相比,检测图像的位移、旋转或者缩放比较大,可能会导致匹配失败。

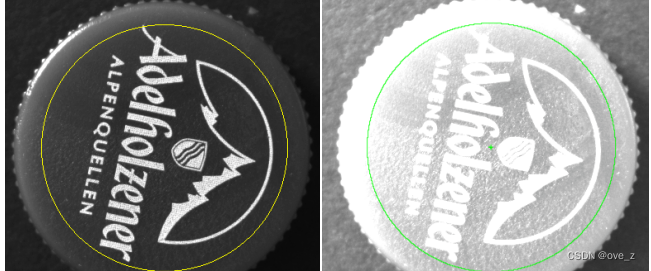

三、基于形状的模板匹配

基于形状的模板匹配,也称为基于边缘方向梯度的匹配,是一种最常用也最前沿的模板匹配算法。该算法以物体边缘的梯度相关性作为匹配标准,原理是**提取ROI中的边缘特征,结合灰度信息创建模板,并根据模板的大小和清晰度的要求生成多层级的图像金字塔模型。接着在图像金字塔层中自上而下逐层搜索模板图像,直到搜索到最底层或得到确定的匹配结果为止。

举个例子:

代码如下:

dev_update_pc ('off')

dev_update_window ('off')

dev_update_var ('off')

read_image (Image, 'green-dot')

get_image_size (Image, Width, Height)

dev_close_window ()

dev_open_window (0, 0, Width, Height, 'black', WindowHandle)

dev_set_color ('red')

dev_display (Image)

threshold (Image, Region, 0, 128)

connection (Region, ConnectedRegions)

select_shape (ConnectedRegions, SelectedRegions, 'area', 'and', 10000, 20000)

fill_up (SelectedRegions, RegionFillUp)

dilation_circle (RegionFillUp, RegionDilation, 5.5)

reduce_domain (Image, RegionDilation, ImageReduced)

create_scaled_shape_model (ImageReduced, 5, rad(-45), rad(90), 'auto', 0.8, 1.0, 'auto', 'none', 'ignore_global_polarity', 40, 10, ModelID)

get_shape_model_contours (Model, ModelID, 1)

area_center (RegionFillUp, Area, RowRef, ColumnRef)

vector_angle_to_rigid (0, 0, 0, RowRef, ColumnRef, 0, HomMat2D)

affine_trans_contour_xld (Model, ModelTrans, HomMat2D)

dev_display (Image)

dev_display (ModelTrans)

read_image (ImageSearch, 'green-dots')

dev_display (ImageSearch)

dev_set_line_width (3)

find_scaled_shape_model (ImageSearch, ModelID, rad(-45), rad(90), 0.8, 1.0, 0.5, 0, 0.5, 'least_squares', 5, 0.8, Row, Column, Angle, Scale, Score)

for I := 0 to |Score| - 1 by 1hom_mat2d_identity (HomMat2DIdentity)hom_mat2d_translate (HomMat2DIdentity, Row[I], Column[I], HomMat2DTranslate)hom_mat2d_rotate (HomMat2DTranslate, Angle[I], Row[I], Column[I], HomMat2DRotate)hom_mat2d_scale (HomMat2DRotate, Scale[I], Scale[I], Row[I], Column[I], HomMat2DScale)affine_trans_contour_xld (Model, ModelTrans, HomMat2DScale)dev_display (ModelTrans)

endfor

该方法使用边缘特征定位物体,对于很多干扰因素不敏感,如光照和图像的灰度变化,甚至可以支持局部边缘缺失、杂乱场景、噪声、失焦和轻微形变的模型。更进一步说,它甚至可以支持多个模板同步进行搜索。但是,在搜索过程中,如果目标图像发生大的旋转或缩放,则会影响搜索的结果,因此不适用于旋转和缩放比较大的情况。

四、基于组件的模板匹配

基于组件的模板匹配可以说是基于形状的模板匹配的加强版,加强的地方在于,这种方法允许模板中包含多个目标,并且允许目标之间存在相对运动(位移和旋转)。这决定了这种方式不适用于尺寸缩放的情况。由于有多个ROI,且需要检测多个ROI之间的相对运动关系,因此这种方法与基于形状的模板匹配相比要稍微复杂一点,且不适用于失焦图像和轻微形变的目标。

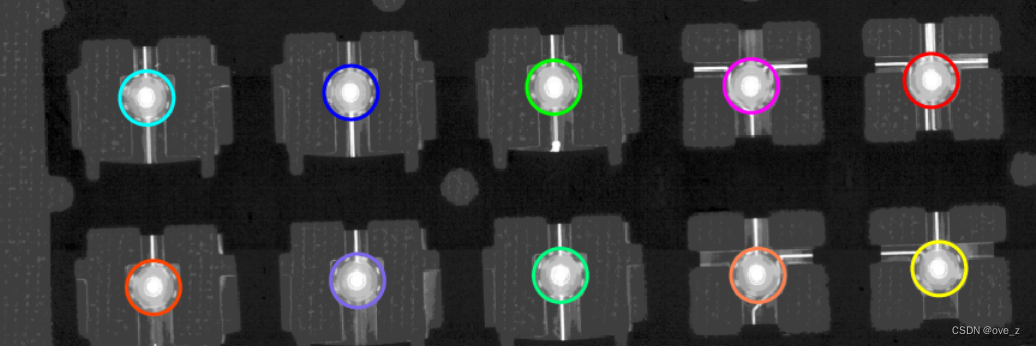

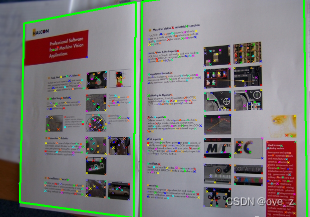

举个例子:

代码如下:

dev_update_off ()

dev_close_window ()

read_image (ModelImage, 'modules/modules_model')

dev_open_window_fit_image (ModelImage, 0, 0, -1, -1, WindowHandle)

dev_display (ModelImage)

set_display_font (WindowHandle, 16, 'mono', 'true', 'false')

Message := 'This program shows how to use the'

Message[1] := 'component-based matching'

Message[2] := 'to locate a compound object'

disp_message (WindowHandle, Message, 'window', 12, 12, 'black', 'true')

disp_continue_message (WindowHandle, 'black', 'true')

stop ()

*

* Define the regions for the components

gen_rectangle2 (ComponentRegions, 318, 109, -1.62, 34, 19)

gen_rectangle2 (Rectangle2, 342, 238, -1.63, 32, 17)

gen_rectangle2 (Rectangle3, 355, 505, 1.41, 25, 17)

gen_rectangle2 (Rectangle4, 247, 448, 0, 14, 8)

gen_rectangle2 (Rectangle5, 237, 537, -1.57, 13, 10)

concat_obj (ComponentRegions, Rectangle2, ComponentRegions)

concat_obj (ComponentRegions, Rectangle3, ComponentRegions)

concat_obj (ComponentRegions, Rectangle4, ComponentRegions)

concat_obj (ComponentRegions, Rectangle5, ComponentRegions)

dev_set_colored (12)

dev_set_draw ('margin')

dev_set_line_width (2)

dev_display (ModelImage)

dev_display (ComponentRegions)

set_display_font (WindowHandle, 16, 'mono', 'true', 'false')

disp_message (WindowHandle, 'Regions of the components', 'window', 12, 12, 'black', 'true')

disp_continue_message (WindowHandle, 'black', 'true')

stop ()

*

* Create the component model by explicitly specifying the relations

create_component_model (ModelImage, ComponentRegions, 20, 20, rad(25), 0, rad(360), 15, 40, 15, 10, 0.8, [4,3,3,3,3], 0, 'none', 'use_polarity', 'true', ComponentModelID, RootRanking)

*

* Find the component model in a run-time image

ImageName := 'modules/modules_'

for I := 1 to 12 by 1read_image (SearchImage, ImageName + I$'.2d')find_component_model (SearchImage, ComponentModelID, RootRanking, 0, rad(360), 0.5, 0, 0.5, 'stop_search', 'search_from_best', 'none', 0.8, 'interpolation', 0, 0.8, ModelStart, ModelEnd, Score, RowComp, ColumnComp, AngleComp, ScoreComp, ModelComp)dev_display (SearchImage)* Display the found component modelsfor Match := 0 to |ModelStart| - 1 by 1dev_set_line_width (1)get_found_component_model (FoundComponents, ComponentModelID, ModelStart, ModelEnd, RowComp, ColumnComp, AngleComp, ScoreComp, ModelComp, Match, 'false', RowCompInst, ColumnCompInst, AngleCompInst, ScoreCompInst)dev_display (FoundComponents)endfordisp_message (WindowHandle, 'Found component models', 'window', 12, 12, 'black', 'true')* If the program shall stop after every image, the following lines* must be activatedif (I < 12)disp_continue_message (WindowHandle, 'black', 'true')endifstop ()

endfor

本例在图中选取了几个元器组件作为模板图像,并根据其形状和相对关系创建了模板,图像在旋转的情况下仍得到了理想的匹配结果。

基于组件的模板匹配适用于组成部件之间有相对运动的物体,使用边缘特征定位物体,对于很多干扰因素不敏感,如光照变化、混乱无序等。其适用于多通道图像,不适用于纹理图像、聚焦不清的图像和形状变形的图像

五、基于形变的模板匹配

形变分为两种,一种是基于目标局部的形变,另一种是由于透视关系而产生的形变。基于形变的模板匹配也是一种基于形状的匹配方法,但不同的是,其返回结果中不仅包括轻微形变的形状、形变的位置和参数,还有描述形变的参数,如旋转角度、缩放倍数等。

基于透视的形变可以返回一个二维投影变换矩阵。如果是在相机标定的情况下,通过相机参数,还可以计算出目标的三维位姿。

举个例子:

代码如下:

dev_update_off ()

dev_close_window ()

read_image (ModelImage, 'food/peanut_chocolate_candies_model')

dev_open_window_fit_image (ModelImage, 0, 0, -1, -1, WindowHandle)

set_display_font (WindowHandle, 16, 'mono', 'true', 'false')

*

* 创建一个模板

create_local_deformable_model (ModelImage, 'auto', [], [], 'auto', 1, [], 'auto', 1, [], 'auto', 'none', 'use_polarity', 65, 25, [], [], ModelID)

get_deformable_model_contours (ModelContours, ModelID, 1)

area_center (ModelImage, Area, Row, Column)

hom_mat2d_identity (HomMat2DIdentity)

hom_mat2d_translate (HomMat2DIdentity, Row, Column, HomMat2DTranslate)

affine_trans_contour_xld (ModelContours, ContoursAffineTrans, HomMat2DTranslate)

dev_set_line_width (2)

dev_set_color ('yellow')

dev_display (ModelImage)

dev_display (ContoursAffineTrans)

disp_message (WindowHandle, 'Model image and contours', 'window', 12, 12, 'black', 'true')

disp_continue_message (WindowHandle, 'black', 'true')

stop ()Smoothness := 19

NumImages := 12

for Index := 1 to NumImages by 1read_image (Image, 'food/peanut_chocolate_candies_' + Index$'02')dev_resize_window_fit_image (Image, 0, 0, -1, -1)dev_display (Image)disp_message (WindowHandle, 'Search ...', 'window', 12, 12, 'black', 'true')count_seconds (S1)* 查找find_local_deformable_model (Image, ImageRectified, VectorField, DeformedContours, ModelID, rad(-120), rad(60), 1, 1, 1, 1, 0.3, 0, 0.7, 0, 0.1, ['vector_field','deformed_contours'], ['deformation_smoothness','expand_border','subpixel'], [Smoothness,0,0], Score, Row, Column)count_seconds (S2)Time := S2 - S1* 显示结果gen_warped_mesh (VectorField, WarpedMesh, Smoothness)dev_set_line_width (1)dev_set_color ('yellow')dev_display (WarpedMesh)Found[Index] := |Score|dev_set_line_width (2)dev_set_color ('green')dev_display (DeformedContours)disp_message (WindowHandle, |Score| + ' matches found in ' + Time$'1.2f' + ' s', 'window', 12, 12, 'black', 'true')disp_message (WindowHandle, 'Score: ' + Score$'.2f', 'image', 350, Column - 80, 'black', 'true')if (Index < NumImages)disp_continue_message (WindowHandle, 'black', 'true')stop ()endif

endfor

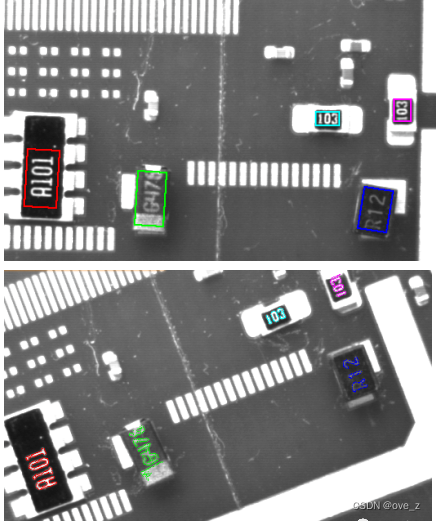

六、基于描述符的模板匹配

与基于透视形变的模板匹配类似,基于描述符的模板匹配能够在物体处于透视形变的状态下进行匹配,并且已标定和未标定的相机图像都适用。与透视形变不同的是,它的模板不是根据边缘轮廓创建的,而是根据特征点创建的。

点的位置或相邻像素的灰度信息等都可以作为描述符。有纹理的平面图形非常适用于这种方法,尤其是对于旋转倾斜等场景中的匹配可以得到非常理想的结果。

举个例子:

代码如下:

dev_close_window ()

*读取参考图像,这里的参考图像应只包含识别的关键区域,用于创建模板

read_image (ImageLabel, 'data/labelShape-0')

*设置窗口参数用于显示图像

get_image_size (ImageLabel, Width, Height)

dev_open_window (0, 0, Width, Height, 'black', WindowHandle1)

dev_set_draw ('margin')

dev_display (ImageLabel)

*设置用于存储特征点和感兴趣区域的变量

NumPoints := []

RowRoi := [10,10,Height - 10,Height - 10]

ColRoi := [10,Width - 10,Width - 10,10]

*将参考图像中的除边缘外的区域都设为感兴趣区域。因为参考图像已经近似于匹配的纹理样本

gen_rectangle1 (Rectangle, 10, 10, Height - 10, Width - 10)

*显示参考图像上选择的ROI区域

dev_set_line_width (4)

dev_display (Rectangle)

stop ()

*将感兴趣区域剪裁为模板图像

reduce_domain (ImageLabel, Rectangle, ImageReduced)

dev_clear_window ()

dev_display (ImageLabel)

*创建基于描述符的模板

create_uncalib_descriptor_model (ImageReduced, 'harris_binomial', [], [], ['min_rot','max_rot','min_scale','max_scale'], [-90,90,0.2,1.1], 42, ModelID)

*设置模型的原点,为了后面获取坐标作参照

set_descriptor_model_origin (ModelID, -Height / 2, -Width / 2)

*获取模型中特征点的位置

get_descriptor_model_points (ModelID, 'model', 'all', Row_D, Col_D)

*将模型中计算出的特征点存入NumPoints变量中

NumPoints := [NumPoints,|Row_D|]*读取测试图像,这里读取的是单通道灰度图像,因此省略了通道转化的步骤

read_image (ImageGray, 'data/labelShape-1')

dev_resize_window_fit_image (ImageGray, 0, 0, -1, -1)

dev_display (ImageGray)

*对描述符特征点进行匹配

find_uncalib_descriptor_model (ImageGray, ModelID, 'threshold', 800, ['min_score_descr','guided_matching'], [0.003,'on'], 0.25, 1, 'num_points', HomMat2D, Score)

*显示匹配结果,将特征点用不同的颜色绘制出来

if ((|HomMat2D| > 0) and (Score > NumPoints[0] / 4))get_descriptor_model_points (ModelID, 'search', 0, Row, Col)*创建十字标识符gen_cross_contour_xld (Cross, Row, Col, 6, 0.785398)projective_trans_region (Rectangle, TransRegion, HomMat2D, 'bilinear')projective_trans_pixel (HomMat2D, RowRoi, ColRoi, RowTrans, ColTrans)angle_ll (RowTrans[2], ColTrans[2], RowTrans[1], ColTrans[1], RowTrans[1], ColTrans[1], RowTrans[0], ColTrans[0], Angle)Angle := deg(Angle)if (Angle > 70 and Angle < 110)area_center (TransRegion, Area, Row, Column)dev_set_color ('green')dev_set_line_width (4)dev_display (TransRegion)dev_set_colored (6)dev_display (Cross) endif

endif

stop ()

*匹配结束,释放模板资源

clear_descriptor_model (ModelID)

七、基于点的模板匹配

基于点的模板匹配主要是用在三维匹配中,通过寻找图像中对应的特征点,进行两幅重叠图像的拼接等操作,在相机标定的情况下被广泛应用。其主要原理是通过提取两幅图像之间的重要特征点实现匹配。把这些特征点作为匹配的输入,输出部分则是两幅图像之间的映射关系,支持图像的位移、旋转、缩放和透视形变。

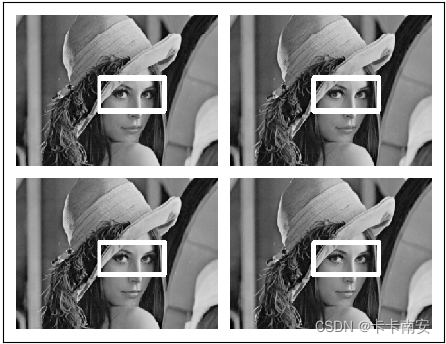

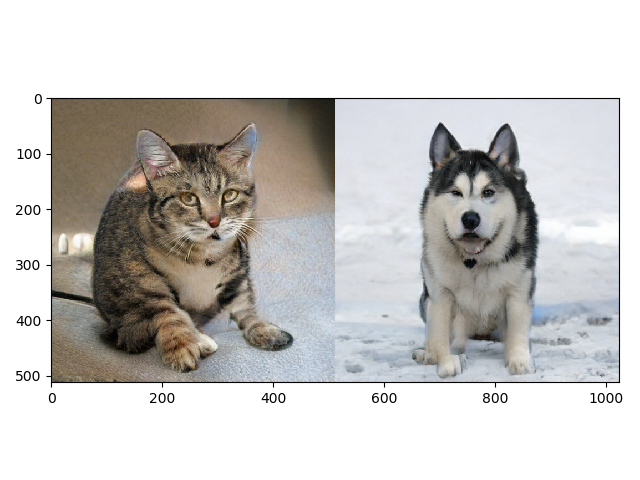

然后自己来实操一下

import cv2

import numpy as np

from matplotlib import pyplot as pltplt.close('all')src = cv2.imread('cxk.jpg', 1)

if src is None:print('Could not open or find the image')exit(0)

print(src.shape)

cv2.imshow("ori", src)

imgGray = cv2.cvtColor(src, cv2.COLOR_BGR2GRAY)

template = cv2.imread('cxk_temp.png', 0)

if template is None:print('Could not open or find the template')exit(0)

print(template.shape)h, w = template.shape[:2]

print("w = %d, h = %d" % (w, h))res = cv2.matchTemplate(imgGray, template, cv2.TM_CCOEFF_NORMED)

threshold = 0.8loc = np.where(res >= threshold)

for pt in zip(*loc[::-1]):cv2.rectangle(src, pt, (pt[0] + w, pt[1] + h), (255, 0, 0), 2)

cv2.imwrite('match_temp_res.png', src)

cv2.imshow('deteced points', src)

cv2.waitKey(0)

cv2.destroyAllWindows()结果就是这样~(doge)

参考博客

(24条消息) OpenCV模板匹配(cv2.matchTemplate)_此木子的博客-CSDN博客_cv2.matchtemplate

(24条消息) 图像处理(8) : 模板匹配_QtHalcon的博客-CSDN博客_图像模板匹配

(24条消息) 模板匹配_duganlx的博客-CSDN博客_模板匹配