一、WGAN概述

WGAN论文地址:https://arxiv.org/abs/1701.07875

在这篇论文中,作者研究了不同的测量方法,来描述模型生成样本和证实样本之间分布差距,或者说,不同的散度定义,在对比之后,认为EM是比较适用于GAN的,然后对EM定义了优化方法,文章重点如下:

- 第二节,用综合利理论分析,对比了EM(Earth Mover)距离,与之前流行的概率距离(log(p)形式)的表现。

- 第三节,定义了Wasserstein-GAN,用来合理、高效地最小化EM距离,并理论性描述了对应的优化问题。

- 第四节,展示WGAN解决了GAN的主要训练问题。WGAN不需要在训练前确保,判别器和生成器的网络结构已经平衡。另外,模式坍塌也被减轻。

整个WGAN的算法如下:

二、 WGAN-GP

WGAN-GP论文地址:https://arxiv.org/abs/1704.00028

这篇论文的作者,发现WGAN有时候会产生很差的样本,或者收敛失败。他们发现主要原因来自判别器的权重剪枝(Weight Clipping),这本是用来加强Lipschitz约束的。为了改善这个问题,提出了另一种权重剪枝方法——对每一个输入,惩罚对应的判别器的正则后的梯度。

主要内容如下:

- 1、在玩具数据集上,证明了判别器权重剪枝导致的问题。

- 2、提出了梯度惩罚(WGAN-GP),可以解决1中的问题。

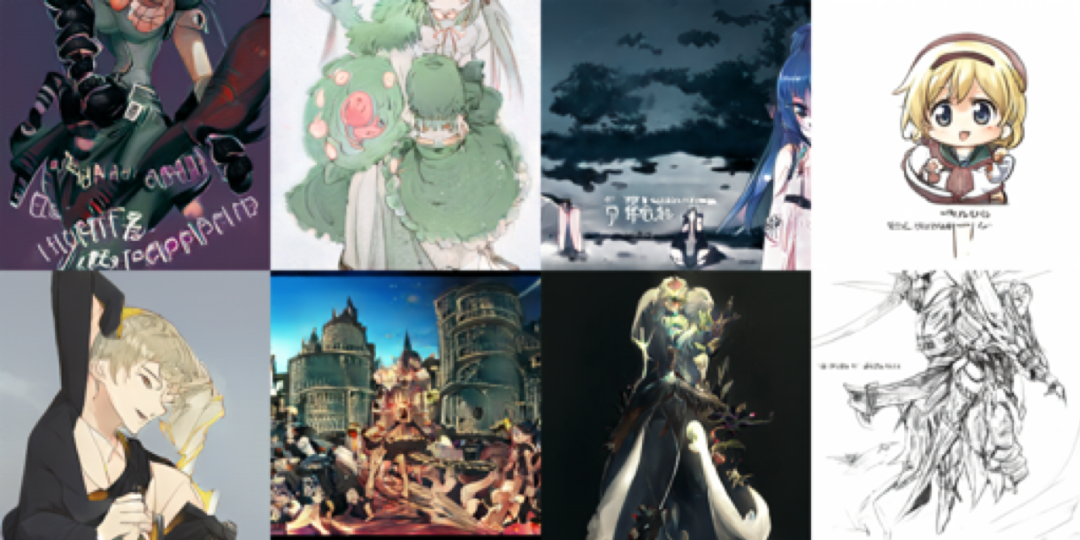

- 3、我们证实了这种改进带来的以下进步:(a).能稳定的训练用不同的GAN结构;(b).有高于权重剪枝的性能提升;(c).能生成高质量的图;(d).一个不使用离散采样的字符级GAN语言模型。

WGAN -GP的算法如下,与WGAN对比一下,就可以看出区别了:

三、BigGAN

BigGAN论文地址: https://arxiv.org/abs/1809.11096

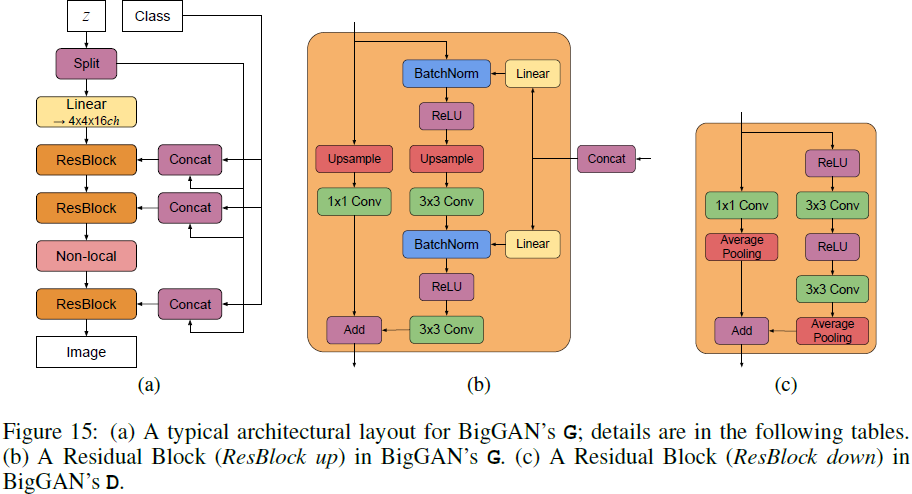

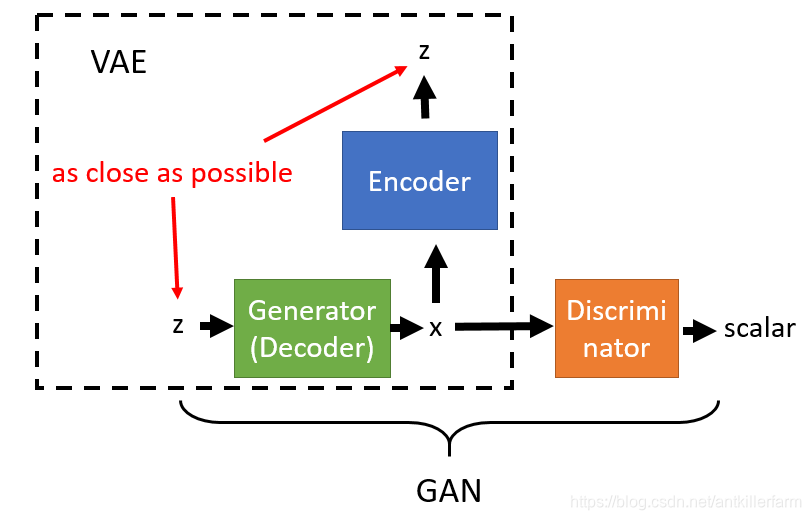

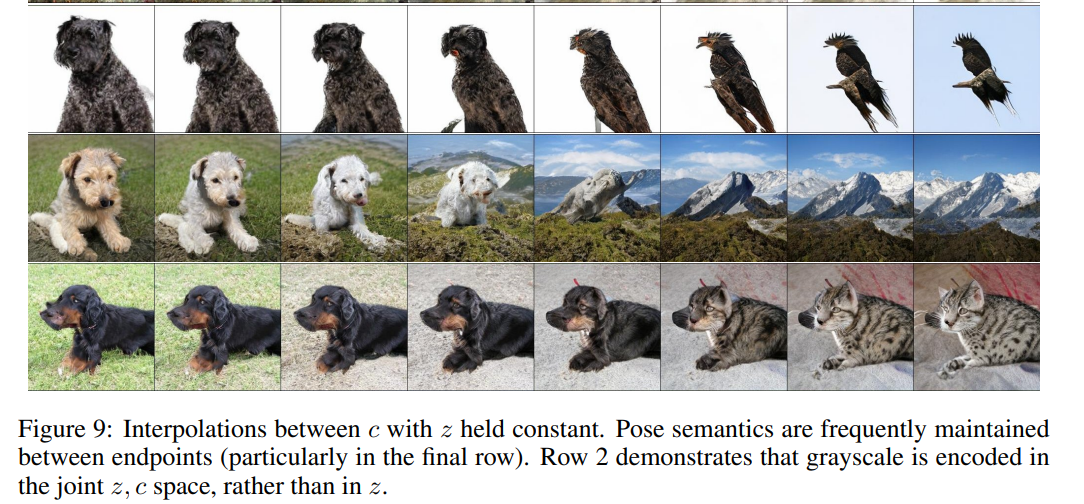

目前,从复杂的数据集(如ImageNet)中,生成高分辨率、多种多样的样本依然是一个难题。这篇论文就是在大尺寸图片上尝试训练GAN,研究改善稳定性的办法。摘要中只提了一个方法——正交正则化,采用正交正则化后,通过降低生成器输入z的方差,可以平衡生成样本的多样性和逼真度。以下D为判别器,G为生成器。

最近的一些论文旨在提高稳定性,一种思路是改进目标函数来促进收敛,另一种是通过约束D或者正则化,来弥补无边界的loss函数带来的负面影响,确保D在任何情况下都能给G提供梯度。

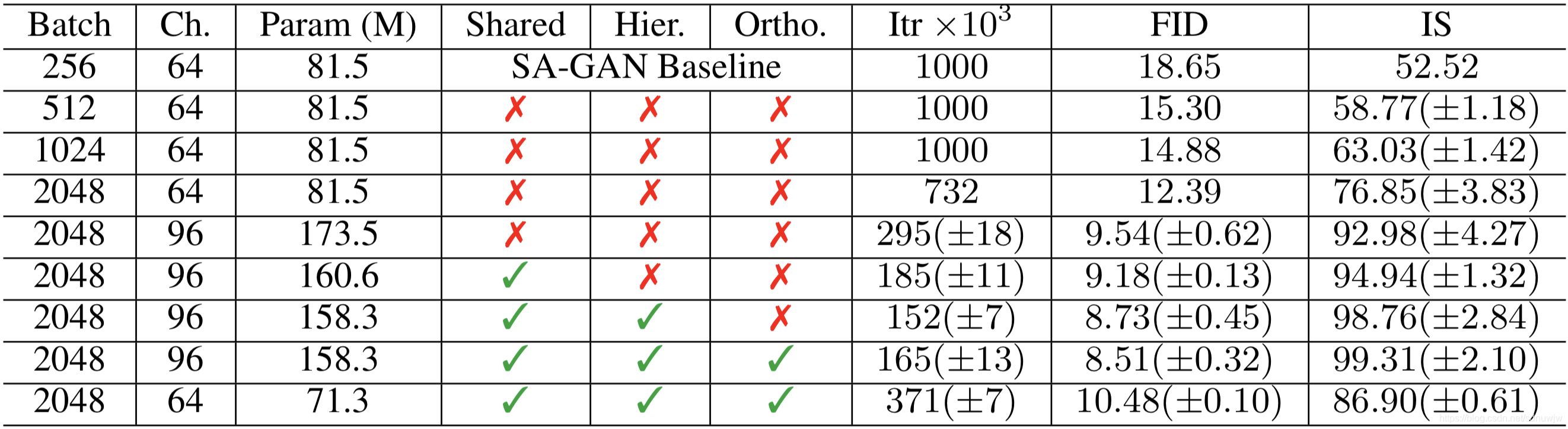

第三节,作者探索了大尺寸GAN训练的方法,获取大模型和大batch带来的性能提升。baseline使用SAGAN,给G的输入附加分类信息,使用的hinge loss函数,优化器设置是G、D学习率一致,每优化两次D优化一次G。详细信息在论文的附件C 。采用两个评价指标:Inception Score (IS),越大越好;Frechet Inception Distance (FID),越小越好。

研究发现以下改进:

- batchsize提高八倍,就有显著提升,IS分数提高46%。副作用是,在几次迭代后,生成图就有很好的细节,但是,最终变得不稳定,产生模式坍塌。原因会在第四节讨论。

- 提升了宽度(通道数)50%,参数大约翻倍了,这个是IS提高了约21%。猜测是相对于复杂的数据集,小模型容量是瓶颈,现在提升了容量。翻倍深度在初始并没有引起提升。这个问题会在后续的BigGAN-deep中探讨。

- 在提供给G的信息中,将类别c嵌入到条件(conditional)BN层会包含大量权重。我们使用了共享的嵌入,线性的把类别信息投射到每层的gains和bias里,这比之前的每次嵌入都用一个独立的层要快很多。

- G输入噪声z时,我们从简单的用z初始化层,改成了用z跳跃连接到之后的层。在BigGan里,是把z分成一个分辨率(?)一个块,然后每个块和c串联(concatenating)起来。在BigGan-deep里,就更简单了,直接把z和c串连起来了。

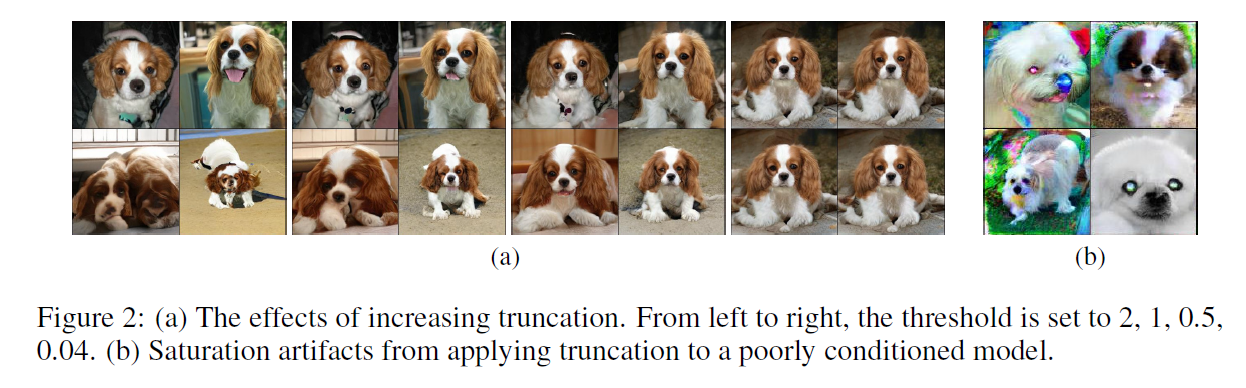

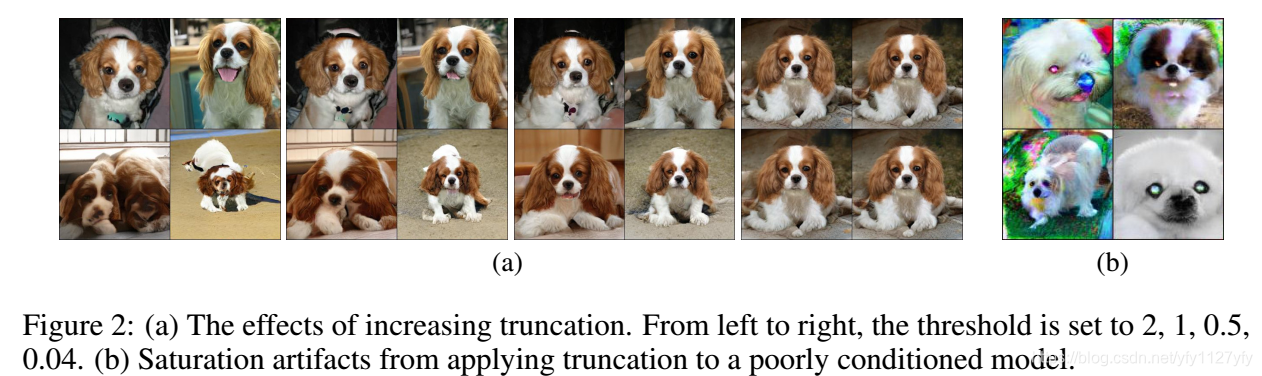

- 截断z向量,把超过设定阈值的值重采样,会提高单个样本的质量,但是会减小整体的样本多样性,见后面的图。(个人理解,阈值越小,截断后z的分布越相似。输入差异越小,收敛越好,但是多样性小了,)。但是训练大模型时,截断z向量可能会引起某些过饱和数据,模型不能完全符合截断。为了解决这个问题,提出了正交正则化,来使模型更符合截断,G更平顺,这样z就能很好的映射到输出样本。

正交正则化的公式如下(ps本文中正态分布写为N(0,i),i 应该是自己定义的一个数):

![]()

作者做了对比实验,结果如下表,上文提到的改进都有所体现:

另外, 上文第5点中的z截断阈值的影响,则在下图可以看出:

还有一些没看,未完待续。。。