Spark开发环境搭建

1)Scala环境

1. 前置说明

安装与配置Scala开发环境。

实验平台直达链接

Scala是一种函数式面向对象语言,它融汇了许多前所未有的特性,而同时又运行于JVM之上。随着开发者对Scala的兴趣日增,以及越来越多的工具支持,无疑Scala语言将成为你手上一件必不可少的工具。

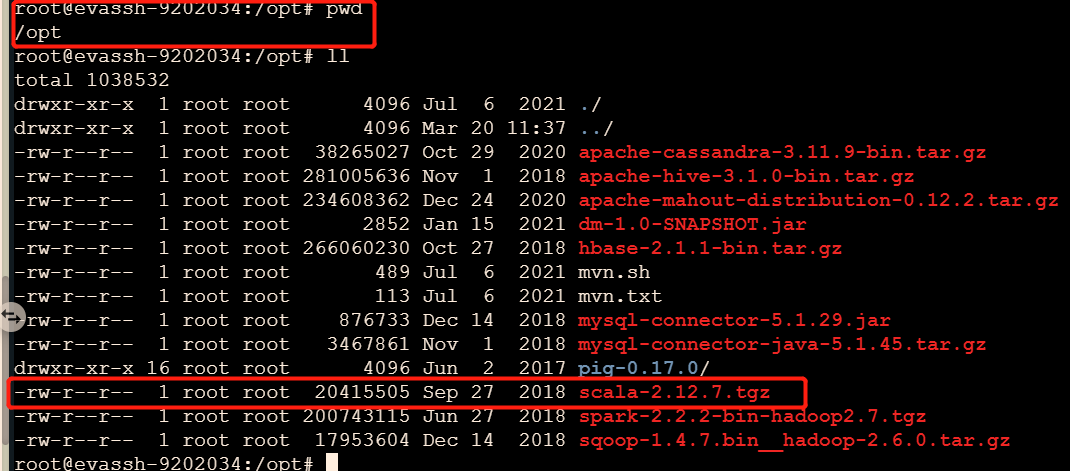

2. 解压配置

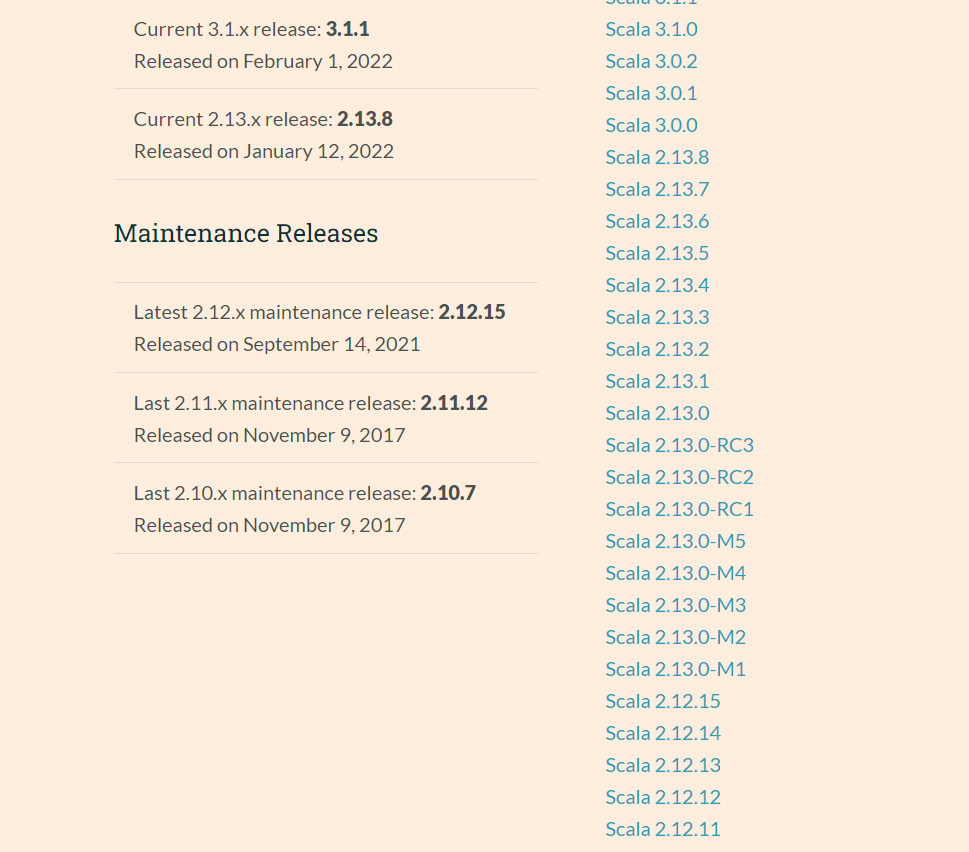

在Scala各版本安装包直达链接根据平台选择下载Scala的安装包

# 创建 app 目录 并解压 scala包

mkdir /app && tar -zxf /opt/scala-2.12.7.tgz -C /app

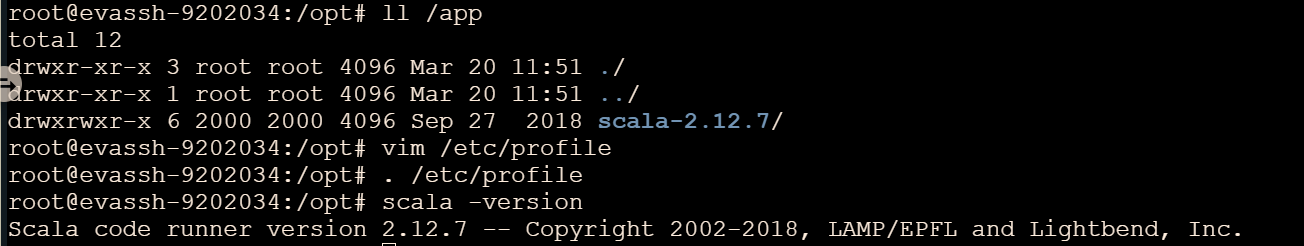

3. 检验配置

SCALA_HOME=/app/scala-2.12.7

export PATH=$PATH:$SCALA_HOME/bin

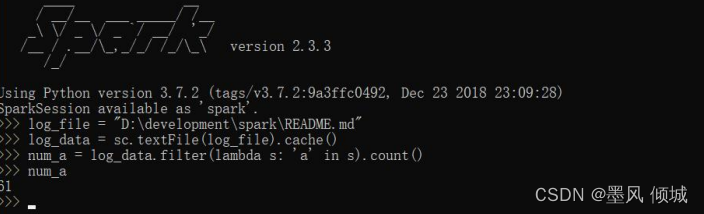

2)Spark环境

实验平台直达链接

1. 前置说明

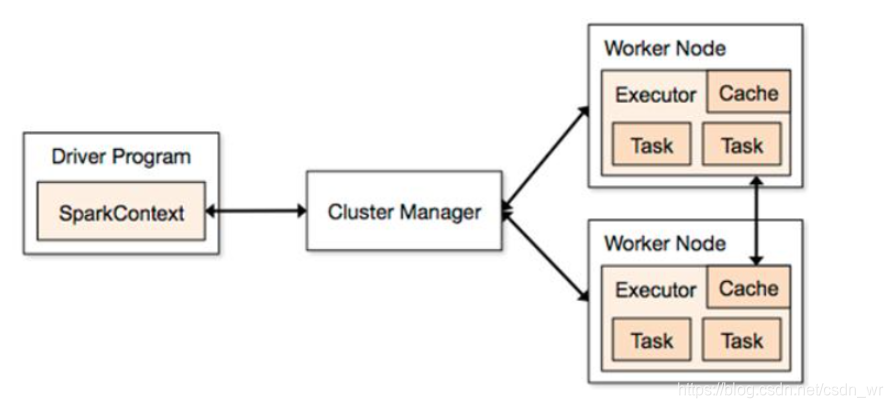

Apache Spark是专为大规模数据处理而设计的快速通用的计算引擎。Spark是UC Berkeley AMP lab(加州大学伯克利分校的AMP实验室)所开源的类Hadoop MapReduce的通用并行框架,Spark拥有Hadoop MapReduce所具有的优点;但不同于MapReduce的是——Job中间输出结果可以保存在内存中,从而不再需要读写HDFS,因此Spark能更好地适用于数据挖掘与机器学习等需要迭代的MapReduce的算法。

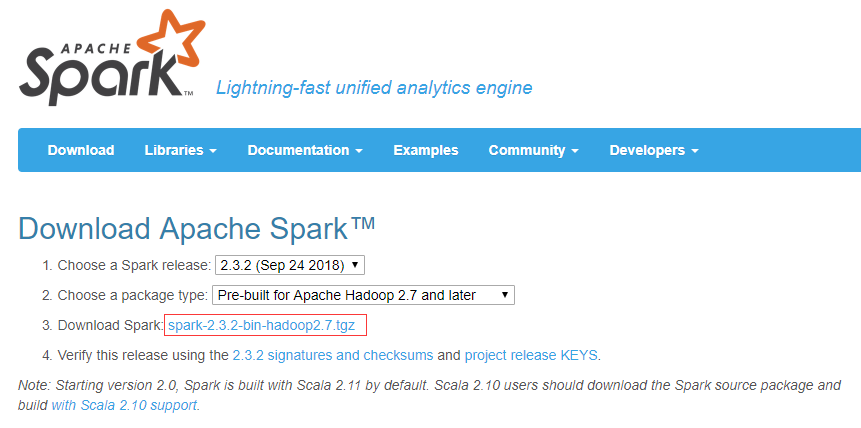

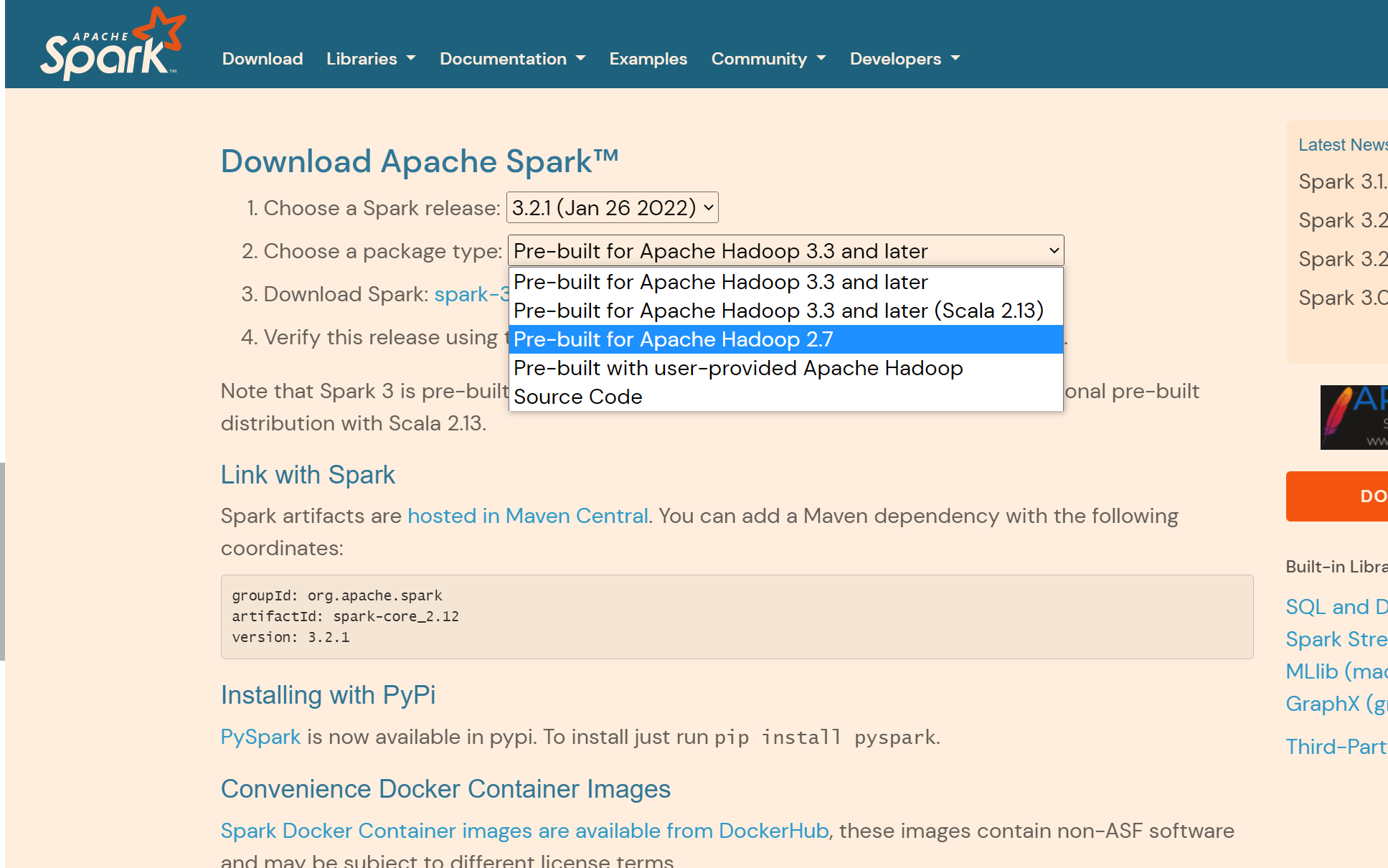

2. 解压配置

平台已将spark安装包下载到/opt目录下

tar -zxf spark-2.2.2-bin-hadoop2.7.tgz -C /app#配置环境变量(根据需求,做目录调整)

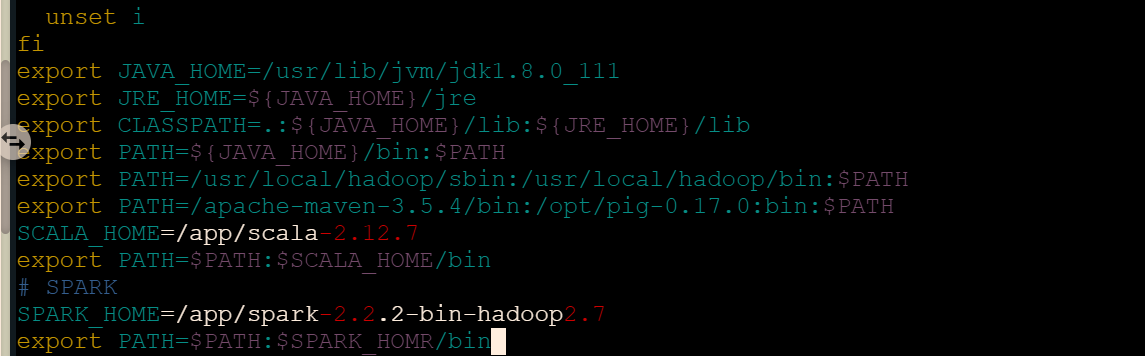

SPARK_HOME=/app/spark-2.2.2-bin-hadoop2.7

export PATH=$PATH:$SPARK_HOMR/bin

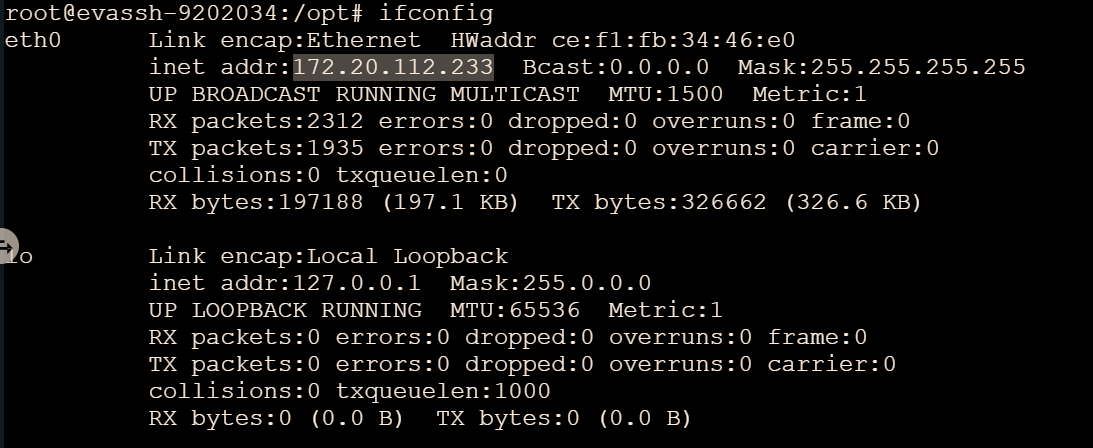

查看IP地址

参数解释:

| 参数 | 解释 |

|---|---|

| JAVA_HOME | Java的安装路径 |

| SCALA_HOME | Scala的安装路径 |

| HADOOP_HOME | Hadoop的安装路径 |

| HADOOP_CONF_DIR | Hadoop配置文件的路径 |

| SPARK_MASTER_IP | Spark主节点的IP或机器名 |

| SPARK_LOCAL_IP | Spark本地的IP或主机名 |

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_111

export SCALA_HOME=/app/scala-2.12.7

export HADOOP_HOME=/usr/local/hadoop/

export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop

export SPARK_MASTER_IP=172.20.112.233

export SPARK_LOCAL_IP=172.20.112.233

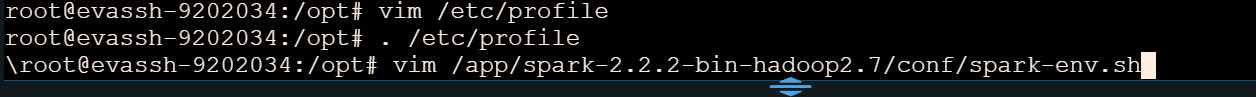

在这里我们需要配置的是spark-env.sh文件,但是在Spark原有目录下查看只发现一个文件spark-env.sh.template,此处我们采取更高效简便的方法跳过复制文件,采用自创spark-env.sh即可

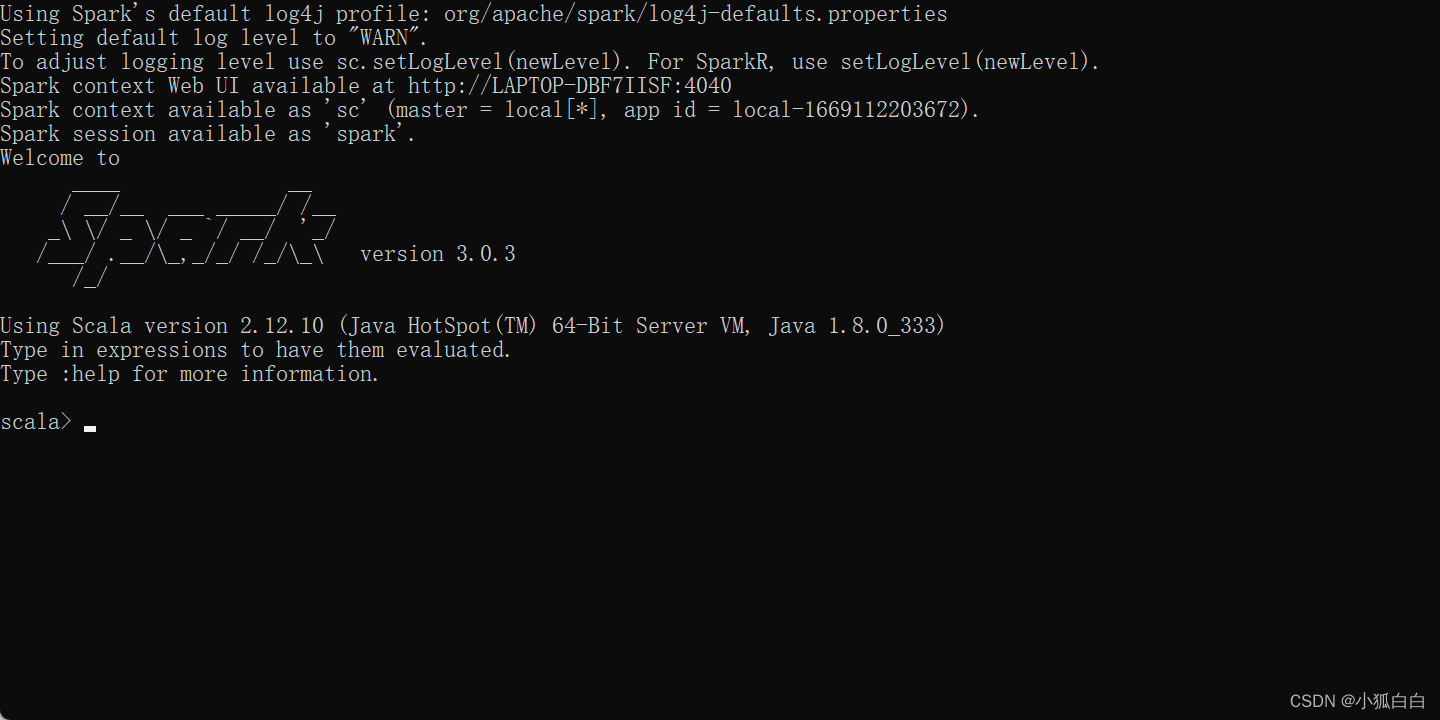

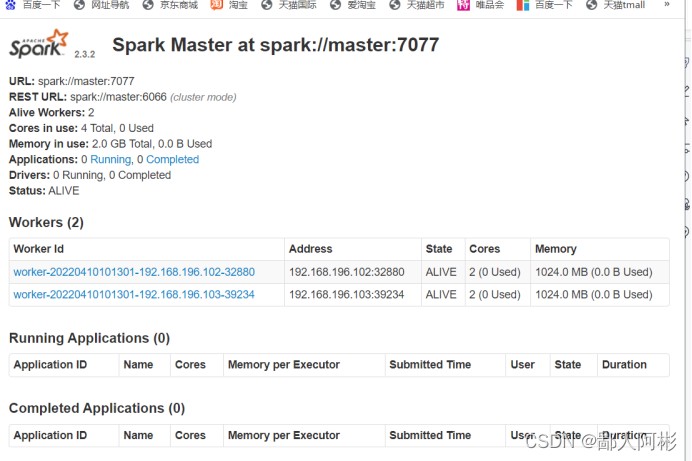

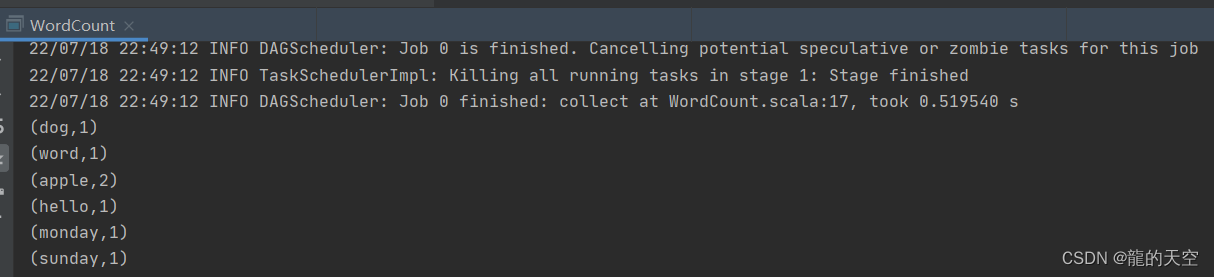

3. 校验配置

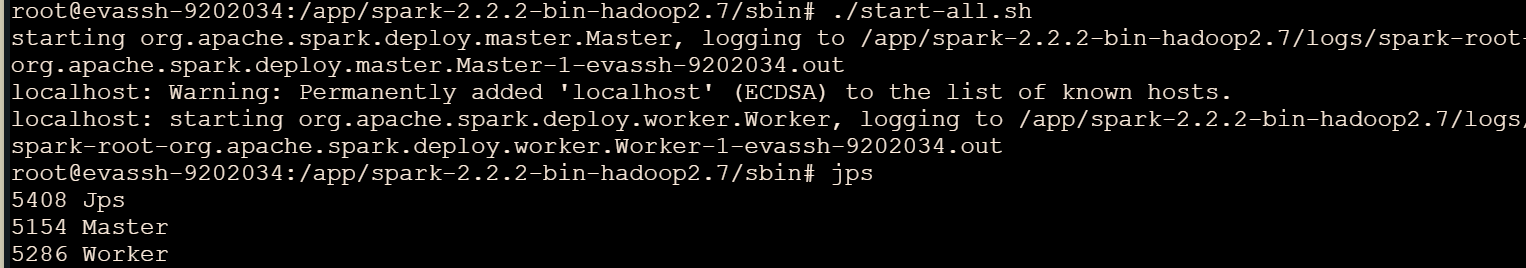

在spark的根目录下输入命令./start-all.sh即可启动,使用jps命令查看是否启动成功

正常开发环境下可能遇到的问题,由于此处平台验证比较古板,无法举例,口述表达一下

Spark底层是基于Hadoop的,我们配置启动Hadoop时默认已经在

profile文件中配置了快捷启动命令,这里我们再调用start-all.sh实际上调用启动的是Hadoop,所以务必切换至Spark自身所在的sbin目录下再调用start-all.sh

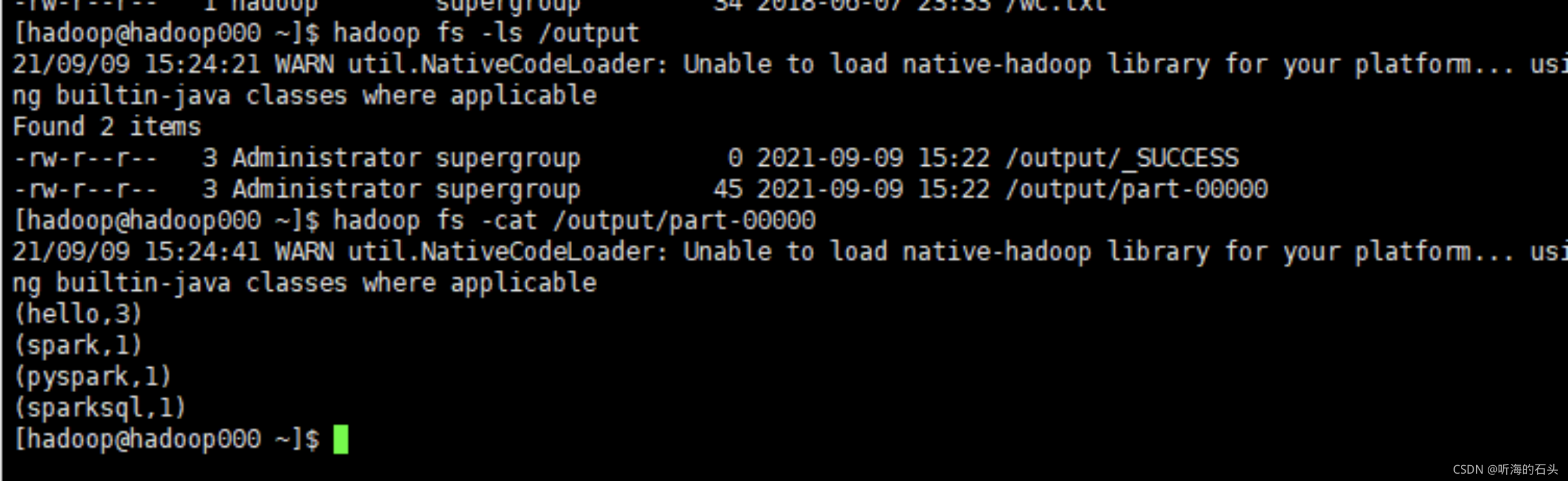

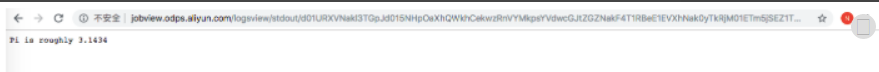

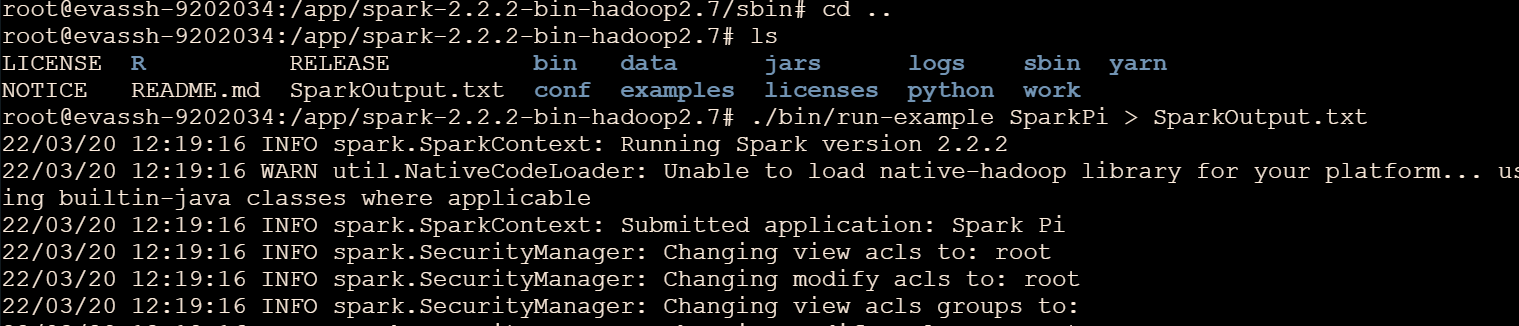

校验

# 在Spark根目录使用命令运行示例程序

./bin/run-example SparkPi > SparkOutput.txt

# 查看计算结果(计算是有误差的所以每次结果会不一样)

cat SparkOutput.txt

申明:以上所有流程基于头歌实验平台提供的环境,如需实操点击直达链接跳转即可开启实验,文章仅作记录