Vector

- 什么是向量

- 基向量

- 向量数乘

- 向量的加法

- 向量点乘

什么是向量

向量是指具有大小和方向的量。它可以形象化地表示为带箭头的线段

箭头所指:代表向量的方向

线段长度:代表向量的大小

向量是线性代数中最基础、最根源的组成部分,向量加法和向量乘法贯穿线性代数始终,起着很重要的作用

基向量

也可以说是单位向量,其他向量都可以由基向量进行缩放、合成得到

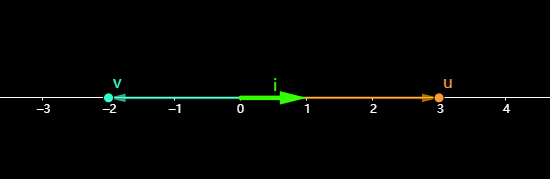

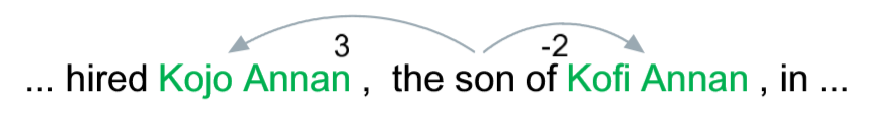

比如在一维坐标系,基向量是 i ⃗ \vec{i} i

u ⃗ \vec{u} u就可以表示为3 i ⃗ \vec{i} i, v ⃗ \vec{v} v表示为-2 i ⃗ \vec{i} i

在二维向量中,比如 p ⃗ \vec{p} p(3,2) =>3*( i ⃗ \vec{i} i,0)+(-2)*(0, j ⃗ \vec{j} j)

向量数乘

k*(x,y,z) = (kx,ky,kz)

其实就是对向量个轴上的分量进行等比缩放

向量的加法

可以从力学角度看,F1和F2的合力

在X轴上的合力FX = 1 + 3 = 4

在Y轴上的合力FY = 2 + (-1) = 1

最后在将FX和FY进行合成得到F = (4,1)

向量点乘

这里慢慢变得有意思了……

先来一个二维向量

在基向量 i ⃗ \vec{i} i、 j ⃗ \vec{j} j构成的二维坐标系下,向量 p ⃗ \vec{p} p可以表示为: p ⃗ \vec{p} p = 3*( i ⃗ \vec{i} i,0) + 2*(0, j ⃗ \vec{j} j)

但是如果在其他基向量构成的坐标系中, p ⃗ \vec{p} p应该如何表示?

先来看看 p ⃗ \vec{p} p在 i ⃗ \vec{i} i所在轴上的表示,前面说过,任何向量都可以看做基向量缩放再合成的结果,所以我们只需要变换基向量即可

(0, j ⃗ \vec{j} j)在水平轴上的表示为(0,0)

( i ⃗ \vec{i} i,0)在水平轴上的表示为( i ⃗ \vec{i} i,0)

在水平轴上 p 2 ⃗ \vec{p2} p2表示为: 3*( i ⃗ \vec{i} i,0) + 2*(0,0) = (3 i ⃗ \vec{i} i,0),由于这里只有一个轴,后面的分量其实是没意义的,所以可以写成3 i ⃗ \vec{i} i

接下来试着将 p ⃗ \vec{p} p表示在L轴上, u ⃗ \vec{u} u是在L轴上的单位向量

将( i ⃗ \vec{i} i,0),(0, j ⃗ \vec{j} j) 转换到L轴后变成了 i 2 ⃗ \vec{i2} i2、 j 2 ⃗ \vec{j2} j2,那么 p 2 ⃗ \vec{p2} p2 = 3* i 2 ⃗ \vec{i2} i2 + 2* j 2 ⃗ \vec{j2} j2

那 i 2 ⃗ \vec{i2} i2、 j 2 ⃗ \vec{j2} j2怎么表示呢?它们跟基向量 u ⃗ \vec{u} u有什么关系?

根据对偶性,可以看出 i ⃗ \vec{i} i在 u ⃗ \vec{u} u上的投影长度和 u ⃗ \vec{u} u在 i ⃗ \vec{i} i上的投影长度相等,那么上面的 i 2 ⃗ \vec{i2} i2 = u x u_x ux u ⃗ \vec{u} u,同理 j 2 ⃗ \vec{j2} j2 = u y u_y uy u ⃗ \vec{u} u

这里的 u ⃗ \vec{u} u是单位向量,那对于非单位向量呢,比如 k u ⃗ \vec{ku} ku = k ⋅ u ⃗ k\cdot\vec{u} k⋅u,它在 i ⃗ \vec{i} i、 j ⃗ \vec{j} j上的投影是怎样的?

k u ⃗ \vec{ku} ku对 u ⃗ \vec{u} u缩放了 k k k倍,对偶性被打破了

i ⃗ \vec{i} i在 k u ⃗ \vec{ku} ku上的投影长度并没有改变, i ⃗ ⋅ k u ⃗ \vec{i}\cdot\vec{ku} i⋅ku = k ( i ⃗ ⋅ u ⃗ ) k(\vec{i}\cdot\vec{u}) k(i⋅u)

图中可以看出 k u ⃗ \vec{ku} ku在 i ⃗ \vec{i} i上的投影长度被缩放了 k k k倍 k u ⃗ ⋅ i ⃗ \vec{ku}\cdot\vec{i} ku⋅i = k ( u ⃗ ⋅ i ⃗ ) k(\vec{u}\cdot\vec{i}) k(u⋅i)

可见,对于非单位向量,彼此的投影仍然保持一致

所以无论 u ⃗ \vec{u} u是不是单位向量, i ⃗ \vec{i} i、 j ⃗ \vec{j} j在 u ⃗ \vec{u} u上的投影长度都为 u x 、 u y u_x、u_y ux、uy

所以:

p 2 ⃗ \vec{p2} p2 = p x ⋅ i 2 ⃗ p_x\cdot\vec{i2} px⋅i2 + p y ⋅ j 2 ⃗ p_y\cdot\vec{j2} py⋅j2

= p x u x p_xu_x pxux u ⃗ \vec{u} u + p y u y p_yu_y pyuy u ⃗ \vec{u} u

= ( p x u x + p y u y p_xu_x+p_yu_y pxux+pyuy)* u ⃗ \vec{u} u

= p x u x + p y u y p_xu_x+p_yu_y pxux+pyuy (一个轴上的向量可直接用数值表示,数值绝对值表示向量长度,正负表示方向)

到此,我们得到了一个非常重要的结论:

向量 p ⃗ \vec{p} p在向量 u ⃗ \vec{u} u上的表示为 p x p_x px u x u_x ux + p y p_y py u y u_y uy

根据对偶性,向量 u ⃗ \vec{u} u在向量 p ⃗ \vec{p} p上的表示也为 p x p_x px u x u_x ux + p y p_y py u y u_y uy

咦,这不是向量点乘公式吗?并且满足交换律!

继续看,是不是觉得这个公式有点眼熟……

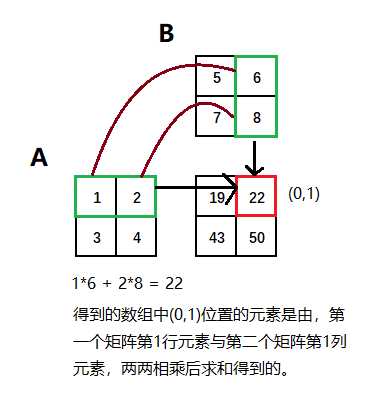

矩阵乘法:

[ a b ] [\begin{matrix} a\\ b \end{matrix}] [ab] ⋅ \cdot ⋅ [ c d ] \begin{matrix} [c&d] \end{matrix} [cd] = a c + b d ac+bd ac+bd

如果将 p ⃗ \vec{p} p写成列式 [ p x p y ] [\begin{matrix} p_x \\ p_y \end{matrix}] [pxpy], u ⃗ \vec{u} u写成行式 [ u x u y ] \begin{matrix} [u_x&u_y] \end{matrix} [uxuy], p ⃗ ⋅ u ⃗ \vec{p}\cdot\vec{u} p⋅u就可以看做是矩阵乘法

p ⃗ ⋅ u ⃗ \vec{p}\cdot\vec{u} p⋅u = [ p x p y ] [\begin{matrix} p_x \\ p_y \end{matrix}] [pxpy] ⋅ \cdot ⋅ [ u x u y ] \begin{matrix} [u_x&u_y] \end{matrix} [uxuy] = p x p_x px u x u_x ux + p y p_y py u y u_y uy

看到这里,我们是否可以理解为:向量的点乘,其实就是将一个向量变换到另一个向量所在的坐标空间中

如下图:二维空间中的点,经过单位向量 u ⃗ \vec{u} u变换后,在 u ⃗ \vec{u} u所在轴上都能得到与之对应的值,这个过程我们可以看做是二维空间到一维空间的投射

a ⃗ ⋅ b ⃗ = ∣ a ⃗ ∣ ∣ b ⃗ ∣ c o s ( φ ) \vec{a} \cdot \vec{b}= |\vec{a}||\vec{b}|cos(\varphi) a⋅b=∣a∣∣b∣cos(φ)

这个公式又是怎么得到的?

先复习下余弦定理:

∣ a ⃗ ∣ 2 |{\vec{a}}|^2 ∣a∣2 = ∣ c ⃗ ∣ 2 |{\vec{c}}|^2 ∣c∣2 + ∣ b ⃗ ∣ 2 |{\vec{b}}|^2 ∣b∣2

= ( ∣ c ⃗ ∣ s i n ( A ) ) 2 (|{\vec{c}}|sin(A))^2 (∣c∣sin(A))2 + ( ( ∣ b ⃗ ∣ − ∣ c ⃗ ∣ c o s ( A ) ) 2 ) ((|{\vec{b}}| - |{\vec{c}}|cos(A)) ^2) ((∣b∣−∣c∣cos(A))2)

= ∣ c ⃗ ∣ 2 |{\vec{c}}|^2 ∣c∣2 s i n ( A ) 2 sin(A)^2 sin(A)2 + ∣ b ⃗ ∣ 2 |{\vec{b}}|^2 ∣b∣2 + ∣ c ⃗ ∣ 2 |{\vec{c}}|^2 ∣c∣2 c o s ( A ) 2 cos(A)^2 cos(A)2 - 2 ∣ c ⃗ ∣ ∣ b ⃗ ∣ c o s ( A ) 2|{\vec{c}}||{\vec{b}}|cos(A) 2∣c∣∣b∣cos(A)

= ∣ c ⃗ ∣ 2 |{\vec{c}}|^2 ∣c∣2( s i n ( A ) 2 sin(A)^2 sin(A)2 + c o s ( A ) 2 cos(A)^2 cos(A)2) + ∣ b ⃗ ∣ 2 |{\vec{b}}|^2 ∣b∣2 - 2 ∣ c ⃗ ∣ ∣ b ⃗ ∣ c o s ( A ) 2|{\vec{c}}||{\vec{b}}|cos(A) 2∣c∣∣b∣cos(A)

= ∣ c ⃗ ∣ 2 |{\vec{c}}|^2 ∣c∣2 + ∣ b ⃗ ∣ 2 |{\vec{b}}|^2 ∣b∣2 - 2 ∣ c ⃗ ∣ ∣ b ⃗ ∣ c o s ( A ) 2|{\vec{c}}||{\vec{b}}|cos(A) 2∣c∣∣b∣cos(A)

按照上面的推导:

2 ∣ c ⃗ ∣ ∣ b ⃗ ∣ c o s ( A ) 2|{\vec{c}}||{\vec{b}}|cos(A) 2∣c∣∣b∣cos(A) = ∣ c ⃗ ∣ 2 |{\vec{c}}|^2 ∣c∣2 + ∣ b ⃗ ∣ 2 |{\vec{b}}|^2 ∣b∣2 - ∣ a ⃗ ∣ 2 |{\vec{a}}|^2 ∣a∣2

= B x 2 B_x^2 Bx2 + B y 2 B_y^2 By2 + C x 2 C_x^2 Cx2 + C y 2 C_y^2 Cy2 - ( C x − B x ) 2 (C_x-B_x)^2 (Cx−Bx)2 - ( C y − B y ) 2 (C_y-B_y)^2 (Cy−By)2

= B x 2 B_x^2 Bx2 + B y 2 B_y^2 By2 + C x 2 C_x^2 Cx2 + C y 2 C_y^2 Cy2 - C x 2 C_x^2 Cx2 - B x 2 B_x^2 Bx2 + 2 C x B x 2C_xB_x 2CxBx - C y 2 C_y^2 Cy2 - B y 2 B_y^2 By2 + 2 C y B y 2C_yB_y 2CyBy

= 2( C x B x C_xB_x CxBx+ C y B y C_yB_y CyBy)

得到: ∣ c ⃗ ∣ ∣ b ⃗ ∣ C o s ( A ) |{\vec{c}}||{\vec{b}}|Cos(A) ∣c∣∣b∣Cos(A) = C x B x C_xB_x CxBx+ C y B y C_yB_y CyBy

所以: a ⃗ ⋅ b ⃗ \vec{a} \cdot \vec{b} a⋅b = a x b x + a y b y a_xb_x+a_yb_y axbx+ayby = ∣ a ⃗ ∣ ∣ b ⃗ ∣ c o s ( φ ) |\vec{a}||\vec{b}|cos(\varphi) ∣a∣∣b∣cos(φ), φ \varphi φ是 a ⃗ b ⃗ \vec{a}\vec{b} ab夹角

根据点乘的结果来判断两个向量的方向关系:

大于 0:0 =< φ \varphi φ < p i / 2 pi/2 pi/2

等于 0: φ \varphi φ = p i / 2 pi/2 pi/2,两向量垂直

小于 0: p i / 2 pi/2 pi/2 < φ \varphi φ =< p i pi pi

从力学角度,是否还可以理解为力F在位移S上做的功?

W = ∣ F ⃗ ∣ ∣ S ⃗ ∣ c o s ( φ ) |\vec{F}||\vec{S}|cos(\varphi) ∣F∣∣S∣cos(φ)

参考:https://www.youtube.com/channel/UCYO_jab_esuFRV4b17AJtAw

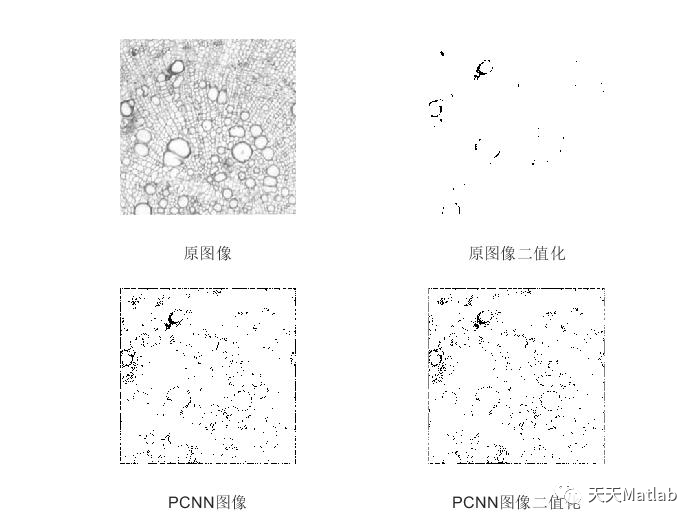

![【MATLAB图像融合】[14]PCNN脉冲耦合神经网络代码分享](https://img-blog.csdnimg.cn/2020091111014875.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3N1ZGE1Mzk1,size_16,color_FFFFFF,t_70#pic_center)

![【MATLAB图像融合】[18]双通道PCNN模型实现图像融合](https://img-blog.csdnimg.cn/20210701180529996.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3N1ZGE1Mzk1,size_16,color_FFFFFF,t_70)