基于mod_proxy实现负载均衡

在httpd.conf中启用httpd-proxy.conf配置文件,Include /etc/httpd/extra/httpd-proxy.conf

修改httpd-proxy.conf文件:

ProxyRequests Off

<proxy balancer://lbcluster1>BalancerMember ajp://192.168.1.211:8009 loadfactor=10 route=TomcatABalancerMember ajp://192.168.1.213:8009 loadfactor=10 route=TomcatB

</proxy><VirtualHost *:80>ServerName www.z.comProxyPass / balancer://lbcluster1/ stickysession=jsessionidProxyPassReverse / balancer://lbcluster1/

</VirtualHost>常用apache指令的说明:

ProxyPreserveHost {On|Off}:如果启用此功能,代理会将用户请求报文中的Host:行发送给后端的服务器,而不再使用ProxyPass指定的服务器地址。如果想在反向代理中支持虚拟主机,则需要开启此项,否则就无需打开此功能。

ProxyVia {On|Off|Full|Block}:用于控制在http首部是否使用Via:,主要用于在多级代理中控制代理请求的流向。默认为Off,即不启用此功能;On表示每个请求和响应报文均添加Via:;Full表示每个Via:行都会添加当前apache服务器的版本号信息;Block表示每个代理请求报文中的Via:都会被移除。

ProxyRequests {On|Off}:是否开启apache正向代理的功能;启用此项时为了代理http协议必须启用mod_proxy_http模块。同时,如果为apache设置了ProxyPass,则必须将ProxyRequests设置为Off。

ProxyPass [path] !|url [key=value key=value ...]]:将后端服务器某URL与当前服务器的某虚拟路径关联起来作为提供服务的路径,path为当前服务器上的某虚拟路径,url为后端服务器上某URL路径。使用此指令时必须将ProxyRequests的值设置为Off。需要注意的是,如果path以“/”结尾,则对应的url也必须以“/”结尾,反之亦然。

另外,mod_proxy模块在httpd 2.1的版本之后支持与后端服务器的连接池功能,连接在按需创建在可以保存至连接池中以备进一步使用。连接池大小或其它设定可以通过在ProxyPass中使用key=value的方式定义。常用的key如下所示:

min:连接池的最小容量,此值与实际连接个数无关,仅表示连接池最小要初始化的空间大小。

max:连接池的最大容量,每个MPM都有自己独立的容量;都值与MPM本身有关,如Prefork的总是为1,而其它的则取决于ThreadsPerChild指令的值。

loadfactor:用于负载均衡集群配置中,定义对应后端服务器的权重,取值范围为1-100。

retry:当apache将请求发送至后端服务器得到错误响应时等待多长时间以后再重试。单位是秒钟。

如果Proxy指定是以balancer://开头,即用于负载均衡集群时,其还可以接受一些特殊的参数,如下所示:

lbmethod:apache实现负载均衡的调度方法,默认是byrequests,即基于权重将统计请求个数进行调度,bytraffic则执行基于权重的流量计数调度,bybusyness通过考量每个后端服务器的当前负载进行调度。

maxattempts:放弃请求之前实现故障转移的次数,默认为1,其最大值不应该大于总的节点数。

nofailover:取值为On或Off,设置为On时表示后端服务器故障时,用户的session将损坏;因此,在后端服务器不支持session复制时可将其设置为On。

stickysession:调度器的sticky session的名字,根据web程序语言的不同,其值为JSESSIONID或PHPSESSIONID。

上述指令除了能在banlancer://或ProxyPass中设定之外,也可使用ProxySet指令直接进行设置,如:

<Proxy balancer://hotcluster> BalancerMember http://www1.test.com:8080 loadfactor=1 BalancerMember http://www2.test.com:8080 loadfactor=2 ProxySet lbmethod=bytraffic

</Proxy>配置基于mod_jk的负载均衡

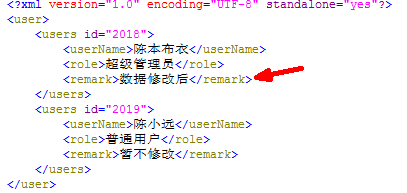

1、为了避免用户直接访问后端Tomcat实例,影响负载均衡的效果,建议在Tomcat的各实例上禁用HTTP/1.1连接器。2、为每一个 Tomcat 实例的引擎添加jvmRoute参数,并通过其为当前引擎设置全局惟一标识符。如下所示。需要注意的是,每一个实例的jvmRoute的值均不能相同,如:

<Engine name=”Standalone” defaultHost=”localhost” jvmRoute=” TomcatA ”>

而后去配置apache,注销配置文件httpd-proxy.conf,启用httpd-jk.conf

#Include /etc/httpd/extra/httpd-proxy.conf

Include /etc/httpd/extra/httpd-jk.confLoadModule jk_module modules/mod_jk.so

JkWorkersFile /etc/httpd/extra/workers.properties

JkLogFile logs/mod_jk.log

JkLogLevel debug

JkMount /* lbcluster1

JkMount /jkstatus/ stat1worker.list = lbcluster1,stat1

worker.TomcatA.type = ajp13

worker.TomcatA.host = 192.168.1.211

worker.TomcatA.port = 8009

worker.TomcatA.lbfactor = 5

worker.TomcatB.type = ajp13

worker.TomcatB.host = 192.168.1.213

worker.TomcatB.port = 8009

worker.TomcatB.lbfactor = 5

worker.lbcluster1.type = lb

worker.lbcluster1.sticky_session = 1

worker.lbcluster1.balance_workers = TomcatA, TomcatB

worker.stat1.type = statusworkers.properties文件一般由两类指令组成:一是mod_jk可以连接的各worker名称列表,二是每一个worker的属性配置信息。它们分别遵循如下使用语法。

worker.list = < a comma separated list of worker names >

worker. <worker name> .<property> = <property value>

其中worker.list指令可以重复指定多次,而worker name则是Tomcat中engine组件jvmRoute参数的值。如:

worker.TomcatA.host=192.168.1.211

根据其工作机制的不同,worker有多种不同的类型,这是需要为每个worker定义的一项属性woker.<work name>.type。常见的类型如下:

ajp13:此类型表示当前worker为一个运行着的Tomcat实例。

lb:lb即load balancing,专用于负载均衡场景中的woker;此worker并不真正负责处理用户请求,而是将用户请求调度给其它类型为ajp13的worker。

status:用户显示分布式环境中各实际worker工作状态的特殊worker,它不处理任何请求,也不关联到任何实际工作的worker实例。具体示例如请参见后文中的配置。

worker其它常见的属性说明:

host:Tomcat的worker实例所在的主机;

port:Tomcat实例上AJP1.3连接器的端口;

connection_pool_minsize:最少要保存在连接池中的连接的个数;默认为pool_size/2;

connection_pool_timeout:连接池中连接的超时时长;

mount:由当前worker提供的context路径,如果有多个则使用空格格开;此属性可以由JkMount指令替代;

retries:错误发生时的重试次数;

socket_timeout:mod_jk等待worker响应的时长,默认为0,即无限等待;

socket_keepalive:是否启用keep alive的功能,1表示启用,0表示禁用;

lbfactor:worker的权重,可以在负载均衡的应用场景中为worker定义此属性;

另外,在负载均衡模式中,专用的属性还有:

balance_workers:用于负载均衡模式中的各worker的名称列表,需要注意的是,出现在此处的worker名称一定不能在任何worker.list属性列表中定义过,并且worker.list属性中定义的worker名字必须包含负载均衡worker。具体示例请参见后文中的定义。

method:可以设定为R、T或B;默认为R,即根据请求的个数进行调度;T表示根据已经发送给worker的实际流量大小进行调度;B表示根据实际负载情况进行调度。

sticky_session:在将某请求调度至某worker后,源于此址的所有后续请求都将直接调度至此worker,实现将用户session与某worker绑定。默认为值为1,即启用此功能。如果后端的各worker之间支持session复制,则可以将此属性值设为0。

查看状态信息:

1、基于mod_proxy模块状态信息

修改配置文件httpd-proxy.conf,在虚拟机中添加balancer-manager

<proxy balancer://lbcluster> BalancerMember ajp://192.168.18.201:8009 loadfactor=1 route=TomcatA BalancerMember ajp://192.168.18.203:8009 loadfactor=1 route=TomcatB ProxySet lbmethod=byrequests

</proxy>

<VirtualHost *:80>ServerName www.z.comProxyPass / balancer://lbcluster/ stickysession=JSESSIONID|jsessionid nofailover=On ProxyPassReverse / balancer://lbcluster/<Location /balancer-manager> #增加状态信息SetHandler balancer-manager Proxypass ! Require all granted </Location><Proxy *>Require all granted </Proxy><Location />Require all granted </Location>

</VirtualHost>基于mod_jk模块的状态信息,注销httpd-proxy.conf,启用httpd-jk.conf

打开浏览器,输入:http://192.168.1.212/jkstatus/

会话共享集群:

1、会话分为标准会话和持久会话。

1)、标准会话管理器(StandardManager):<Manager className="org.apache.catalina.session.StandardManager"maxInactiveInterval="7200"/>maxActiveSessions:最多允许的活动会话数量,默认为-1,表示不限制;

maxInactiveInterval:非活动的会话超时时长,默认为60s;

pathname:会话文件的保存目录;

2)、持久会话管理器(PersistentManager):

将会话数据保存至持久存储中,并且能在服务器意外中止后重新启动时重新加载这些会话信息。持久会话管理器支持将会话保存至文件存储(FileStore)或JDBC存储(JDBCStore)中。

保存至文件中的示例:

<Manager className="org.apache.catalina.session.PersistentManager"saveOnRestart="true"><Store className="org.apache.catalina.session.FileStore"directory="/data/tomcat-sessions"/>

</Manager>保存至JDBCStore中的示例:

<Manager className="org.apache.catalina.session.PersistentManager"saveOnRestart="true"><Store className="org.apache.catalina.session.JDBCStore"driverName="com.mysql.jdbc.Driver"connectionURL="jdbc:mysql://localhost:3306/mydb?user=jb;password=pw"/>

</Manager>2.Manager组件

Manger对象用于实现HTTP会话管理的功能,Tomcat中有5种Manger的实现:1)、StandardManager

Tomcat6的默认会话管理器,用于非集群环境中对单个处于运行状态的Tomcat实例会话进行管理。当Tomcat关闭时,这些会话相关的数据会被写入磁盘上的一个名叫SESSION.ser的文件,并在Tomcat下次启动时读取此文件。

2)、PersistentManager

当一个会话长时间处于空闲状态时会被写入到swap会话对象,这对于内存资源比较吃紧的应用环境来说比较有用。

3)、DeltaManager

用于Tomcat集群的会话管理器,它通过将改变了会话数据同步给集群中的其它节点实现会话复制。这种实现会将所有会话的改变同步给集群中的每一个节点,也是在集群环境中用得最多的一种实现方式。

4)、BackupManager

用于Tomcat集群的会话管理器,与DeltaManager不同的是,某节点会话的改变只会同步给集群中的另一个而非所有节点。

5)、SimpleTcpReplicationManager

Tomcat4时用到的版本,过于老旧了

3.DeltaManager具体实现过程

1)、修改server.xml配置文件,定义在Engine容器中,则表示对所有主机均启动用集群功能,如果定义在某Host中,则表示仅对此主机启用集群功能:<Cluster className="org.apache.catalina.ha.tcp.SimpleTcpCluster" channelSendOptions="6"><Manager className="org.apache.catalina.ha.session.BackupManager" expireSessionsOnShutdown="false" notifyListenersOnReplication="true" mapSendOptions="6"/><Channel className="org.apache.catalina.tribes.group.GroupChannel"><Membership className="org.apache.catalina.tribes.membership.McastService" address="228.0.0.4" port="45564" frequency="500" dropTime="3000"/><Receiver className="org.apache.catalina.tribes.transport.nio.NioReceiver" address="192.168.1.211" port="5001" selectorTimeout="100" maxThreads="6"/><Sender className="org.apache.catalina.tribes.transport.ReplicationTransmitter"><Transport className="org.apache.catalina.tribes.transport.nio.PooledParallelSender"/></Sender><Interceptor className="org.apache.catalina.tribes.group.interceptors.TcpFailureDetector"/><Interceptor className="org.apache.catalina.tribes.group.interceptors.MessageDispatch15Interceptor"/><Interceptor className="org.apache.catalina.tribes.group.interceptors.ThroughputInterceptor"/></Channel><Valve className="org.apache.catalina.ha.tcp.ReplicationValve" filter=".*\.gif;.*\.js;.*\.jpg;.*\.png;.*\.htm;.*\.html;.*\.css;.*\.txt;"/><Valve className="org.apache.catalina.ha.session.JvmRouteBinderValve"/><Deployer className="org.apache.catalina.ha.deploy.FarmWarDeployer" tempDir="/tmp/war-temp/" deployDir="/tmp/war-deploy/" watchDir="/tmp/war-listen/" watchEnabled="false"/><ClusterListener className="org.apache.catalina.ha.session.ClusterSessionListener"/><ClusterListener className="org.apache.catalina.ha.session.JvmRouteSessionIDBinderListener"/>

</Cluster><web-app xmlns="http://java.sun.com/xml/ns/javaee"xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"xsi:schemaLocation="http://java.sun.com/xml/ns/javaeehttp://java.sun.com/xml/ns/javaee/web-app_3_0.xsd"version="3.0">

<distributable/>ProxyRequests Off

<proxy balancer://lbcluster1>BalancerMember ajp://192.168.1.211:8009 loadfactor=10 route=TC1BalancerMember ajp://192.168.1.213:8009 loadfactor=10 route=TC2

</proxy>

<VirtualHost *:80>ProxyPass / balancer://lbcluster1/ stickysession=jsessionidProxyPassReverse / balancer://lbcluster1/

</VirtualHost>在浏览器中输入192.168.1.212:

刷新

4)、用于mod_proxy状态信息的输出

<Location /balancer-manager>SetHandler balancer-managerOrder Deny,AllowAllow from all

</Location><pre name="code" class="plain">ProxyRequests Off

<proxy balancer://lbcluster1>BalancerMember ajp://192.168.10.8:8009 loadfactor=1BalancerMember ajp://192.168.10.9:8009 loadfactor=1ProxySet lbmethod=bytraffic

</proxy>

<VirtualHost *:80>ServerName localhostProxyVia OnProxyPass / balancer://lbcluster1/ stickysession=JSESSIONID|jsessionid nofailover=OnProxyPassReverse / balancer://lbcluster1/<Location /balancer-manager>SetHandler balancer-managerProxypass !Require all granted</Location><Proxy *>Require all granted</Proxy><Location / >Require all granted</Location>此外,所有启用集群功能的web应用程序,其web.xml中都须添加<distributable/>才能实现集群功能。如果某web应用程序没有自己的web.xml,也可以通过复制默认的web.xml至其WEB-INF目录中实现。