一、回归算法

回归是统计学中最有力的工具之一。机器学习监督学习算法分为分类算法和回归算法两种,其实就是根据类别标签分布类型为离散型、连续性而定义的。回归算法用于连续型分布预测,针对的是数值型的样本,使用回归,可以在给定输入的时候预测出一个数值,这是对分类方法的提升,因为这样可以预测连续型数据而不仅仅是离散的类别标签。

回归分析中,只包括一个自变量和一个因变量,且二者的关系可用一条直线近似表示,这种回归分析称为一元线性回归分析。如果回归分析中包括两个或两个以上的自变量,且因变量和自变量之间是线性关系,则称为多元线性回归分析。那么什么是线性关系和非线性关系?

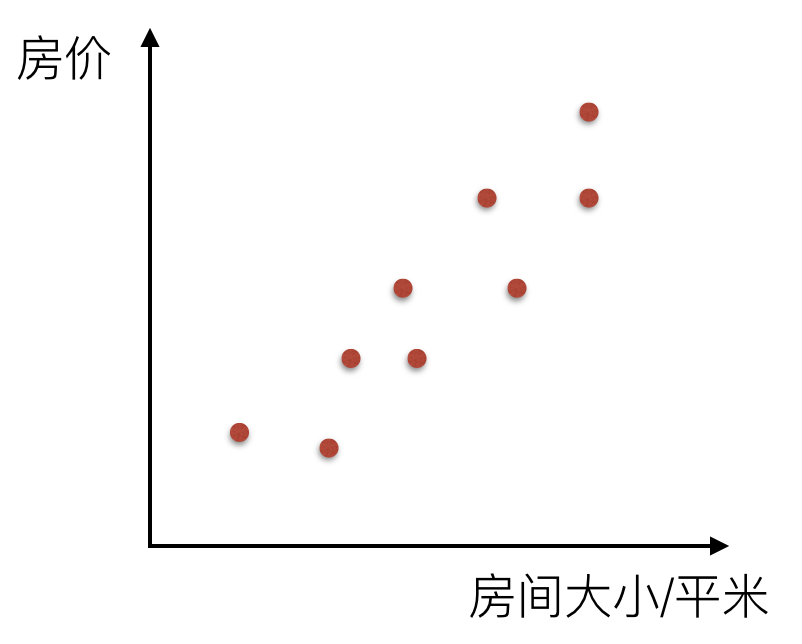

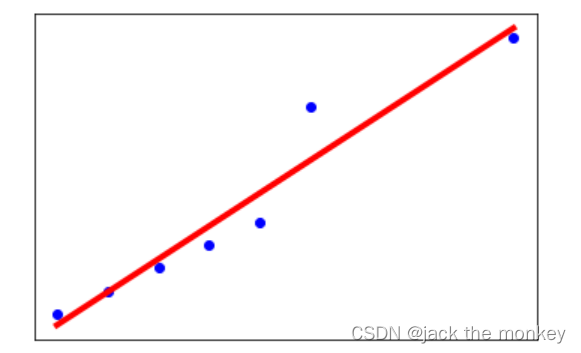

比如说在房价上,房子的面积和房子的价格有着明显的关系。那么X=房间大小,Y=房价,那么在坐标系中可以看到这些点:

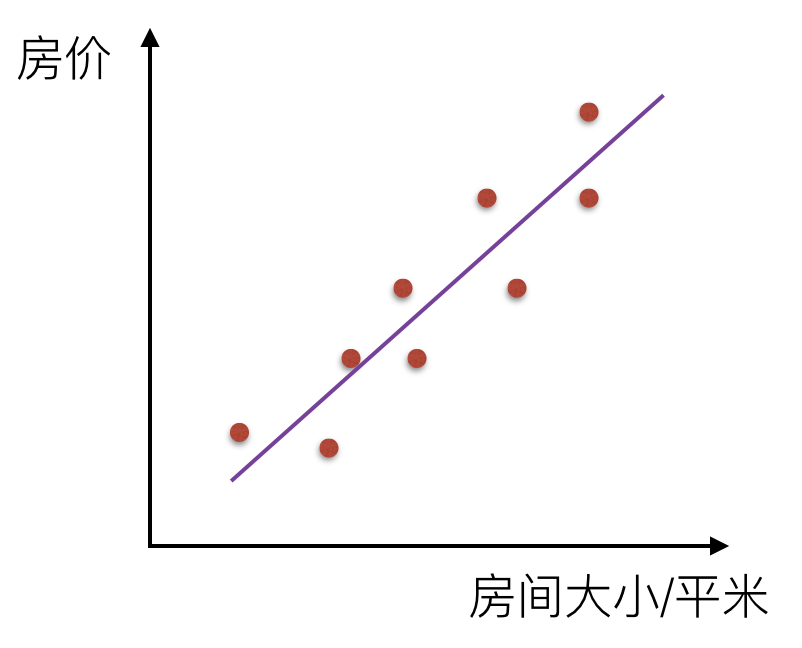

那么通过一条直线把这个关系描述出来,叫线性关系

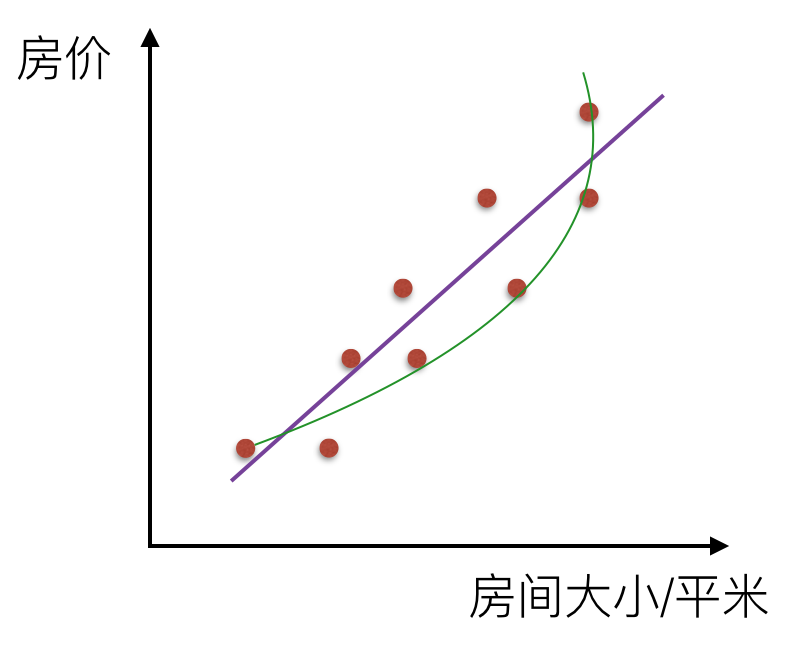

如果是一条曲线,那么叫非线性关系

那么回归的目的就是建立一个回归方程(函数)用来预测目标值,回归的求解就是求这个回归方程的回归系数。

二、回归算法之线性回归

线性回归的定义是:目标值预期是输入变量的线性组合。线性模型形式简单、易于建模,但却蕴含着机器学习中一些重要的基本思想。线性回归,是利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法,运用十分广泛。

优点:结果易于理解,计算不复杂

缺点:对非线性的数据拟合不好

适用数据类型:数值型和标称型

对于单变量线性回归,例如:前面房价例子中房子的大小预测房子的价格。f(x) = w1*x+w0,这样通过主要参数w1就可以得出预测的值。

通用公式为:

$$h\left(\theta\right){=}\theta_0+\theta_1{x}$$

那么对于多变量回归,例如:瓜的好坏程度 f(x) = w0+0.2色泽+0.5根蒂+0.3*敲声,得出的值来判断一个瓜的好与不好的程度。

通用公式为:

$$h\left(\theta\right){=}\theta{0}+\theta{1}{x{1}}+\theta{2}{x_{2}}$$

线性模型中的向量W值,客观的表达了各属性在预测中的重要性,因此线性模型有很好的解释性。对于这种“多特征预测”也就是(多元线性回归),那么线性回归就是在这个基础上得到这些W的值,然后以这些值来建立模型,预测测试数据。简单的来说就是学得一个线性模型以尽可能准确的预测实值输出标记。

那么如果对于多变量线性回归来说我们可以通过向量的方式来表示W值与特征X值之间的关系:

$$\theta = \begin{pmatrix}\theta_0 \\theta_1 \\theta_2 \\theta_3\end{pmatrix}$$ $$X = \begin{pmatrix}x_0\x_1\x_2\x_3\end{pmatrix}$$

两向量相乘,结果为一个整数是估计值,其中所有特征集合的第一个特征值$$x_0$$=1,那么我们可以通过通用的向量公式来表示线性模型:

$$h(\theta) = \theta^T * x$$

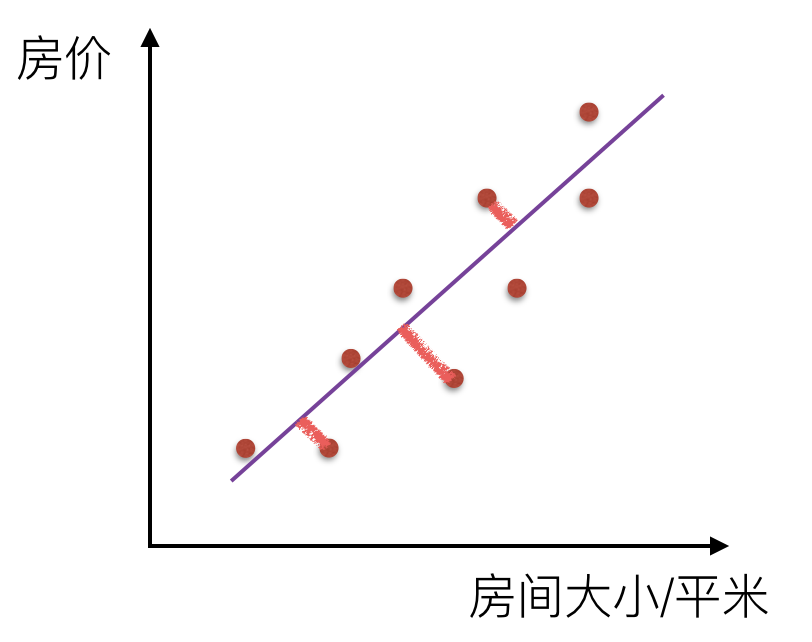

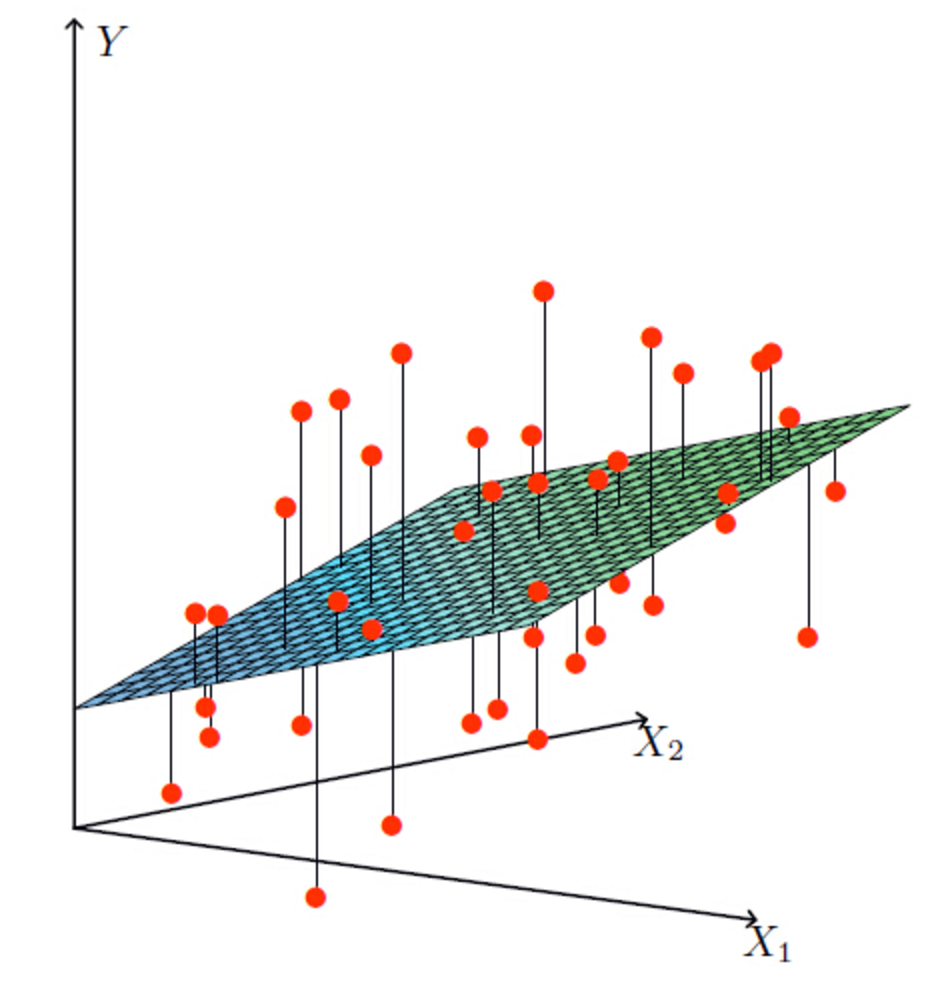

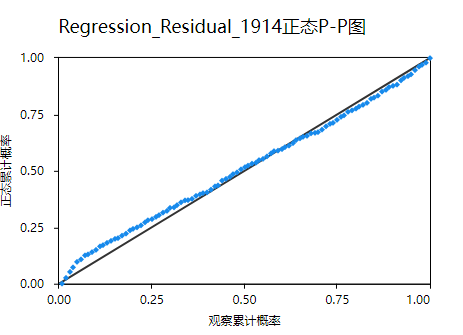

一个列向量的转置与特征的乘积,得出我们预测的结果,但是显然我们这个模型得到的结果可定会有误差,如下图所示:

单变量

多变量

损失函数

损失函数是一个贯穿整个机器学习重要的一个概念,大部分机器学习算法都会有误差,我们得通过显性的公式来描述这个误差,并且将这个误差优化到最小值。

对于线性回归模型,将模型与数据点之间的距离差之和做为衡量匹配好坏的标准,误差越小,匹配程度越大。我们要找的模型就是需要将f(x)和我们的真实值之间最相似的状态。于是我们就有了误差公式,模型与数据差的平方和最小:

$$J\left(\theta\right){=}\sum{i=1}^{m} \left({h\theta}({x}^{(i)}){-}{y}^{(i)}\right)^{2}$$

上面公式定义了所有的误差和,那么现在需要使这个值最小?那么有两种方法,一种使用梯度下降算法,另一种使正规方程解法(只适用于简单的线性回归)。

梯度下降算法

上面误差公式是一个通式,我们取两个单个变量来求最小值,误差和可以表示为:

$$cost\left({w0+w_1x_1}\right){=}\sum{i=1}^{N} \left({w_0+w_1x_i}{-}{y_i}\right)^{2}$$

可以通过调整不同的$$w_1$$和$$w_0$$的值,就能使误差不断变化,而当你找到这个公式的最小值时,你就能得到最好的$$w_1$$,$$w_0$$ 而这对$$\left({w_1},{w_0}\right)$$就是能最好描述你数据关系的模型参数。

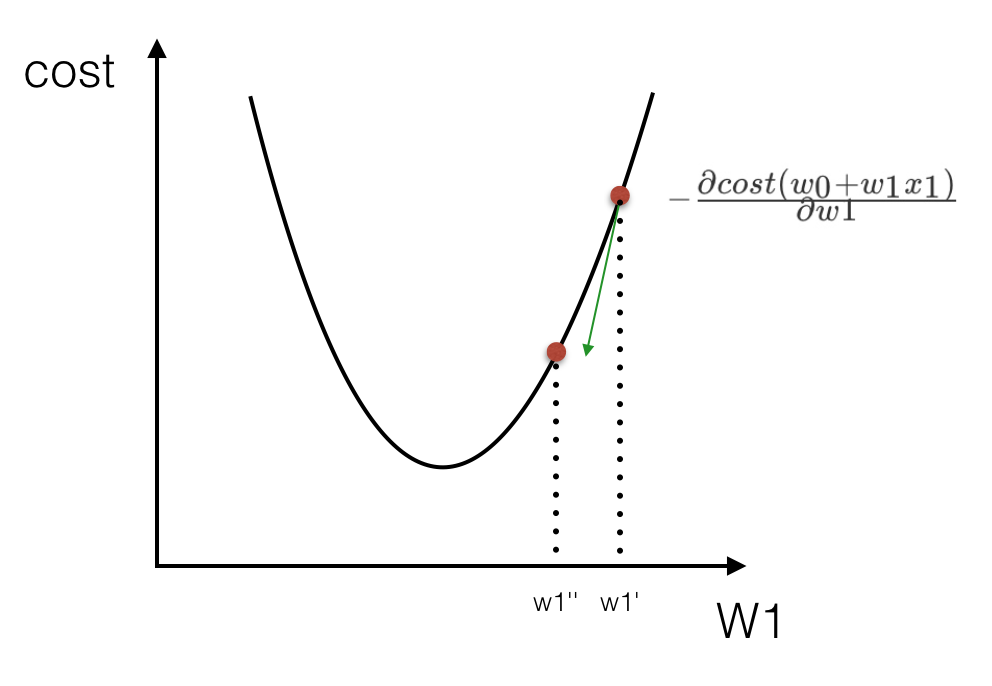

怎么找$$cost\left({w_0+w_1x_1}\right)$$的最小? $$cost\left({w_0+w_1x_1}\right)$$的图像其实像一个山谷一样,有一个最低点。找这个最低点的办法就是,先随便找一个点($$w_1$$=5, $$w_0$$=4), 然后 沿着这个碗下降的方向找,最后就能找到山谷的最低点。

所以得出$${w_1^{''}}-{w_1^{'}}=-\frac{\partial{cost\left({w_0+w_1x_1}\right)}}{\partial w1}$$,那么这个过程是按照某一点在$$w_1$$上的偏导数下降寻找最低点。当然在进行移动的时候也需要考虑,每次移动的速度,也就是$$\alpha$$的值,这个值也叫做(学习率),如下式:

$${w_1}:=-{w_1}-\alpha\frac{\partial{cost\left({w_0+w_1x_1}\right)}}{\partial w1}$$

$${w_0}:=-{w_0}-\alpha\frac{\partial{cost\left({w_0+w_1x_1}\right)}}{\partial w1}$$

这样就能求出$$w_0,w_1$$的值,当然你这个过程是不断的进行迭代求出来,通过交叉验证方法即可。

LinearRegression

sklearn.linear_model.LinearRegression

class LinearRegression(fit_intercept = True,normalize = False,copy_X = True,n_jobs = 1)""":param normalize:如果设置为True时,数据进行标准化。请在使用normalize = False的估计器调时用fit之前使用preprocessing.StandardScaler:param copy_X:boolean,可选,默认为True,如果为True,则X将被复制:param n_jobs:int,可选,默认1。用于计算的CPU核数"""

实例代码:

from sklearn.linear_model import LinearRegression

reg = LinearRegression()

方法

fit(X,y,sample_weight = None)

使用X作为训练数据拟合模型,y作为X的类别值。X,y为数组或者矩阵

reg.fit ([[0, 0], [1, 1], [2, 2]], [0, 1, 2])

predict(X)

预测提供的数据对应的结果

reg.predict([[3,3]])array([ 3.])

属性

coef_

表示回归系数w=(w1,w2....)

reg.coef_array([ 0.5, 0.5])

intercept_表示w0

加入交叉验证

前面我们已经提到了模型的交叉验证,那么我们这个自己去建立数据集,然后通过线性回归的交叉验证得到模型。由于sklearn中另外两种回归岭回归、lasso回归都本省提供了回归CV方法,比如linear_model.Lasso,交叉验证linear_model.LassoCV;linear_model.Ridge,交叉验证linear_model.RidgeCV。所以我们需要通过前面的cross_validation提供的方法进行k-折交叉验证。

from sklearn.datasets.samples_generator import make_regression

from sklearn.model_selection import cross_val_score

from sklearn import linear_model

import matplotlib.pyplot as pltlr = linear_model.LinearRegression()

X, y = make_regression(n_samples=200, n_features=5000, random_state=0)

result = cross_val_score(lr, X, y)

print result

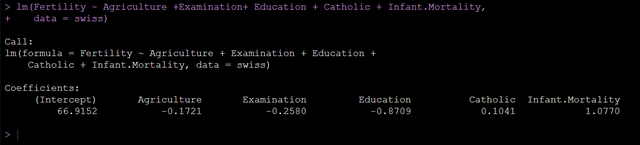

三、线性回归案例分析

波士顿房价预测

使用scikit-learn中内置的回归模型对“美国波士顿房价”数据进行预测。对于一些比赛数据,可以从kaggle官网上获取,网址:https://www.kaggle.com/datasets

1.美国波士顿地区房价数据描述

from sklearn.datasets import load_bostonboston = load_boston()print boston.DESCR

2.波士顿地区房价数据分割

from sklearn.cross_validation import train_test_split

import numpy as np

X = boston.data

y = boston.targetX_train,X_test,y_train,y_test = train_test_split(X,y,random_state=33,test_size = 0.25)

3.训练与测试数据标准化处理

from sklearn.preprocessing import StandardScaler

ss_X = StandardScaler()

ss_y = StandardScaler()X_train = ss_X.fit_transform(X_train)

X_test = ss_X.transform(X_test)

y_train = ss_X.fit_transform(y_train)

X_train = ss_X.transform(y_test)

4.使用最简单的线性回归模型LinearRegression和梯度下降估计SGDRegressor对房价进行预测

from sklearn.linear_model import LinearRegression

lr = LinearRegression()

lr.fit(X_train,y_train)

lr_y_predict = lr.predict(X_test)from sklearn.linear_model import SGDRegressor

sgdr = SGDRegressor()

sgdr.fit(X_train,y_train)

sgdr_y_predict = sgdr.predict(X_test)

5.性能评测

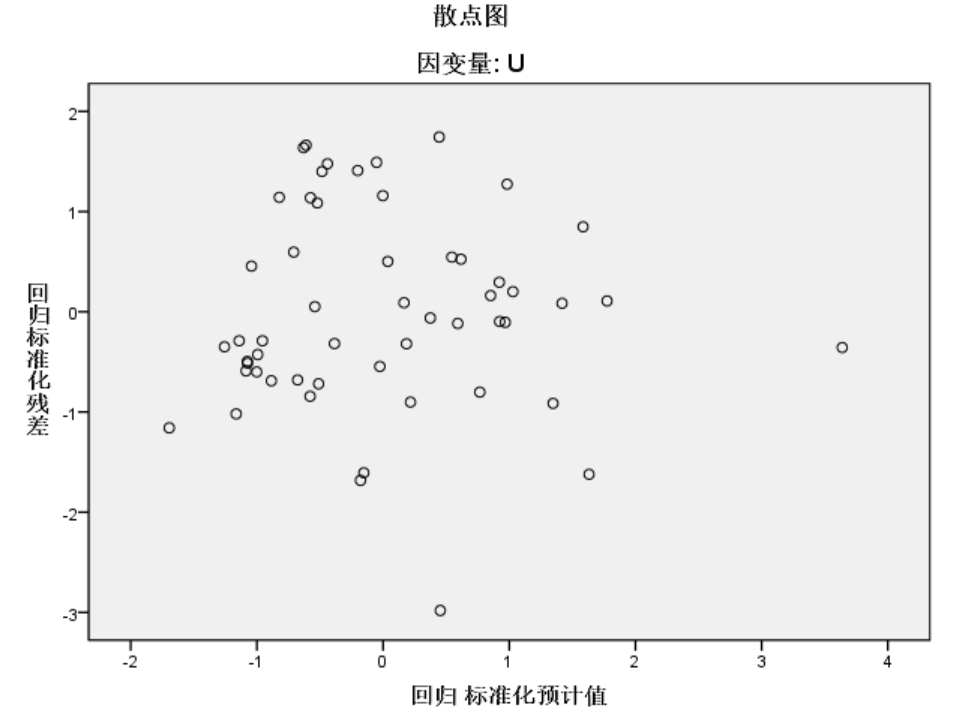

对于不同的类别预测,我们不能苛刻的要求回归预测的数值结果要严格的与真实值相同。一般情况下,我们希望衡量预测值与真实值之间的差距。因此,可以测评函数进行评价。其中最为直观的评价指标均方误差(Mean Squared Error)MSE,因为这也是线性回归模型所要优化的目标。

MSE的计算方法如式:

$${MSE=}\frac{1}{m}\sum_{i=1}^{m}\left({y^{i}-\bar{y}}\right)^{2}$$

使用MSE评价机制对两种模型的回归性能作出评价

from sklearn.metrics import mean_squared_errorprint '线性回归模型的均方误差为:',mean_squared_error(ss_y.inverse_transform(y_test),ss_y.inverse_tranform(lr_y_predict))

print '梯度下降模型的均方误差为:',mean_squared_error(ss_y.inverse_transform(y_test),ss_y.inverse_tranform(sgdr_y_predict))

通过这一比较发现,使用梯度下降估计参数的方法在性能表现上不及使用解析方法的LinearRegression,但是如果面对训练数据规模十分庞大的任务,随即梯度法不论是在分类还是回归问题上都表现的十分高效,可以在不损失过多性能的前提下,节省大量计算时间。根据Scikit-learn光网的建议,如果数据规模超过10万,推荐使用随机梯度法估计参数模型。

注意:线性回归器是最为简单、易用的回归模型。正式因为其对特征与回归目标之间的线性假设,从某种程度上说也局限了其应用范围。特别是,现实生活中的许多实例数据的各种特征与回归目标之间,绝大多数不能保证严格的线性关系。尽管如此,在不清楚特征之间关系的前提下,我们仍然可以使用线性回归模型作为大多数数据分析的基线系统。

完整代码如下:

from sklearn.linear_model import LinearRegression, SGDRegressor, Ridge

from sklearn.preprocessing import StandardScaler

from sklearn.datasets import load_boston

from sklearn.cross_validation import train_test_split

from sklearn.metrics import mean_squared_error,classification_report

from sklearn.cluster import KMeansdef linearmodel():"""线性回归对波士顿数据集处理:return: None"""# 1、加载数据集ld = load_boston()x_train,x_test,y_train,y_test = train_test_split(ld.data,ld.target,test_size=0.25)# 2、标准化处理# 特征值处理std_x = StandardScaler()x_train = std_x.fit_transform(x_train)x_test = std_x.transform(x_test)# 目标值进行处理std_y = StandardScaler()y_train = std_y.fit_transform(y_train)y_test = std_y.transform(y_test)# 3、估计器流程# LinearRegressionlr = LinearRegression()lr.fit(x_train,y_train)# print(lr.coef_)y_lr_predict = lr.predict(x_test)y_lr_predict = std_y.inverse_transform(y_lr_predict)print("Lr预测值:",y_lr_predict)# SGDRegressorsgd = SGDRegressor()sgd.fit(x_train,y_train)# print(sgd.coef_)y_sgd_predict = sgd.predict(x_test)y_sgd_predict = std_y.inverse_transform(y_sgd_predict)print("SGD预测值:",y_sgd_predict)# 带有正则化的岭回归rd = Ridge(alpha=0.01)rd.fit(x_train,y_train)y_rd_predict = rd.predict(x_test)y_rd_predict = std_y.inverse_transform(y_rd_predict)print(rd.coef_)# 两种模型评估结果print("lr的均方误差为:",mean_squared_error(std_y.inverse_transform(y_test),y_lr_predict))print("SGD的均方误差为:",mean_squared_error(std_y.inverse_transform(y_test),y_sgd_predict))print("Ridge的均方误差为:",mean_squared_error(std_y.inverse_transform(y_test),y_rd_predict))return None