论文链接

A Diverse Driving Dataset for Heterogeneous Multitask Learning

Abstract

介绍了BDD100K数据集,包含100K段视频以及10种类型的任务,针对这种多元化任务需要特殊的训练策略。

1 Introduction

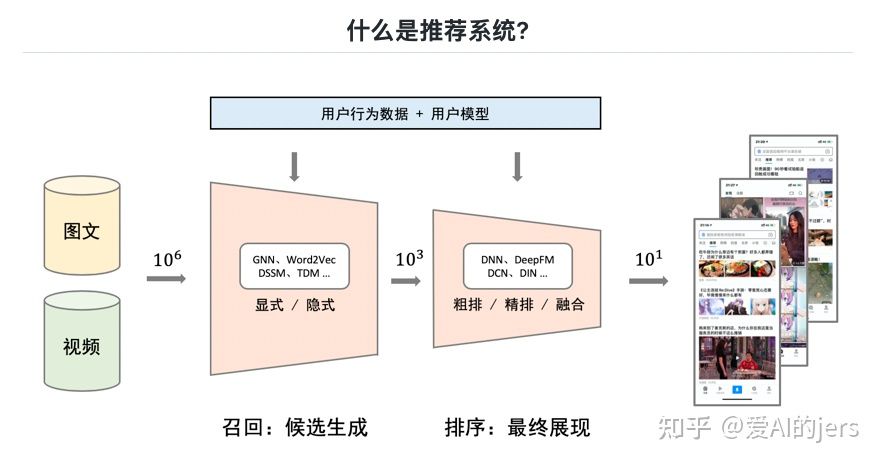

ImageNet、COCO等数据集在之前很长一段时间里推动了计算机视觉的发展,针对自动驾驶,作者团队提出了BDD100K数据集,包含image tagging, lane detection, drivable area segmentation, road object detection, semantic segmentation, instance segmentation, multi-object detection tracking, multi-object segmentation tracking, domain adaptation, and imitation learning十项任务,并且提供了相应的评估方法。挑战来源于通过一种单一模型支持多种任务。

2 Related Work

一般的Visual datasets往往是general-purpose的,作者推出的数据集提供了像素级别的标注,并且提供了视觉信息以外的维度。

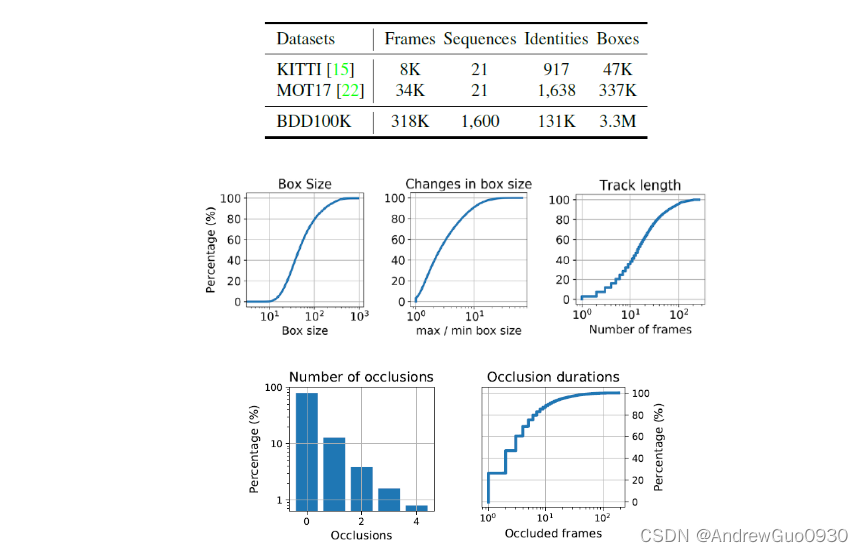

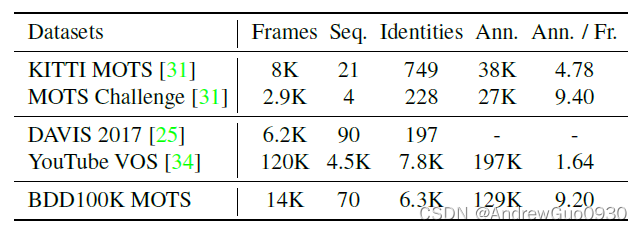

由于自动驾驶技术的发展,Driving datasets在近些年得到了广泛关注。MOT等数据集关注行人目标,Cityscapes提供了语义分割信息,RobotCar、KITTI还提供了雷达点云信息,Mapillary Vistas提供了fine-grained annotations。

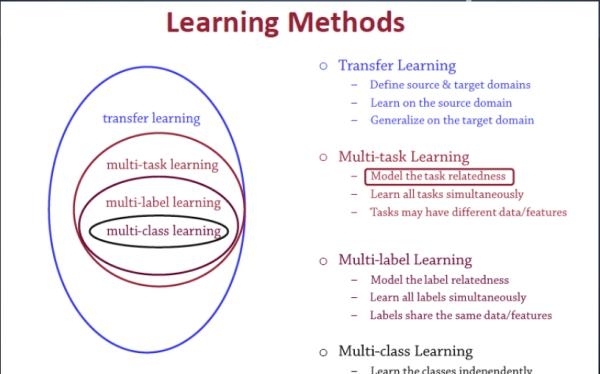

Multitask Learning旨在通过从其他任务学习提高通用性。随着对任务间关系的研究不断深入,多任务学习、迁移学习(transfer learning)相关的benchmarks以及challenges不断涌现,通过单一模型完成多种任务。

3 BDD100K

3.1 Image Tagging

给图像打标签,例如天气、场景、早晚等,提供了DLA-34分类的结果。

3.2 Object Detection

提供了bbox信息以及可见度信息。

3.3 Lane Marking

相关的数据集很少并且种类较为单一,BDD100K的车道标记包含road curb, crosswalk, double hite, double yellow, double other color, single white, single yellow, single other color八种类型。

3.4 Drivable Area

实际情况下并不一定存在车道线,并且车不是所有情况都在线内开。BDD100K的可行驶区域分为directly和alternatively两类,前者为当前行驶的区域,后者为可以变道的区域。

3.5 Semantic Instance Segmentation

数据集的划分为train:val:test=7K:1K:2K。

3.6 Multiple Object Tracking

2000段视频,约400K帧,每段视频约40s,按照5 FPS速度标注,train:val:test=1400:200:200。Waymo数据集视频段数更少,但是拥有更多的2D标注框。

3.7 Multiple Object Tracking and Segmentation(MOTS)

3.8 Imitation Learning

人类的操作得到的视觉或驾驶轨迹信息可用于机器的模仿学习。

4 Diversity

BDD100K的数据很丰富。

5 Multitask Learning

5.1 Homogeneous Multitask Learning

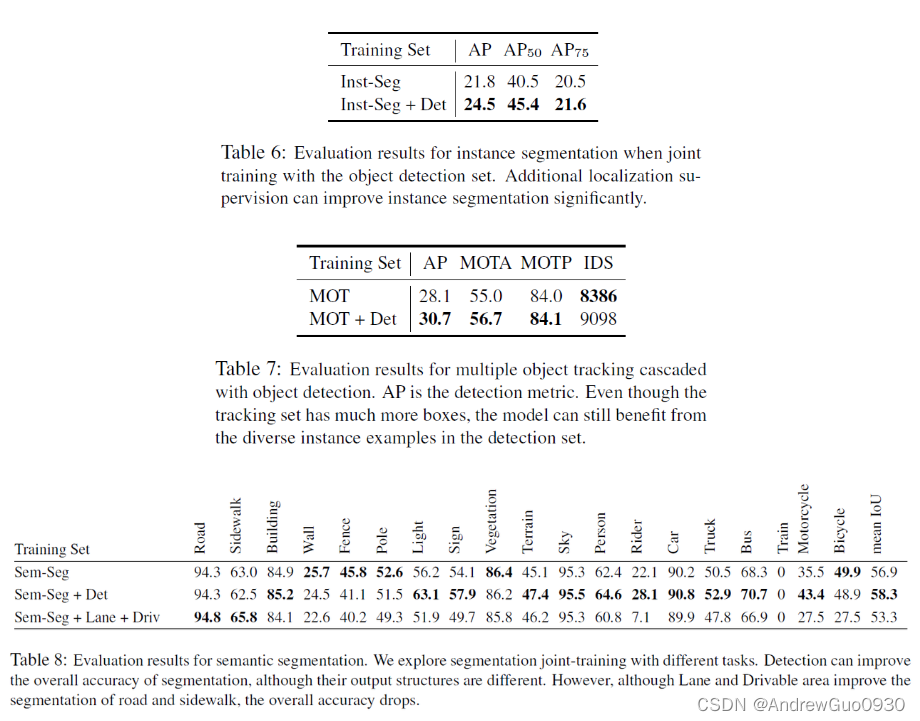

举个例子,lane marking与drivable area具有相同的数据子集,可将drivable area看作分割,lane marking看作轮廓检测,并且通过mean IoU评估分割,Optimal Dataset Scale F-measure (ODS-F)评估车道线标记。我们假设这两项任务具有同样的预测结构,但这样可能导致无法从每个单独任务中获取新信息。

5.2 Cascaded Multitask Learning

比如将目标检测与实例分割、多目标跟踪与目标检测、语义分割与其他任务级联起来,能得到更好的效果。

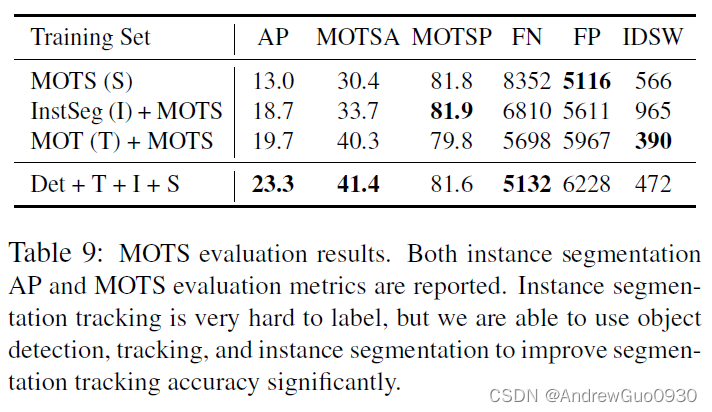

5.3 Heterogeneous Multitask Learning

异构多任务学习,作者举了一个例子,在InstSeg的预训练模型上进行fine-tune以实现MOTS模型,结果segmentation AP和MOTSP均有提升;而在MOT的预训练模型上进行fine-tune,其中IDSW明显降低;最后将四个任务综合起来,得到的结果均有一定的提升。

6 Conclusion

推出了BDD100K数据集,建立了基准,多任务学习,希望能促进未来异质多任务学习的发展。