转载自:自动驾驶之心

01 引言

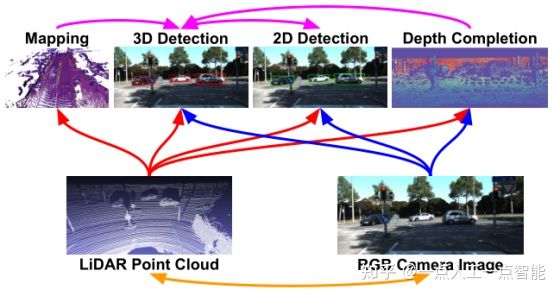

本文介绍一篇uber公司在CVPR上发表的一篇论文,即使用多种传感器(LiDAR和RGB相机)数据,以及多任务进行数据融合,实现准确高效的3D目标检测。简而言之,自动驾驶领域因为:

1.相机无法提供细颗粒度的3D目标特征信息;

2.LiDAR只能提供稀疏的观测信息。

由于这两个主要原因,很直观的科研界和工业界提出了很多多传感器融合的方法,那么如何实施融合,又大致分为以下三类:

• 多传感器级联式特征数据融合;

• 一阶段特征检测融合;

• 二阶段特征检测融合。

然而,这些方法也有存在很多不足。

比如,多传感器级联式特征数据融合方法,简单来说,就是以“串联”的方式,把不同传感器的数据进行融合优化,那么不同级联阶段,不同的传感器的缺陷依然制约着最终的检测精度。

一阶段特征检测融合,一般方法是使用某一种传感器数据,其他传感器数据用来做优化,一般做法都是用LiDAR数据来优化相机特征数据,但是LiDAR数据往往过于稀疏,某些特殊情况下,一个特征只有一个点来表示,那么对于融合优化的性能提升微乎其微。

二阶段特征检测融合,就不仅仅是基于低级特征进行融合,而是在不同传感器数据低级特征的基础上,进一步使用ROI等方法,提取更高维度的特征信息,最终实现准确的目标检测,但是缺点也很明显,这一过程耗时严重,对于能否满足自动驾驶的实时检测有待商榷。

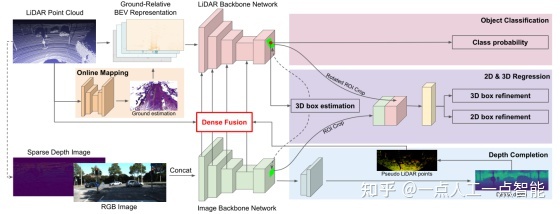

针对这些方法的不足,本文提出了基于多任务和多传感器数据融合实现3D目标检测算法,下面是本算法的具体实施方案图。从下往上来看,就是以LiDAR数据和RGB相机数据作为输入,分别实施四种任务:建图、3D目标检测、3D目标检测、深度估计。

02 算法框架详解

如果用一句话总结本算法的措施,就是----“大力出奇迹”。本算法,相当于将多传感器(LiDAR和相机)数据,分别实施了不同的任务,包括:建图、3D目标检测、3D目标检测、深度估计。这四种不同的任务,然后结合这四种不同任务的结果,实现3D目标的准确预测,这种冗余的功能必然带来性能的提升,同样也会带来一些问题,比如算法运行的时间效率就是一个问题,从这个思路入手,进一步挖掘,可能又是一个算法思路。这里,我们给出算法框架图。

整个算法框架很好理解,从左到右,依次是数据输入,一阶段的数据提取,二阶段的不同任务计算和3D目标检测。

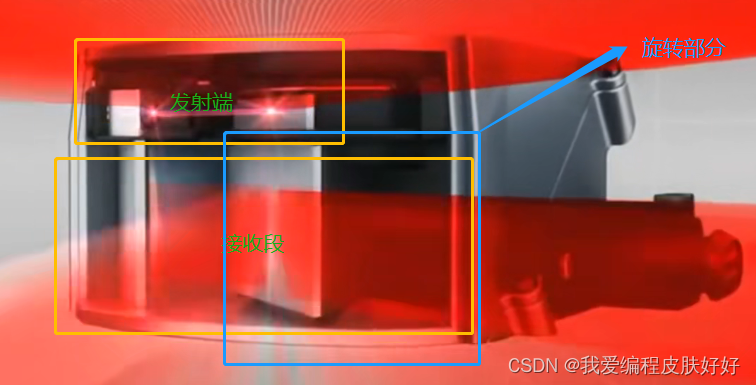

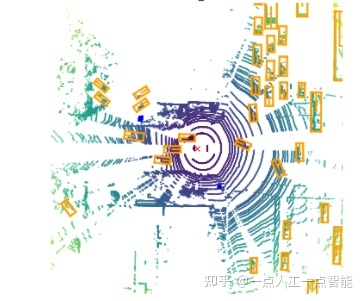

数据输入,LiDAR数据为了方便和效率,使用体素格式表示LiDAR数据,简单的示例如下。LiDAR数据的又是很明显,对于表示细粒度的目标方便便捷,但是往往特征信息丰富程度不充分。此外,本文为了简化计算量,直接使用鸟瞰图替代了真实3D体素点云图,这样,就减少了一个维度,大大减少了计算量。需要注意的是,LiDAR点云数据同样生成了衣服稀疏深度图像,作为深度估计任务的输入之一。对于RGB相机数据,大家都比较数据,直接作为数据进行输入。

一阶段的数据提取,这里采用普遍的深度神经网络结构,值得注意的是,本算法采用了两路网络结构,这同样很消耗计算量。具体来来说,就是RGB相机图像数据输入到一个ResNet中,LiDAR数据也输入到一个稍作修改的ReNet中(这里的修改是基于ResNet-18基础上,加深了网络深度,同时减小网络宽度),LiDAR数据处理的网络之后接着FPN,实现多尺度特征提取。这样,本算法就实现了对于RGB图像特征信息和LiDAR数据特征信息的提取。

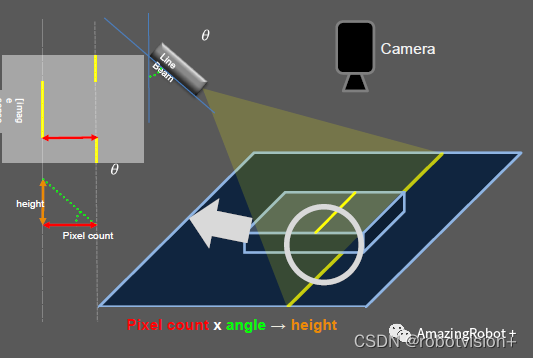

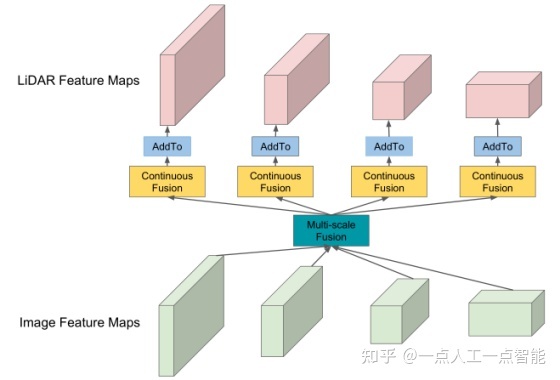

二阶段操作,主要涵盖了像素级的数据融合和ROI级的数据融合。由上一阶段得到的多尺度特征信息,将从图像数据提取到富信息与LiDAR特征信息进行融合,像素级信息融合,如下图所示。

值得注意的是,不是将两种传感器特征信息进行直接相加,而是通过构建图像特征图与点云鸟瞰图之间构建稠密准确的关系,简单的做法就是:对于鸟瞰特征图中每一个像素,找到LiDAR数据中的最近点,投影到图像特征图中,从而获得对于的图像数据特征信息,进一步计算鸟瞰图像素和LiDAR点之间的距离作为几何特征信息,最终将几何特征信息和图像特征信息联合输入到多层感知机进一步像素级融合。

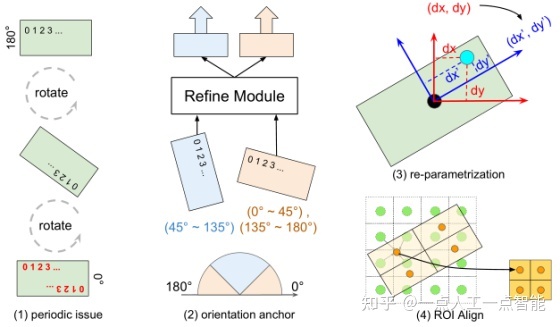

ROI级别的特征提取,则是为了进一步提高3D目标检测的精度。这样的话,ROI特征提取就要非常准确,从而预测出准确的box,通过将3D检测结果投影到图像和鸟瞰特征图上,获得一个轴对齐的图像ROI和一个有方向的鸟瞰ROI,这一过程又包含了三种特征增强方法,分别是:周期性旋转、方向性锚点和ROI对齐。

03 试验和结果

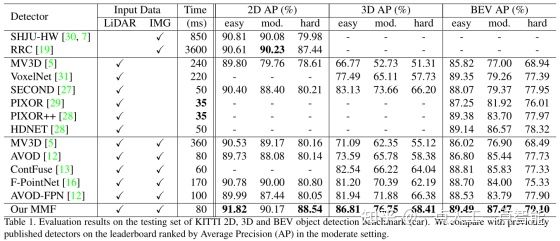

本文提出的算法,在KITTI的2D、3D和BEV数据上,进行评估算法的各项性能,同时在TOR4D比赛上评估了算法的性能。这里不详述KITTI数据集相关介绍,需要进一步了解的同学可以在文末的引用链接进一步查看。

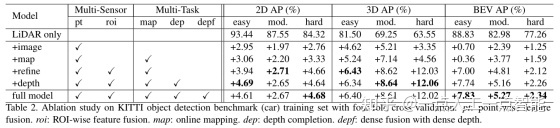

从上面的截图可知,本文算法在KITTI数据上都获得最有的性能表现,基本都有2个百分点的提高,这主要是归结于本算法使用了多种不同任务来辅助提高目标检测精度。进一步,为了衡量不同功能模块对于性能的影响,这里使用了消融实验,主要涵盖了LiDAR、图像、建图、优化约束和深度估计,这几个功能模块,具体的效果如下图。

简单来说,在2D和3D数据上,深度估计模块对于性能的提高最为重要,而在鸟瞰数据集上,算法整体对于功能提高影响最大。

04 总结

本文提出了一种多任务多传感器检测模型,该模型联合推理 2D 和 3D 对象检测、全局估计和深度补全。像素级和 ROI级特征融合用于实现完整的多传感器融合,而多任务学习提供额外的地图先验和几何线索,从而实现更好的表示学习和更密集的特征融合。在 KITTI 和 TOR4D基准上验证了所提出的方法,并在所有检测任务中大大超越了最新技术。

多任务多传感器数据融合实现3D目标检测https://mp.weixin.qq.com/s/gPciLw5RT1iDYySTw6vjAw