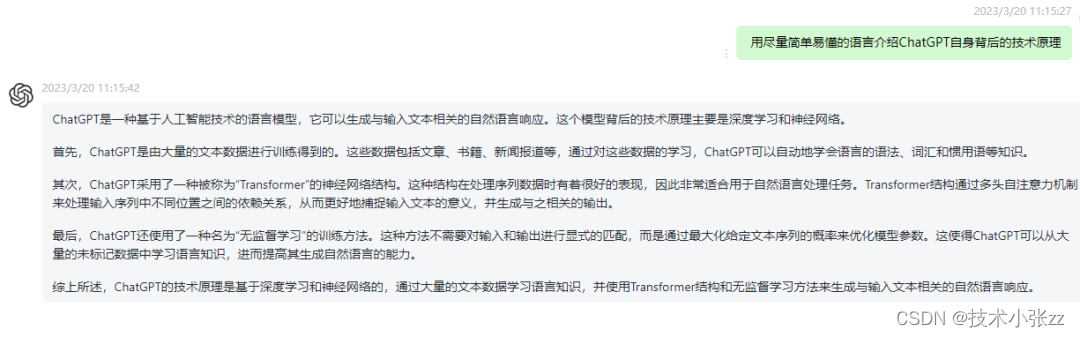

ChatGPT 是一种基于 GPT 模型的对话生成模型,其原理是在预训练的 GPT 模型基础上,使用对话数据进行微调,以生成符合对话场景的文本。

目录

一、ChatGPT的基本原理

二、ChatGPT的实现代码

三、代码的基本思想

一、ChatGPT的基本原理

GPT 模型是一种基于 Transformer 的语言模型,可以生成符合上下文语境的文本。在预训练阶段,GPT 模型使用大量的文本数据进行训练,学习到了丰富的语言知识。在微调阶段,我们可以使用对话数据对 GPT 模型进行微调,以使其生成符合对话场景的文本。

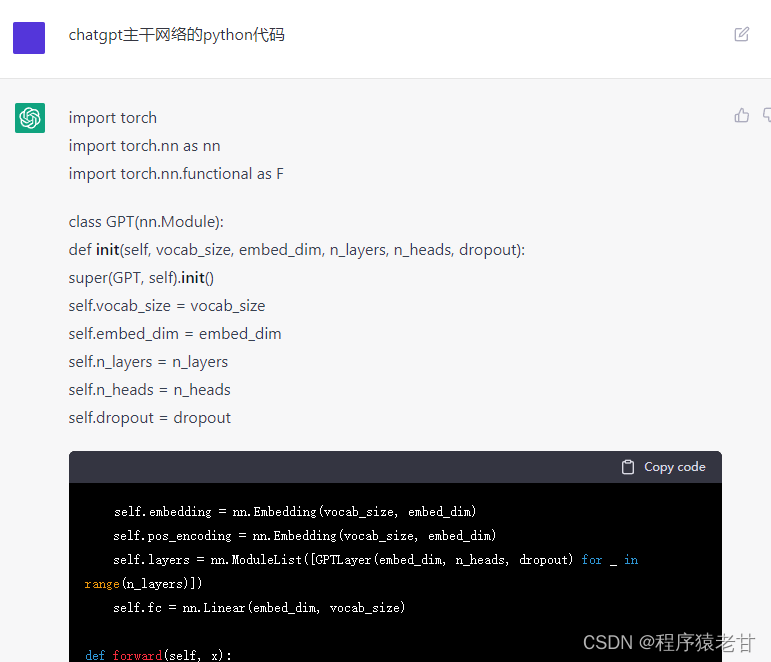

二、ChatGPT的实现代码

ChatGPT 的实现代码如下:

import torch

import torch.nn.functional as F

from transformers import GPT2LMHeadModel, GPT2Tokenizer# 加载预训练模型和分词器

model = GPT2LMHeadModel.from_pretrained('gpt2') # 加载预训练模型

tokenizer = GPT2Tokenizer.from_pretrained('gpt2') # 加载分词器# 定义对话生成函数

def generate(model, tokenizer, prompt, max_length=30, temperature=1.0):# 将对话前缀转换为输入张量input_ids = tokenizer.encode(prompt, add_special_tokens=False, return_tensors='pt')input_ids = input_ids.cuda() # 将输入张量移动到 GPU 上# 使用模型生成文本output = model.generate(input_ids, max_length=max_length, temperature=temperature)# 将输出张量转换为文本并返回return tokenizer.decode(output[0], skip_special_tokens=True)# 微调对话数据

conversation = ["你好,我是小明。","你好,我是小红。","你喜欢什么运动?","我喜欢打篮球。","你呢?","我喜欢跑步。"

]text = ""

for i, sentence in enumerate(conversation):text += sentenceif i % 2 == 0:text += tokenizer.eos_token # 在奇数句子末尾添加 eos 标记model.train() # 设置模型为训练模式

for epoch in range(3):# 将对话数据转换为输入张量input_ids = tokenizer.encode(text, add_special_tokens=True, return_tensors='pt')input_ids = input_ids.cuda() # 将输入张量移动到 GPU 上# 使用模型计算损失并反向传播output = model(input_ids, labels=input_ids)loss = output.lossloss.backward()optimizer.step()optimizer.zero_grad()# 测试对话生成函数

prompt = "你喜欢什么运动?"

response = generate(model, tokenizer, prompt, max_length=20, temperature=0.7)

print(response)

三、代码的基本思想

-

加载预训练模型和分词器。我们使用

GPT2LMHeadModel.from_pretrained()和GPT2Tokenizer.from_pretrained()函数加载预训练的 GPT 模型和分词器。 -

定义对话生成函数。这个函数使用模型和分词器生成对话文本。输入参数包括模型

model、分词器tokenizer、对话前缀prompt、生成文本的最大长度max_length和温度temperature。首先使用分词器将对话前缀转换为输入张量input_ids,并将其移动到 GPU 上。然后使用模型的generate()方法生成文本,并将输出张量转换为文本返回。 -

微调对话数据。首先定义对话数据

conversation,然后将其拼接成一个字符串text,其中奇数句子末尾添加eos标记。然后使用分词器将对话数据转换为输入张量input_ids,并将其移动到 GPU 上。接着使用模型计算损失并反向传播,以微调模型。我们使用model.train()将模型设置为训练模式,并使用optimizer.step()和optimizer.zero_grad()分别执行参数更新和梯度清零操作。 -

测试对话生成函数。我们使用

generate()函数生成对话文本,并将其打印出来。