任务学习-Multitask Learning概述

Reference

https://blog.csdn.net/u010417185/article/details/83065506

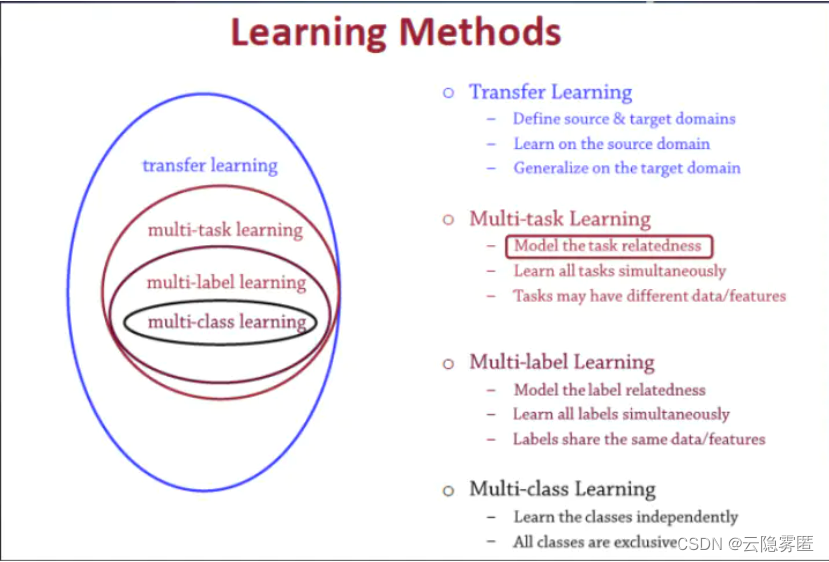

1、单任务学习VS多任务学习

- 单任务学习:一次只学习一个任务(task),大部分的机器学习任务都属于单任务学习。

- 多任务学习:把多个相关(related)的任务放在一起学习,同时学习多个任务。

多任务学习(multitask learning)产生的原因?

现在大多数机器学习任务都是单任务学习。对于复杂的问题,也可以分解为简单且相互独立的子问题来单独解决,然后再合并结果,得到最初复杂问题的结果。这样做看似合理,其实是不正确的,因为现实世界中很多问题不能分解为一个一个独立的子问题,即使可以分解,各个子问题之间也是相互关联的,通过一些共享因素或共享表示(share representation)联系在一起。把现实问题当做一个个独立的单任务处理,忽略了问题之间所富含的丰富的关联信息。多任务学习就是为了解决这个问题而诞生的。把多个相关(related)的任务(task)放在一起学习。这样做真的有效吗?答案是肯定的。多个任务之间共享一些因素,它们可以在学习过程中,共享它们所学到的信息,这是单任务学习所具备的。相关联的多任务学习比单任务学习能去的更好的泛化(generalization)效果。

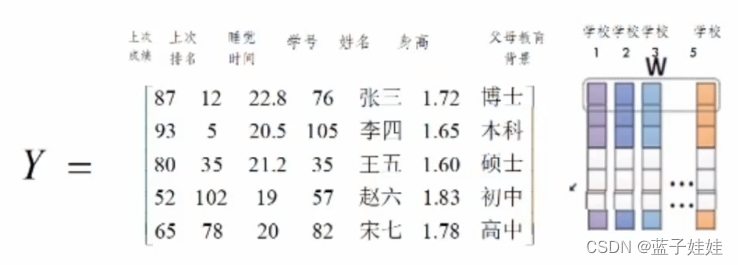

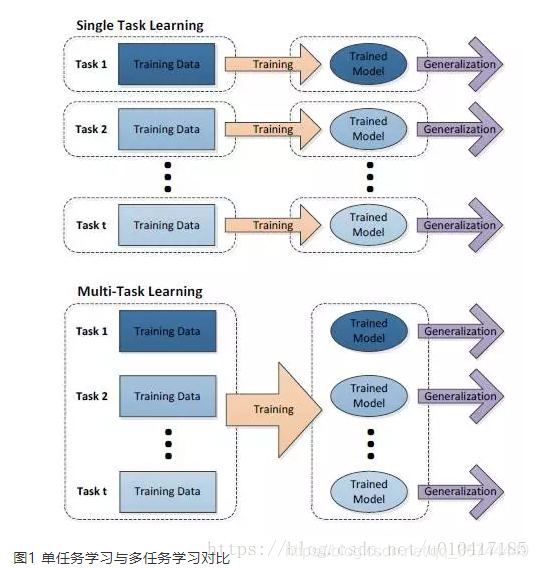

单任务与多任务对比如图1所示:

从图1中可以发现,单任务学习时,各个任务之间的模型空间(Trained Model)是相互独立的(图1上)。多任务学习时,多个任务之间的模型空间(Trained Model)是共享的(图1下)。

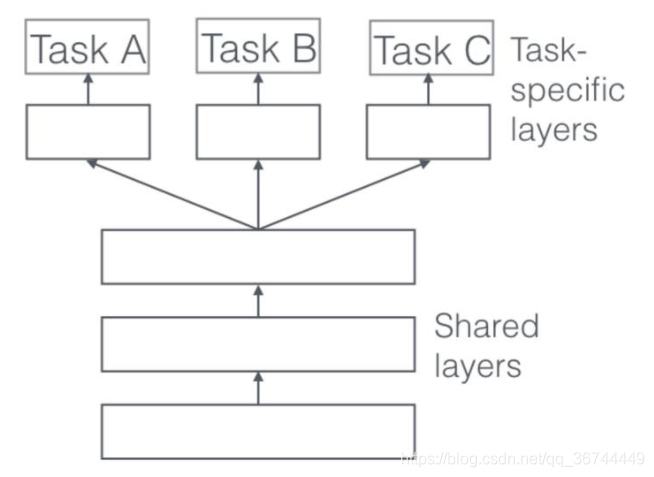

假设用含一个隐含层的神经网络来表示学习一个任务,单任务学习和多任务学习可以表示成如图2所示。

从图二可以发现,单任务学习时,各个task任务的学习是相互独立的,多任务学习时,多个任务之间的浅层表示共享(shared representation)。

2、多任务学习的定义

多任务学习(Multitask learning)定义:基于共享表示(shared representation),把多个相关的任务放在一起学习的一种机器学习方法。

多任务学习(Multitask Learning)是一种推导迁移学习方法,主任务(main tasks)使用相关任务(related tasks)的训练信号(training signal)所拥有的领域相关信息(domain-specific information),做为一直推导偏差(inductive bias)来提升主任务(main tasks)泛化效果(generalization performance)的一种机器学习方法。

多任务学习涉及多个相关的任务同时并行学习,梯度同时反向传播,多个任务通过底层的共享表示(shared representation)来互相帮助学习,提升泛化效果。简单来说:多任务学习把多个相关的任务放在一起学习(注意,一定要是相关的任务,后面会给出相关任务(related tasks)的定义,以及他们共享了那些信息),学习过程(training)中通过一个在浅层的共享(shared representation)表示来互相分享、互相补充学习到的领域相关的信息(domain information),互相促进学习,提升泛化的效果。

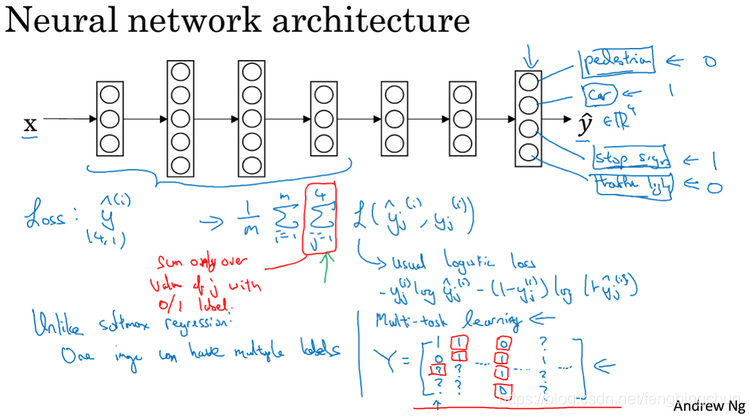

3. 多任务学习 :共享相关任务表征

**定义:**基于共享表示(shared representation),把多个相关的任务放在一起学习的一种机器学习方法。

也就是说,基于某些层的参数共享,训练几个具有相似性的任务,然后给出每个任务的分类结果。

**举例:**比如我们要识别一张图像中的脸是否是人脸、哪种脸部表情、性别、年龄段。针对这个问题,可以用单个模型来预测单个任务,但是可能在数据量不够的情况下,可能会导致过拟合,但是由于这几个任务之间存在一些联系,因此可以考虑用多任务学习,让模型同时给出多个任务的结果。

在实际应用中,通常通过在所有任务之间共享隐藏层,同时保留几个特定任务的输出层来实现。

多任务学习涉及多个相关的任务同时并行学习,梯度同时反向传播,多个任务通过底层的共享表示(shared representation)来互相帮助学习,提升泛化效果。

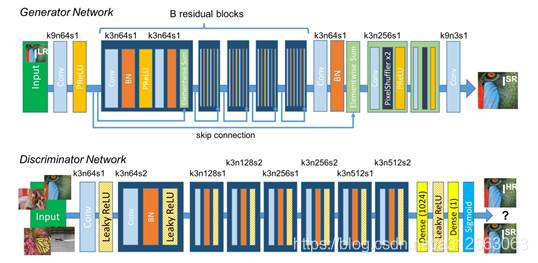

网络结构

硬共享机制:

在一个基学习器的最后一层加上多个特定的输出层,如softmax或者Dense层

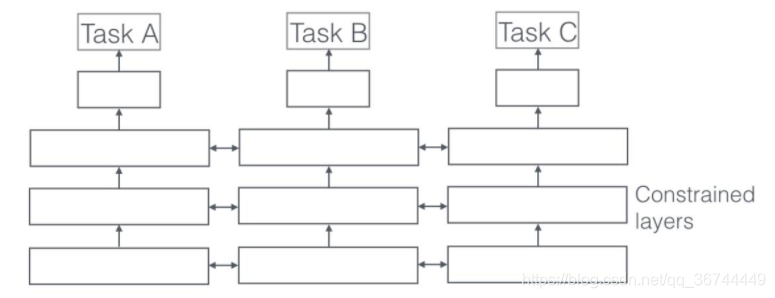

Soft 参数共享机制

另一方面,在共享 Soft 参数时,每个任务都有自己的参数和模型。模型参数之间的距离是正则化的,以便鼓励参数相似化。例如使用 L2 距离进行正则化

硬共享机制实现:

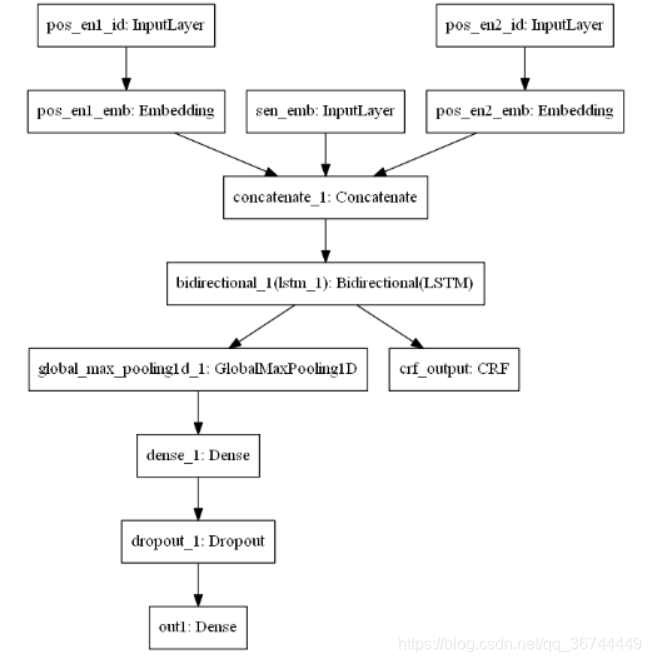

【例1】

https://blog.csdn.net/weixin_39713335/article/details/110599926

from keras.layers import Input,LSTM,Bidirectional,Dense,Dropout,Concatenate,Embedding,GlobalMaxPool1D

from keras.models import Model

from keras_contrib.layers import CRF

import keras.backend as K

from keras.utils import plot_modelK.clear_session()

maxlen = 40#输入

inputs = Input(shape=(maxlen,768),name="sen_emb")

pos1_en = Input(shape=(maxlen,),name="pos_en1_id")

pos2_en = Input(shape=(maxlen,),name="pos_en2_id")

pos1_emb = Embedding(maxlen,8,input_length=maxlen,name = "pos_en1_emb")(pos1_en)

pos2_emb = Embedding(maxlen,8,input_length=maxlen,name = "pos_en2_emb")(pos2_en)

x = Concatenate(axis=2)([inputs,pos1_emb,pos2_emb])#参数共享部分

x = Bidirectional(LSTM(128,return_sequences=True))(x) #双向LSTM#任务一,10分类的文本分类任务

out1 = GlobalMaxPool1D()(x)

out1 = Dense(64, activation='relu')(out1)

out1 = Dropout(0.5)(out1)

out1 = Dense(10, activation='softmax',name = "out1")(out1)#任务二,实体识别任务

crf = CRF(2, sparse_target=True,name ="crf_output")

crf_output = crf(x)#模型有两个输出out1,crf_output

model = Model(inputs=[inputs,pos1_en,pos2_en], outputs=[out1,crf_output])

model.summary()###模型有两个loss,categorical_crossentropy和crf.loss_function

model.compile(optimizer='adam',loss={'out1': 'categorical_crossentropy','crf_output': crf.loss_function},loss_weights={'out1':1, 'crf_output': 1},metrics=["acc"])plot_model(model,to_file="model.png")

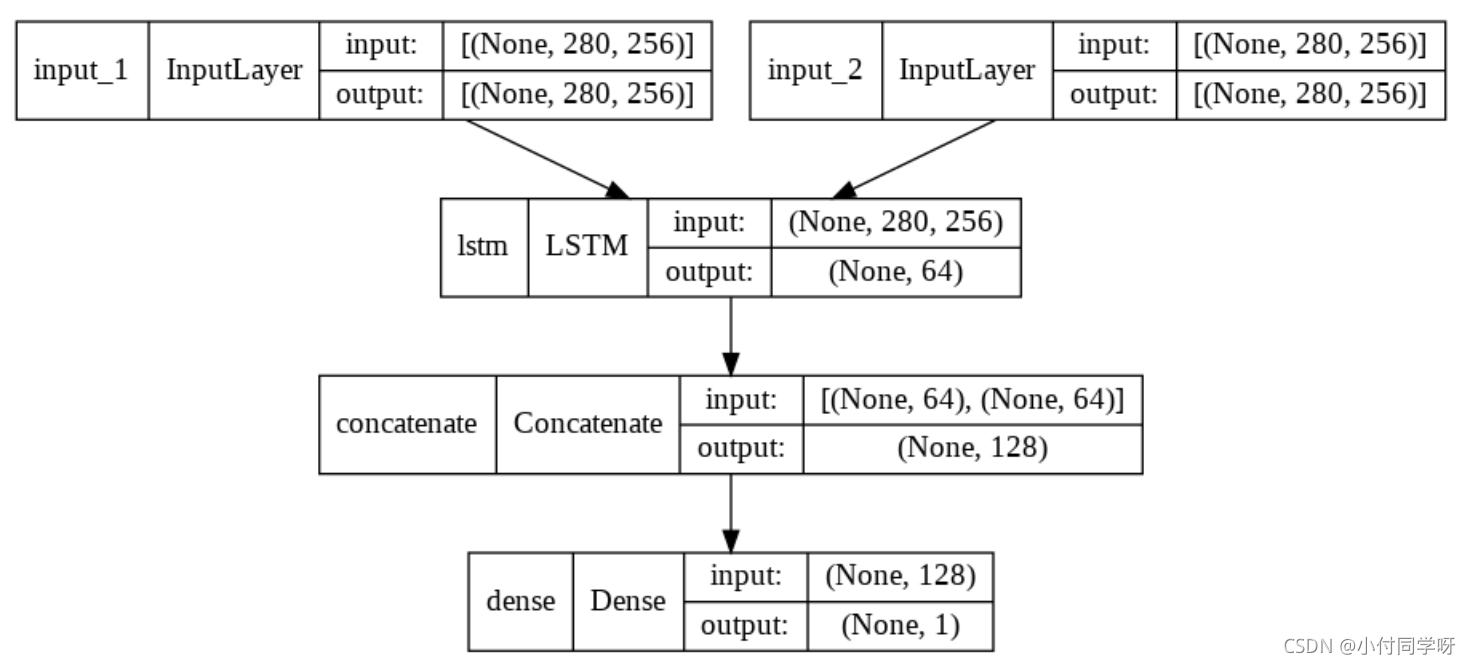

【例2】

https://blog.csdn.net/u010159842/article/details/83034297

# create the base pre-trained model

input_tensor = Input(shape=(299, 299, 3))

base_model = Xception(include_top=True, weights='imagenet', input_tensor=None, input_shape=None)

plot_model(base_model, to_file='xception_model.png')

base_model.layers.pop()

base_model.outputs = [base_model.layers[-1].output]

base_model.layers[-1].outbound_nodes = []

base_model.output_layers = [base_model.layers[-1]]feature = base_model

img1 = Input(shape=(299, 299, 3), name='img_1')

img2 = Input(shape=(299, 299, 3), name='img_2')feature1 = feature(img1)

feature2 = feature(img2)# Three loss functions

category_predict1 = Dense(100, activation='softmax', name='ctg_out_1')(Dropout(0.5)(feature1)

)

category_predict2 = Dense(100, activation='softmax', name='ctg_out_2')(Dropout(0.5)(feature2)

)

dis = Lambda(eucl_dist, name='square')([feature1, feature2])

judge = Dense(2, activation='softmax', name='bin_out')(dis)

model = Model(inputs=[img1, img2], outputs=[category_predict1, category_predict2, judge])

model.compile(optimizer=SGD(lr=0.0001, momentum=0.9),loss={'ctg_out_1': 'categorical_crossentropy','ctg_out_2': 'categorical_crossentropy','bin_out': 'categorical_crossentropy'},loss_weights={'ctg_out_1': 1.,'ctg_out_2': 1.,'bin_out': 0.5},metrics=['accuracy'])

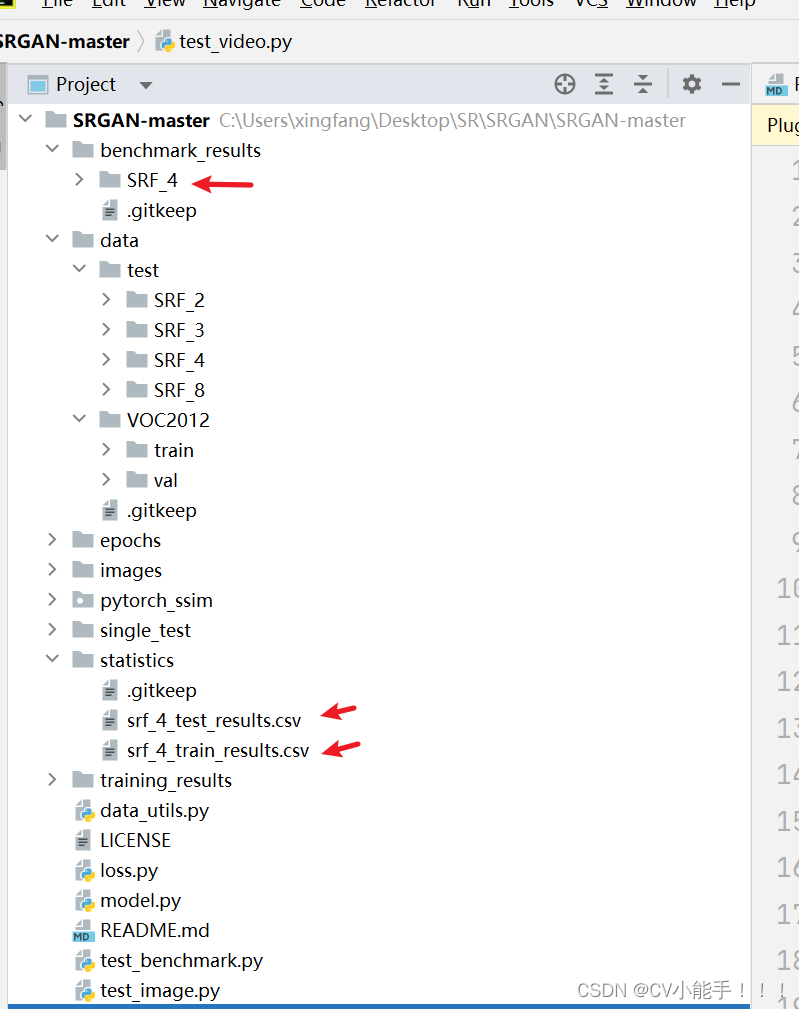

【例3】

https://blog.csdn.net/xiadimichen14908/article/details/89376791

keras多任务学习背景

给定输入狗图片,希望得到类别和年龄这两个分类task的结果,模型主要包括

模型共享一个backbone,这里选择使用resnet,并且用在imagenet训练的结果作为pretrain model,加载模型,也就是这里的my_new_model

设计类别和年龄这两个task的分类器. 这里类别分类器为category一共有11类,采用softmax, 年龄分类器为age,一共有3类,都是采用全连接

整体的模型结构就是model,backbone提取的特征分别送进category和age输出不同task的分类概率。model.complie分别设置loss的种类(交叉熵损失,smooth-l1,MSEloss等),multi-task的loss权重,以及评价的metric

resnet_weights_path='resnet50_weights_tf_dim_ordering_tf_kernels_notop.h5'

my_new_model = Sequential()

my_new_model.add(ResNet50(include_top=False, pooling='avg', weights=None))

my_new_model.add(Activation('relu'))

my_new_model.add(Dropout(0.5))

my_new_model.summary()

img1 = Input(shape=(224, 224, 3), name='img')

feature = my_new_model(img1)

category = Dense(11, activation='softmax',name='category_out1')(feature)

age = Dense(3,activation='softmax',name='age_out2')(feature)

model = Model(inputs=[img1], outputs=[category, age])

model.compile(optimizer='sgd',loss={'category_out1': 'categorical_crossentropy','age_out2': 'categorical_crossentropy'},loss_weights={'category_out1': 1.,'age_out2': 1.},metrics=['accuracy'])