目录

一.Task

二.Task中的全局队列和本地队列

三.TaskCreationOptions 枚举

四.CancellationTokenSource/CancellationToken

1.延时取消线程

2.立即取消:

五.Task的三种调用方式

为了防止大家被标题误导 写在前面:

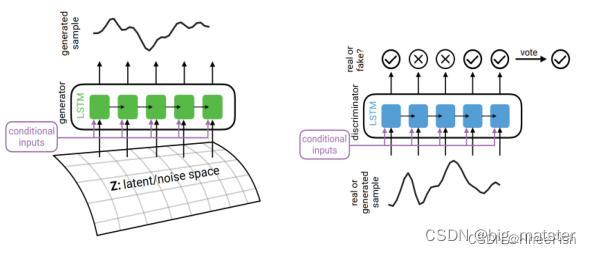

Task并不是线程 Task的执行需要线程池中的或者独立线程来完成Task和线程并不是1对1的关系 这个从下文的图中可以看出,任务只能说是“异步的”,不见得要在其他线程上运行

前言:

终于写到Task了 其实之所以开始写线程的这个专栏 就是因为使用到了Task 因为想对多线程更加了解 所以开始耐着性子从Thread->Interlocker->Monitor->Mutex->ThreadPool 这样一路写了过来 本来以为ThreadPool写完紧接着就能开始写Task 结果又发现了AutoResetEvent/ManualResetEvent和 信号量 Semaphore/SemaphoreSlim 于是又写了一篇关于AutoResetEvent/ManualResetEvent,今天终于写到Task了,有时候就是这样,没有办法一蹴而就需要循序渐进 我在学习中还有很多不足,容易浮躁,这次一套写下来受益匪浅。

一.Task

Task是在ThreadPool的基础上推出的

首先明确Task并不是线程 Task的执行需要线程池中的或者独立线程来完成Task和线程并不是1对1的关系 这个从下文的图中可以看出

关于ThreadPool 我们在 C# 多线程五 ThreadPool线程池的简单理解与运用中已经有介绍不再赘述

我们知道了ThreadPool的弊端:

不能控制线程池中线程的执行顺序,

不能获取线程池内线程取消/异常/完成的通知。

net4.0在ThreadPool的基础上推出了Task,Task拥有线程池的优点,同时也解决了使用线程池不易控制的弊端。

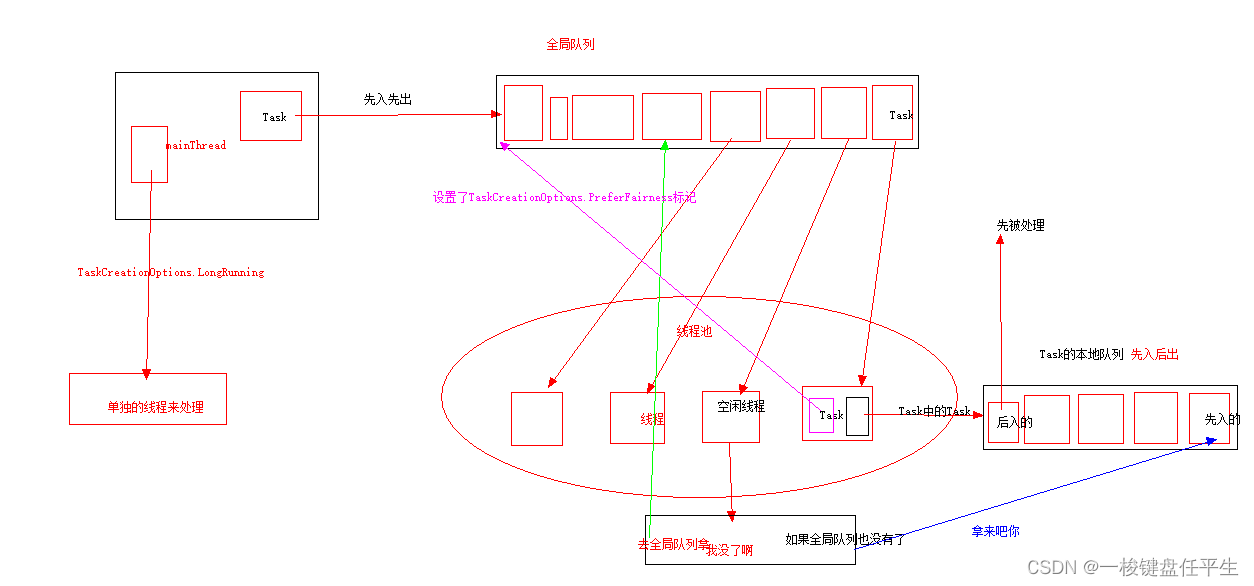

二.Task中的全局队列和本地队列

Task使线程池中的每个线程都有一个本地队列 线程池通过一个任务调度器分配任务

当主线程创建一个Task 由于创建这个Task的并不是线程池中的线程 则任务调度器会把该Task放入全局队列中 如果这个Task是由线程池中的线程创建,并且未设置TaskCreationOptions.PreferFairness标记(默认情况下未设置),则任务调度器会把该Task放入到该线程的本地队列中。如果设置了TaskCreationOptions.PreferFairness标记,则放入全局队列

ThreadPool的运行原理:

Task的运行原理:

三.TaskCreationOptions 枚举

None = 0

默认的,任务进入本地队列,使用线程池中的线程

PreferFairness = 1

preferLocal=false,进入全局队列

LongRunning = 2

默认的TaskScheduler采用的是.NET线程池ThreadPool,它主要面向的是细粒度的小任务,其执行时间通常在毫秒级。线程池中的线程数与处理器的内核数有关,如果线程池中没有空闲的线程,那么后续的Task将会被阻塞。因此,如果事先知道一个Task的执行需要较长的时间,就需要使用TaskCreationOptions.LongRunning枚举指明。使用TaskCreationOptions.LongRunning创建的任务将会脱离线程池启动一个单独的线程来执行。

AttachedToParent = 4

父Task会等待子Task结束。

父Task会捕获子Task的Exception。

父Task的执行状态取决于子Task的执行状态。

子任务和父任务并不一定运行在同一线程上。

DenyChildAttach = 8

如果你不希望一个Task的启动的子Attach附加到它自己身上,则可以在启动父Task时为它指定TaskCreationOptions.DenyChildAttach。通过DenyChildAttach启动的父Task拒绝用AttachedToParent来启动子Task的附加

HideScheduler = 16

当指定TaskCreationOptions.HideScheduler时,创建Task里再创建的子Task将使用默认的TaskScheduler(既是ThreadPoolTaskScheduler——线程池),而不是当前的TaskScheduler。这相当于在创建Task时隐藏了自己当前的TaskScheduler。对于本身就是在默认的TaskScheduler里创建的Task

关于TaskScheduler 这篇博客说的很清楚 有兴趣的可以去看下C#TaskScheduler 任务调度器的原理 - 小林野夫 - 博客园

我个人的理解是 TaskScheduler 就是线程操作任务的逻辑,那些线程用哪些方式去执行或者等待 就想是帮助线程分发任务的一个指挥中心

RunContinuationsAsynchronously = 64

强制异步执行添加到当前任务的延续任务

四.CancellationTokenSource/CancellationToken

CancellationTokenSource通知 CancellationToken,告知其应被取消。

一个 CancellationToken 对象,指示是否请求取消。

一个 CancellationTokenSource 对象,该对象通过其 Token 属性提供取消令牌,并通过调用取消 Cancel 消息或 CancelAfter 方法发送取消消息。

使用方法:

实例化 CancellationTokenSource 对象,此对象管理取消通知并将其发送给单个取消标记。

将 CancellationTokenSource.Token 属性返回的标记传递给每个侦听取消的任务或线程。

CancellationToken.IsCancellationRequested从接收取消令牌的操作调用该方法。 为每个任务或线程提供响应取消请求的机制。 是否选择取消操作,以及具体操作方式取决于应用程序逻辑。

调用 CancellationTokenSource.Cancel 方法以提供取消通知。 这将取消 CancellationToken.IsCancellationRequested 令牌的每个副本上的属性设置为 true。

Dispose使用完对象后CancellationTokenSource调用该方法。

几个常用方法:

Cancel()

传达取消请求。

Cancel(Boolean)

如果出现异常,传达取消请求,并指定是否应处理其余回调和可取消操作。

CancelAfter(Int32)

在指定的毫秒数后计划对此 CancellationTokenSource 的取消操作。

CancelAfter(TimeSpan)

在指定的时间跨度后计划对此 CancellationTokenSource 的取消操作。

Dispose()

释放 CancellationTokenSource 类的当前实例所使用的所有资源。

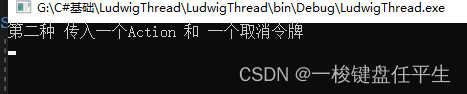

1.延时取消线程

代码:

class Program {static void Main(string[] args) {using(CancellationTokenSource cancellationTokenSource = new CancellationTokenSource()) {Task task2 = new Task(() => {Console.WriteLine("第二种 传入一个Action 和 一个取消令牌");}, cancellationTokenSource.Token);//延时取消cancellationTokenSource.CancelAfter(1000);//取消回调cancellationTokenSource.Token.Register(() => {Console.WriteLine("取消令牌,取消后的回调");});task2.Start();}}

}打印:

2.立即取消:

代码:

class Program {static void Main(string[] args) {using(CancellationTokenSource cancellationTokenSource = new CancellationTokenSource()) {Task task2 = new Task(() => {Console.WriteLine("第二种 传入一个Action 和 一个取消令牌");}, cancellationTokenSource.Token);//取消回调cancellationTokenSource.Token.Register(() => {Console.WriteLine("取消令牌,取消后的回调");});task2.Start();//取消cancellationTokenSource.Cancel();}Console.ReadLine();}

}打印:

注:注意cancellationTokenSource.Cancel();和task2.Start();的执行顺序 如果先cancellationTokenSource.Cancel()然后task2.Start()会报错:不能对已完成的任务执行Start

五.Task的三种调用方式

1.Task task=new task()

task.Start();

使用默认TaskScheduler执行任务

task.Start(TaskScheduler scheduler);

使用只当TaskScheduler执行任务

可以为委托传递一个参数 但是需要装箱拆箱

2.Task.Factory.StartNew()

可以自定义任务调度器

StartNew方法仅在需要精细地控制长时间运行的计算密集型任务时使用

可以为委托传递输入参数。

3.Task.Run(() => { });

使用默认的线程池调度器

Run方法是启动计算密集型任务的建议的方法

Run方法无法为委托传递输入参数。

内容太多分篇了,剩下的下篇在写

C# 多线程八 任务Task的简单理解与运用二

如果有不对的地方希望能指出来 感激不尽。

另外,不熟悉的代码一定要写一下加深记忆 只用看的记不了太久。