机器学习基础:概率论基础

机器学习基础:随机变量及其概率分布

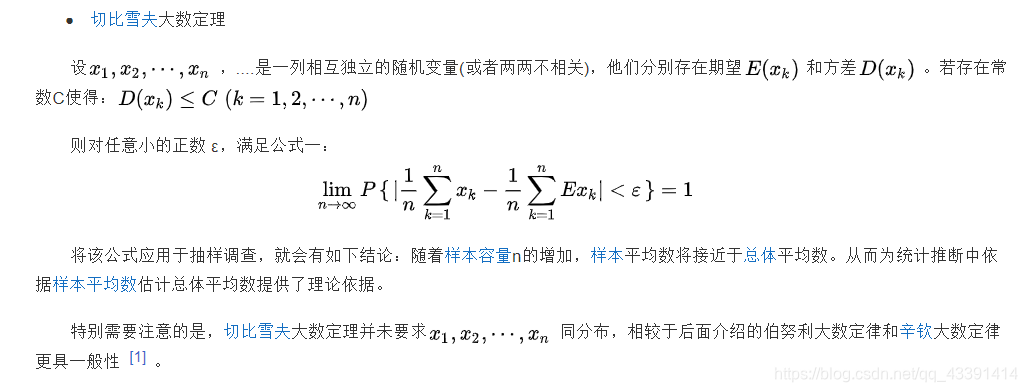

机器学习基础:大数定律与中心极限定理

机器学习必备基础知识,力求以最简洁的语言,描述最完整的内容。

很多知识没有深入剖析,也没必要深入剖析。大致了解知识框架之后,即可开始学习机器学习,有不懂的再回过头再仔细研究,驱动式学习才是最高效的学习。

概率和统计的概念

概率论与数理统计 绝大部分理工科学生都学过的一门课。

概率和统计研究的都是概率相关问题,只是角度刚好相反。

-

概率:已知一个模型和参数,去预测这个模型产生的结果的特性。 比如已知西瓜的甜度成正态分布,预测某写瓜甜度大于某个值的个数。

-

统计:有一堆数据,要利用这堆数据去预测模型和参数。 比如有很多瓜,通过统计大致知道他们的甜度成正态分布,哪个 μ μ μ和 σ σ σ能最准确的描述这些瓜甜度的分布情况呢?

通俗讲就是:概率是已知模型和参数,推数据。统计是已知数据,推模型和参数。

概率

反映随机事件出现的可能性大小。抛硬币正面朝上的概率就是1/2

条件概率

A A A发生条件下 B B B发生的概率

P ( B ∣ A ) = P ( A B ) P ( A ) P(B|A)=\frac{P(AB)}{P(A)} P(B∣A)=P(A)P(AB)

写成乘法

P ( A B ) = P ( A ) P ( B ∣ A ) P(AB)=P(A)P(B|A) P(AB)=P(A)P(B∣A)

A B AB AB事件同时发生的概率,等于事件 A A A发生的概率乘以已知事件 A A A发生时 B B B发生的概率。

乘法公式

P ( A 1 A 2 ) = P ( A 1 ) P ( A 2 ∣ A 1 ) = P ( A 2 ) P ( A 1 ∣ A 2 ) \begin{align} P({{A}_{1}}{{A}_{2}})=P({{A}_{1}})P({{A}_{2}}|{{A}_{1}}) \\=P({{A}_{2}})P({{A}_{1}}|{{A}_{2}}) \end{align} P(A1A2)=P(A1)P(A2∣A1)=P(A2)P(A1∣A2)

P ( A 1 A 2 ⋯ A n ) = P ( A 1 ) P ( A 2 ∣ A 1 ) P ( A 3 ∣ A 1 A 2 ) ⋯ P ( A n ∣ A 1 A 2 ⋯ A n − 1 ) P({{A}_{1}}{{A}_{2}}\cdots {{A}_{n}})=P({{A}_{1}})P({{A}_{2}}|{{A}_{1}})P({{A}_{3}}|{{A}_{1}}{{A}_{2}})\cdots P({{A}_{n}}|{{A}_{1}}{{A}_{2}}\cdots {{A}_{n-1}}) P(A1A2⋯An)=P(A1)P(A2∣A1)P(A3∣A1A2)⋯P(An∣A1A2⋯An−1)

全概率公式

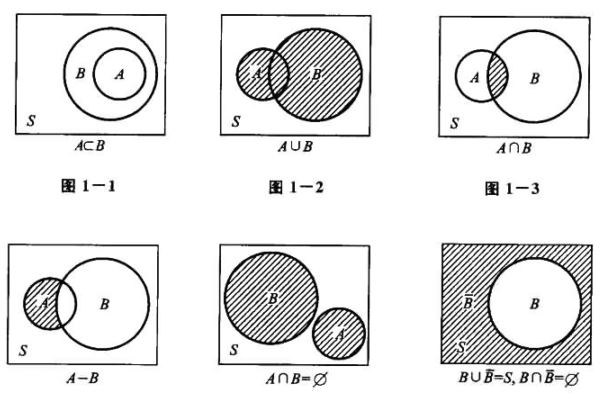

事件组 A 1 , A 2 , . . . , A n ( n 可为 ∞ ) 满足: A_1,A_2,...,A_n(n可为\infin)满足: A1,A2,...,An(n可为∞)满足:

- ⋃ i = 1 n A i = Ω \bigcup_{i=1}^nA_i=\Omega ⋃i=1nAi=Ω

- A 1 , A 2 , . . . , A n A_1,A_2,...,A_n A1,A2,...,An两两互不相容,则 A 1 , A 2 , . . . , A n A_1,A_2,...,A_n A1,A2,...,An为样本空间 Ω \Omega Ω的一个划分或完备事件组

全概率公式要求将样本空间分解成互不相容的简单事件,再研究这些事件发生时复杂事件 B B B的发生概率,合并后的到事件 B B B在样本空间中发生的概率。

P ( B ) = ∑ i = 1 n P ( A i B ) = ∑ i = 1 n P ( A i ) P ( B ∣ A i ) P(B)=\sum_{i=1}^{n}{P(A_iB)}=\sum_{i=1}^{n}P(A_i)P(B|A_i) P(B)=i=1∑nP(AiB)=i=1∑nP(Ai)P(B∣Ai)

先验概率和后验概率

在全概率公式中, A 1 , A 2 , . . . , A n A_1,A_2,...,A_n A1,A2,...,An可以看作 B B B发生的原因, B B B是结果。 P ( A i ) P(A_i) P(Ai)称为先验概率。在机器学习中通常指的是某个分类出现的概率

若在 B B B发生后考察 A i A_i Ai发生的概率(事件 A i A_i Ai对于事件 B B B的影响程度),就是 P ( A i ∣ B ) P(A_i|B) P(Ai∣B),称为后验概率。

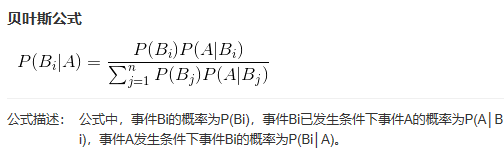

Bayes公式

条件概率中的乘法公式: P ( A B ) = P ( A ) P ( B ∣ A ) = P ( B ) P ( A ∣ B ) P(AB) = P(A)P(B|A) = P(B)P(A|B) P(AB)=P(A)P(B∣A)=P(B)P(A∣B)

即有

P ( A ∣ B ) = P ( A ) P ( B ) ⋅ P ( B ∣ A ) (1) P(A|B)=\frac{P(A)}{P(B)}·P(B|A)\tag{1} P(A∣B)=P(B)P(A)⋅P(B∣A)(1)

进一步加强条件:现在事件B在样本空间中被分割成了两两互不相容事件 A 1 , A 2 , . . . , A n A_1,A_2,...,A_n A1,A2,...,An ( 1 ) (1) (1)式变成了这样

P ( A i ∣ B ) = P ( A i ) P ( B ) P ( B ∣ A i ) (2) P(A_i|B)=\frac{P(A_i)}{P(B)}P(B|A_i)\tag{2} P(Ai∣B)=P(B)P(Ai)P(B∣Ai)(2)

将上面的全概率公式代入:

P ( A i ∣ B ) = P ( A i ) ∑ k = 1 n P ( A k ) P ( B ∣ A k ) ⋅ P ( B ∣ A i ) (3) P(A_i|B)=\frac{P(A_i)}{\sum_{k=1}^{n}P(A_k)P(B|A_k)}·P(B|A_i)\tag{3} P(Ai∣B)=∑k=1nP(Ak)P(B∣Ak)P(Ai)⋅P(B∣Ai)(3)

这就是 B a y e s Bayes Bayes公式

独立性

如果 A , B A,B A,B满足 P ( A B ) = P ( A ) P ( B ) P(AB)=P(A)P(B) P(AB)=P(A)P(B),称事件 A B AB AB相互独立

- 则有 P ( B ∣ A ) = P ( B ) = P ( A ) P(B|A) = P(B)=P(A) P(B∣A)=P(B)=P(A)

随机变量及其概率分布

离散型随机变量

随机变量 X X X的可能取值是离散的,有限个值 x 1 , . . . , x n x_1,...,x_n x1,...,xn或可列无限个值 x 1 , . . . , x n , . . . x_1,...,x_n,... x1,...,xn,...

每个取值对应的概率为 p k p_k pk,记成 P ( X = x i ) = p k , k = 1 , 2 , . . . P(X=x_i)=p_k,\ k=1,2,... P(X=xi)=pk, k=1,2,...,这称为离散型随机变量 X X X的分布律

两点分布

( 0 − 1 ) (0-1) (0−1)分布 又称两点分布 随机变量只可能取0或1

P { X = k } = p k ( 1 − p ) 1 − k ( k = 0 , 1 ) P\{X=k\}=p^k(1-p)^{1-k}\quad\quad\quad\quad(k=0,1) P{X=k}=pk(1−p)1−k(k=0,1)

二项分布

每次试验只有两个结果, A A A与 A ‾ \overline A A,且 P ( A ) = p , P ( A ‾ ) = 1 − p = q P(A)=p,\ P(\overline A)=1-p=q P(A)=p, P(A)=1−p=q

- 重复进行 n n n次试验,每次试验的结果相互独立,分布律为:

p k = P ( X = k ) = C n k p k q n − k 0 < p < 1 , q = 1 − p , k = 0 , 1 , . . . , n p_k=P(X=k)=C_n^kp^kq^{n-k}\\0<p<1,\ q=1-p,\ k=0,1,...,n pk=P(X=k)=Cnkpkqn−k0<p<1, q=1−p, k=0,1,...,n

当 n = 1 n=1 n=1时, p k = P ( X = k ) = p k q n − k p_k=P(X=k)=p^kq^{n-k} pk=P(X=k)=pkqn−k 退化为两点分布

泊松分布

X X X分布律为

p k = P ( X = k ) = λ k k ! e − λ ( k = 0 , 1 , 2... , n ) , λ > 0 p_k=P(X=k)=\frac{\lambda^k}{k!}e^{-\lambda}\\(k=0,1,2...,n),\ \lambda>0 pk=P(X=k)=k!λke−λ(k=0,1,2...,n), λ>0

称 X X X服从以参数为 λ \lambda λ的泊松分布,记为 X ∼ P ( λ ) X\thicksim P(\lambda) X∼P(λ)

- 泊松分布是二项分布的极限分布,当 n n n很大, p p p很小时,二项分布可以近似地看成是参数 λ = n p \lambda=np λ=np的泊松分布

- 常用于描述大量实验中稀有事件出现频数的概率模型。因为根据分布律,当 k k k越大时 P ( X = k ) P(X=k) P(X=k)越来越小(阶乘比指数高阶),也就是说, X X X取大值的概率很小

几何分布

n n n重伯努利试验中,记 X X X为事件 A A A首次发生所需的试验次数,即 P ( X = k ) P(X=k) P(X=k)为 A A A前 k − 1 k-1 k−1次不发生,第 k k k次发生的概率

p k = P ( X = k ) = q k − 1 p k = 1 , 2 , . . . ; q = 1 − p p_k=P(X=k)=q^{k-1}p \quad \quad k=1,2,...;\ q=1-p pk=P(X=k)=qk−1pk=1,2,...; q=1−p

称 X X X服从参数为 p p p的几何分布,记为 X ∼ g ( p ) X\thicksim g(p) X∼g(p)

- 验证分布律性质:

∑ k = 1 ∞ p k = ∑ k = 1 ∞ q k − 1 p = p ∑ k = 1 ∞ q k − 1 = p 1 1 − q = 1 \sum_{k=1}^{\infin}p_k=\sum_{k=1}^{\infin}q^{k-1}p=p\sum_{k=1}^{\infin}q^{k-1}=p\frac1{1-q}=1 k=1∑∞pk=k=1∑∞qk−1p=pk=1∑∞qk−1=p1−q1=1

连续型随机变量

概率密度

-

对于随机变量 X X X,若存在非负函数 f ( x ) , ( − ∞ < x < + ∞ ) f(x),(-\infin<x<+\infin) f(x),(−∞<x<+∞),使对任意实数 x x x,都有

F ( x ) = P ( X ⩽ x ) = ∫ − ∞ x f ( u ) d u F(x)=P(X\leqslant x)=\int_{-\infin}^xf(u)du F(x)=P(X⩽x)=∫−∞xf(u)du

则称 X X X为连续型随机变量, f ( x ) f(x) f(x)为 X X X的概率密度函数,简称概率密度或密度函数常记为 X ∼ f ( x ) , ( − ∞ < x < + ∞ ) X\sim f(x),(-\infin<x<+\infin) X∼f(x),(−∞<x<+∞)

性质

- f ( x ) ⩾ 0 f(x)\geqslant 0 f(x)⩾0

- ∫ − ∞ + ∞ f ( u ) d u = 1 \int_{-\infin}^{+\infin}f(u)du=1 ∫−∞+∞f(u)du=1

- 任意实数 a < b a<b a<b, P ( a < X ⩽ b ) = F ( b ) − F ( a ) = ∫ a b f ( u ) d u P(a<X\leqslant b)=F(b)-F(a)=\int_{a}^{b}f(u)du P(a<X⩽b)=F(b)−F(a)=∫abf(u)du

- 其实上式 P ( a < X ⩽ b ) P(a<X\leqslant b) P(a<X⩽b)中小于号取不取整并不影响结果(与离散型随机变量严格要求左开右闭不同!)因为 f ( x ) f(x) f(x)可积 → \rightarrow → F ( x ) F(x) F(x)连续(左右都连续),有 P ( X = a ) = F ( a ) − F ( a − 0 ) = 0 P(X=a)=F(a)-F(a-0)=0 P(X=a)=F(a)−F(a−0)=0

- 若 x x x是 f ( x ) f(x) f(x)的连续点,则 f ( x ) = F ′ ( x ) f(x)=F'(x) f(x)=F′(x)

均匀分布

-

X X X概率密度为

f ( x ) = { 1 b − a , a<x<b 0 , 其他 f(x)=\begin{cases} \frac1{b-a}, & \text{a<x<b}\\ 0, & \text{其他} \end{cases} f(x)={b−a1,0,a<x<b其他

则称 X X X在**区间[a,b]**上服从均匀分布,记为 X ∼ U [ a , b ] X\sim U[a,b] X∼U[a,b]分布函数为

F ( x ) = { 0 , x<a x − a b − a , a ⩽ x < b 1 , x ⩾ b F(x)=\begin{cases} 0, & \text{x<a}\\ \frac{x-a}{b-a}, & {a\leqslant x<b}\\ 1, &{x\geqslant b} \end{cases} F(x)=⎩ ⎨ ⎧0,b−ax−a,1,x<aa⩽x<bx⩾b -

P ( c < X < d ) = ∫ c d f ( x ) d x = ∫ c d 1 b − a d x = d − c b − a P(c<X<d)=\int_c^df(x)dx=\int_c^d\frac1{b-a}dx=\frac{d-c}{b-a} P(c<X<d)=∫cdf(x)dx=∫cdb−a1dx=b−ad−c

概率意义: X X X落在 ( a , b ) (a,b) (a,b)中任一区间的概率只与该区间的长度成正比,而与该区间的位置无关

指数分布

X X X概率密度为

f ( x ) = { λ e − λ x , x ⩾ 0 0 , x < 0 f(x)=\begin{cases} \lambda e^{-\lambda x},&{x\geqslant 0}\\ 0, &{x<0} \end{cases} f(x)={λe−λx,0,x⩾0x<0

其中 λ > 0 \lambda>0 λ>0为常数,则称 X X X服从参数为 λ \lambda λ的指数分布,记为 X ∼ E ( λ ) X\sim E(\lambda) X∼E(λ)X X X分布函数为

F ( x ) = { 1 − e − λ x , x ⩾ 0 0 , 其他 F(x)=\begin{cases} 1- e^{-\lambda x},&{x\geqslant 0}\\ 0, &{其他} \end{cases} F(x)={1−e−λx,0,x⩾0其他3 正态分布

X X X密度函数为

f ( x ) = 1 2 π σ e − ( x − μ ) 2 2 σ 2 x ∈ R f(x)=\frac{1}{\sqrt {2\pi}\sigma}e^{-\frac{(x-\mu)^2}{2\sigma^2}}\\ x\in \R f(x)=2πσ1e−2σ2(x−μ)2x∈R

其中 μ \mu μ为实数, σ > 0 \sigma>0 σ>0,类比测量时的真实值为 μ \mu μ, n n n次测量均方误差 1 n ∑ ( x i − μ ) 2 → σ 2 \frac1n\sum(x_i-\mu)^2\rightarrow \sigma^2 n1∑(xi−μ)2→σ2,则称 X X X服从参数为 μ , σ 2 \mu,\sigma^2 μ,σ2的正态分布,也称高斯分布,记为 X ∼ N ( μ , σ 2 ) X\sim N(\mu,\sigma^2) X∼N(μ,σ2)密度函数图像性质:

-

单峰对称:关于直线 x = μ x=\mu x=μ对称, x = μ x=\mu x=μ时 f ( x ) m a x = 1 2 π σ f(x)_{max}=\frac1{\sqrt{2\pi} \sigma} f(x)max=2πσ1

-

由于图像覆盖面积是 1 1 1,固定 μ \mu μ时, σ \sigma σ越小,最高点越高,即图形越高越陡;反之图形越低越平(换个角度,误差越小越靠近真实值 μ \mu μ)

-

μ = 0 , σ = 1 \mu=0,\ \sigma=1 μ=0, σ=1时的正态分布称为标准正态分布,记作 X ∼ N ( 0 , 1 ) X\sim N(0,1) X∼N(0,1)

-

f ( x ) = 1 2 π e − x 2 2 x ∈ R f(x)=\frac{1}{\sqrt {2\pi}}e^{-\frac{x^2}{2}}\quad\quad\quad x\in \R f(x)=2π1e−2x2x∈R

分布函数

Φ ( x ) = P ( X ⩽ x ) = 1 2 π ∫ − ∞ x e − t 2 2 d t x ∈ R Φ ( 0 ) = 1 2 Φ ( + ∞ ) ( 对称性 ) \Phi(x)=P(X\leqslant x)=\frac{1}{\sqrt {2\pi}}\int _{-\infin}^x e^{-\frac{t^2}{2}}dt\\ x\in \R\\ \Phi(0)=\frac12\Phi(+\infin)(对称性) Φ(x)=P(X⩽x)=2π1∫−∞xe−2t2dtx∈RΦ(0)=21Φ(+∞)(对称性)对标准正态分布的分布函数 Φ ( x ) \Phi(x) Φ(x),有 Φ ( − x ) = 1 − Φ ( x ) \Phi(-x)=1-\Phi(x) Φ(−x)=1−Φ(x)

-

-