文章目录

- 写作缘起

- 上代码

- 思路分析

- 效果展示

- 写在最后

写作缘起

南墙最近发现自己常用的看小说网站多了许多广告,果然商业化的现今网上几无净土啊,便决定自己写个小说下载器,这样看小说贼爽

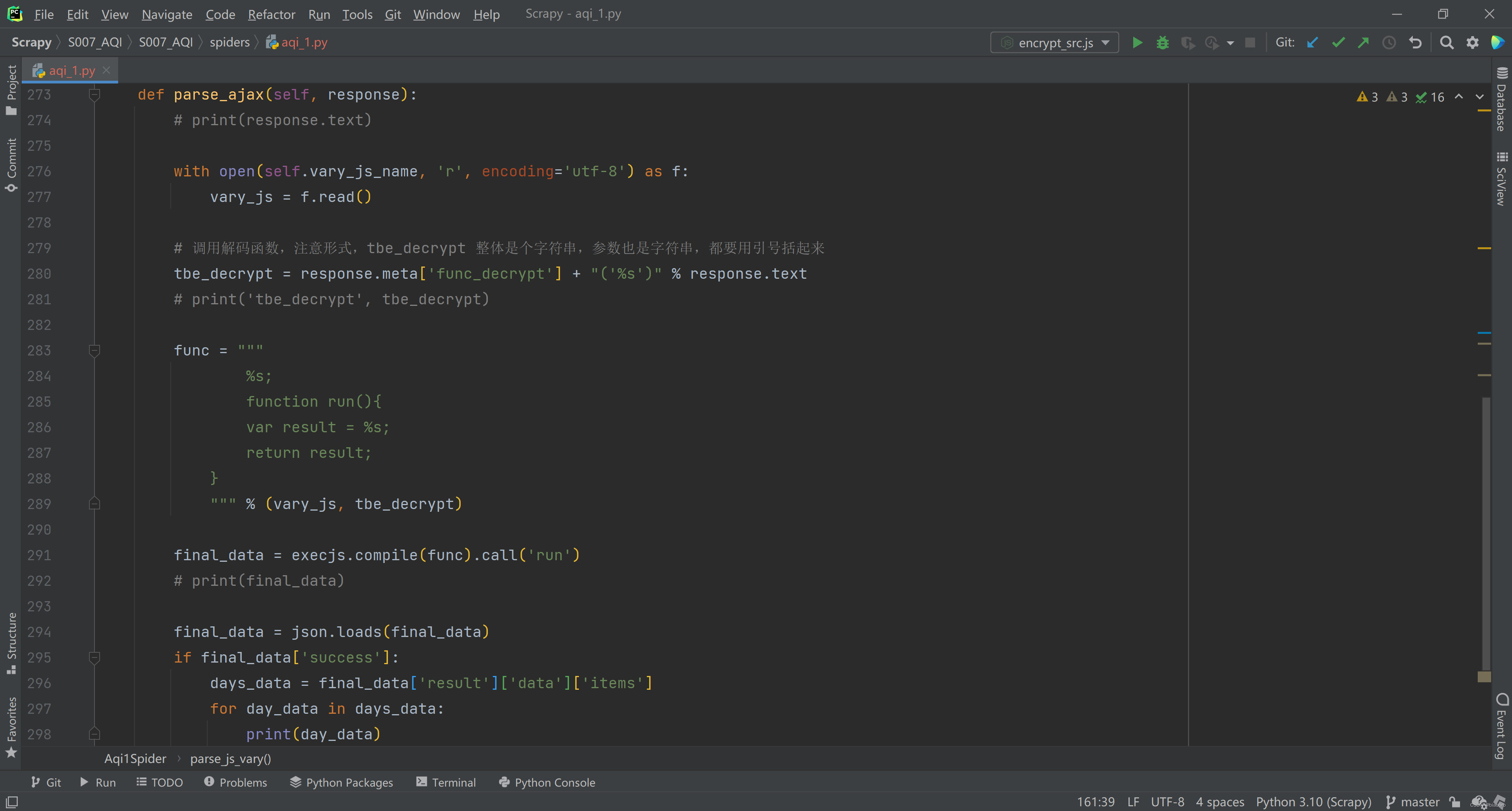

上代码

import randomimport requests

from bs4 import BeautifulSoup

import re

import os

import time

# 构造请求头

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36','Connection': 'close','Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8','Referer': 'http://www.quanshuwang.com/','Accept-Encoding': 'gzip, deflate, sdch','Accept-Language':'zh-CN,zh;q=0.9'

}# 代理列表

user_agent_list = ["Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36","Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/537.36","Mozilla/5.0 (Windows NT 10.0; …) Gecko/20100101 Firefox/61.0","Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/64.0.3282.186 Safari/537.36","Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.62 Safari/537.36","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/45.0.2454.101 Safari/537.36","Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)","Mozilla/5.0 (Macintosh; U; PPC Mac OS X 10.5; en-US; rv:1.9.2.15) Gecko/20110303 Firefox/3.6.15",]

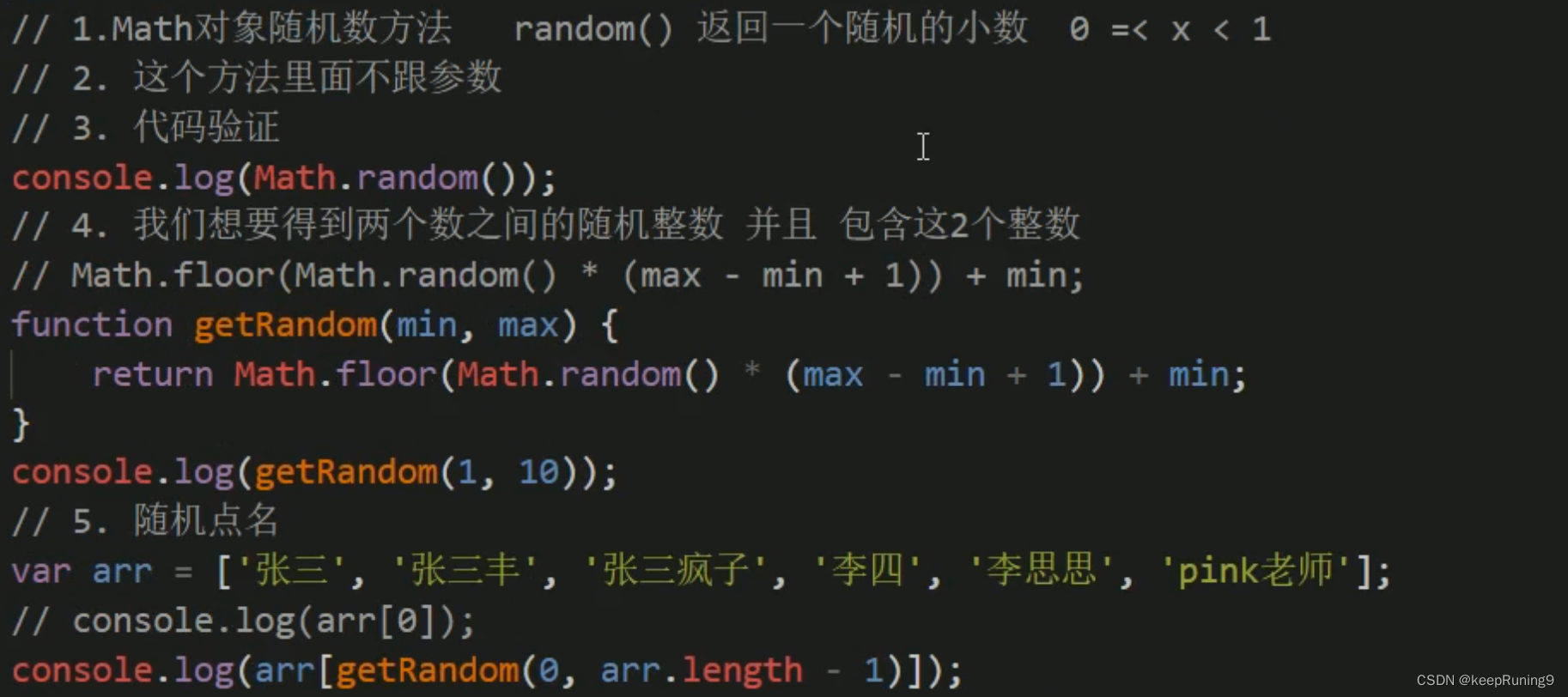

# 随机选取一个代理,总是使用同一个容易被封

headers['User-Agent'] = random.choice(user_agent_list)

# print(headers['User-Agent'])

# print(type(random.choice(user_agent_list)))def download(url):# url = 'http://www.quanshuwang.com/book/44/44683/15379610.html'res = requests.get(url,headers=headers)res.encoding ='gbk'if res.status_code != 200:print("爬取失败")html = res.textsoup = BeautifulSoup(html,'html.parser')# 获取内容content = soup.find('div',id='content')# print(content)# 获取标题title = re.findall(r'</script>.*?(.*?)<br/>',str(content))[0].strip()content = str(content).replace('<br/>','')# print(content)content = content[content.find('\n')+1:]content = content.split('<s',1)[0]content = content.replace('\n','')# 设置下载路径path = './book/'+title+'.txt'if not os.path.exists('./book'):os.mkdir('./book')# 下载到文件with open(path,'w') as f:f.write(content)f.close()# 程序入口

if __name__ =="__main__":num = int(input("请输入想要下载的章节数目:"))i = 0 # 已下载章节数j = 0 # 偏移量,一般来说加1 但存在无效链接 需要加n(n>1)while i < num:location = 15379609 + jurl = 'http://www.quanshuwang.com/book/44/44683/' + str(location) + '.html'try:download(url)except Exception as e: # 捕获异常并打印异常信息,跳过该urlprint(url+' '+str(e))j = j + 1continueprint(url+' 第'+str(i)+'章下载完成')# 后移下载下一章节i = i + 1j = j + 1time.sleep(6)print('**下载完成**')思路分析

思路分三步:

第一步 分析结构

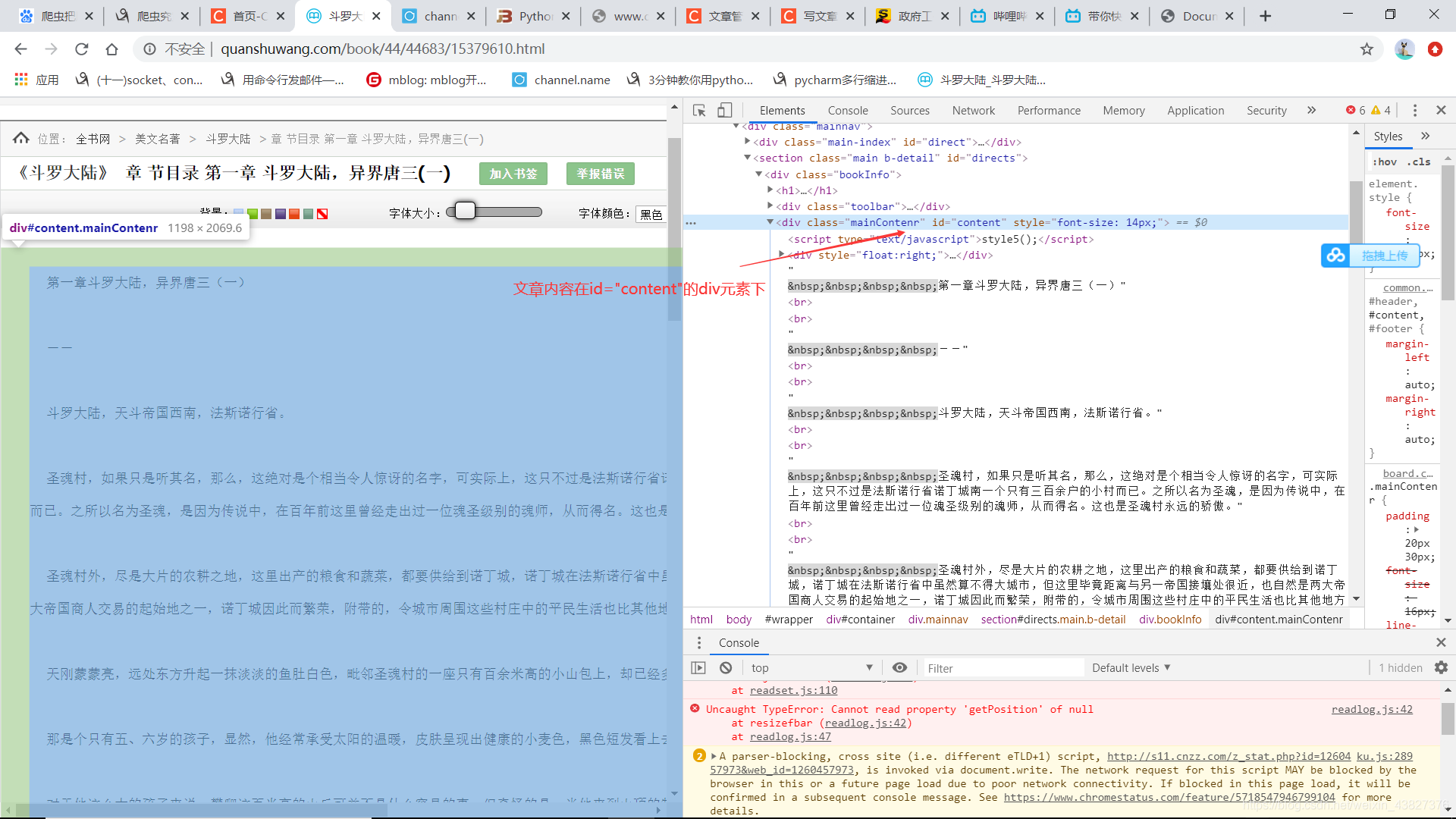

这个的结构比较简单,文字内容都在id="content"的div元素下,为了方便起见,使用bs4库,用 content = soup.find('div',id='content')这段代码便可获取文字内容,然后再对字符串进行数据清洗,去空格符,去换行符等操作。同时把文章标题提取出来作为txt文件名。

soup = BeautifulSoup(html,'html.parser')# 获取内容content = soup.find('div',id='content')# print(content)# 获取标题title = re.findall(r'</script>.*?(.*?)<br/>',str(content))[0].strip()content = str(content).replace('<br/>','')# print(content)content = content[content.find('\n')+1:]content = content.split('<s',1)[0]content = content.replace('\n','')第二步 通过观察发现章节url之间的规律

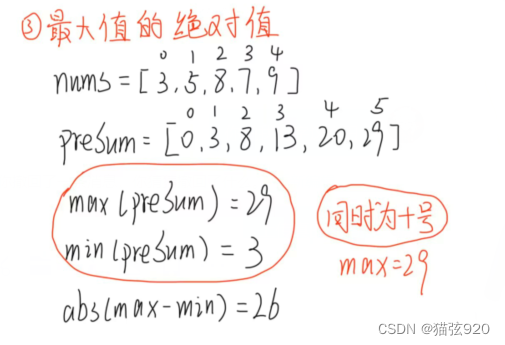

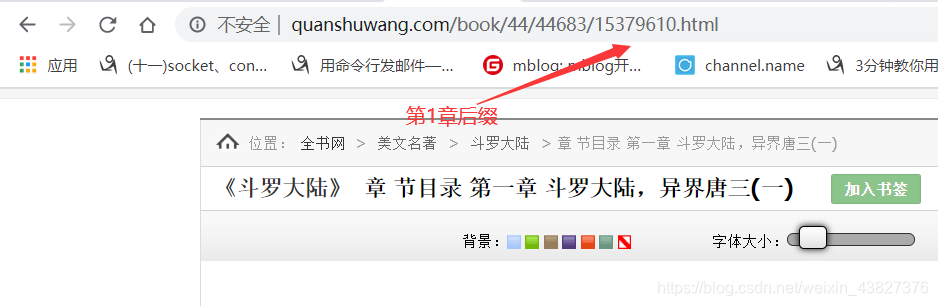

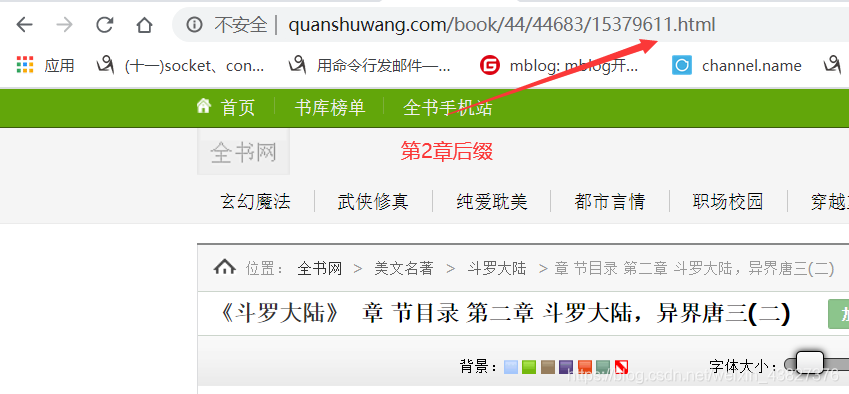

从上面可以发现相邻章节的url链接只有后缀数字不同,而且是递增1,得到第1章的后缀便可以推断出后面所有章节的url(其实后面通过大批量的下载发现有无效链接,比如55应该是第45章,但第45章是到57、58了,说明中间有空缺,但是并不影响,我们通过累加下载的有效章节数依旧可以控制总章节数)

i=0 # 已下载章节数j = 0 # 偏移量,一般来说加1 但存在无效链接 需要加n(n>1)while i < num:location = 15379609 + jurl = 'http://www.quanshuwang.com/book/44/44683/' + str(location) + '.html'try:download(url)

第三步 下载

这个相对而言就比较简单了,直接上代码吧

# 下载到本地if not os.path.exists('./book'):os.mkdir('./book')path = './book/'+title+'.txt'with open(path,'w') as f:f.write(content)f.close()

后来发现其实可以在主界面把所有章节的url提取出来放入一个列表中,然后下载这样就比较方便了

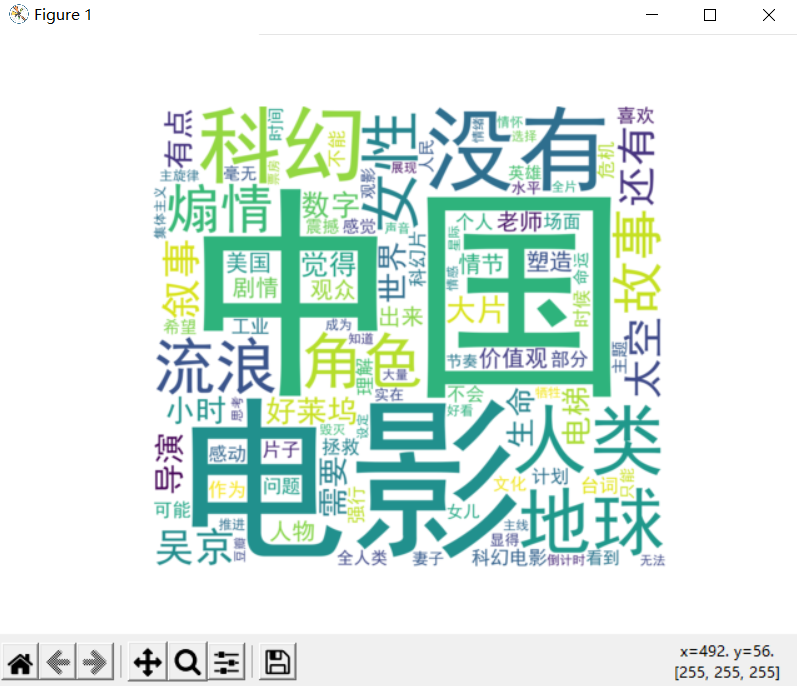

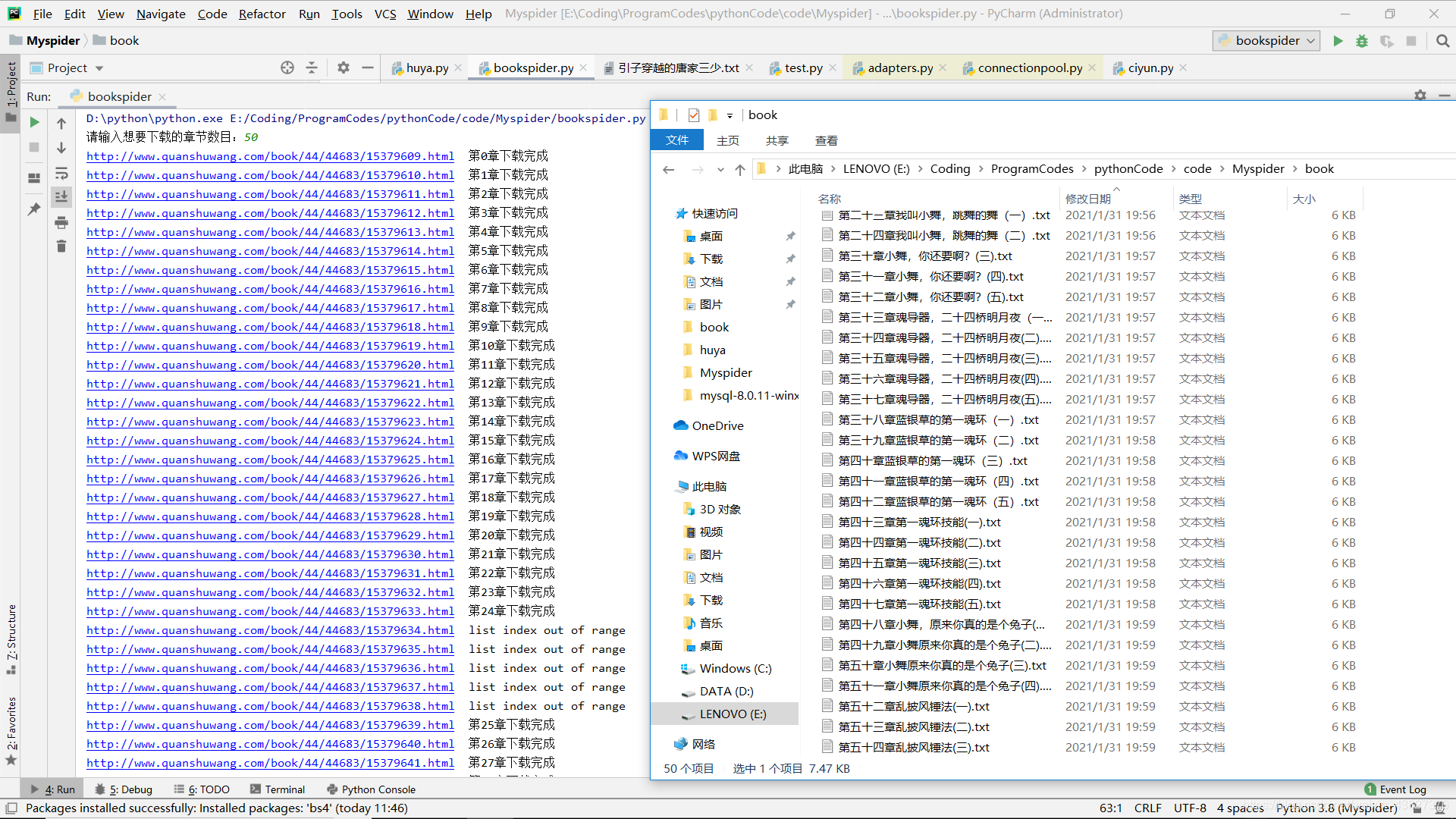

效果展示

运行效果

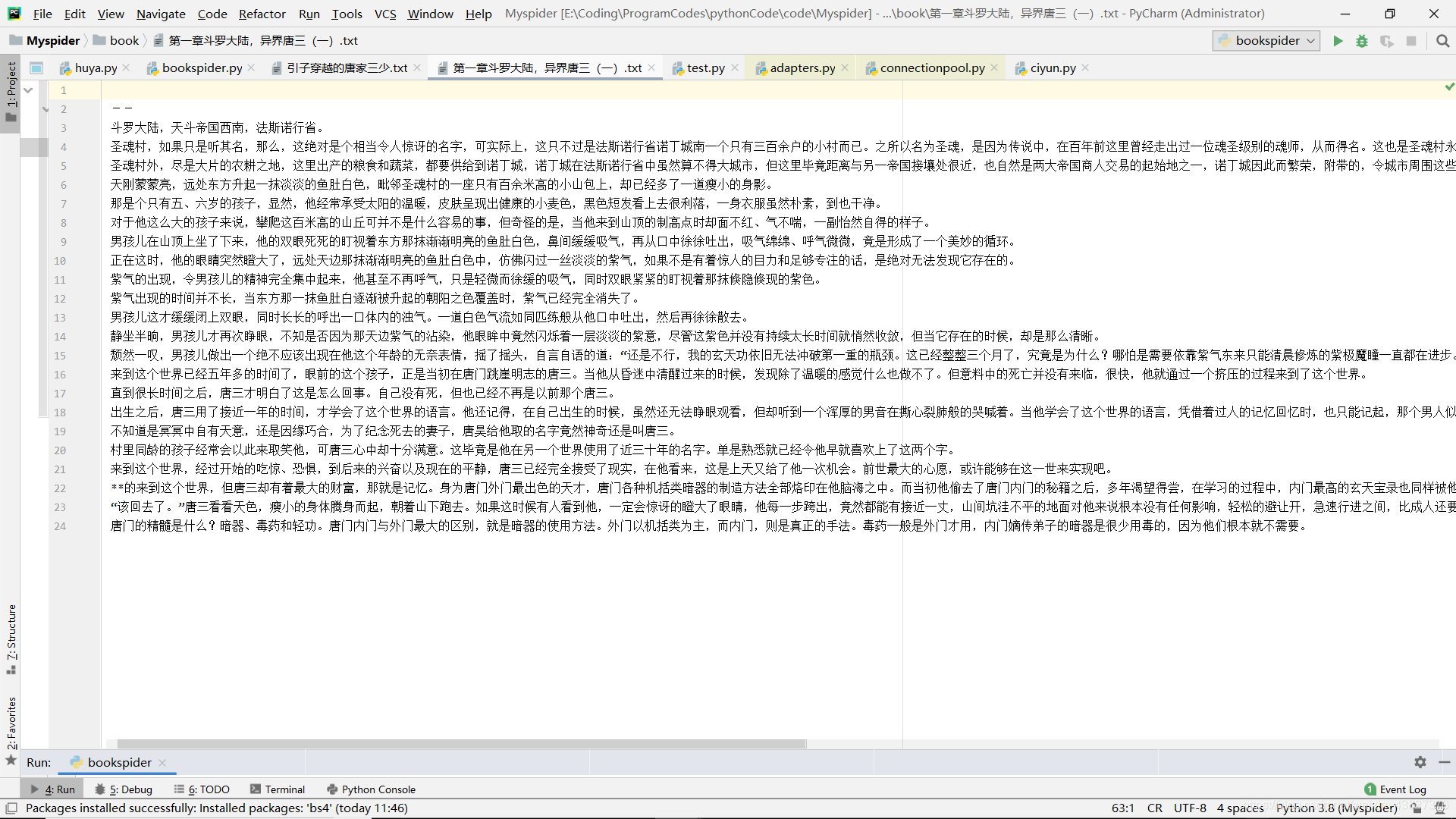

打开txt看小说咯

噔噔噔噔,终于可以爽快地看小说了

写在最后

但是下载还是有些地方需要注意,爬取速度不要太快,设置一个间隔如 time.sleep(6),不然容易爬崩别人的网站。虽然设置了,但效果不太佳还是会出现ip被封。关于出现异常报错connection absorted / requests. exceptions.ConnectionError 解决方案我是参考大佬的,附上链接 python爬虫 requests异常requests.exceptions.ConnectionError: HTTPSConnectionPool Max retries exceeded

还有可以拓展到搜索一本指定的书,这个网站也提供了搜索框,只是由于作者还不会浏览器模拟和表单提交,而且无法从url的后缀数字中发现书籍规律,只能告一段落了,之后再补上吧