本博客地址:https://security.blog.csdn.net/article/details/123573886

一、联邦学习的定义

横向联邦学习和纵向联邦学习要求所有的参与方具有相同的特征空间或样本空间,从而建立起一个有效的共享机器学习模型。然而,在更多的实际情况下,各个参与方所拥有的数据集可能存在高度的差异,例如:参与方的数据集之间可能只有少量的重叠样本和特征,并且这些数据集的规模与分布情况可能差别很大,此时横向联邦学习与纵向联邦学习就不是很适合了。

在这种情况下,通过迁移学习技术,使其可以应用于更广的业务范围,同时可以帮助只有少量数据(较少重叠的样本和特征)和弱监督(较少标记)的应用建立有效且精确的机器学习模型,并且遵守数据隐私和安全条例的规定。这种组合即称为联邦迁移学习(FTL),它可以处理超出现有横向联邦学习和纵向联邦学习能力范围的问题。

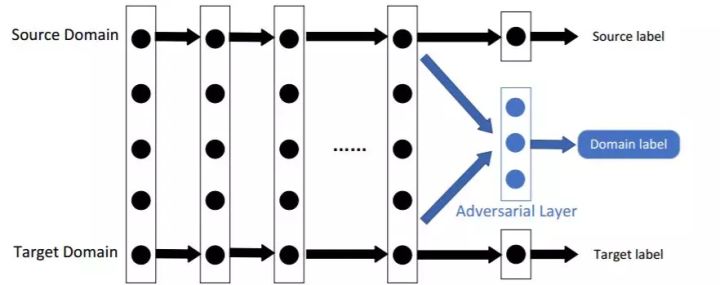

一个联邦迁移学习系统一般包括两方,称为源域和目标域。一个多方的联邦迁移学习系统可以被认为是多个两方联邦迁移学习系统的结合。

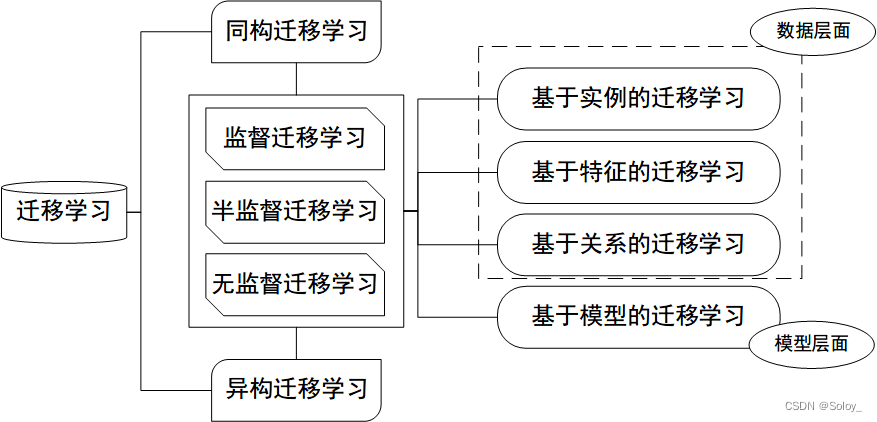

二、联邦迁移学习的分类

基于实例的联邦迁移学习

对于横向联邦学习,参与方的数据通常来自不同的分布,这可能会导致在这些数据上训练的机器学习模型的性能较差。参与方可以有选择地挑选或者加权训练样本,以减小分布差异,从而可以将目标损失函数最小化。对于纵向联邦学习,参与方可能具有非常不同的业务目标。因此,对齐的样本及其某些特征可能对联邦迁移学习产生负面影响,这被称为负迁移。在这种情况下,参与方可以有选择地挑选用于训练的特征和样本,以避免产生负迁移。

基于特征的联邦迁移学习

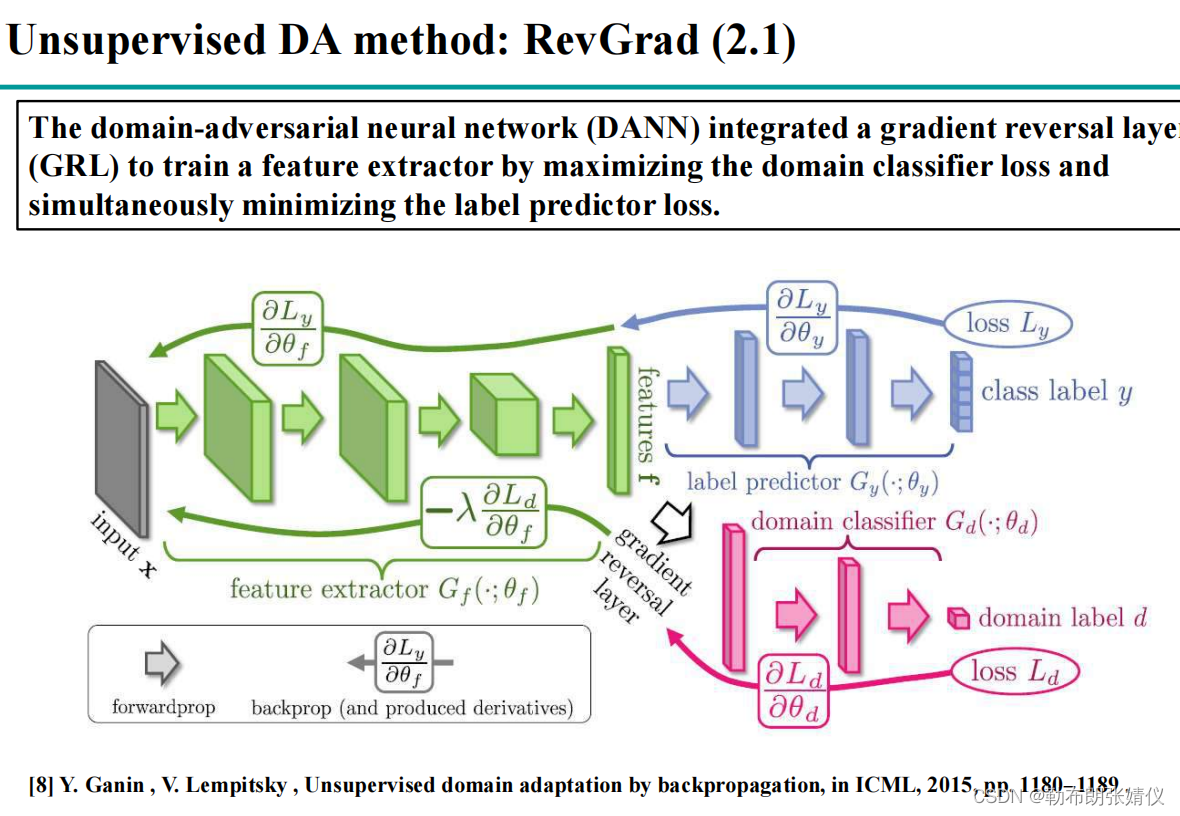

参与方协同学习一个共同的表征空间。在该空间中,可以缓解从原始数据转换而来的表征之间的分布和语义差异,从而使知识可以在不同领域之间传递。对于横向联邦学习,可以通过最小化参与方样本之间的最大平均差异来学习共同的表征空间。对于纵向联邦学习,可以通过最小化对齐样本中属于不同参与方的表征之间的距离,来学习共同的表征空间。

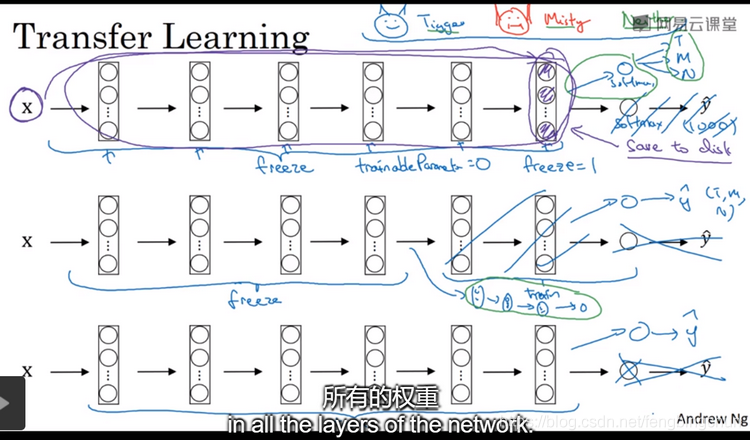

基于模型的联邦迁移学习

参与方协同学习可以用于迁移学习的共享模型,或者参与方利用预训练模型作为联邦学习任务的全部或者部分初始模型。横向联邦学习本身就是一种基于模型的联邦迁移学习,因为在每个通信回合中,各参与方会协同训练一个全局模型,并且各参与方把该全局模型作为初始模型进行微调。对于纵向联邦学习,可以从对齐的样本中学习预测模型或者利用半监督学习技术,以推断缺失的特征和标签,然后,可以使用扩大的训练样本训练更准确的共享模型。

三、联邦迁移学习算法

3.1、联邦迁移学习的训练过程

种联邦迁移学习算法训练过程包含以下几个步骤:

● 步骤一:

A方:在本地运行神经网络 ,以获得数据的隐藏表征

;

B方:在本地运行神经网络 ,以获得数据的隐藏表征

;

● 步骤二:

A方:计算和加密一组中间结果,设为 ,并将其发送给B方,以帮助计算梯度

;

B方:计算和加密一组中间结果,设为 和

,并发送给A方,以帮助计算梯度

和损失L;

● 步骤三:

A方:基于收到的 和

,通过式

和

计算得到

和

,之后A方创建随机掩码

并将其添加至

以得到

,A方向B方发送

和

;

B方:基于收到的 ,通过

计算得到

。之后,B方创建随机掩码

并将其添加至

以得到

,B方向A方发送

。

● 步骤四:

A方:解密得到 ,并将其发送给B方;

B方:解密得到 和L,并将它们发回给A方。

● 步骤五:

A方:去掉随机掩码并获得梯度 ,之后,使用自己的梯度来更新自己的模型;

B方:去掉随机掩码并获得梯度 ,之后,使用自己的梯度来更新自己的模型。

● 步骤六:

一旦损失L收敛,A方向B方发送终止信号,否则就前往步骤一以继续训练过程。

3.2、联邦迁移学习的预测过程

一旦联邦迁移学习模型训练完毕,它便能用于预测B方中的未标注数据。对于未标注数据样本的预测过程,步骤如下:

● 步骤一:

B方用已训练好的神经网络参数 计算

,并给A方发送加密过的

。

● 步骤二:

A方评估 并用随机值对结果进行掩藏,并将加密和掩藏过的

发送给B方。

● 步骤三:

B方解密 并将

发送给A方。

● 步骤四:

A方获得 ,进而得到标签

,并将标签

发送给B方。

四、基于秘密共享的联邦迁移学习

4.1、基于秘密共享的联邦迁移学习的训练过程

对于基于秘密共享的联邦迁移学习的训练过程,步骤如下:

● 步骤一:

A方和B方在本地运行各自的神经网络 和

,以获得数据的隐藏表征

和

。

● 步骤二:

A方和B方通过秘密共享协议共同地计算 。A方计算

并发送给B方,B方计算

并发送给A方。

● 步骤三:

A方和B方通过式 分别重构损失L。

● 步骤四:

A方和B方通过秘密共享协议共同地计算 和

。

● 步骤五:

A方通过 计算梯度,并更新它的本地模型

。同时,B方通过

计算梯度,并更新它的本地模型

。

● 步骤六:

一旦损失L收敛,A方给B方发送终止信号。否则,前往步骤一以继续训练过程。

4.2、基于秘密共享的联邦迁移学习的预测过程

在训练结束之后,就可以进入预测阶段,预测过程主要包括两个步骤。

● 步骤一:

A方和B方在本地运行已训练完毕的神经网络 和

,以获得数据隐藏表征

和

。

● 步骤二:

基于 和

,A方和B方共同地通过秘密共享协议重建

以及计算标签

。