在本章中,我们将学习如何开始使用自然语言工具包(软件包)。

前提条件

如果想用自然语言处理来构建应用程序,那么上下文中的变化就会使其变得非常困难。 语境因素影响机器如何理解特定句子。 因此,我们需要通过使用机器学习方法来开发自然语言应用程序,以便机器也能够理解人类可以理解上下文的方式。

要构建这样的应用程序,我们将使用名为NLTK(自然语言工具包包)的Python包。

导入NLTK

在使用之前需要安装NLTK,它可以在以下命令来安装 -

pip install nltk

要为NLTK构建conda包,请使用以下命令 -

conda install -c anaconda nltk

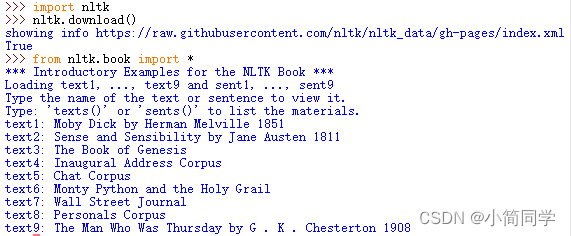

现在安装NLTK包后,需要通过python命令提示符导入。通过在Python命令提示符下编写以下命令来导入它 -

>>> import nltk

下载NLTK的数据

现在导入NLTK后,我们还需要下载所需的数据。 它可以在Python命令提示符下通过以下命令完成 -

>>> nltk.download()

安装其他必需的软件包

为了使用NLTK构建自然语言处理应用程序,需要安装必要的软件包。如下 -

gensim

它是一个强大的语义建模库,对许多应用程序很有用。可以通过执行以下命令来安装它 -

pip install gensim

pattern

它用于使gensim包正常工作。可以通过执行以下命令来安装它 -

pip install pattern

标记化,词干化和词形化的概念

在本节中,我们将了解什么是标记化,词干化和词形化。

1. 标记化

它可以被定义为将给定文本即字符序列分成称为令牌的较小单元的过程。令牌可以是单词,数字或标点符号。 它也被称为分词。 以下是标记化的一个简单示例 -

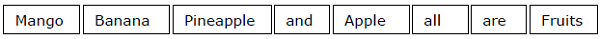

输入 - 芒果,香蕉,菠萝和苹果都是水果。

输出 -

打断给定文本的过程可以通过查找单词边界来完成。 单词的结尾和新单词的开头称为单词边界。 文字的书写体系和印刷结构会影响边界。

在Python NLTK模块中,有与标记化有关的不同包,可以根据需要将文本划分为标记。 一些软件包如下所示 -

sent_tokenize包

顾名思义,这个软件包会将输入文本分成几个句子。 可以使用下面的Python代码导入这个包 -

from nltk.tokenize import sent_tokenize

word_tokenize包

这个包将输入文本分成单词。可以使用下面的Python代码来导入这个包 -

from nltk.tokenize import word_tokenize

WordPuncttokenizer包

这个包将输入文本分成单词和标点符号。可以使用下面的Python代码来导入这个包 -

from nltk.tokenize import WordPuncttokenizer

2. 词干

在处理文字时,由于语法原因,我们遇到了很多变化。 这里的变化的概念意味着必须处理像:democracy, democratic 和 democratization 等不同形式的相同词汇。机器非常需要理解这些不同的单词具有相同的基本形式。 通过这种方式,在分析文本的同时提取单词的基本形式将会很有用。

我们可以通过阻止来实现这一点。 通过这种方式,可以说干扰是通过切断单词的结尾来提取单词基本形式的启发式过程。

在Python NLTK模块中,有一些与stemming相关的其它包。 这些包可以用来获取单词的基本形式。 这些软件包使用算法。 一些软件包如下所示 -

PorterStemmer包

这个Python包使用Porter算法来提取基础表单。可以使用下面的Python代码来这个包 -

from nltk.stem.porter import PorterStemmer

例如,如果将writing这个词作为这个词干的输入,它们就会在词干之后得到write这个词。

LancasterStemmer包

这个Python包将使用Lancaster的算法来提取基本形式。 可以使用下面的Python代码来导入这个包 -

from nltk.stem.lancaster import LancasterStemmer

例如,如果将writing这个词作为这个词干的输入,它们就会在词干之后得到write这个词。

SnowballStemmer包

这个Python包将使用雪球算法来提取基本形式。 可以使用下面的Python代码来导入这个包 -

from nltk.stem.snowball import SnowballStemmer

例如,如果将writing这个词作为这个词干的输入