1.前言

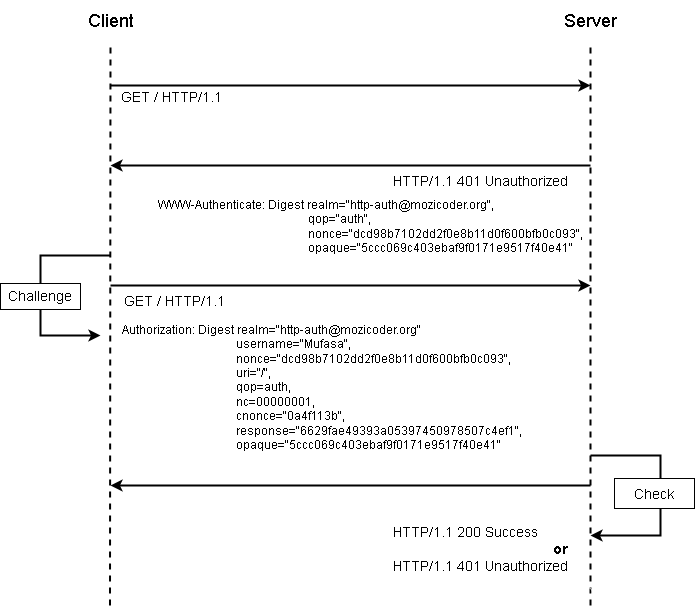

mysql慢查询,已经有现成的成熟的方案收集展示了:pt-query-digest结合box公司的anemometer,没用过的移步:《mysql慢查询可视化》(本章内容需要提前了解anemometer)。

但DBA们一定还遇到过这样的问题:某个时间段CPU负载较高,但慢查却没有。这种情况一般是由高并发的但单个性能正常的SQL导致的,所以慢查没有,但总体负载会升高。

那怎么办呢?

选择1:配置events_statements_history_long,缺点明显:数据很容易被覆盖,查看不便。

选择2:之前本人参考oracle原生的一个功能,每10s自动抓一次活动会话,记录到表中,但有个明显的缺点:从库event_scheduler都是不开的,导致从库没法做。

针对该痛点,本人设计了一个定时收集events_statements_summary_by_digest,并通过amemometer展示的方案。

2.功能展示

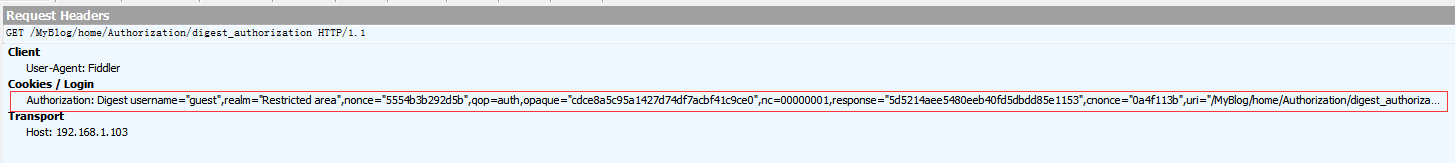

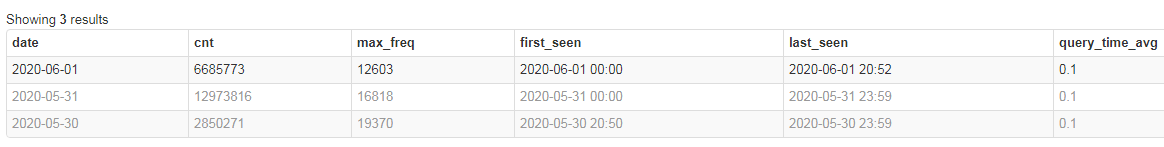

选择时间段、host(沿用的慢查中的名称,理解为mysql实例):

展示每个digest的总次数、最高执行频率(按分钟)、平均耗时(毫秒)

点击checksum,查看某个SQL执行频率的走势图,展示每分钟执行的次数

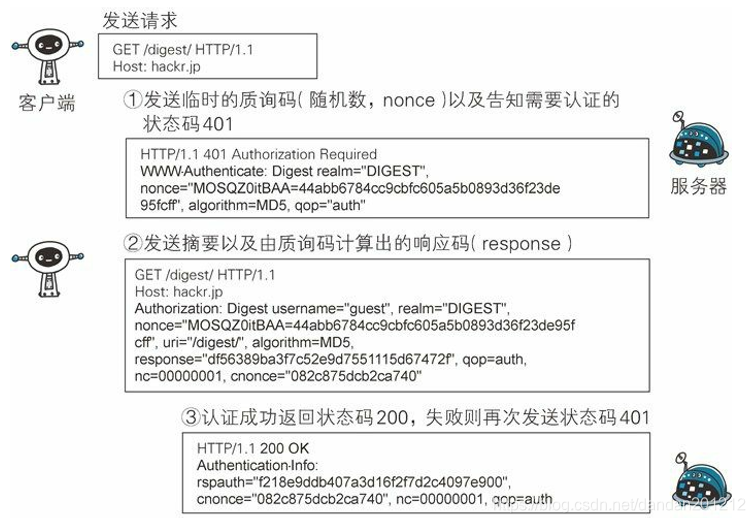

按天聚合:

如果想查看执行频率波动有异常,可以在having中添加条件:

最高频率是平均频率的3倍:max(ts_cnt) > (sum(ts_cnt)/count(*)) * 3

3.实现逻辑

3.1.数据来源

events_statements_summary_by_digest

默认performance_schema_digests_size=10000,SQL digest较多的库要调整到20000以上;

参数不能动态调整,没有停机时间的实例可以监控记录数,满了truncate即可。

3.2.表结构

global_query_review、global_query_review_history直接沿用慢查的表结构,字段不变;

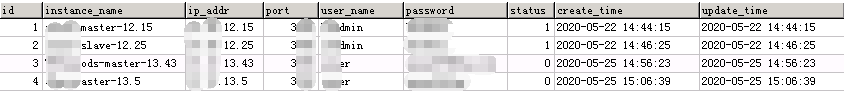

db_instance实:例配置表,记录实例的信息,python自动定时扫描该表。

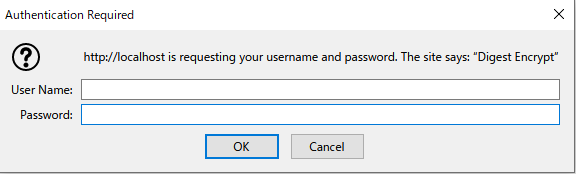

3.3.python程序

python程序由两个JOB构成:

job1:check_db_pool:定时扫描db_instance表,更新连接池

job2:handle_db_all: 定时处理所有实例的数据入库

job1

目标库连接池存放在字典:db_pool_dic

获取实例ip\端口等信息,包括ischanged(最近1分钟实例信息是否改变):get_instance()

按顺序处理一下逻辑:

- 在db_pool_dic中,但不在get_instance()中的,从db_pool_dic中删除

- 检查db_pool_dic连接池的有效性(select 1),无效则删除

- 在get_instance()中,ischanged="changed",且在db_pool_dic中的,从db_pool_dic中删除

- 在get_instance()中,但不在db_pool_dic中,创建连接池,增加到db_pool_dic

job2

遍历get_instance(),以线程方式处理每个目标库:handle_db

handle_db主要任务是获取最近1分钟内每个digest执行次数的增量,入库

增量是通过连续2次获取的digest执行次数相减得到

按顺序执行以下过程:

- 从redis中获取上次set的digest信息:df_full_last_bytes=rs.get(redis_key_name)

- 查询digest中LAST_SEEN>now()-1mins的数据:df_1min

- 查询digest全量信息:df_full

- 如果df_full_last_bytes为空:return

- df_full_last_bytes与df_1min关联,计算增量

- redis set df_full_last_bytes,有效期90秒

补充2个SQL

df_full:

select concat('instance_name','-',digest,'-',ifnull(schema_name,'unknow')) checksum ,sum(count_star) count_star

from events_statements_summary_by_digest where digest is not NULL

group by checksumdf_1min:

select concat('instance_name ','-',digest,'-',ifnull(schema_name,'unknow')) checksum,ifnull(schema_name,'unknow') as db_max,

count_star,digest_text,round(avg_timer_wait/1000000000,1) query_time_avg

from events_statements_summary_by_digest

where LAST_SEEN > DATE_SUB(now(),INTERVAL 1 minute)

and digest is not NULL4. 表结构

创建管理库:digest_stat

4.1. db_instance

instance_name:自定义的实例名,唯一约束;

update_time数据变更后自动更新,python程序根据该字段更新连接池配置信息;

status:目标库是否激活,启用。

CREATE TABLE `db_instance` (`id` int(11) NOT NULL AUTO_INCREMENT,`instance_name` varchar(50) COLLATE utf8mb4_bin NOT NULL,`ip_addr` varchar(15) COLLATE utf8mb4_bin NOT NULL,`port` int(11) NOT NULL,`user_name` varchar(50) COLLATE utf8mb4_bin NOT NULL,`password` varchar(50) COLLATE utf8mb4_bin NOT NULL,`status` int(1) NOT NULL DEFAULT '0' COMMENT '0:active, 1:inactive',`create_time` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP,`update_time` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP,PRIMARY KEY (`id`),UNIQUE KEY `idxu_instancename` (`instance_name`),UNIQUE KEY `idx_ip_port` (`ip_addr`,`port`)

) ENGINE=InnoDB4.2. global_query_review

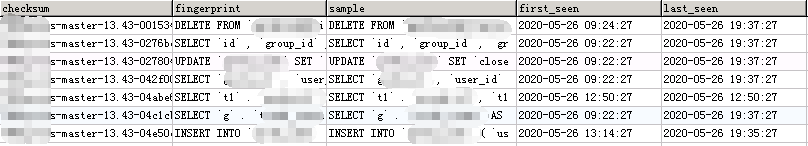

CREATE TABLE `global_query_review` (`checksum` varchar(200) NOT NULL,`fingerprint` text NOT NULL,`sample` longtext,`first_seen` datetime DEFAULT NULL,`last_seen` datetime DEFAULT NULL,`reviewed_by` varchar(20) DEFAULT NULL,`reviewed_on` datetime DEFAULT NULL,`comments` text,`reviewed_status` varchar(24) DEFAULT NULL,PRIMARY KEY (`checksum`)

) ENGINE=InnoDB4.3.global_query_review_history

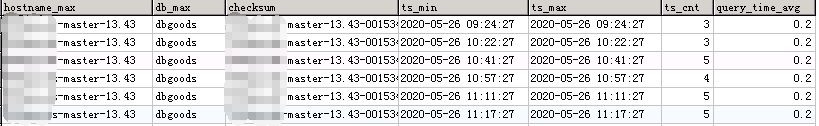

CREATE TABLE `global_query_review_history` (`hostname_max` varchar(64) NOT NULL,`db_max` varchar(64) DEFAULT NULL,`checksum` varchar(200) NOT NULL,`sample` longtext,`ts_min` datetime NOT NULL DEFAULT '0000-00-00 00:00:00',`ts_max` datetime NOT NULL DEFAULT '0000-00-00 00:00:00',`ts_cnt` float DEFAULT NULL,`query_time_avg` float DEFAULT NULL,UNIQUE KEY `hostname_max` (`hostname_max`,`checksum`,`ts_min`,`ts_max`),KEY `ts_min` (`ts_min`),KEY `checksum` (`checksum`)

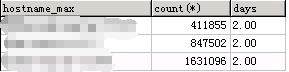

) ENGINE=InnoDB该表记录数会很多,我司的3个库,保留了2天数据,记录数分别为41w,84w,163w

因此:

1,一定要对该表自动清理,一般不要超过7天;

2、可以调整python数据抽取策略,如每分钟超过30次的才收集,平均耗时大于1毫秒的才收集,等等

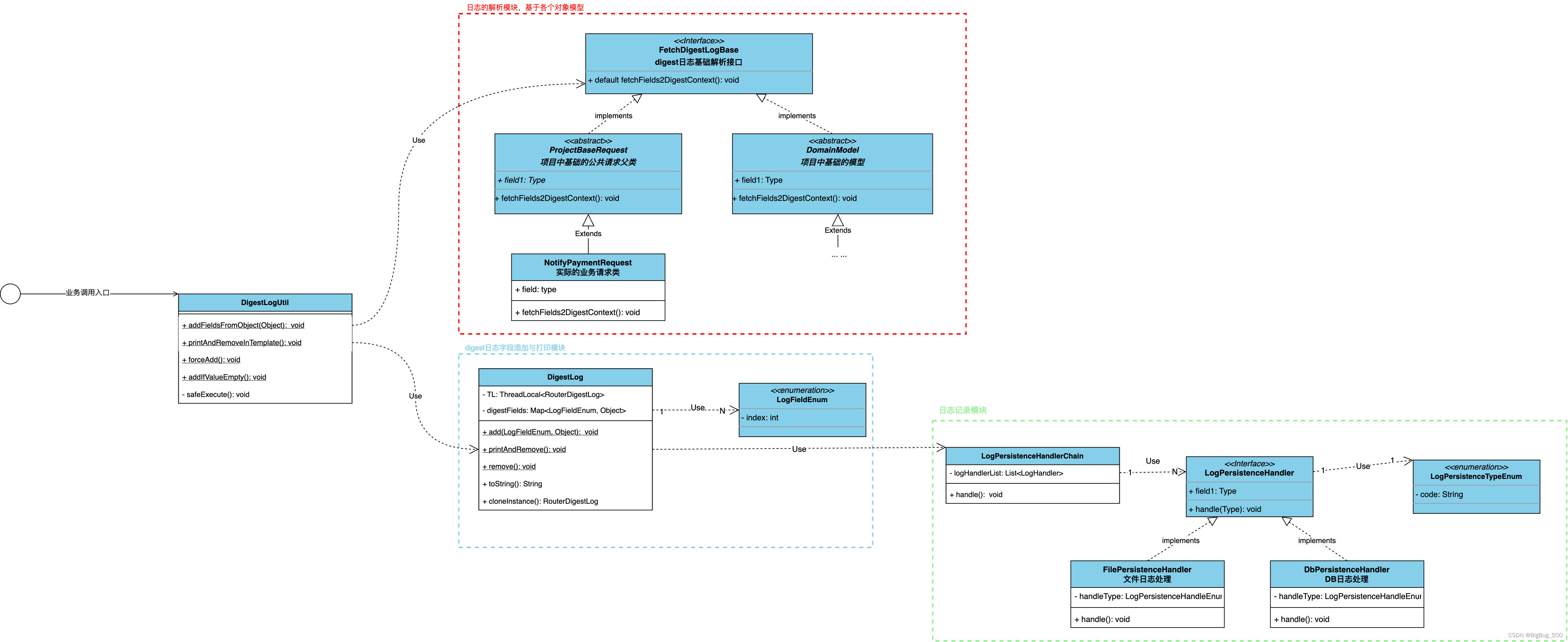

5. Anemometer程序调整

在慢查调整过的基础上,再做以下调整:

1. conf/datasource_slowlog.inc.php

修改数据库信息

2. conf/config.inc.php

$conf['history_defaults'] = array(

'table_fields' => array('date', 'cnt','max_freq','first_seen','last_seen','query_time_avg')$conf['report_defaults'] = array('fact-order' => 'cnt DESC','table_fields' => array('checksum','hostname','db','sql_short','cnt','max_freq','first_seen','last_seen','query_time_avg'),'dimension-hostname_max' => '一个默认的实例名称' ## 指定实例默认值,否则默认查所有数据,响应慢'custom_fields' => array('checksum' => 'checksum','hostname' => 'hostname_max','db' => 'db_max','sql_short' => 'LEFT(fact.sample,30)','cnt' => 'sum(ts_cnt)','max_freq' => 'max(ts_cnt)','query_time_avg' => 'ROUND(avg(query_time_avg),1)','first_seen' => 'substring(min(ts_min),1,16)','last_seen' => 'substring(max(ts_max),1,16)','date' => 'substring(ts_min,1,10)','minute_ts' => 'round(unix_timestamp(substring(ts_min,1,16)))'),3. lib/Anemometer.php

private function translate_checksum($checksum){{//throw new Exception("Invalid query checksum");return $checksum;}}最后,具体python程序见:https://github.com/meishd/mysql_allsql_digest/