1. Normal Neural Network:

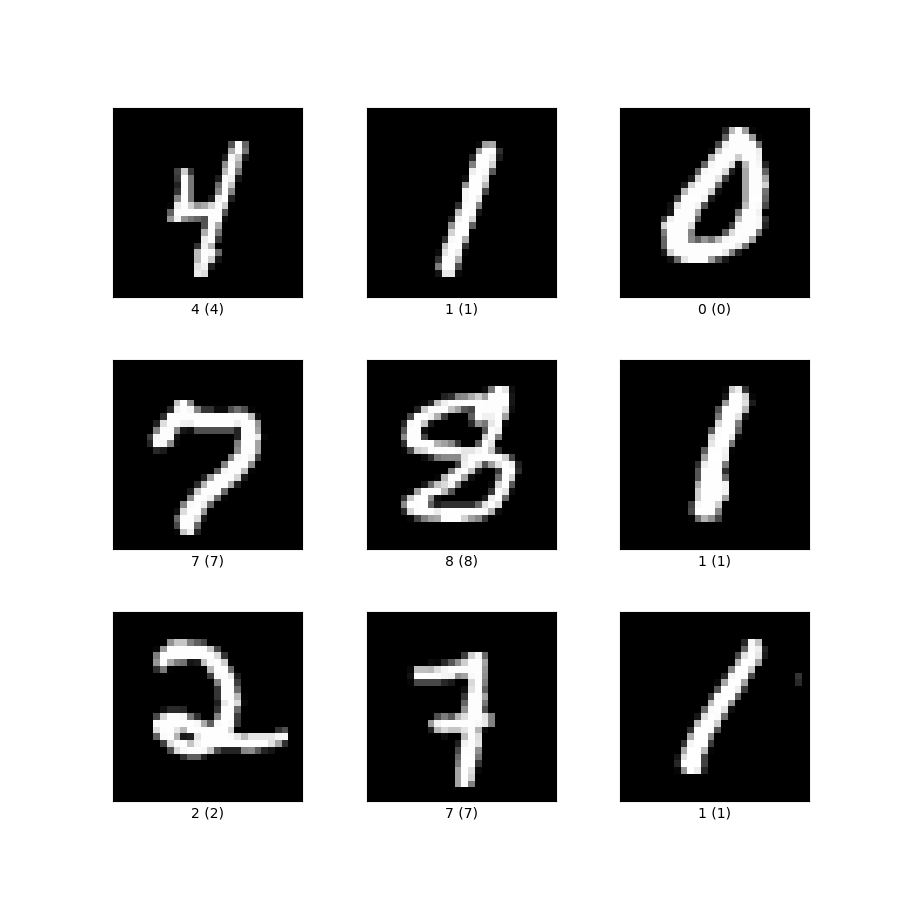

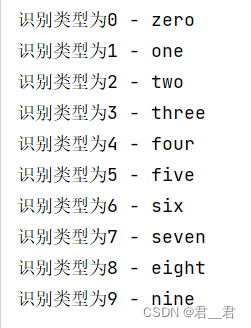

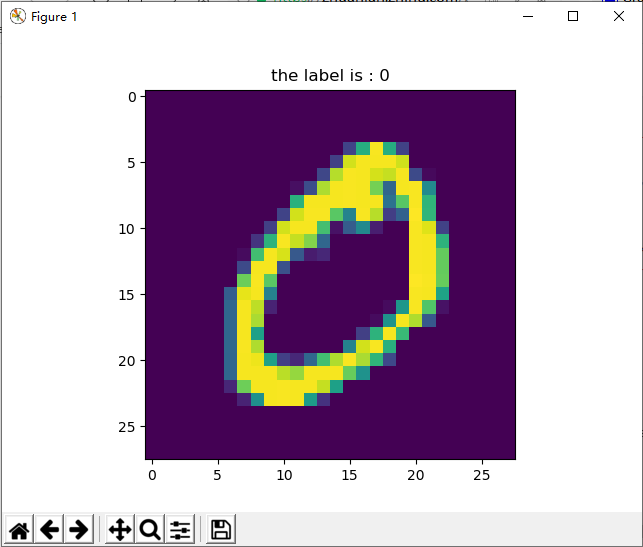

首先我用的是两层(input layer 和 output layer)的feed-forward的神经网络结构来训练数据, y = wx + b, 在输出层用的是softmax求概率,算loss用的是交叉熵的办法,选用梯度下降法来最小化loss更新参数w和b,通过对比output和input对应的label,计算出准确率,因为此网络结构较简单,只能达到91%的accuracy。

代码实现:

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

mnist = input_data.read_data_sets('MNIST_data', one_hot=True)sess = tf.InteractiveSession()# input x 和 label y_

x = tf.placeholder("float", shape=[None, 784])

y_ = tf.placeholder("float", shape=[None, 10])# 初始化权值和偏置

W = tf.Variable(tf.zeros([784, 10]))

b = tf.Variable(tf.zeros([10]))# 初始化所有的变量

sess.run(tf.initialize_all_variables())# 求输出,用softmax:y = Wx + b

y = tf.nn.softmax(tf.matmul(x, W) + b)# 交叉熵作为cost function

cross_entropy = -tf.reduce_sum(y_ * tf.log(y))# 用梯度下降法最小化交叉熵来更新参数

optimizer = tf.train.GradientDescentOptimizer(0.01).minimize(cross_entropy)# 进行训练过程

for i in range(1000):batch = mnist.train.next_batch(100)optimizer.run(feed_dict={x: batch[0], y_: batch[1]}) # 引入x和y_的值# 判断y和y_是否equal

correct_prediction = tf.equal(tf.argmax(y, 1), tf.argmax(y_, 1))# 把判断y和y_的布尔值转化为数值

accuracy = tf.reduce_mean(tf.cast(correct_prediction, "float"))# 输出test数据集的accuracy

print(accuracy.eval(feed_dict={x: mnist.train.images, y_: mnist.train.labels}))

print(accuracy.eval(feed_dict={x: mnist.test.images, y_: mnist.test.labels}))2. CNN

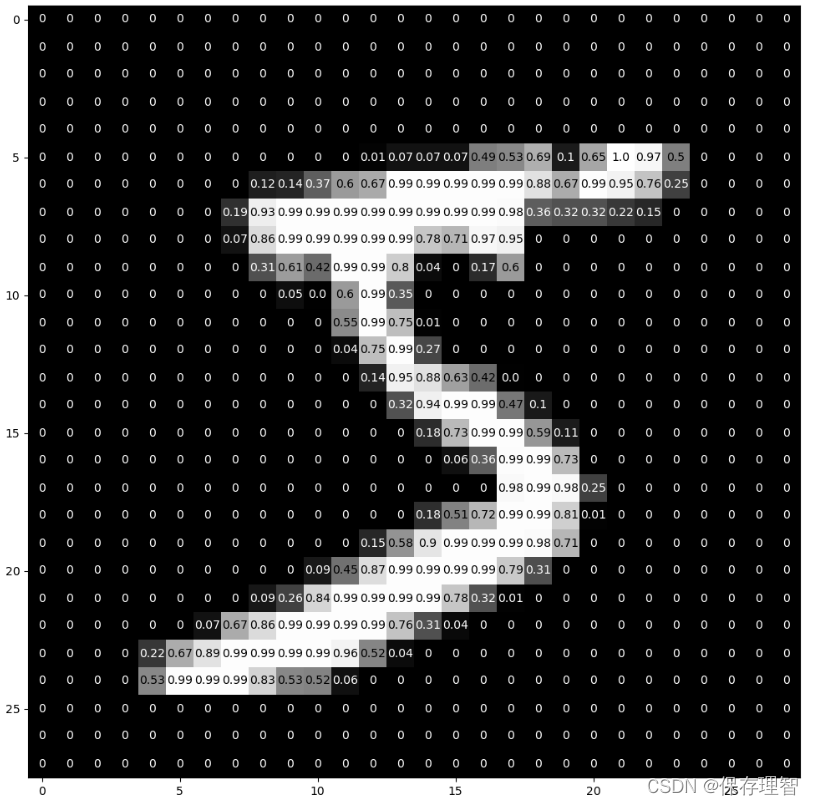

用卷积神经网络结构进行了手写数字识别,主要用到的方法有:conv, max_pooling, ReLU, dropout, softmax. 计算loss用的是交叉熵,用Adam来最小化loss更新参数,准确率可以达到99.27%

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

mnist = input_data.read_data_sets('MNIST_data', one_hot=True)sess = tf.InteractiveSession()x = tf.placeholder("float", shape=[None, 784])

y_ = tf.placeholder("float", shape=[None, 10])# 权重和偏差初始化

def weight_variable(shape):initial = tf.truncated_normal(shape, stddev=0.1)return tf.Variable(initial)def bias_variable(shape):initial = tf.constant(0.1, shape=shape)return tf.Variable(initial)# 建立卷积和池化的函数

def conv2d(x, W):return tf.nn.conv2d(x, W, strides=[1, 1, 1, 1], padding='SAME')def max_pool_2x2(x):return tf.nn.max_pool(x, ksize=[1, 2, 2, 1],strides=[1, 2, 2, 1], padding='SAME')# 第一层卷积

W_conv1 = weight_variable([5, 5, 1, 32]) # 32 个 5x5 的filter

b_conv1 = bias_variable([32])

x_image = tf.reshape(x, [-1, 28, 28, 1])

h_conv1 = tf.nn.relu(conv2d(x_image, W_conv1) + b_conv1)

h_pool1 = max_pool_2x2(h_conv1)# 第二层卷积

W_conv2 = weight_variable([5, 5, 32, 64]) # 64个5x5x32的filter

b_conv2 = bias_variable([64])

h_conv2 = tf.nn.relu(conv2d(h_pool1, W_conv2) + b_conv2)

h_pool2 = max_pool_2x2(h_conv2)# fully connected layer

W_fc1 = weight_variable([7 * 7 * 64, 1024])

b_fc1 = bias_variable([1024])

h_pool2_flat = tf.reshape(h_pool2, [-1, 7 * 7 * 64])

h_fc1 = tf.nn.relu(tf.matmul(h_pool2_flat, W_fc1) + b_fc1)# dropout:keep_prob:概率;在训练过程中使用dropout,在测试过程中不用dropout

keep_prob = tf.placeholder("float")

h_fc1_drop = tf.nn.dropout(h_fc1, keep_prob)# output layer:softmax

W_fc2 = weight_variable([1024, 10])

b_fc2 = bias_variable([10])y_conv = tf.nn.softmax(tf.matmul(h_fc1_drop, W_fc2) + b_fc2)# 训练和评估模型

cross_entropy = -tf.reduce_sum(y_ * tf.log(y_conv))

train_step = tf.train.AdamOptimizer(1e-4).minimize(cross_entropy)

correct_prediction = tf.equal(tf.argmax(y_conv, 1), tf.argmax(y_, 1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, "float"))

sess.run(tf.initialize_all_variables())

for i in range(20000):batch = mnist.train.next_batch(50)if i % 100 == 0:train_accuracy = accuracy.eval(feed_dict={x: batch[0], y_: batch[1], keep_prob: 1.0})print("step %d, training accuracy %g" % (i, train_accuracy))train_step.run(feed_dict={x: batch[0], y_: batch[1], keep_prob: 0.5})print("test accuracy %g" % accuracy.eval(feed_dict={x: mnist.test.images, y_: mnist.test.labels, keep_prob: 1.0}))

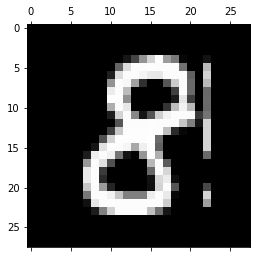

![[转]MNIST机器学习入门](http://wiki.jikexueyuan.com/project/tensorflow-zh/images/mnist9.png)