文章目录

- 1、无参数,无返回值的函数

- 2、无参数,有返回值的函数

- 3、有参数,无返回值的函数

- 4、有参数,有返回值的函数

- 5、小结

函数根据有没有参数,有没有返回值,可以相互组合,一共有4种

- 无参数,无返回值

- 无参数,有返回值

- 有参数,无返回值

- 有参数,有返回值

1、无参数,无返回值的函数

此类函数,不能接收参数,也没有返回值,一般情况下,打印提示等类似的功能,使用这类的函数。

2、无参数,有返回值的函数

此类函数,不能接收参数,但是可以返回某个数据,一般情况下,像采集数据,用此类函数。

3、有参数,无返回值的函数

此类函数,能接收参数,但不可以返回数据,一般情况下,对某些变量设置数据而不需结果时,用此类函数。

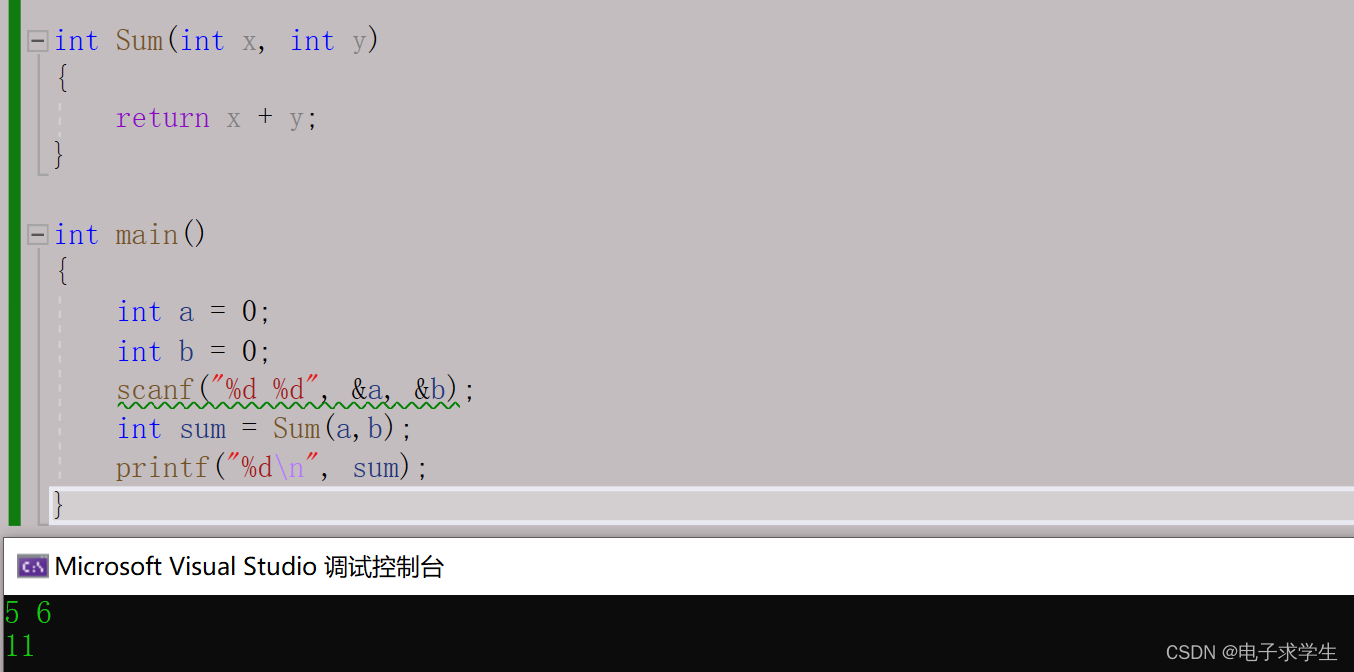

4、有参数,有返回值的函数

此类函数,不仅能接收参数,还可以返回某个数据,一般情况下,像数据处理并需要结果的应用,用此类函数。

5、小结

函数根据有没有参数,有没有返回值可以相互组合

定义函数时,是根据实际的功能需求来设计的,所以不同开发人员编写的函数类型各不相同。