目录

- 一、爬取南阳理工学院ACM题目

- 1、新建.py文件

- 2、爬取结果

- 3、代码分析

- (1)调用

- (2)定义表头

- (3)爬取信息并显示进度条

- (4)把爬取内容存放文件NYOJ_Subjects.csv中

- 二、爬取重庆交通大学新闻网站

- 1、确定爬取信息的位置

- (1)进入网站http://news.cqjtu.edu.cn/xxtz.htm

- (2)按“F12”,选择“元素”

- 2、代码实现

- 3、爬取结果

- 三、总结

一、爬取南阳理工学院ACM题目

网站 http://www.51mxd.cn/

1、新建.py文件

import requests# 导入网页请求库

from bs4 import BeautifulSoup# 导入网页解析库

import csv

from tqdm import tqdm# 模拟浏览器访问

Headers = 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3741.400 QQBrowser/10.5.3863.400'# 表头

csvHeaders = ['题号', '难度', '标题', '通过率', '通过数/总提交数']# 题目数据

subjects = []# 爬取题目

print('题目信息爬取中:\n')

for pages in tqdm(range(1, 11 + 1)):# 传入URLr = requests.get(f'http://www.51mxd.cn/problemset.php-page={pages}.htm', Headers)r.raise_for_status()r.encoding = 'utf-8'# 解析URLsoup = BeautifulSoup(r.text, 'html5lib')#查找爬取与td相关所有内容td = soup.find_all('td')subject = []for t in td:if t.string is not None:subject.append(t.string)if len(subject) == 5:subjects.append(subject)subject = []# 存放题目

with open('NYOJ_Subjects.csv', 'w', newline='') as file:fileWriter = csv.writer(file)fileWriter.writerow(csvHeaders)fileWriter.writerows(subjects)print('\n题目信息爬取完成!!!')

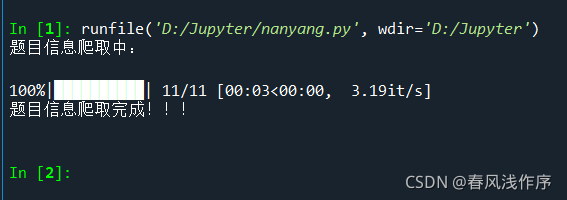

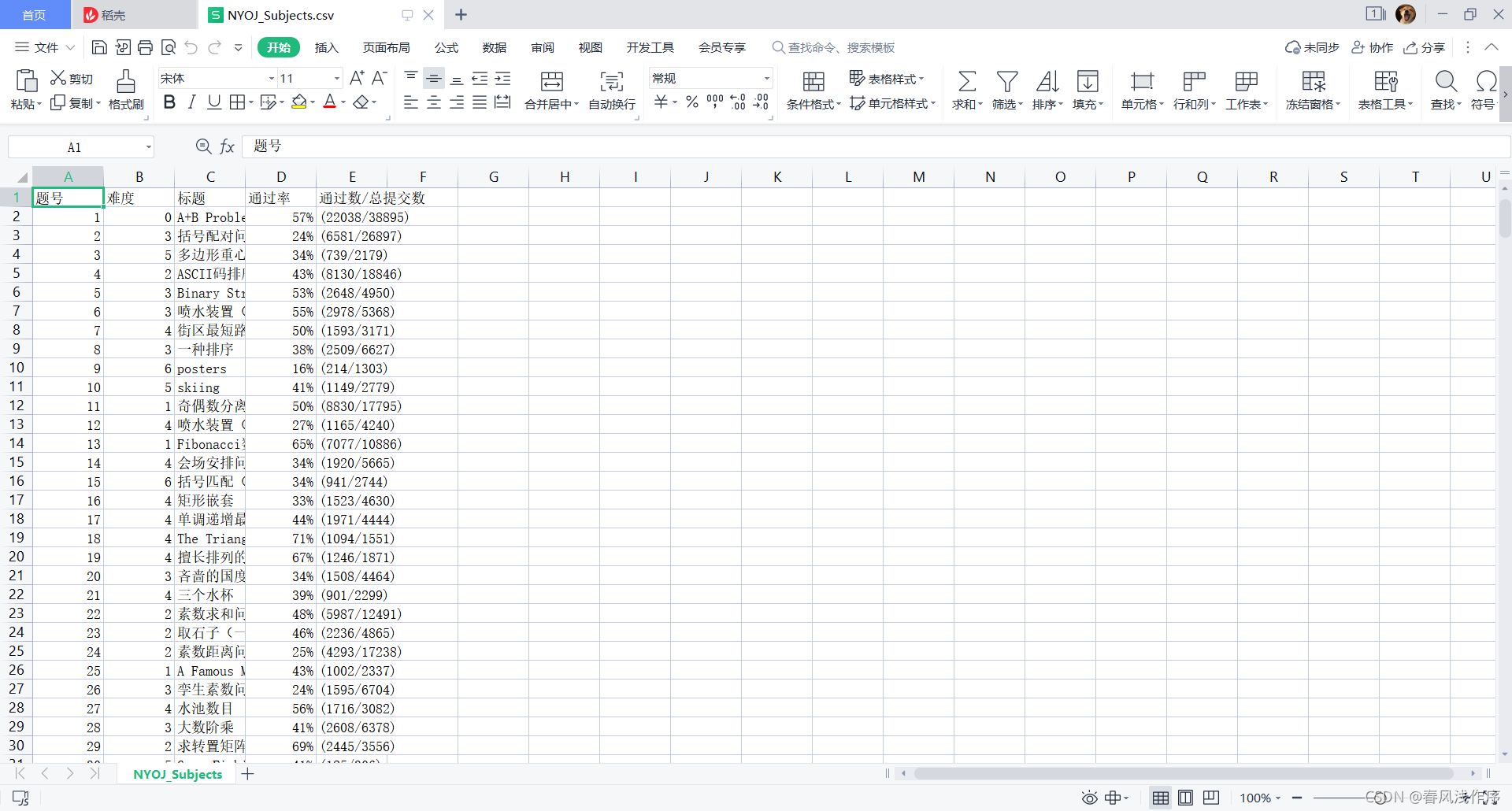

2、爬取结果

点击运行后生成NYOJ_Subjects.csv文件,打开该文件

3、代码分析

(1)调用

本次调用了 requests网页请求库和Beautiful Soup网页解析库

import requests# 导入网页请求库

from bs4 import BeautifulSoup# 导入网页解析库(2)定义表头

定义访问浏览器所需的请求头和写入csv文件需要的表头以及存放题目数据的列表

# 模拟浏览器访问# 模拟浏览器访问

Headers = 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3741.400 QQBrowser/10.5.3863.400'# 表头

csvHeaders = ['题号', '难度', '标题', '通过率', '通过数/总提交数']#表头列表# 题目数据

subjects = []#定义列表存放数据

(3)爬取信息并显示进度条

根据表头csvHeaders中内容爬取信息,并在进度条中显示进度

# 爬取题目

print('题目信息爬取中:\n')

for pages in tqdm(range(1, 11 + 1)):#一页一页地爬取信息# 传入URLr = requests.get(f'http://www.51mxd.cn/problemset.php-page={pages}.htm', Headers)r.raise_for_status()r.encoding = 'utf-8'#输出文档为utf-8编码# 解析URLsoup = BeautifulSoup(r.text, 'html5lib')#查找爬取与csvHeaders表头中相关所有内容td = soup.find_all('td')subject = []#新定义一个subject用来存放当前页面爬取的满足特征的信息for t in td:if t.string is not None:subject.append(t.string)if len(subject) == 5:#通过长度判断subject内容是否爬取到上面5项subjects.append(subject)#把subject存放进上面的subjects中subject = []#subject置空

(4)把爬取内容存放文件NYOJ_Subjects.csv中

# 存放题目

with open('NYOJ_Subjects.csv', 'w', newline='') as file:fileWriter = csv.writer(file)fileWriter.writerow(csvHeaders)fileWriter.writerows(subjects)print('\n题目信息爬取完成!!!')

二、爬取重庆交通大学新闻网站

1、确定爬取信息的位置

(1)进入网站http://news.cqjtu.edu.cn/xxtz.htm

(2)按“F12”,选择“元素”

可以观察到需要爬取时间和标题所在位置

2、代码实现

# -*- coding: utf-8 -*-

"""

Created on Wed Nov 17 14:39:03 2021@author: 86199

"""

import requests

from bs4 import BeautifulSoup

import csv

from tqdm import tqdm

import urllib.request, urllib.error # 制定URL 获取网页数据# 所有新闻

subjects = []# 模拟浏览器访问

Headers = { # 模拟浏览器头部信息"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.69 Safari/537.36 Edg/95.0.1020.53"

}# 表头

csvHeaders = ['时间', '标题']print('信息爬取中:\n')

for pages in tqdm(range(1, 65 + 1)):# 发出请求request = urllib.request.Request(f'http://news.cqjtu.edu.cn/xxtz/{pages}.htm', headers=Headers)html = ""# 如果请求成功则获取网页内容try:response = urllib.request.urlopen(request)html = response.read().decode("utf-8")except urllib.error.URLError as e:if hasattr(e, "code"):print(e.code)if hasattr(e, "reason"):print(e.reason)# 解析网页soup = BeautifulSoup(html, 'html5lib')# 存放一条新闻subject = []# 查找所有li标签li = soup.find_all('li')for l in li:# 查找满足条件的div标签if l.find_all('div',class_="time") is not None and l.find_all('div',class_="right-title") is not None:# 时间for time in l.find_all('div',class_="time"):subject.append(time.string)# 标题for title in l.find_all('div',class_="right-title"):for t in title.find_all('a',target="_blank"):subject.append(t.string)if subject:print(subject)subjects.append(subject)subject = []# 保存数据

with open('test.csv', 'w', newline='',encoding='utf-8') as file:fileWriter = csv.writer(file)fileWriter.writerow(csvHeaders)fileWriter.writerows(subjects)print('\n信息爬取完成!!!')

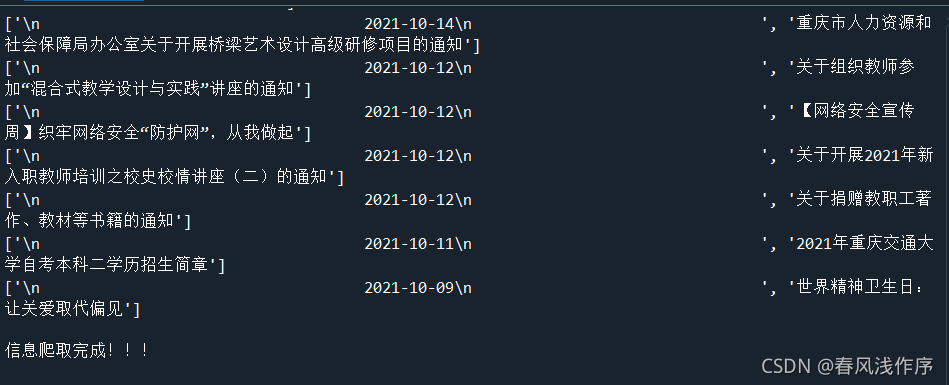

3、爬取结果

打开生成的test.csv文件如下

三、总结

Python中通过调用库来进行爬虫,总体来说还是比较简单的,不过需要一定的Web基础。