几种不同的基础架构

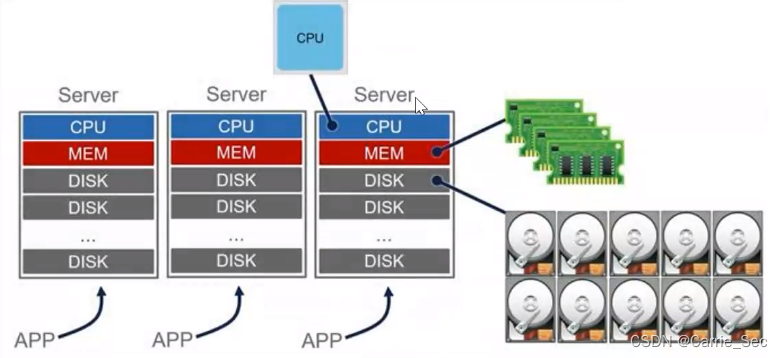

1.独立机架式服务器

资源无法灵活的扩容和更换

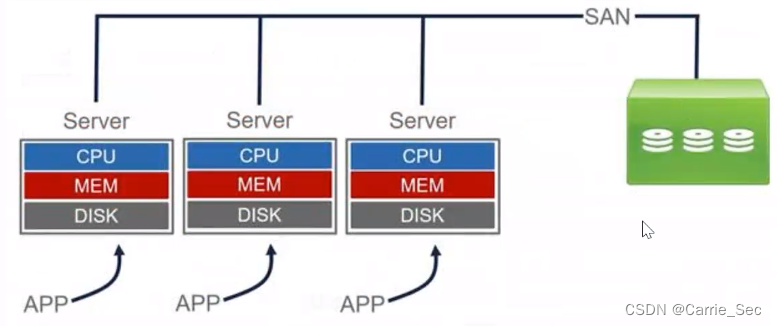

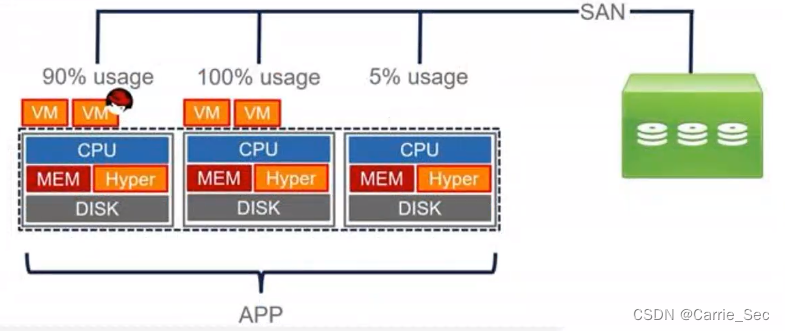

2.server+SAN存储架构

计算资源无法灵活的扩容和更换

存储池化,但是计算资源、内存还是无法灵活更换

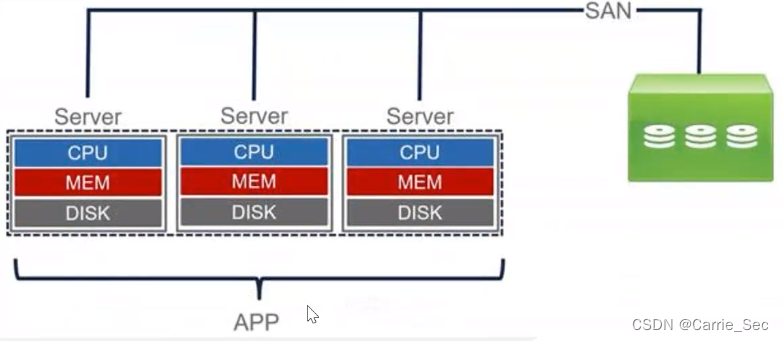

3.Server+SAN存储架构+应用群集

同个应用运行在多个server上,可灵活调整使用的计算资源

资源利率不可控(几台cpu内存资源无法相互调节,利用得当)

多台物理设备承载一个应用集群

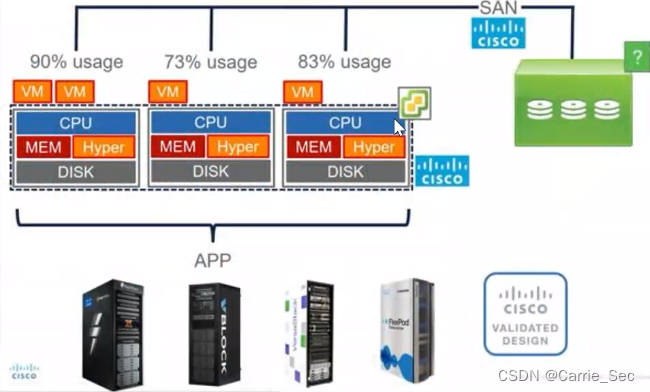

4.server+SAN存储架构+虚拟化系统(现在常见)

优点:所有服务器在一个集群,支持虚拟机在线迁移

缺点:涉及到了多种产品和厂商、多种设备的配置和运维

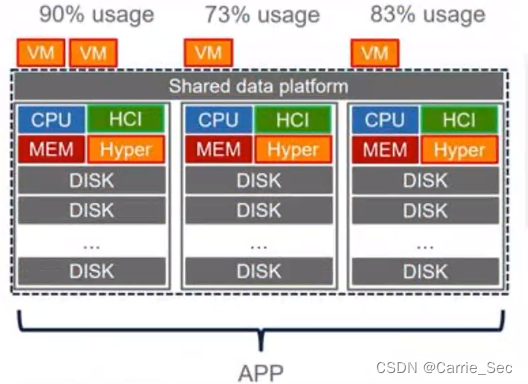

5.超融合(硬件+分布式存储软件+虚拟化系统)

重新将资源集中在一个设备中,各个服务器的存储通过软件组成一个共享数据平台

物理上数据分散

超融合概念

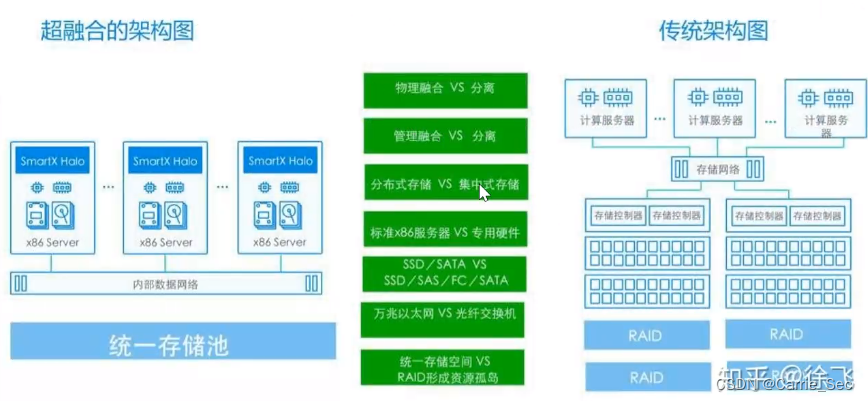

超融合(Hyper-Converged Infrastructure,HCI)指的是虚拟化计算和分布式存储的融合。

与使用传统的集中式存储不同,超融合使用标准的x86服务器来构建分布式存储。

超融合的英语是Hyper-Converged。这个词中的“超”并不是超级的意思,而是Hypervisor中的Hyper,也就是虚拟化的意思。

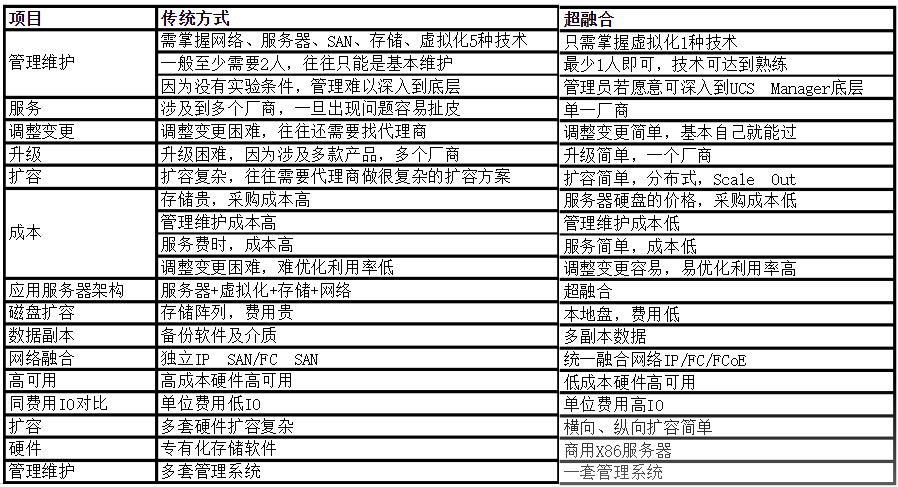

超融合架构对比传统架构

思科Hyper Flex介绍

HyperFlex=HX节点+交换矩阵(FI,提供UCSM统一交换与管理平台)+分布式存储软件+虚拟化软件

融合节点:为集群提供底层硬件,包括计算资源及存储资源;

计算节点:为集群提供计算资源

4.5版本最多允许64节点(32融合+32计算)

除ESXI虚拟化平台外,从HX3.0开始,支持Hyper-V

最右边:可以把旧的刀片机架作为计算节点加入进来

HyperFlex硬件组成

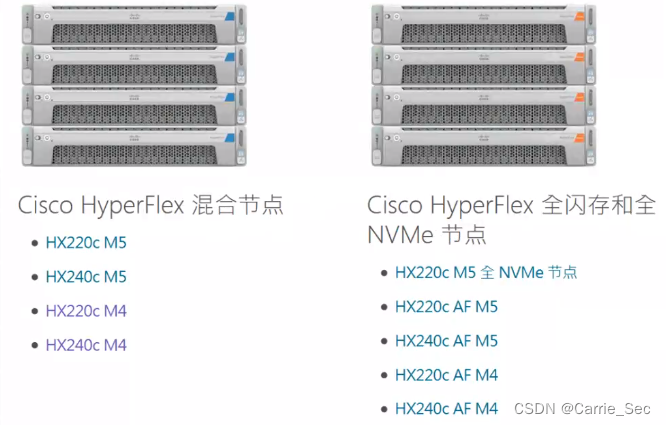

1.HX节点

存储盘:缓存盘、数据盘

容量盘选HDD->混合节点

容量盘SSD->全闪节点(性能更好)

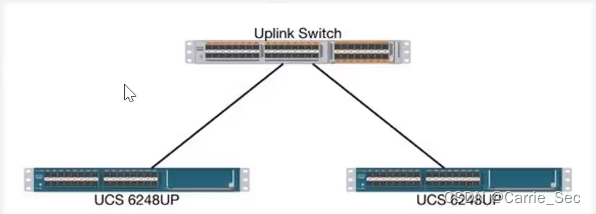

2.交换矩阵

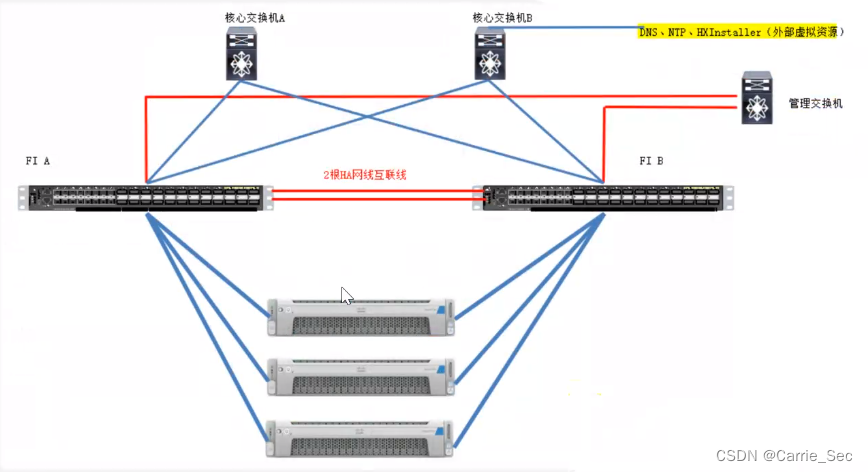

常见超融合物理拓扑

思科UCS组网架构

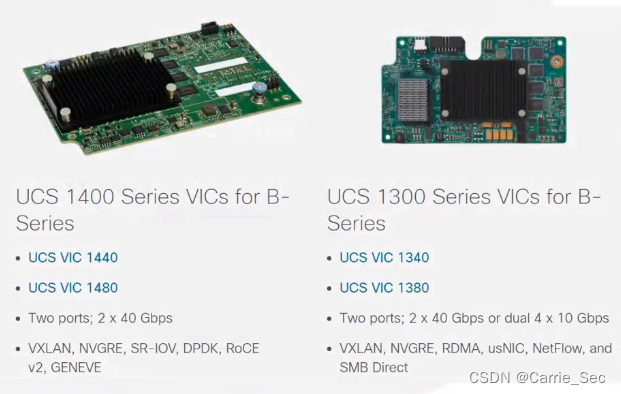

VIC卡(virtual interface card),虚拟接口卡,可以将一张物理网卡虚拟出多个虚拟网卡。思科VIC卡支持在同一个物理硬件上同时支持HBA主机总线适配器&NIC网络接口适配器功能选项。

服务配置文件

cisco UCS的服务配置文件(server profile)提供了一个无状态(stateless)的服务器,即一个service profile就代表了一个服务器,而不是刀片硬件本身。

service profile用于供给给物理服务器;很多的标识属性都提取自pools,而不是硬件。

同一时间,一个service profile只能关联一个刀片服务器。可以将service profile先取消关联,然后再关联到其他刀片,也可以再关联到其他型号的刀片服务器,service profile和刀片型号没有关系。

server组成=硬件+服务配置文件。

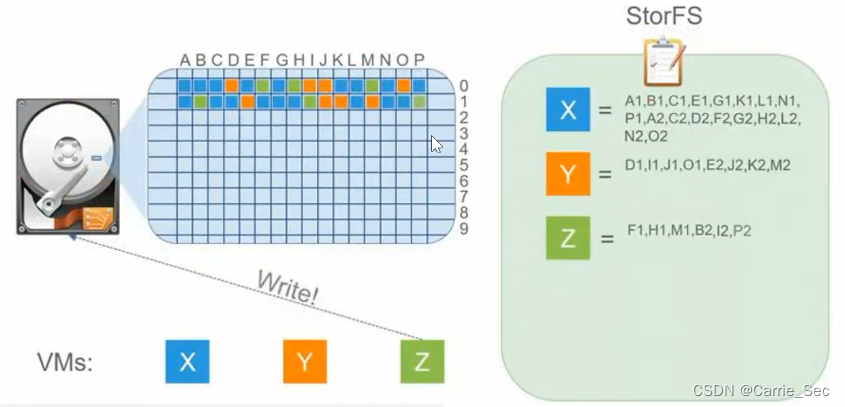

StorFS系统

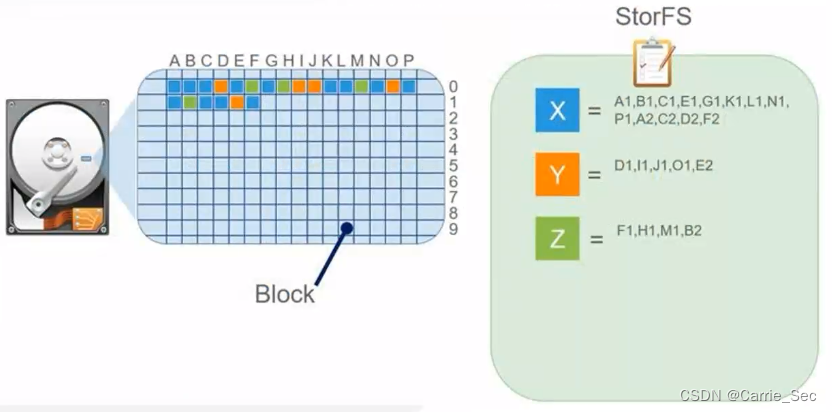

分布式日志结构文件系统

数据以信息块(blocks)为单位按顺序写入物理硬盘,并使用指针系统将信息块组合成系统中的文件

指针文件用于记录信息块的位置和组合顺序

写入数据过程:数据存入信息块,信息块信息加入到指针文件

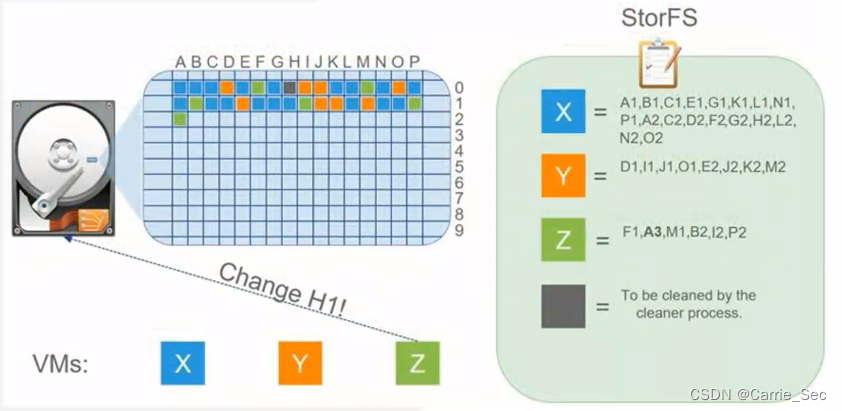

修改数据过程

修改内容写入新的信息块,指针中的信息块信息被替换,原信息块被记录到带清除数据块列表中

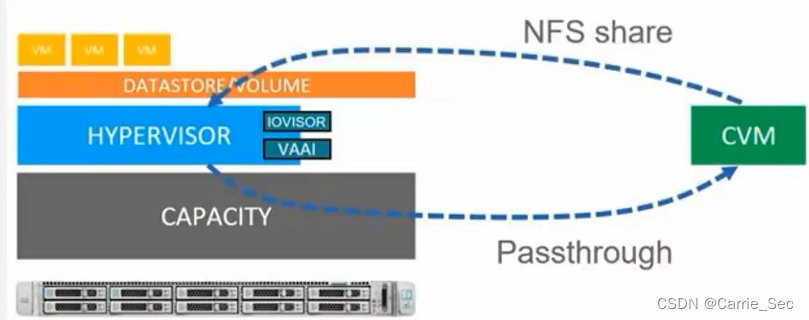

CVM

控制虚拟机(HX Storage Controller VM,简称CVM),每个节点运行一个,存放文件系统目录

物理存储统一纳入共享数据平台,并作为NFS(network file system)共享呈现给Hypervisor

节点的物理磁盘通过hypervisor被CVM管理,进行数据的直接读写和缓存

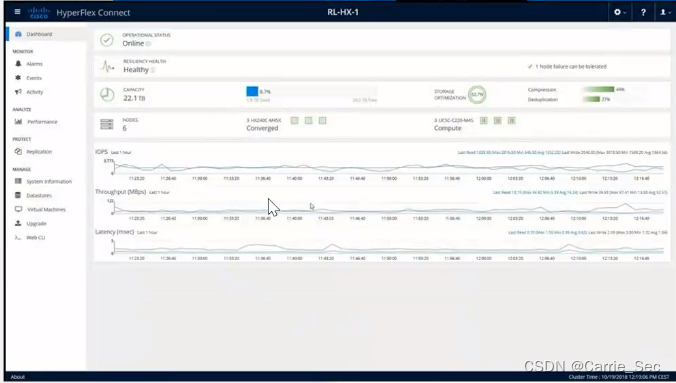

CVM对HyperFlex集群管理并对外提供管理界面

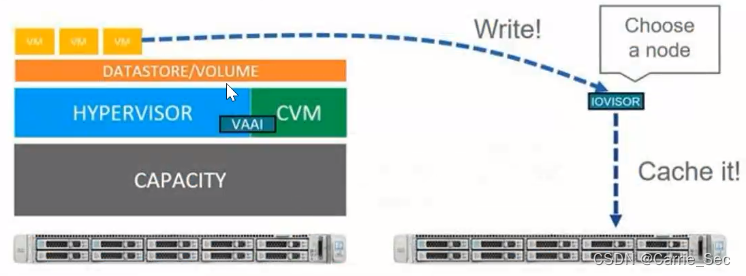

IOVISOR

- IOVISOR,IO监视器,在hypervisor中负责数据分配(data distribution)

- IO监视器捕捉需要写入的信息,然后发送到任意可用的融合节点进行缓存

- IO监视器不依赖于CVM,如果CVM发生故障,IO监视器仍然会把文件写入的数据重新定向到可用的节点中

HyperFlex复制因子及可用空间计算 - Replication Factor复制因子(RF),是HyperFlex系统写入存储块的副本数。

- 可以选择RF2或RF3,分别对应两份数据和三份数据,实际可用容量可以简单估算为50%和33%。

- RF2可以允许同一节点故障,RF3在四节点或以上的情况下可以允许同时两个节点故障。

- HX集群在创建时需要设置RF值,一旦完成创建,就无法更改,如果需要更改只能重新创建集群。

- 官方建议的配置为RF3。

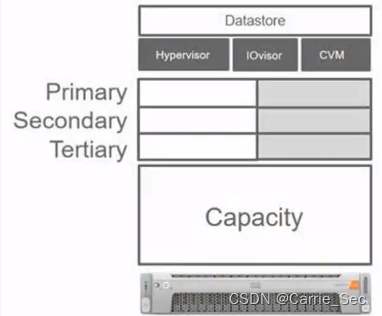

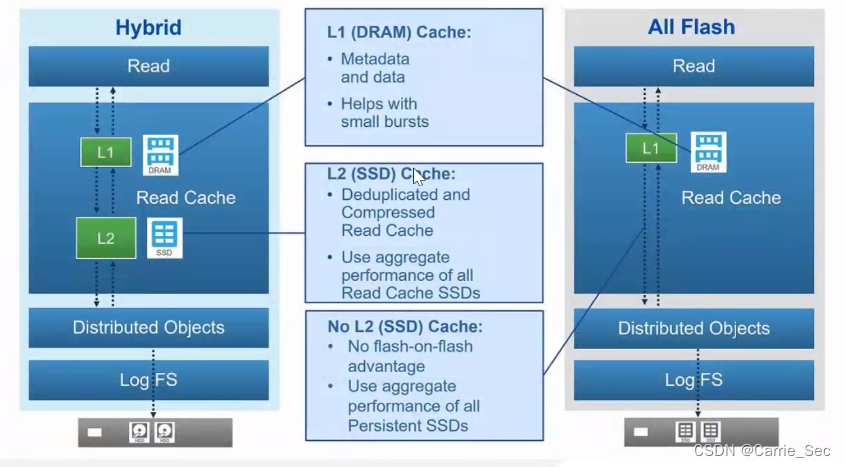

数据的读写缓存机制

- 系统需要基于高性能互联网络

- 三级存储结构:内存+cache缓存盘(SSD)+数据盘

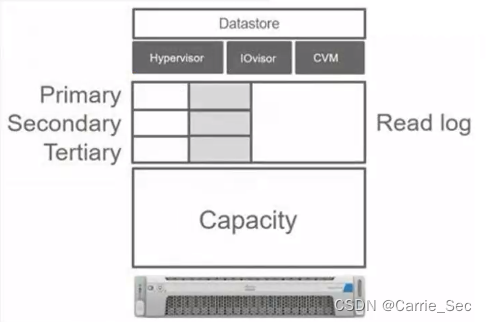

- 读缓存机制中,全闪系统的缓存盘和容量盘性能差距较小,因此不使用缓存盘去读缓存区,系统直接从容量盘读数据

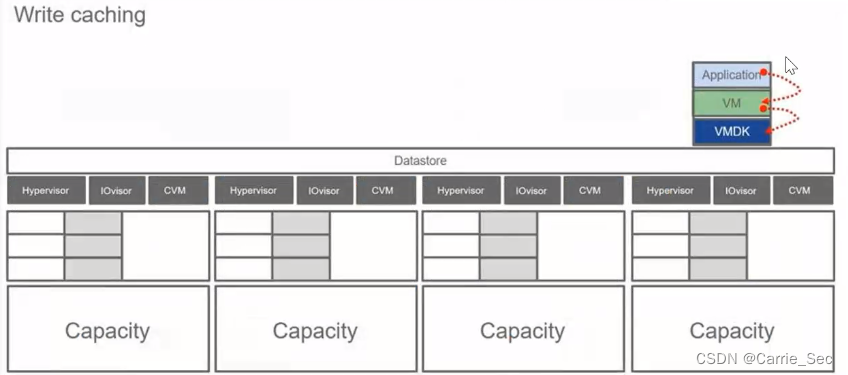

- 写缓存机制,全闪和混合式HyperFlex的运作方式一致,数据先写入缓存盘再下沉至容量盘

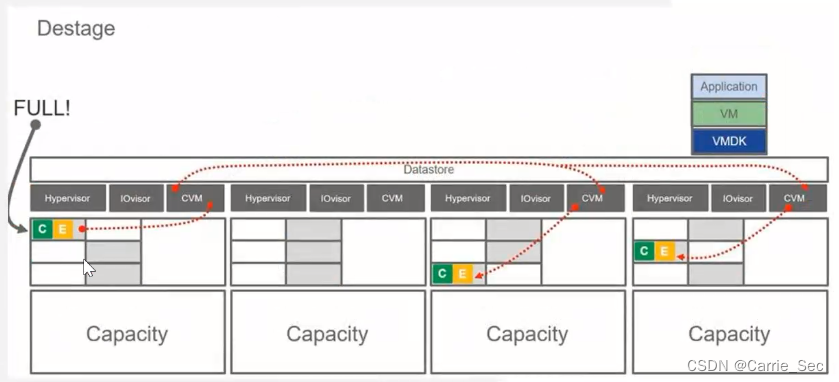

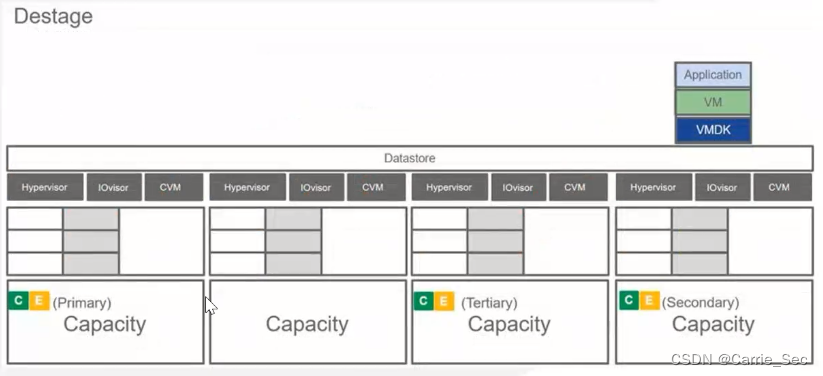

以RF3为例

- 写入缓存区分为活动缓存区(active)和被动缓存去(passive)

- 活动缓存区用于缓存数据,被动缓存区用于把数据从移动到容量盘(数据下沉过程,destaging)

- 写入缓存区可被进一步分为几个缓存等级,等级数量由安装时定义的副本数决定(RF2两个等级,RF3三个等级)

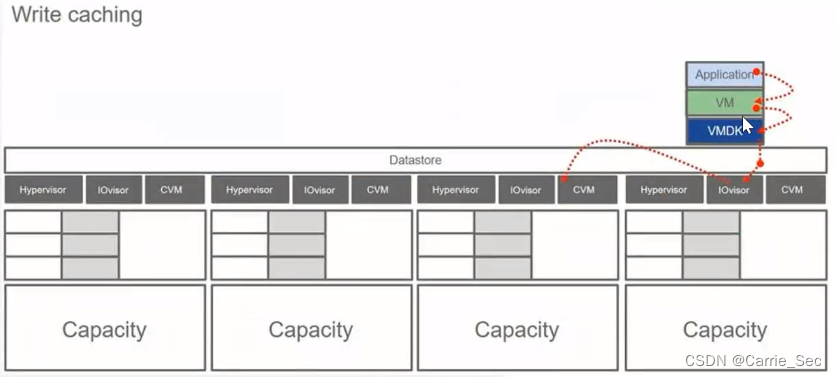

例子:- VM运行在节点4上

- 应用要求写入数据时,虚拟机操作系统向Hypervisor要求写入

- Hypervisor开始向NFS共享进行写入,该操作被IO监视器拦截

- IO监视器选择一个节点上的CVM作为写入信息的主要CVM

- IO监视器把数据块转发到所选的第一级节点(例中为节点3)

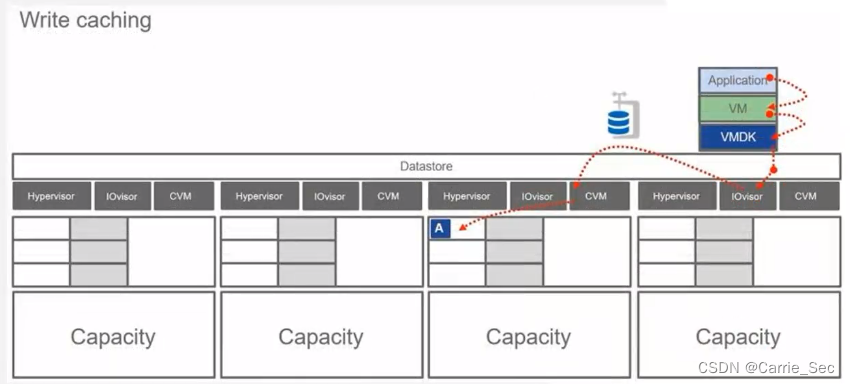

- 数据到达目标节点后,CVM会把数据压缩并写入到第一级写缓存区

-选择另外两个节点作为第二和第三级节点,并将数据再次转发,并存放至第二或第三级缓存区

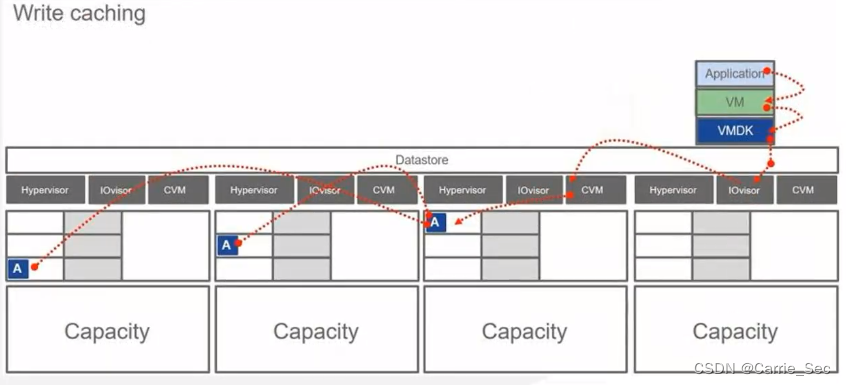

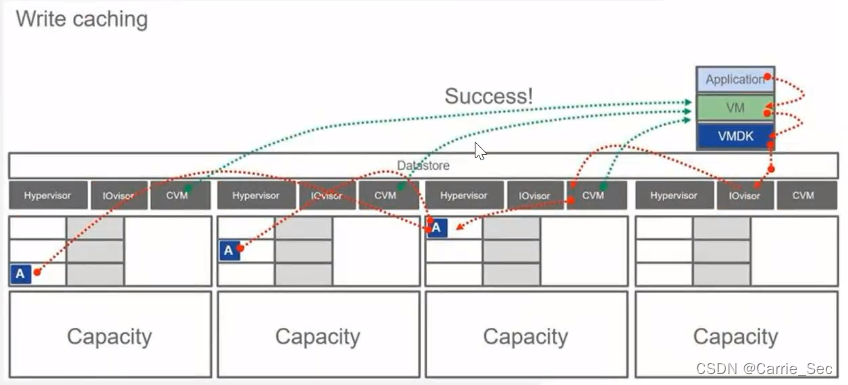

- 数据被缓存到各个节点后,节点会送回VMOS信息表示写入成功

- 在第一级缓存区被填满时,会启动写入后端磁盘程序(destage),将缓存中的信息移动到容量盘中

- 各级缓存区中的数据被放入被动缓存区

- 所有信息被写到节点的容量盘中

- 被写入的信息在容量盘中仍会保持1、2、3等级

读数据流程

思科HyperFlex部署实施

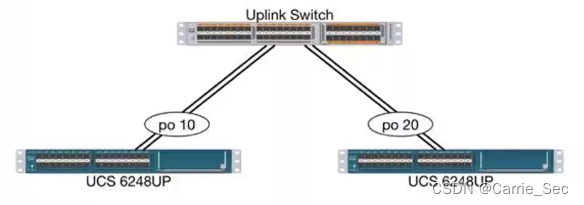

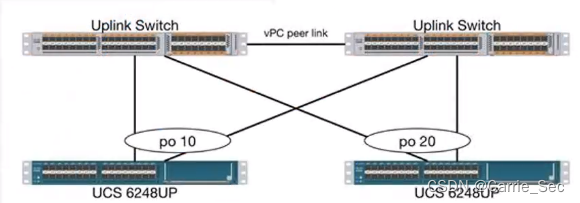

几种上联模式

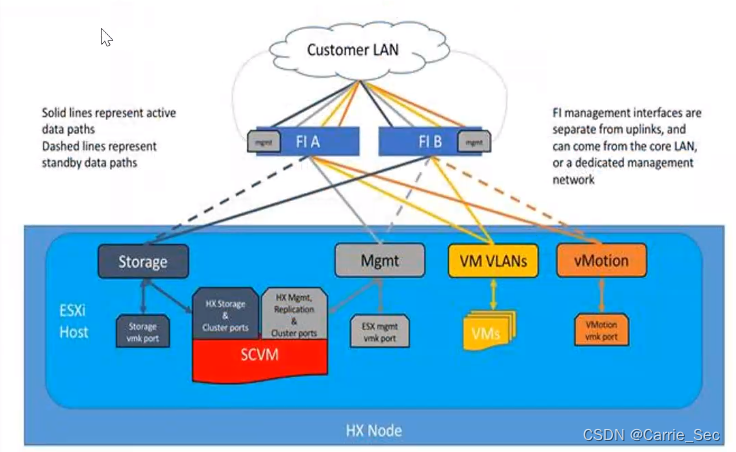

逻辑网络拓扑图

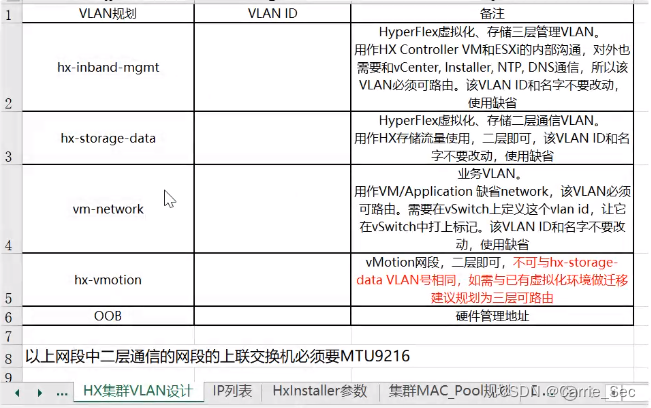

Mgmt:HyperFlex虚拟化、存储三层管理流量

storage:hyperflex虚拟化存储接口、存储二层通信流量

VM VLANs:虚拟化平台VM虚拟机流量

vMotion:虚拟化平台vMotion流量

除了业务流量AA以外其他都是AS模式(active standby)

实施前准备–信息规划

-

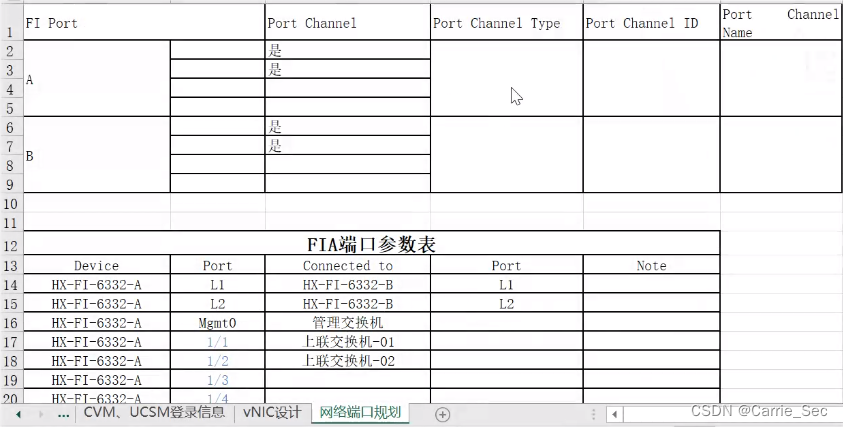

设备互联信息规划

-

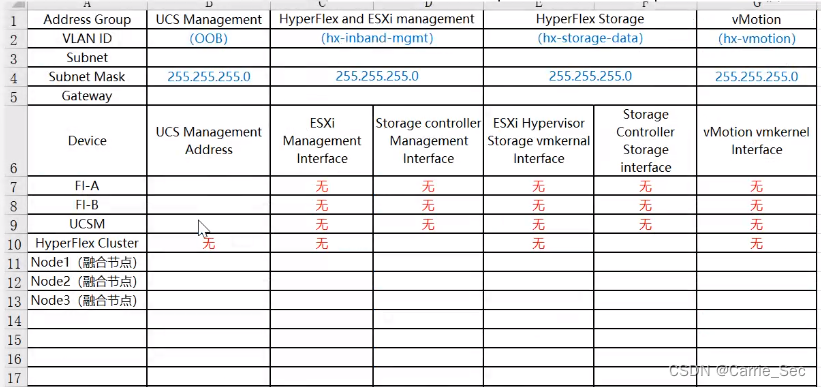

网络信息规划

-

hyperflex及虚拟化平台的vlan、地址信息等

-

DNS、NTP相关信息

-

在安装vCenter前在DNS中添加正反向解析

-

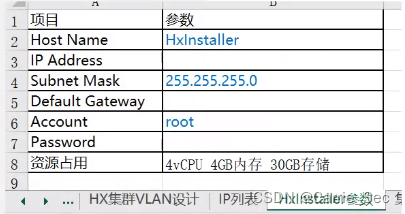

HXinstaller准备

其他信息规划

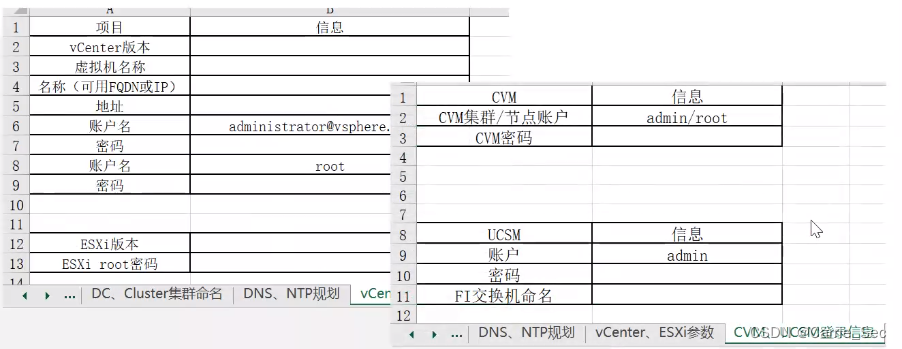

*规划ESXI和vCenter版本时需要注意版本兼容性

软件下载 -

思科官网下载

HX-Intsaller模板文件、FI&UCS固件包、HX定制版ESXi -

Vmware官网下载

VCSA

网络配置

设置上联交换机与FI的互联口为trunk/port channel

Jumbo frames MTU(FI允许使用的最大传输单位)设置为9216(在互联端口下配置,或设置全局策略)

在网络交换机上完成VLAN相关配置

其他信息确认

完成HXinstaller虚拟机部署

确认DNS及NTP服务器状态

确认网络连通性:HXinstaller、DNS、NTP与ucsm管理流量(OOB)、ESXI(hx-inband-mmgt)等之间网络互联

部署实施 -

FI初始化

-

两台FI之间的心跳通过L1-L1和L2-L2用网线互联,完成连接后加电,用console线接入主FI的console口,根据console的输出,进行第一台初始化的配置。

-

第一台配置完成后,访问第二台FI。

-

访问UCSM

-

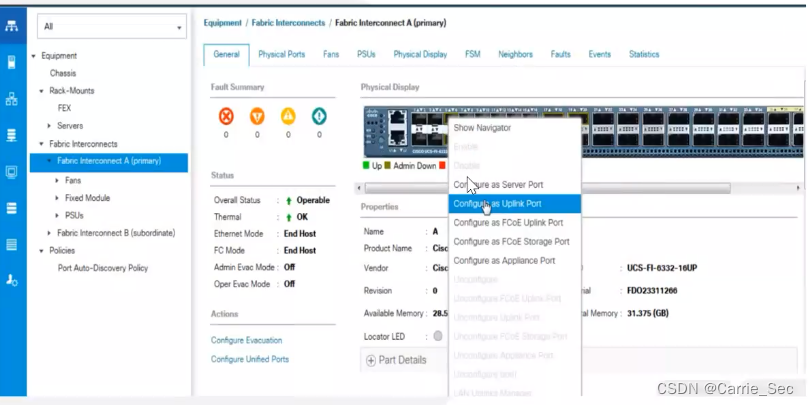

配置server口及uplink口

-

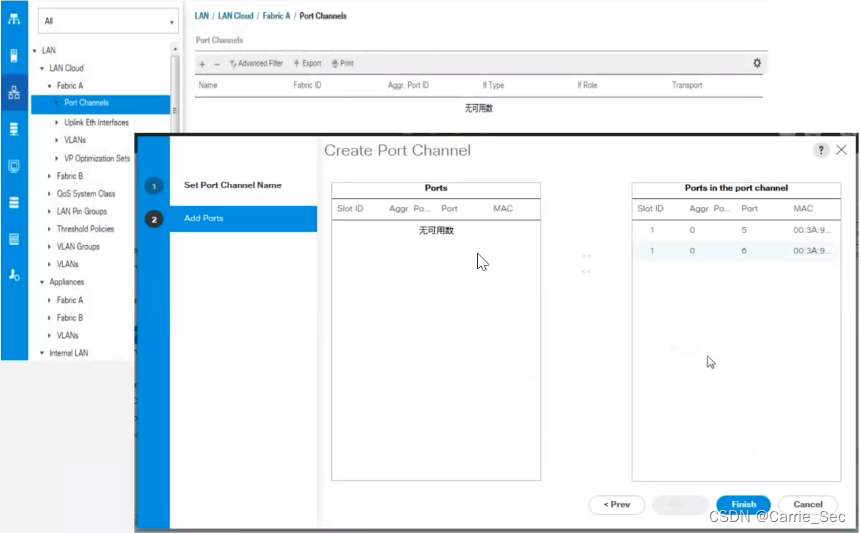

配置port-channel

-

路径:LAN->LAN Cloud->Fabric A/B->Port Channnels

-

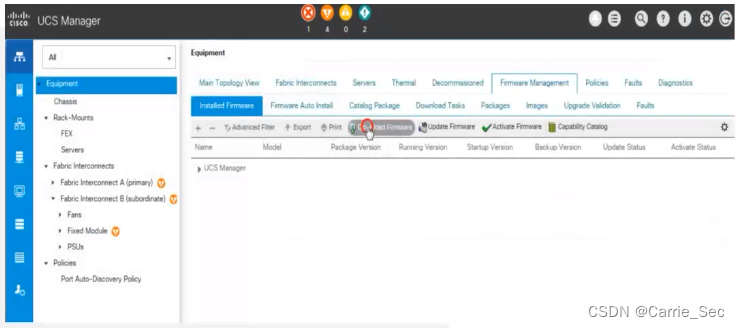

固件升级

-

上载固件包

-

路径:Equipment->Firmware Management->Installed Firmware->Download Firmware

-

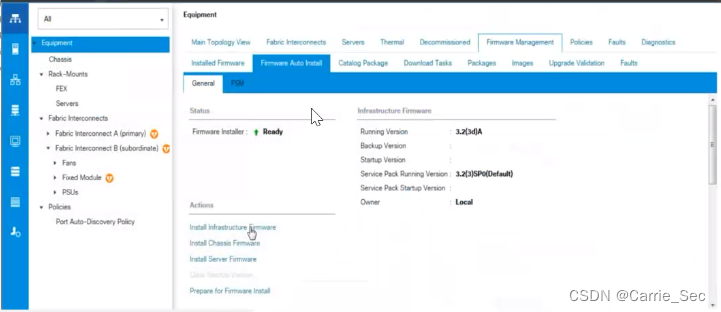

依次对FI和Server进行升级

-

路径:Equipment->Firmware Management->Firmware Auto Install->General

-

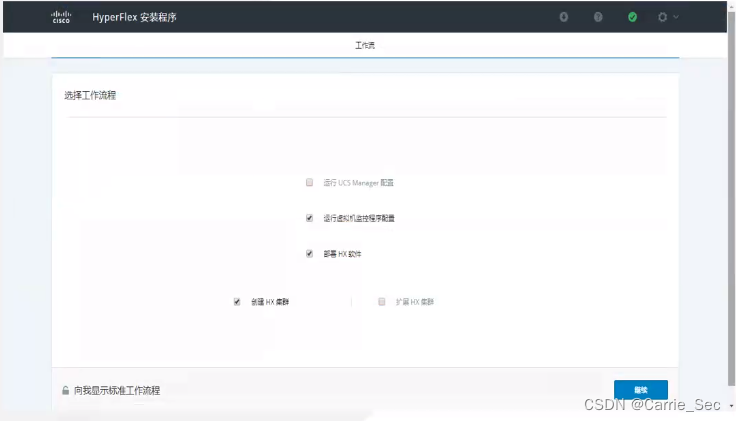

使用浏览器登录HX Installer,进行UCSM配置

-

后续需要重新安装ESXI新版本,在登陆后选择自定义工作流程安装,并勾选允许UCS Manager配置

-

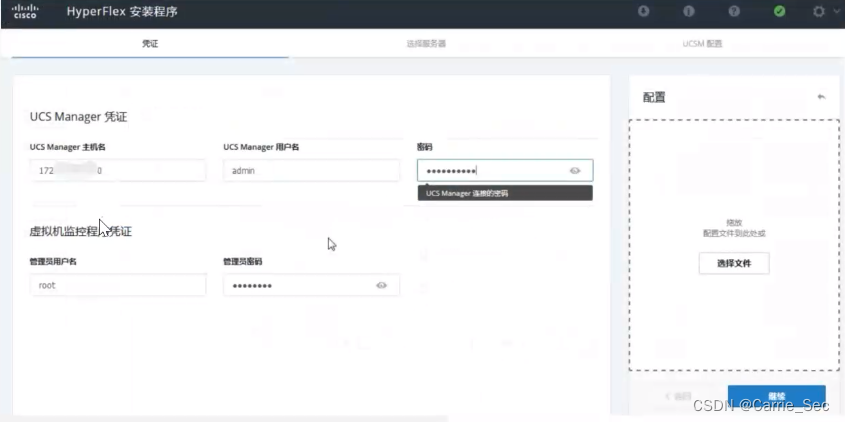

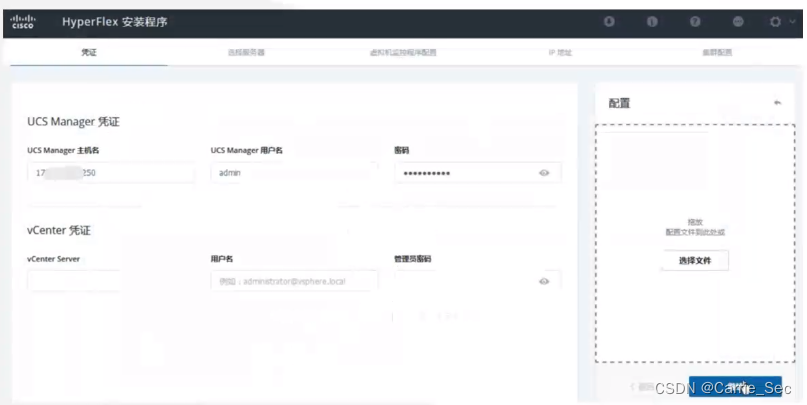

输入UCSM账号信息

-

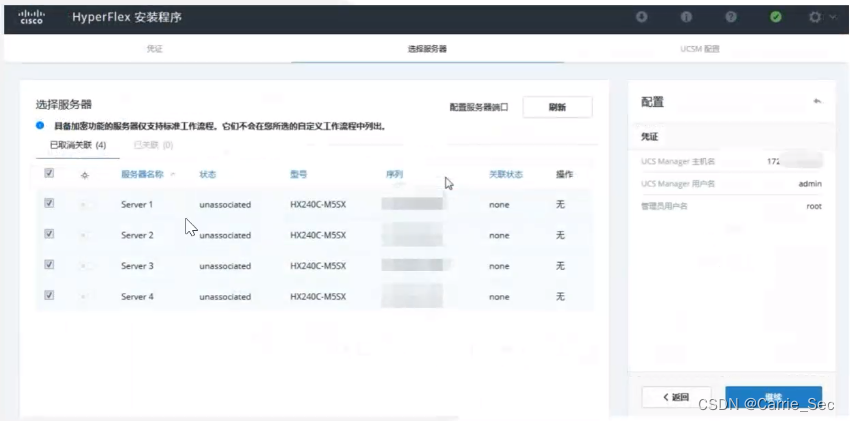

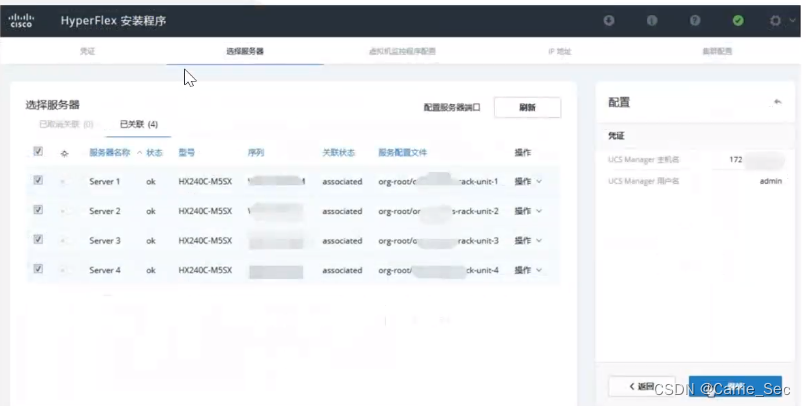

选择要关联的服务器

-

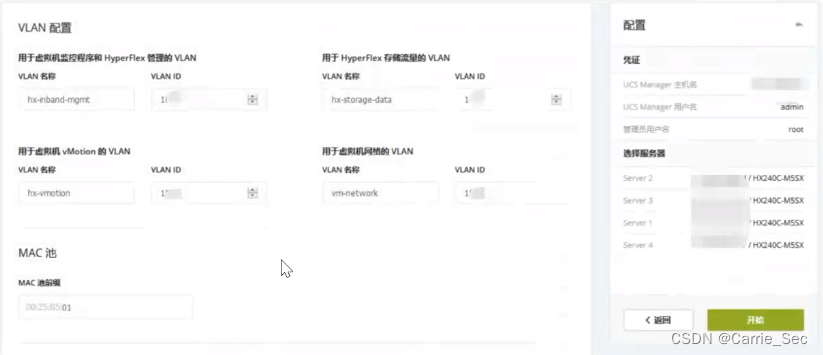

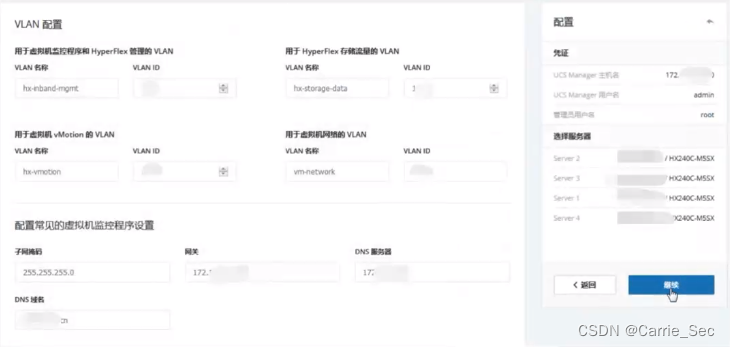

填入VLAN、管理地址等信息,点击开始

-

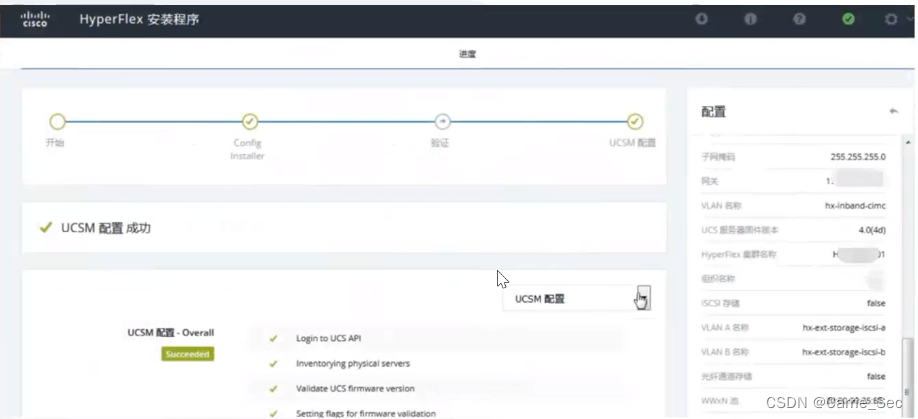

等待配置完成

-

关联好service profile之后,可以进行ESXI安装

-

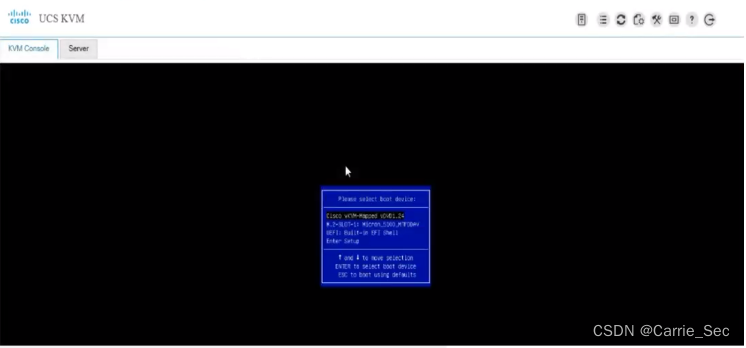

通过UCSM访问主机的KVM控制台,挂载ESXI镜像进行安装

-

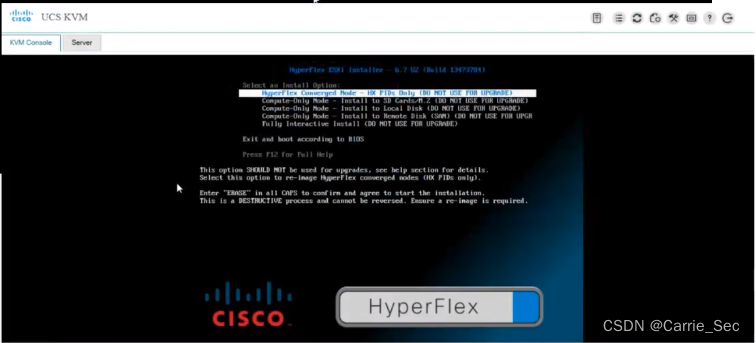

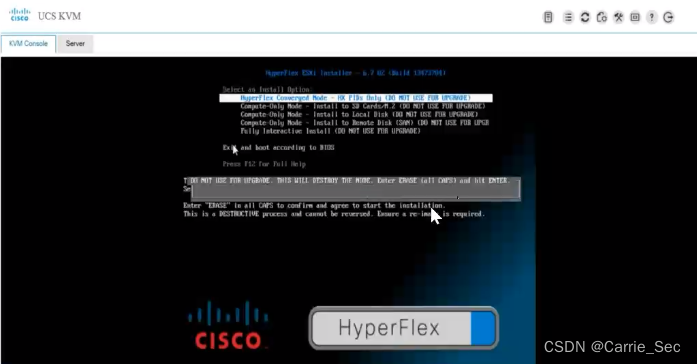

选择第一个融合节点安装,输入ERASE并敲击回车

-

安装为全自动,不需要人为填写任何参数

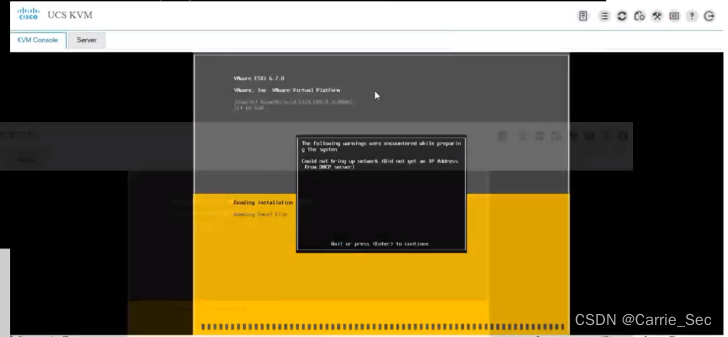

-

过程中会提示没有管理地址,回车确认即可

-

安装完成后自动重启

-

回到HX Installer,进入自定义流程界面,选择后面3步进行最终部署

-

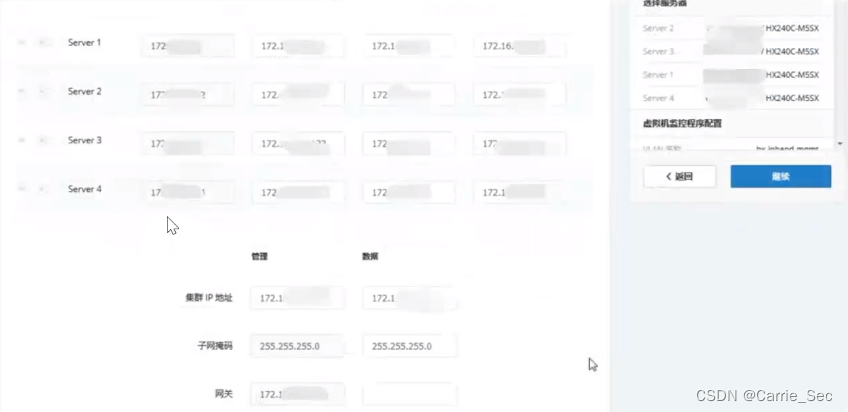

填入UCSM账号密码信息

-

如果是无vcenter部署模式,所有与BV相关内容全部留空

-

勾选要部署的服务器

-

填写VLAN、网关、子网掩码、DNS、ESXI管理地址、ESXI密码等信息

-

填写IP信息

-

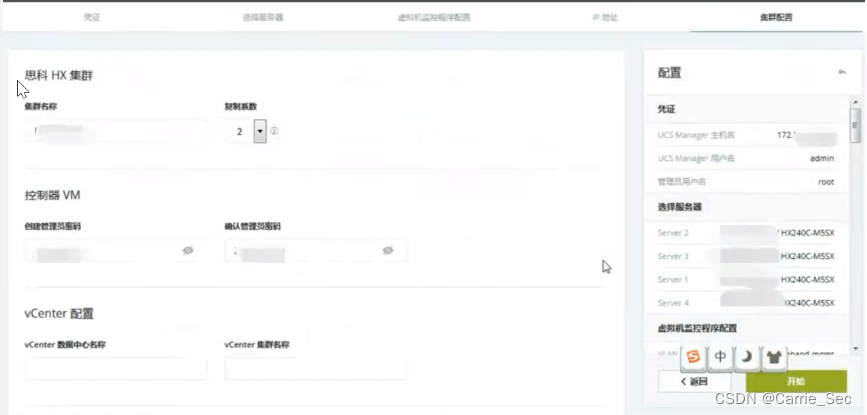

填写其他配置信息

-

信息填写完成后点击开始,等待部署完成

上面有复制系数 -

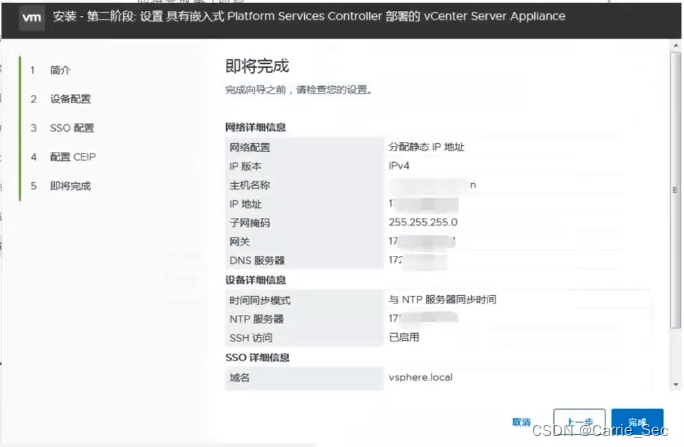

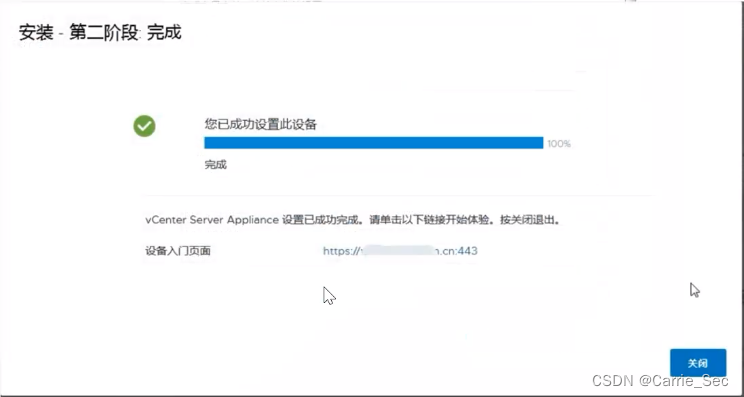

部署vcenter

-

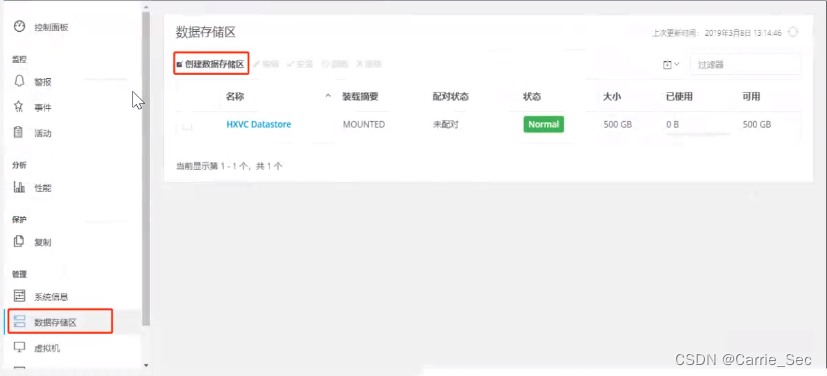

开始vcenter部署前需要通过浏览器访问CVM管理集群地址,即Hyperflex Connect集群管理界面,创建数据存储区

-

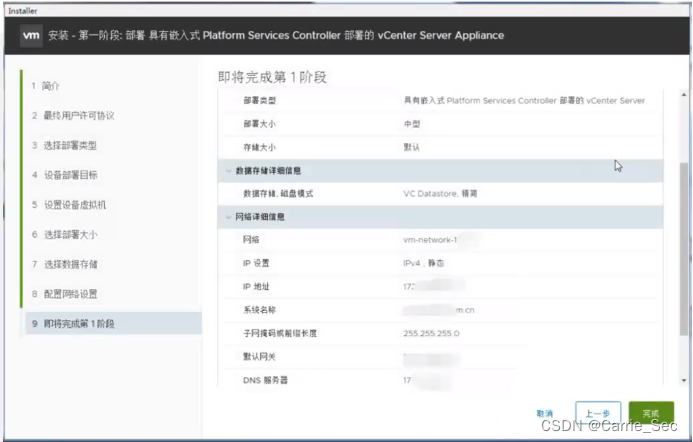

分两阶段完成VC的部署

-

需要提前在DNS上添加正反向解析

-

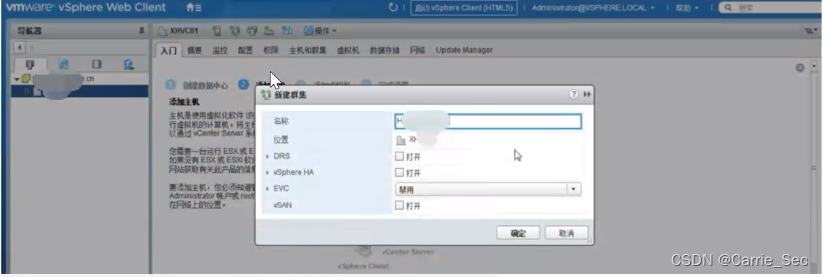

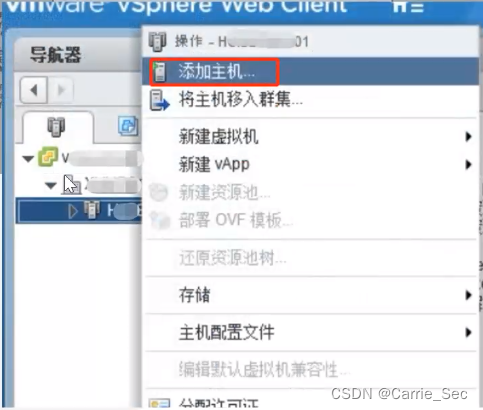

使用浏览器登录vcenter,创建集群并添加ESXI主机

-

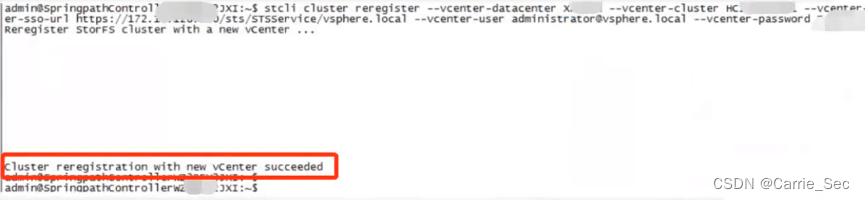

SSH登录至任意一台CVM并敲击注册命令,将HyperFlex集群注册至内置vcenter

-

看到succeeded则说明集群注册至vcenter成功

-

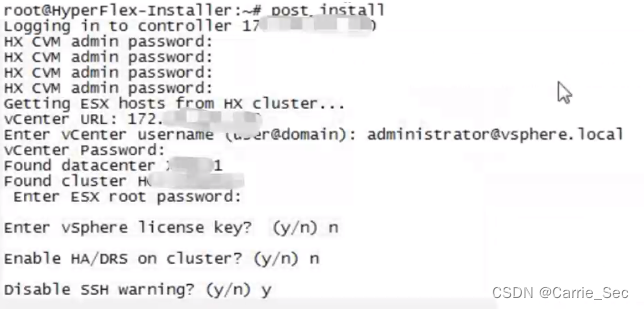

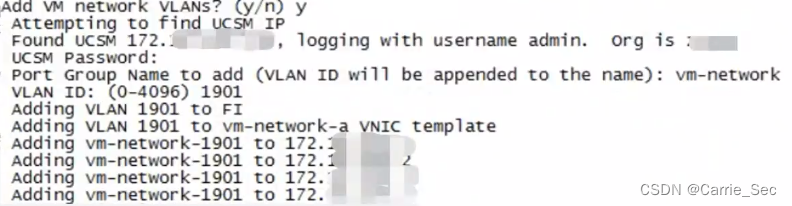

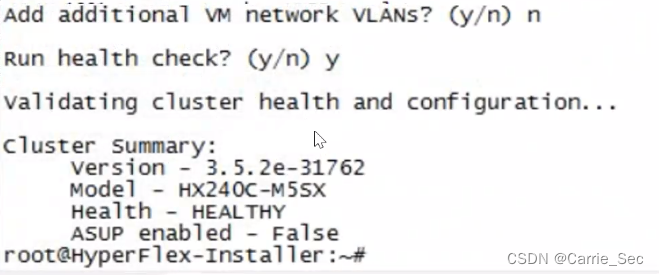

通过SSH登录HX Installer,运行post install脚本,根据提示添加或修改配置

-

该脚本可完成,设置HA/DRS、添加vmotion网络、VM网络、运行集群健康状态检查等