ChatGPT是一种基于深度学习的语言模型,它利用了人工神经网络和自然语言处理技术来学习和理解自然语言。在本文中,我将探讨ChatGPT是如何学习人类语言的,并介绍它所使用的算法和模型。

深度学习

深度学习是一种机器学习技术,它模拟了人脑神经元的工作方式,可以通过多层神经网络来实现复杂的任务。深度学习已被广泛应用于计算机视觉、自然语言处理等领域,在这些领域里面都取得了很好的成果。

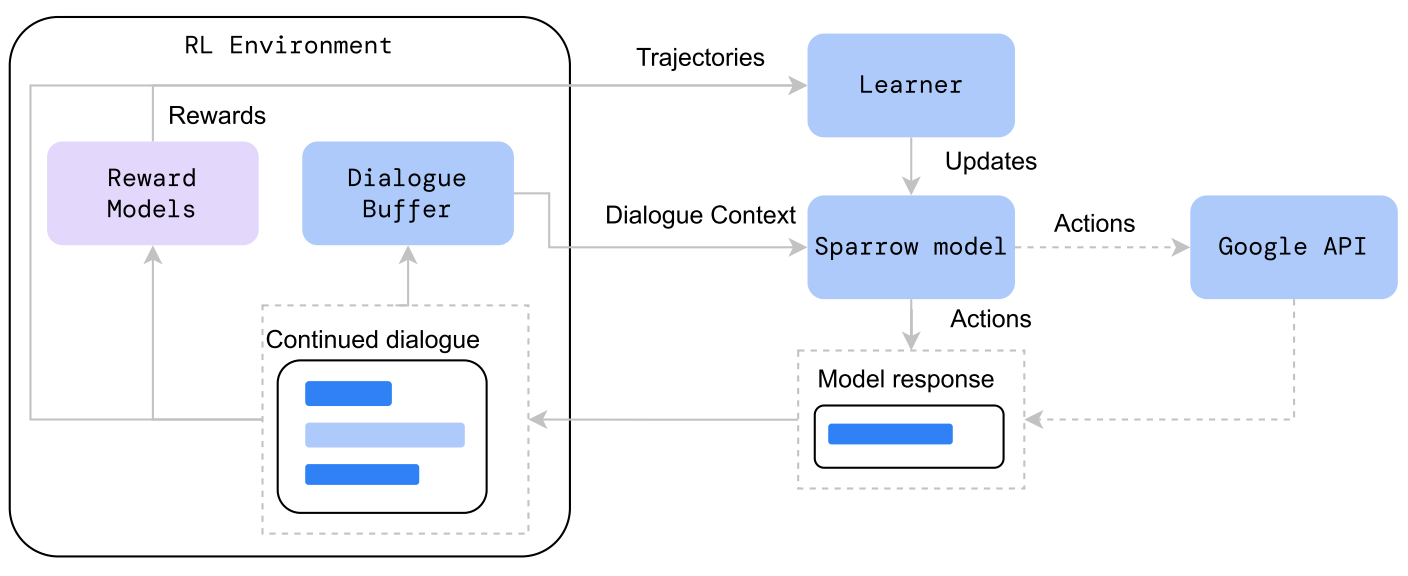

ChatGPT依赖于深度学习技术,它采用了一个特殊的神经网络结构,称为Transformer。Transformer是一种自注意力机制模型,能以最少的计算量处理长序列数据,并且在翻译和生成方面比传统的循环神经网络(RNN)更有效。ChatGPT使用Transformer来提高对话的连贯性和逻辑性,使其产生的响应更加自然流畅。

自监督学习

自监督学习是一种无需标注数据即可进行学习的技术。在自监督学习中,模型使用未标记的数据来训练自己,并尝试生成有意义的输出。ChatGPT利用了自监督学习技术,它从大量的非结构化文本数据(例如维基百科、新闻文章等)中进行训练,以便理解和生成自然语言。

在训练期间,ChatGPT会读入一个输入序列,并预测下一个单词或字符。这个过程称为语言建模。通过这种方式,ChatGPT可以在不需要标注数据的情况下学习自然语言的语法、结构和规则,同时提高其生成响应的能力。

预训练

预训练是指在特定任务之前对模型进行一些通用任务的训练,以便使模型更好地理解领域特定的数据。ChatGPT采用了预训练技术,它首先进行通用语言建模的预训练,然后再针对特定任务进行微调。

预训练过程中,ChatGPT使用了两种不同的学习目标:掩码语言建模(Masked Language Modeling,MLM)和下一句预测(Next Sentence Prediction,NSP)。在掩码语言建模中,输入序列中的某些单词或字符被随机遮盖,模型需要预测这些被遮盖的单词或字符。在下一句预测中,模型需要预测给定两个句子之间是否存在关系。

通过这种方式,ChatGPT可以学习到自然语言的语义信息和上下文相关性,进而提高其生成响应的准确性和连贯性。

微调

微调是指在特定任务上对已经训练好的模型进行重新训练,以便适应新的数据和要求。在ChatGPT中,微调是针对特定领域的对话或文本生成任务进行的。

与预训练不同,在微调过程中,ChatGPT的模型参数将被更新以适应特定的任务需求。例如,在对话生成任务中,模型需要使用已有的对话历史来生成下一个响应。为

了达到这个目标,ChatGPT需要在微调期间进行一些调整,包括增加对话历史的输入和生成更加具有上下文感知能力的响应。

微调可以通过反向传播算法来实现。该算法计算模型输出与正确答案之间的误差,并将误差传递回模型中以更新参数。在微调过程中,ChatGPT依靠大量的数据来优化其模型,以便更好地适应特定任务的需求。

结论

在本文中,我们讨论了ChatGPT是如何学习人类语言的,并介绍了它所使用的算法和模型。ChatGPT依赖于深度学习技术和自监督学习方法,在大量未标记的文本数据中进行预训练。随后,在特定任务上进行微调,以适应不同任务的要求。

总体而言,ChatGPT取得了惊人的成果,它已经被广泛用于各种对话生成任务和自然语言处理领域。随着模型的不断改进和完善,我们相信ChatGPT将会在未来更多的任务中发挥出更为重要的作用。