汤吉良老师团队发表于2020年的SIGIR

《Streaming Graph Neural Networks》论文阅读笔记

- 背景:

图能够很好的表示实际数据(如社交网络,传输网络)。利用神经网络建模图结构数据,学习特征表示,改善图相关任务(如边预测,节点分类)的性能。 - 已有方法:

图神经网络(扩展传统的神经网络)用来处理图结构相关的任务。 - 存在问题:

已有的图神经网络都是为静态图设计的,不能利用动态图(比如社交网络中新用户加入或者有新的关系时)中的信息(已被证明能够促进各种图分析任务,如社区发现、边预测等,提高推荐的性能)。因此为动态图设计图神经网络是必要的。 - 挑战:

(1) 获得图神经网络的进化结构;

(2) 只要有新的连接就更新节点信息。建立新的连接时需要考虑节点属性(新的交互代表着用户最近的喜好),也会影响节点的属性。

(3) 交互间考虑时间间隔(会影响节点的更新策略,交互信息的传播策略;不仅影响与交互相关的两个节点,还有相近的节点)。 - 本文:

提出DGNN,建模图演化过程中的动态信息。通过获得边(即交互)的序列信息,边之间的时间间隔和信息传播更新节点信息。 - 具体:

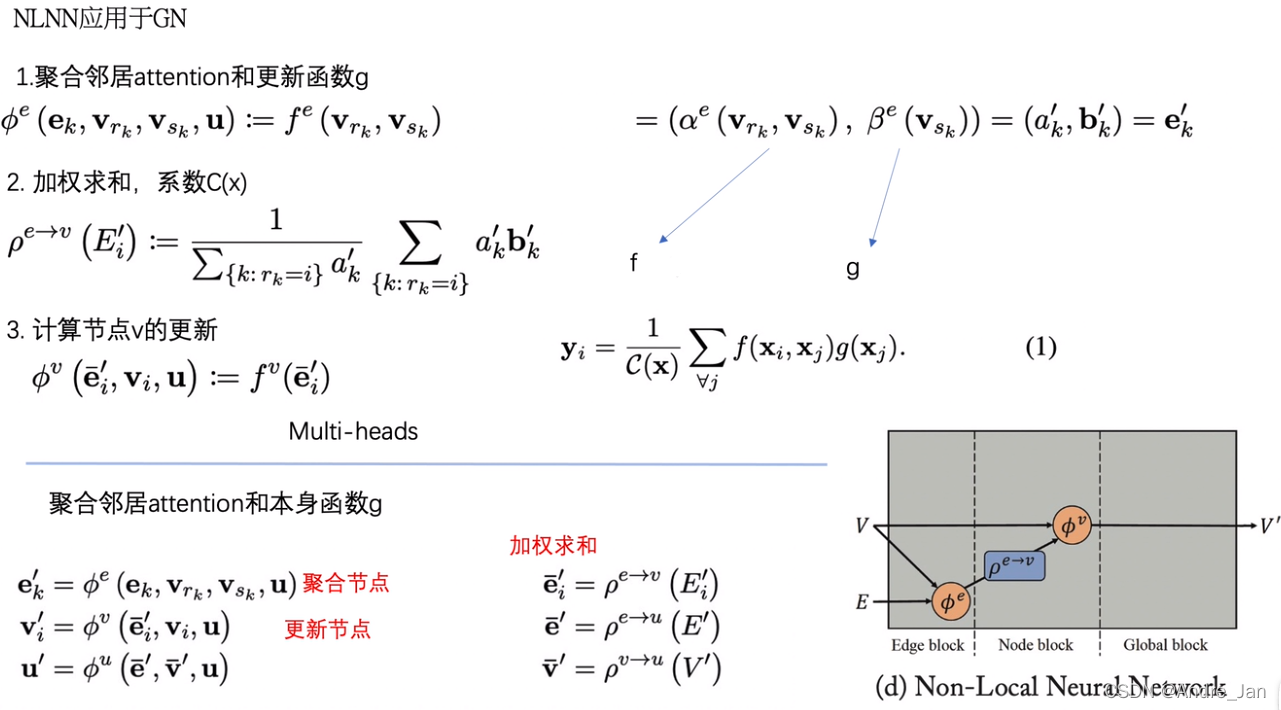

6.1 更新

相似的用户在社交网络中更有可能连接,因此要更新交互节点的交互信息。

近期的交互能更好的反映用户的喜好,因此将同一节点产生的交互视为序列,但只存储节点最近期的信息。基于LSTM建模更新部分。

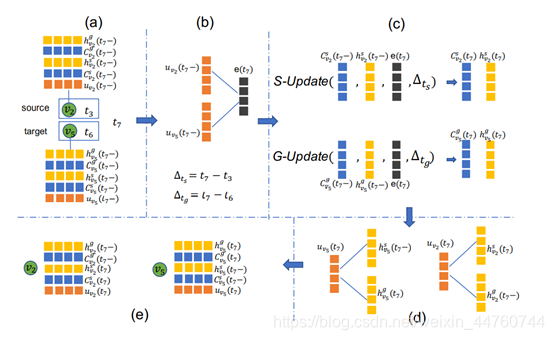

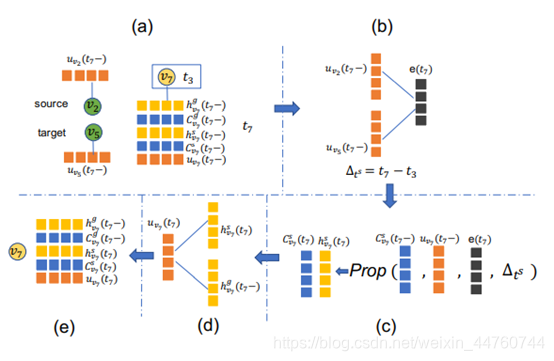

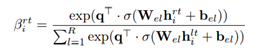

(1) 交互单元

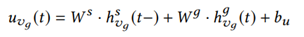

从节点信息生成交互信息,作为更新单元的输入。

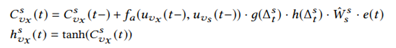

(2) 更新单元

S更新单元只更新源节点的信息 + G更新单元只更新目标节点的信息。

较早的交互更应该被遗忘,近期的交互更应该受到重视。因此在更新时考虑时间间隔。

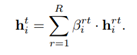

(3) 聚合单元

组合节点的源和目标隐藏状态生成特征。

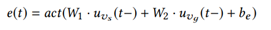

对于源节点:

对于目标节点:

6.2 传播

更新两个交互节点。选择当前交互节点的邻居作为受影响的节点。(新连接的影响是局部的;一旦受影响的节点与其他节点交互,信息将进一步传播;跳数越多,性能反而会下降)

(1) 交互单元

(2) 传播单元

与之前不同。

4种传播:从源节点到源节点邻居(以该节点为源,和目标的邻居集合) + 从源节点到目标节点邻居 + 从目标节点到源节点邻居 + 从目标节点到目标节点邻居。

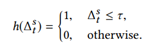

g是递减函数,时间间隔越大,短期记忆保存得越少。

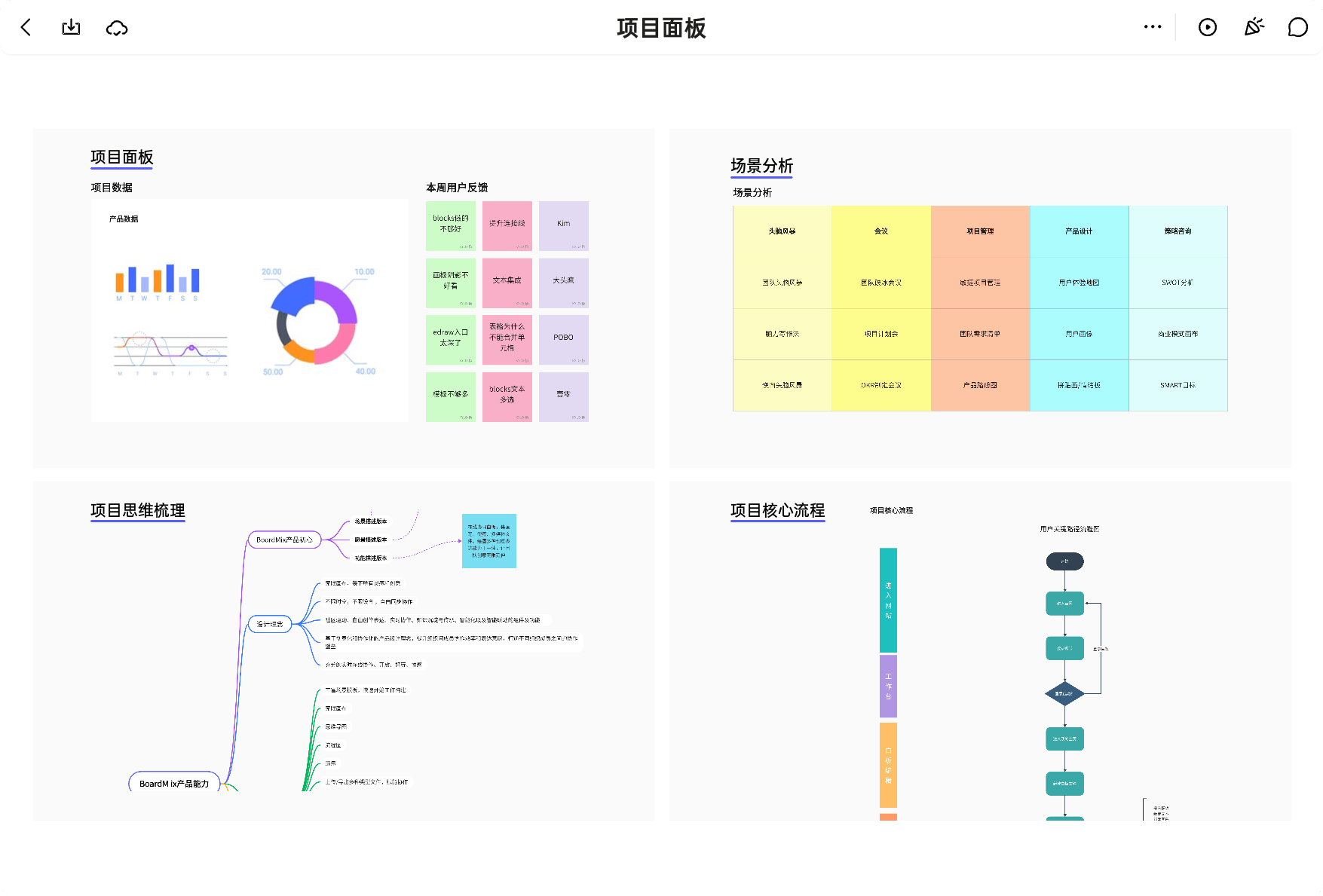

h用来过滤较早的邻居:

如果时间间隔太大,信息将停止传播给他的邻居,使传播更有效。

f是注意函数,获得节点间的连接强度。

(3) 聚合单元

6.3 参数学习

首先将两个交互节点的特征映射到交互中相应的角色,然后使用一个基于图的损失函数,批量(保持时间顺序的交互序列)梯度下降算法进行优化,半监督式训练(包括标签和未标签的数据)。

《Dynamic Heterogeneous Graph Embedding Using Hierarchical Attentions》论文阅读笔记

阿里,2020,ECIR.:动态网络特征学习

当前图嵌入的热门方向:不仅学习当前图的结构信息,还能学到图随时间的变化。

阿里提出了基于层次化注意机制的动态图特征算法,在异构变化的图中学习节点特征,是推荐底层算法模型上的突破。

背景:

大多数嵌入方法,如node2vec、GCN、GraphSAGE 和 GAT ,都是针对静态图(假设图不会发生改变),实际中,关系图是会随着时间改变的,如社交网络,电子商务网络。若将这些关系表示在一张图上,不能显式建模用户随时间的兴趣变化。

具体:

构建图:

使用用户的历史行为日志。节点:用户和商品;边:点击,查询,下单。

模型:

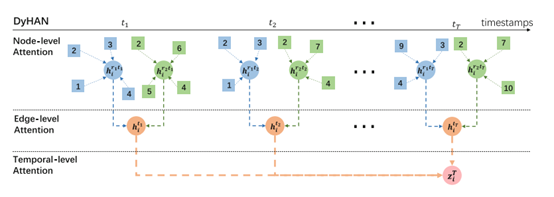

主要为三层注意机制,节点层级,边层级,时序层级上的聚合。

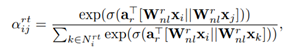

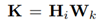

(1) 节点层级聚合:

根据边的类型划分成子图,加权聚合子图每个节点及其邻居的信息:

最终得到节点(在某时间针对某种边类型)的特征:

(2) 边层级聚合:

假设一种类型的边只能反映一种语义类型的信息,采用注意层自动学习不同边的重要程度:

加权聚合边类型向量(不同的边类型向量对于节点的贡献不同),最终得到节点的特征:

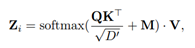

(3) 时序层级聚合:

按照重要性聚合一系列时间步的节点特征。

其中,

![[概念]神经网络的种类(前馈神经网络,反馈神经网络,图网络)](https://img-blog.csdnimg.cn/20200226160209933.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3dlaXhpbl80MDUxOTMxNQ==,size_16,color_FFFFFF,t_70)