原文链接:When Does Label Smoothing Help?

Hinton老师的这篇paper,解释了标签平滑策略在什么情况下是有效的?

摘要

通过从hard targets加权平均得到的soft targets,可以显著提升多分类神经网络的泛化性和训练速度。这种标签平滑策略可以避免模型过于“武断”,且已经在图片分类、语言翻译以及语音识别等任务上取得了sota效果。尽管已经有广泛应用,但对标签平滑的理解略显匮乏。这篇文章中,我们从实证角度论述,标签平滑除了提高模型泛化性之外,还可以提高模型的校准性(model calibration),可以有效提升模型的beam-search。然而,我们也观察到,在teacher-network训练中使用标签平滑策略,知识蒸馏得到的student-network性能会下降。为了解释这个问题,我们对网络的倒数第二层可视化,观察标签平滑是怎么改变模型表征的。发现,标签平滑有助于让模型从更紧凑的同类样本中学习,但这也导致了不同类别样本之间的相似性信息的损失,从而影响了模型蒸馏的效果。

引言

w/o: without

w/ : with

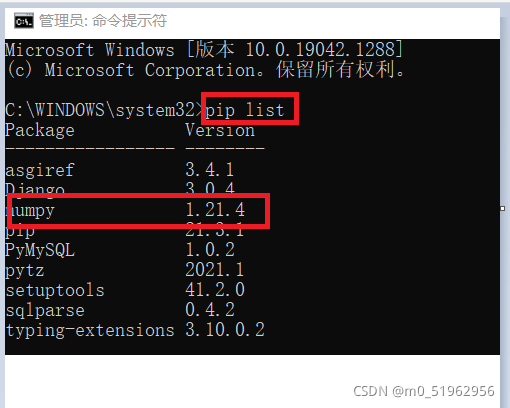

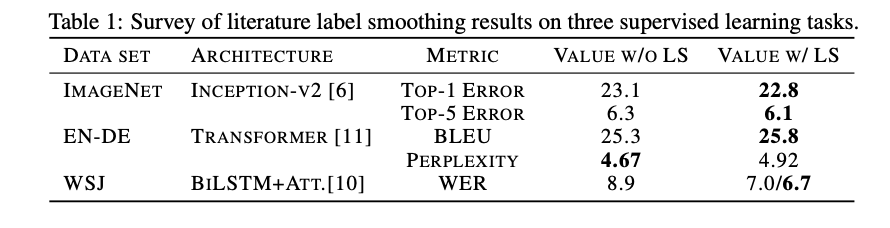

采用标签平滑策略前后的几个任务效果对比:

这篇文章阐述了结合标签平滑策略训练的网络的行为,并说明了这种网络的几个有意思的地方。本文贡献如下:

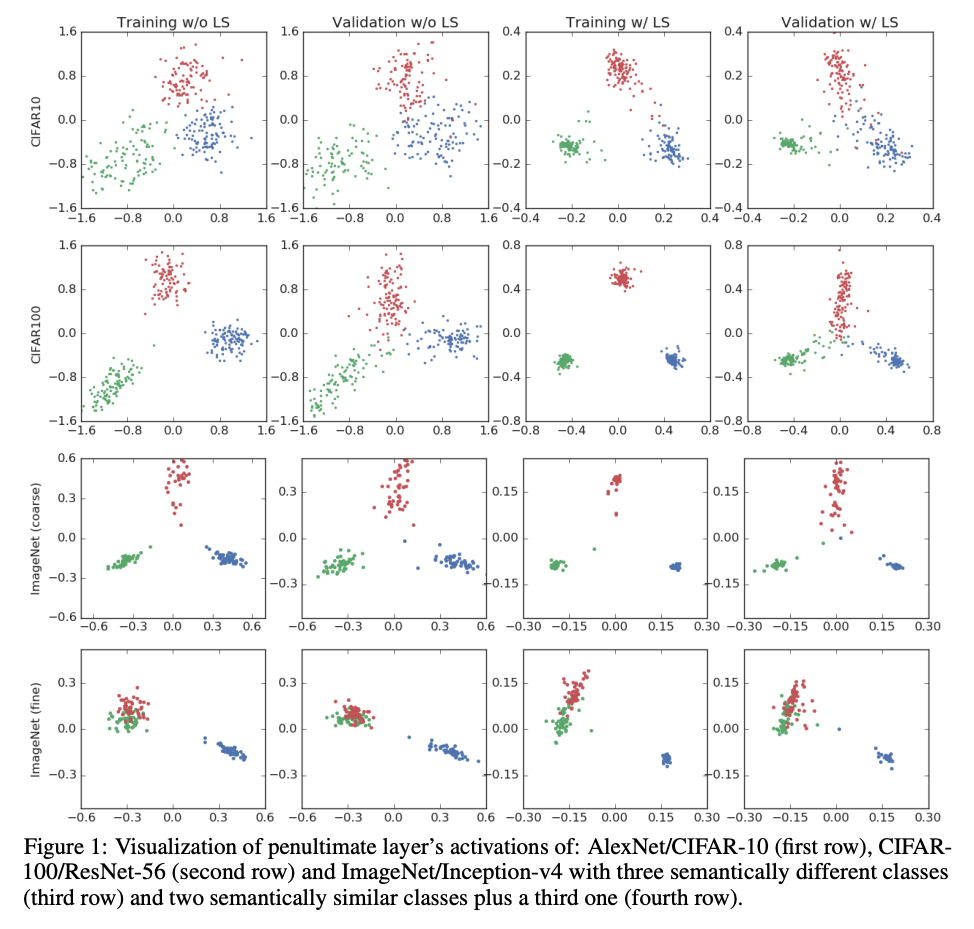

1)在倒数第二层的线性映射中引入可视化方法。这种可视化方法可以对比有无标签平滑策略时,表征的差异。

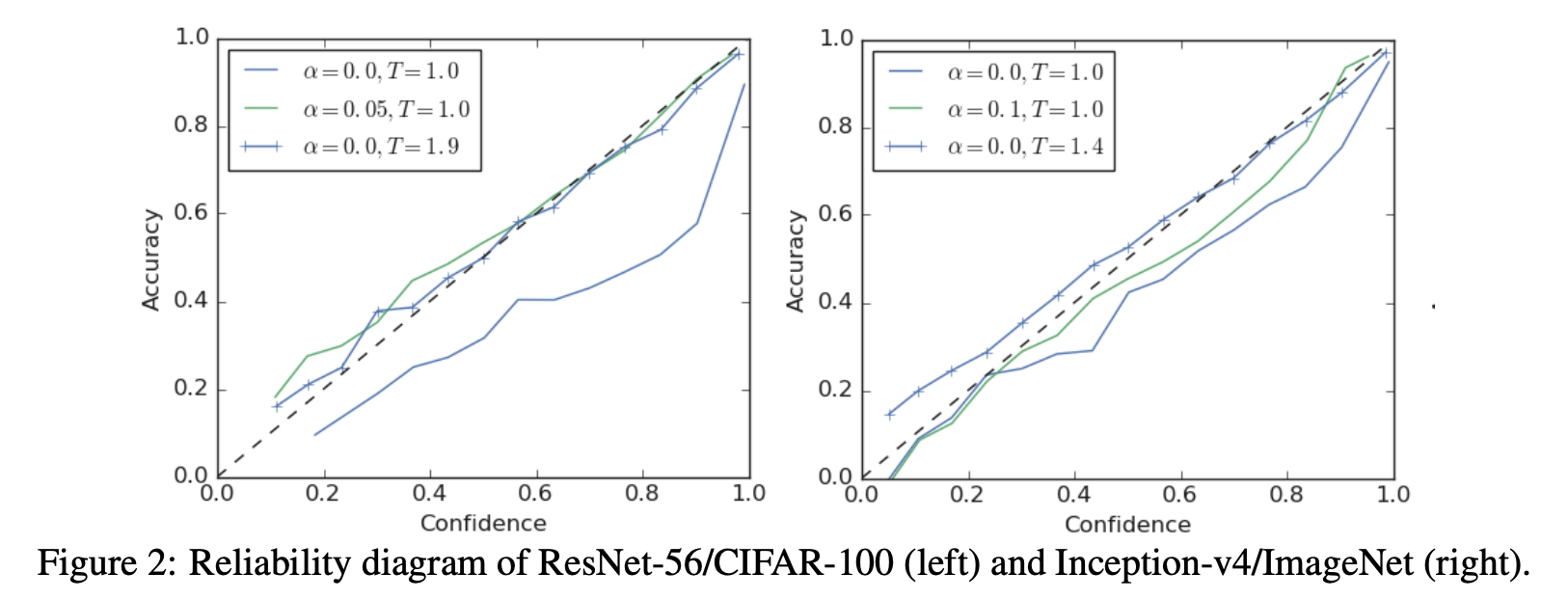

2)我们论证了标签平滑策略可以隐含地起到对模型校准的作用。因此,模型预测的置信度和精度可以更好地对齐。

3)我们说明了标签平滑策略会降低知识蒸馏的效果。即在teacher-network中采用标签平滑策略,会导致student-network中的模型性能下降。我们进一步说明了导致这种结果变差的原因,是由于logits中的信息缺失造成的。

标签平滑策略定义:

第类的预测:

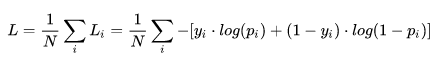

交叉熵:

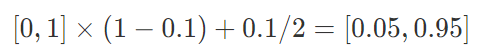

平滑后的标签:

倒数第二层表征

label smoothing encourages the activations of the penultimate layer to be close to the template of the correct class and equally distant to the templates of the incorrect classes.

隐含的模型校准

标签平滑可以降低ECE(estimated expected calibration error),可以在不使用temperature scaling的情况下校准网络。

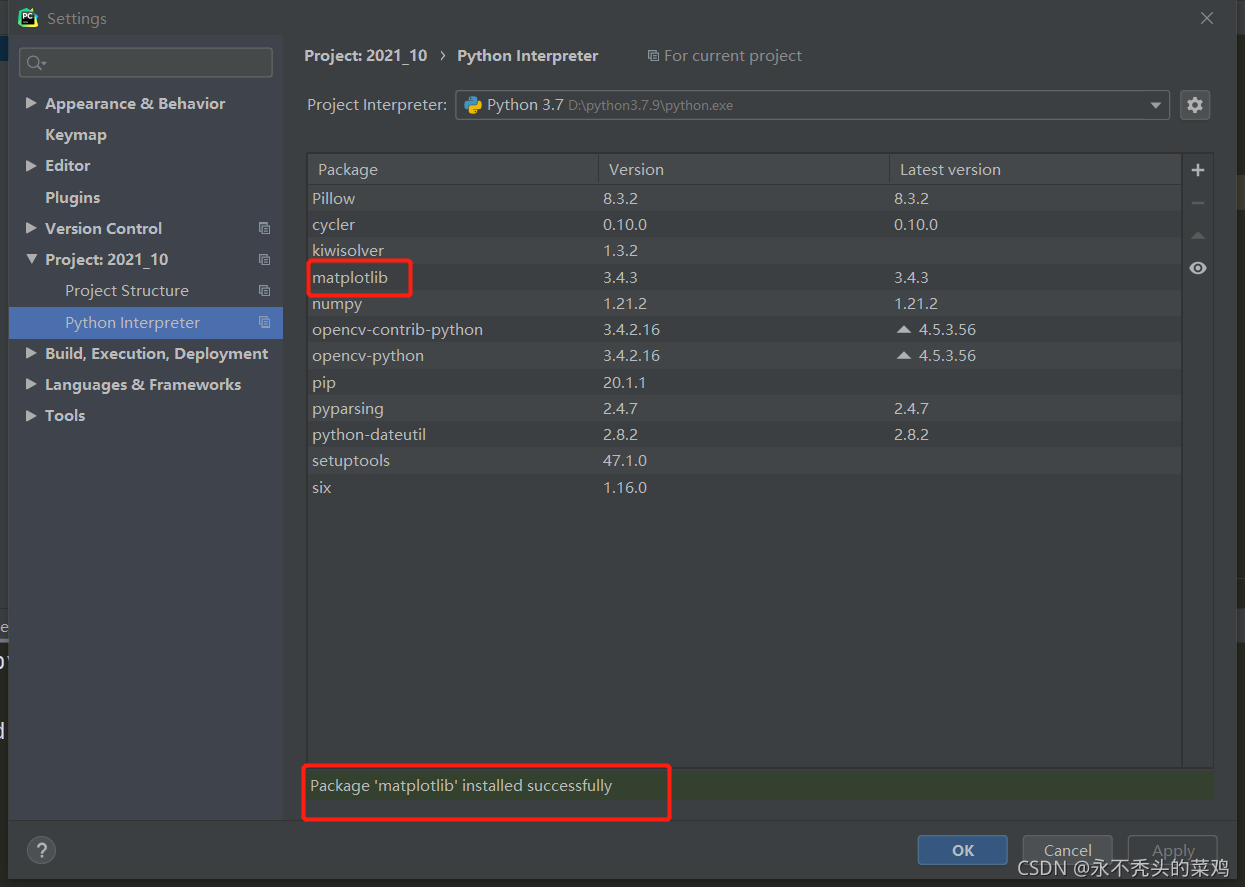

图2左边表示ResNet-56预测的可靠性示意图:中间虚线表示理想的模型,准确率等于置信度。蓝色实线表示在hard-targes上训练,不使用temperature scaling的情况,可以看到这个模型明显过拟合了,因为准确率低于置信度。蓝色带十字架的实现表示在hard-targes上训练,使用temperature scaling(1.9)的情况,可以看到斜率接近于1。绿色实现表示在soft-targets上训练,不使用temperature scaling的情况,可以看出来,对比使用temperature scaling,可以取得类似的模型校准的效果。

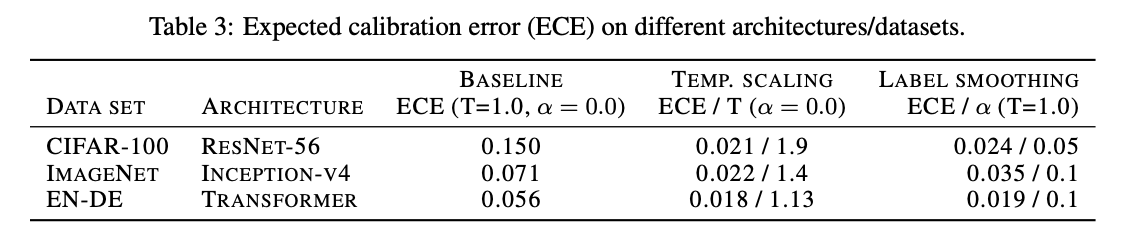

表3表示在不同的平滑率和温度参数T的情况下,ECE的变化情况。

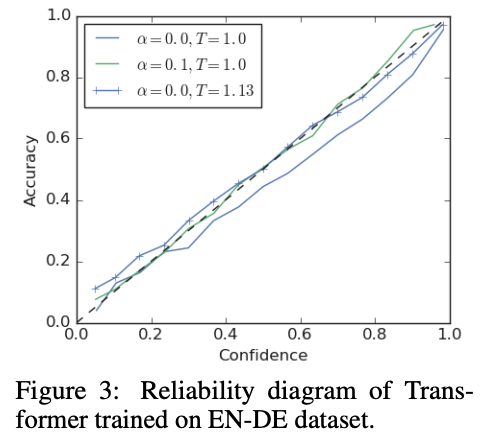

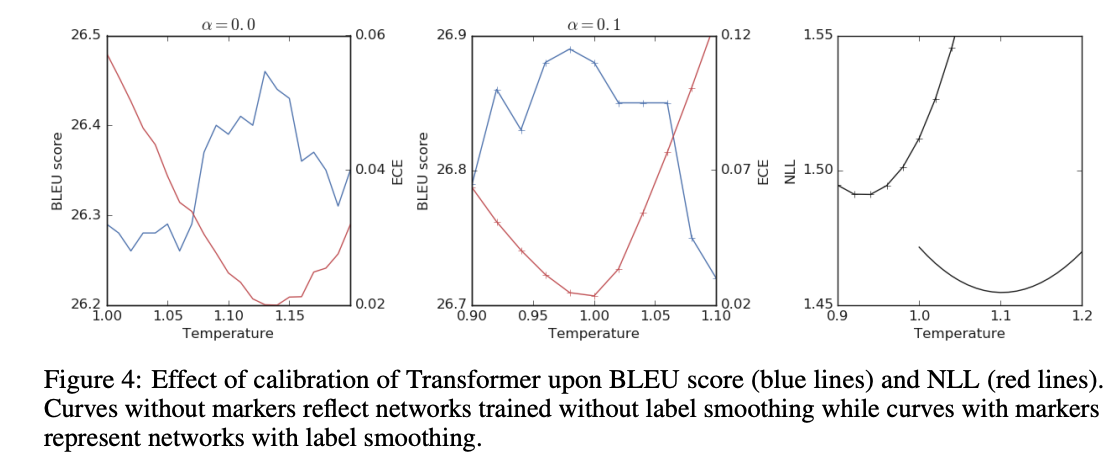

图3和表4表示在机器学习上的测试情况:

知识蒸馏

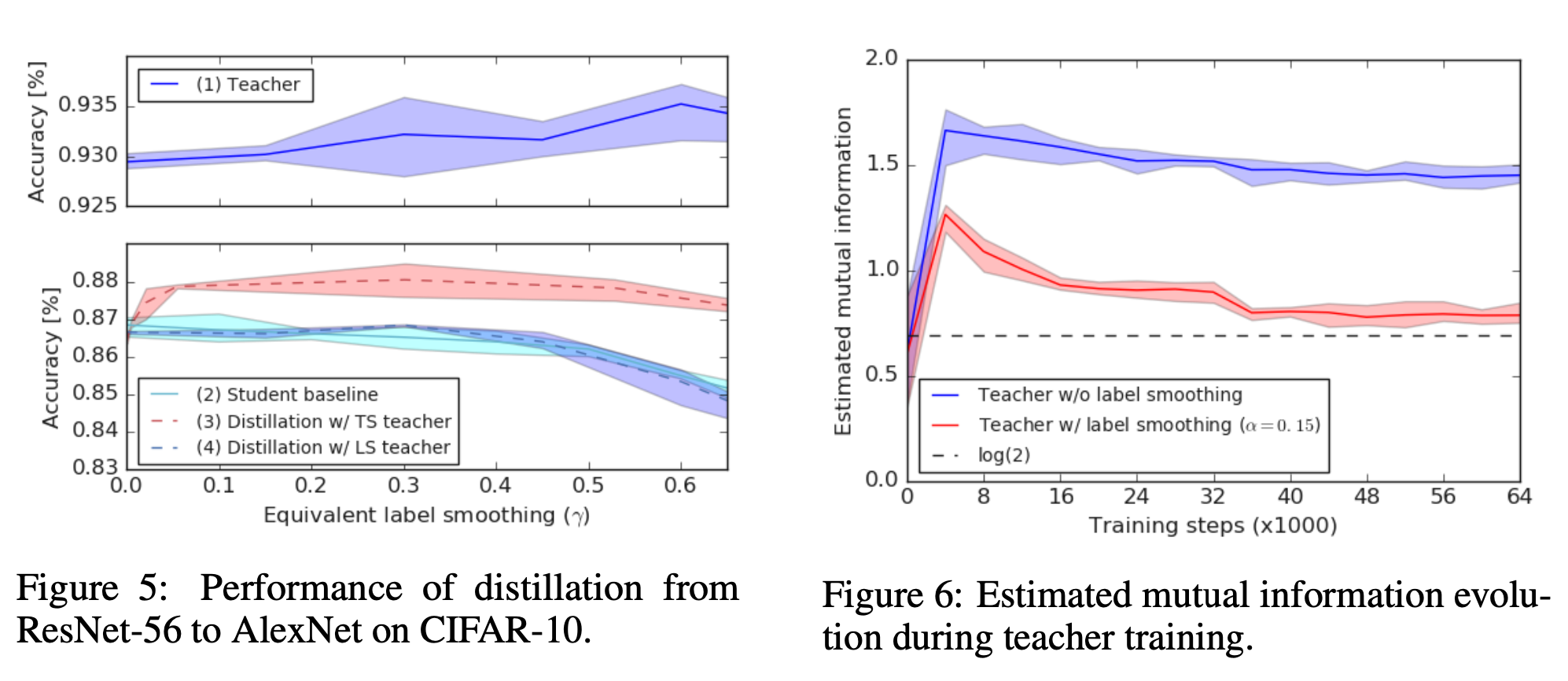

如果在teacher model中增加LS的优化,teacher model的效果会变好,但是蒸馏的student的模型反而会变差。

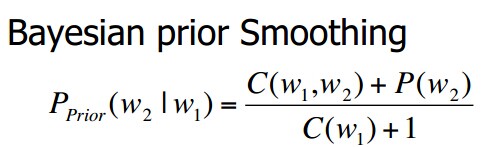

在没有LS的时候,各个错误类别的logits不同,这个携带了信息,而且有些正确类别的样本反而会更靠近错误类别。但是增加了LS之后,这些信息都被抹去了。

结论&未来工作

标签平滑强制对分类进行更紧密的分组,同时强制在聚类之间进行更等距的间隔。这种特性可以通过我们提出的可视化设计在低维空间中观察出来。标签平滑对泛化性和模型校准是有益的,但会减低知识蒸馏的效果。我们用信息丢失的角度解释了这个原因。在标签平滑策略下,鼓励模型同等地对待每个负类别。在硬标签策略下,缺乏对后面几层表征的约束,在预测类和实例之间缺乏logit变化。这可以通过估计输入样本和输出logit之间的互信息来量化,我们已经论述了,标签平滑可以降低互信息。这一发现提出了一个新的研究方向,重点关注标签平滑与信息瓶颈原理之间的关系,并对压缩、泛化和信息传输产生影响。