ChatGPT 学习笔记

概述

背景

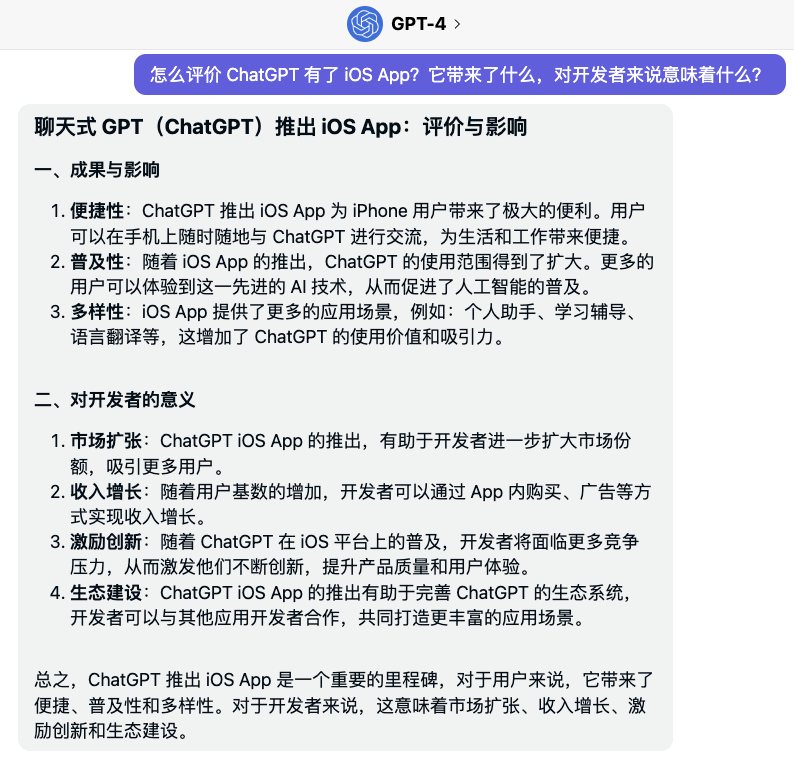

- Chat GPT(Generative Pre-trained Tansformer)一种生成式预训练模型。是一种基于互联网可用数据训练的文本生成深度学习模型。它用于问答、文本摘要生成、机器翻译、分类、代码生成和对话 AI。

- 是NLP领域一种语言模型,训练GTP-3投入了1200亿美元电费,上万GPU集群。OPENAI有微软投资的数据中心。

- NLP的训练,并非数据越多越好。参数越多,模型越复杂,答案越固定精准,泛化能力弱,不一定适应下游场景,不是ChatGPT的目标。

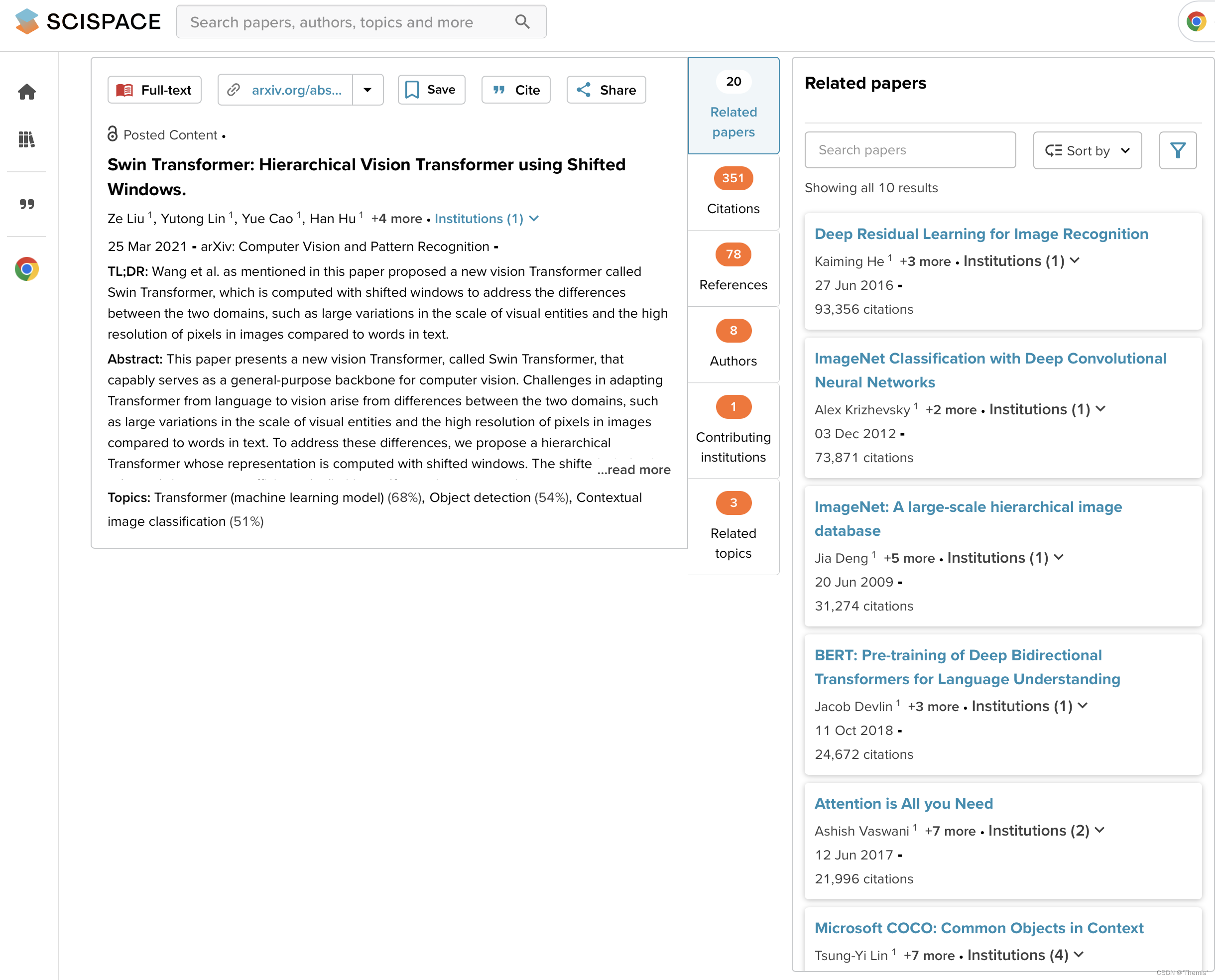

- 类似模型:BERT(已经有上下文,做完形填空);GPT(预测以后的事)

- GPT思想:统一NLP,做大模型,不再做具体领域的小模型。因NLP具备大模型先决条件:NLP中都是输入文本,输出也是文本,连续数据,CV则无法做到。

基本原理

- NLP模型:前文预测后面词的概率,更长的一句话再预测更后面的词,往后迭代。

- 损失函数就是预测下一词,整体架构是transformer解码器。

- GPT-1:所有下游任务都要微调、再训练,即预训练模型结合输出层做下一步任务的微调。

- GPT-2:

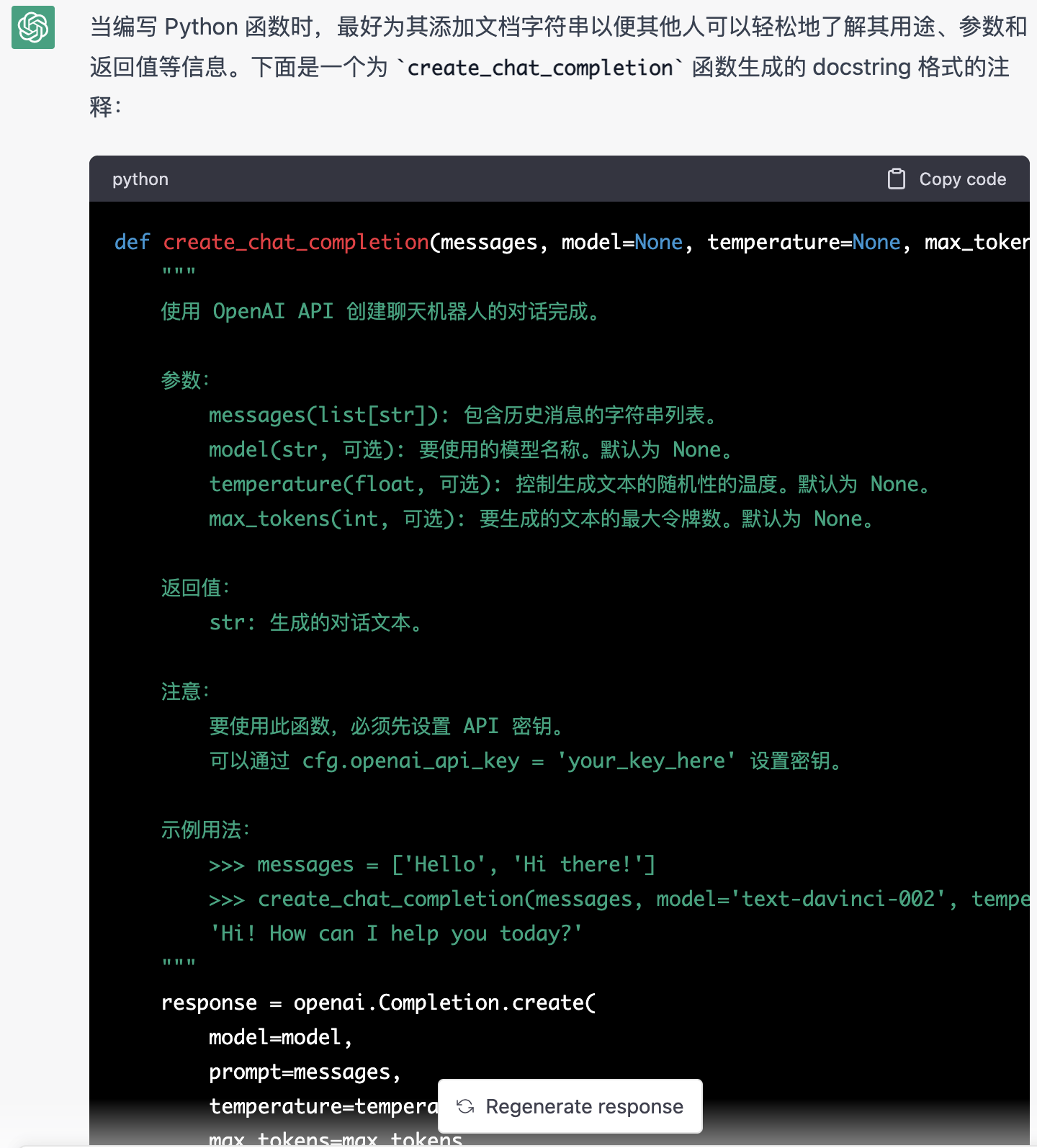

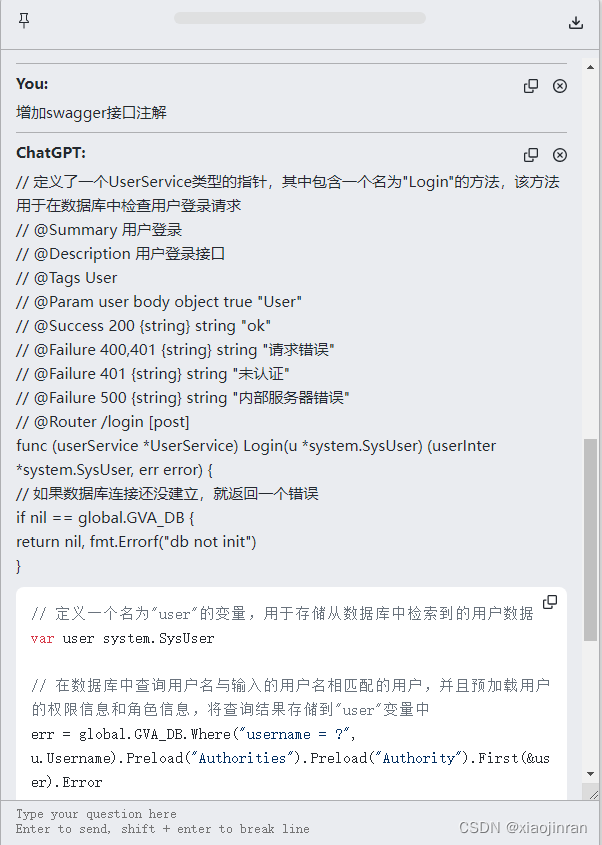

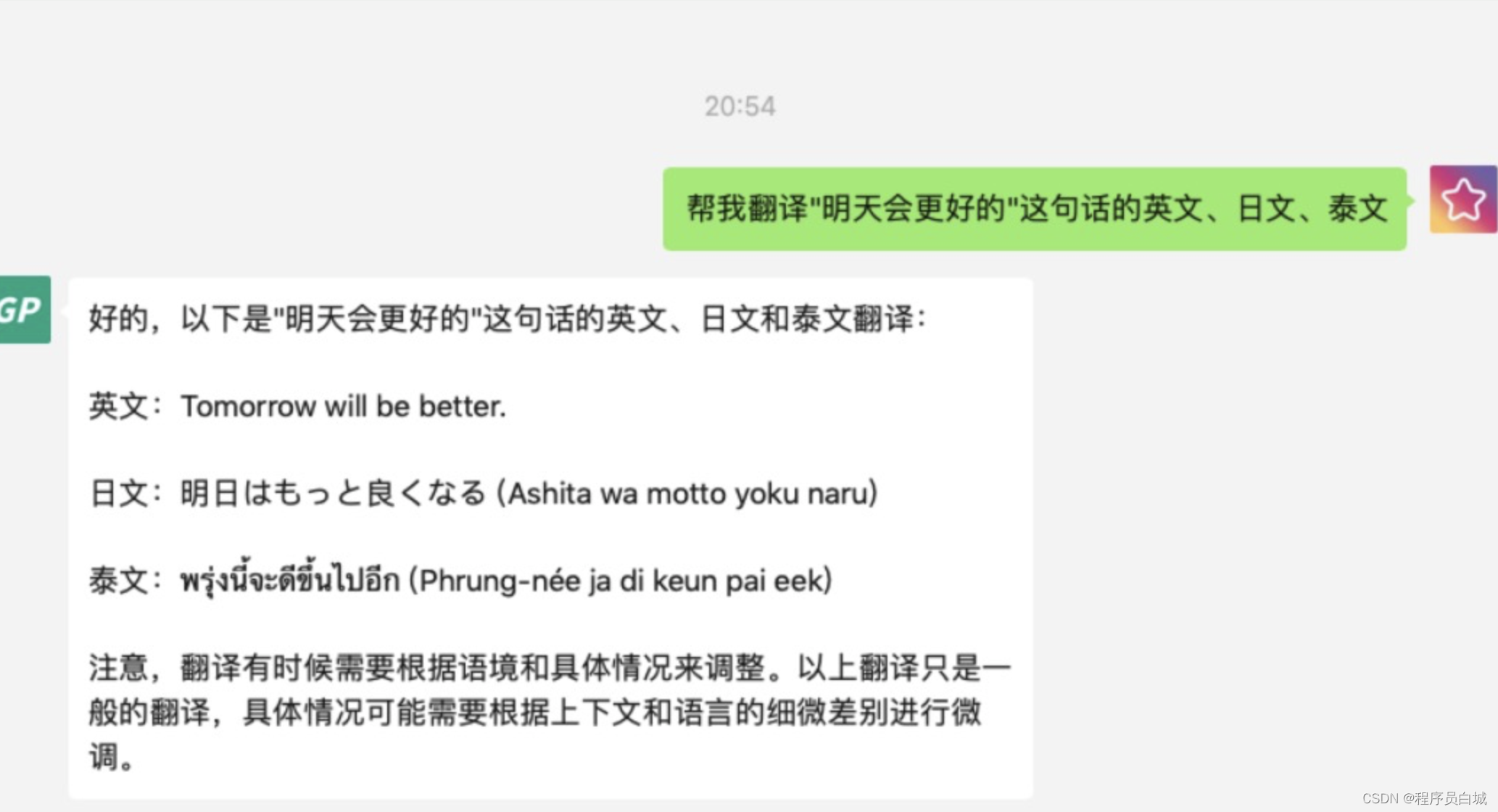

(1)zero-shot(零样本学习):模型训练网,下游任务不用再微调。但是下游任务很发散,很难一次训练好,从而以不变应万变,为此,需要+“暗示”,即在一句话后,加一句提示的话(如:这句话有多少单词?)下句话会根据暗示,聚焦范围。2代特点是模型更大,不再需要微调。

(2)采样策略改进:解决关键问题:改变采样策略,防止自回归模型陷入死循环,如:①成语接龙:一一得一,一一得一…②写作文:我干啥了然后,我xxx然后,我xxx然后…。为了增加模型多样性,Temperature策略对预测结果进行概率重设计。T>1多样性丰富,T<1精准答案。 - GPT-3:2020年,改变NLP格局,不开源。训练数据包罗万象,