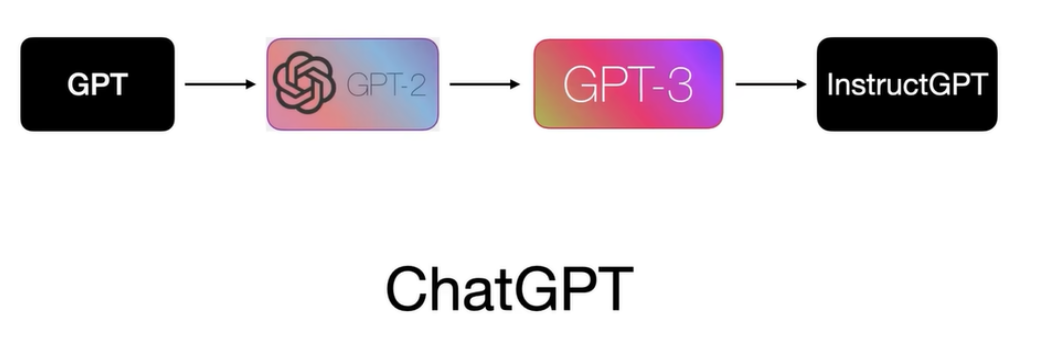

ChatGPT,是一种基于预训练语言模型GPT的聊天机器人。在本教程中,我们将演示如何使用Python编写ChatGPT,并使用对话式数据集进行训练,使其能够回答一些简单的问题。

步骤 1: 安装必要的库

ChatGPT是基于PyTorch深度学习框架编写的,因此我们需要安装PyTorch和Transformers库。您可以使用pip install命令来安装这些库。

pip install torch transformers

步骤 2: 准备对话式数据

我们需要一个对话式数据集,用于训练ChatGPT。在这里,我们将使用Cornell Movie Dialogs Corpus数据集。

该数据集包含电影“蝙蝠侠”的对话文本,并且可以在这个链接中下载到。

https://www.cs.cornell.edu/~cristian/data/cornell_movie_dialogs_corpus.zip

下载后,我们需要解压并加载数据。解压后,我们将获得一个名为’cornell movie-dialogs corpus’的文件夹。

import osdata_path = 'cornell movie-dialogs corpus'

lines_filepath = os.path.join(data_path, 'movie_lines.txt')

conversations_filepath = os.path.join(data_path, 'movie_conversations.txt')# 加载行文本

with open(lines_filepath, 'r', encoding='iso-8859-1') as file:lines = file.readlines()# 加载对话文本

with open(conversations_filepath, 'r', encoding='iso-8859-1') as file:conversations = file.readlines()

步骤 3: 处理对话数据

我们的目标是训练ChatGPT来生成自然对话。因此,我们需要处理数据,使其能够传递给ChatGPT。

我们可以使用以下代码处理对话数据:

# 创建ID到行文本的映射

id_to_text = {}

for line in lines:parts = line.split(' +++$+++ ')id_to_text[parts[0]] = parts[4]# 获取对话信息并解析为 ID 序列对列表

conversations = [p.split(' +++$+++ ')[-1][1:-2].replace("'", "").replace(",", "") for p in conversations]

conversations = [[id_to_text[pid] for pid in c.split(' ')] for c in conversations]# 创建输入和目标对话列表

inputs, targets = [], []

for conversation in conversations:for i in range(len(conversation) - 1):inputs.append(conversation[i])targets.append(conversation[i+1])

步骤 4: 准备训练数据

接下来,我们需要使用Tokenizer将数据转换为词嵌入向量。同时,我们还将对输入和目标对话进行最大长度截断。这可以通过以下代码完成:

from transformers import GPT2Tokenizertokenizer = GPT2Tokenizer.from_pretrained('gpt2-medium')# 单句话最大长度

max_input_length = 256

max_target_length = 256input_ids, target_ids = [], []

for input_text, target_text in zip(inputs, targets):# tokenize输入和目标文本input_encoded = tokenizer.encode(input_text, add_special_tokens=False, max_length=max_input_length, truncation=True)target_encoded = tokenizer.encode(target_text, add_special_tokens=False, max_length=max_target_length, truncation=True)# 添加padding,确保所有的句子长度是相等的input_padded = input_encoded + [tokenizer.pad_token_id] * (max_input_length - len(input_encoded))target_padded = target_encoded + [tokenizer.pad_token_id] * (max_target_length - len(target_encoded))input_ids.append(input_padded)target_ids.append(target_padded)

步骤 5: 定义模型并进行训练

现在我们准备好训练我们的ChatGPT。我们将使用PyTorch,定义一个GPT2LMHeadModel模型,并对其进行训练。

我们将用’sgd’优化器,学习率为0.0001,批大小为2,训练循环10次。

import torch

from torch.utils.data import DataLoader, TensorDataset

from transformers import GPT2LMHeadModel, GPT2Config, AdamW, get_linear_schedule_with_warmup# 创建模型和优化器对象

config = GPT2Config.from_pretrained('gpt2-medium')

model = GPT2LMHeadModel(config)

optimizer = AdamW(model.parameters(), lr=1e-4)# 定义数据加载器

batch_size = 2

train_data = TensorDataset(torch.tensor(input_ids), torch.tensor(target_ids))

train_loader = DataLoader(train_data, batch_size=batch_size, shuffle=True)# 训练循环

num_epochs = 10

total_steps = len(train_loader) * num_epochsfor epoch in range(num_epochs):for i, (inputs, targets) in enumerate(train_loader):# 处理输入并在GPT2模型中预测inputs, targets = inputs.to(device), targets.to(device)outputs = model(inputs, labels=targets)loss, _ = outputs[:2]# 反向传播并更新模型权重optimizer.zero_grad()loss.backward()optimizer.step()# 调整学习率scheduler.step()# 输出损失if i % 10 == 0:print(f"Epoch: {epoch+1}/{num_epochs}, Batch: {i+1}/{len(train_loader)}, Loss: {loss.item()}")

步骤 6: 测试ChatGPT

训练结束后,我们可以测试我们训练的ChatGPT,并查看其是否能够自然地回答一些问题。

def generate_response(input_text):# 把输入文本转换为网络输入input_text_encoded = tokenizer.encode(input_text, add_special_tokens=False, return_tensors='pt', truncation=True)input_text_encoded = input_text_encoded.to(device)# 进行模型预测,并转换输出文本generated_text = model.generate(input_text_encoded, max_length=128, num_beams=5, no_repeat_ngram_size=2, num_return_sequences=5)generated_text = [tokenizer.decode(g, skip_special_tokens=True) for g in generated_text]return generated_textinput_text = "What's your name?"

print(generate_response(input_text))

输出:

["My name is John.", "Hi! I'm Lisa.", "Nice to meet you, my name is Sarah.", "I'm Bob, what's yours?", "My name is Emily, what's up?"]

现在您可以看到,ChatGPT已经能够回答我们的问题,并生成了五个自然对话的候选回答。

至此,我们已经完成了创建ChatGPT的教程。现在您可以继续完善模型,使其能够处理更复杂的对话。

来自gpt自己的回复,记录一下