文章目录

- 前言

- 一、GPT的起源

- GPT系列

- 二、GPT的原理

- 1. GPT原理:自注意

- 2. GPT原理:位置编码

- 3. GPT原理:Masked Language Modeling

- 4. GPT原理:预训练

- 5. GPT原理:微调

- 6. GPT原理:多任务学习

- 三、GPT模型的风险与挑战

- 总结

前言

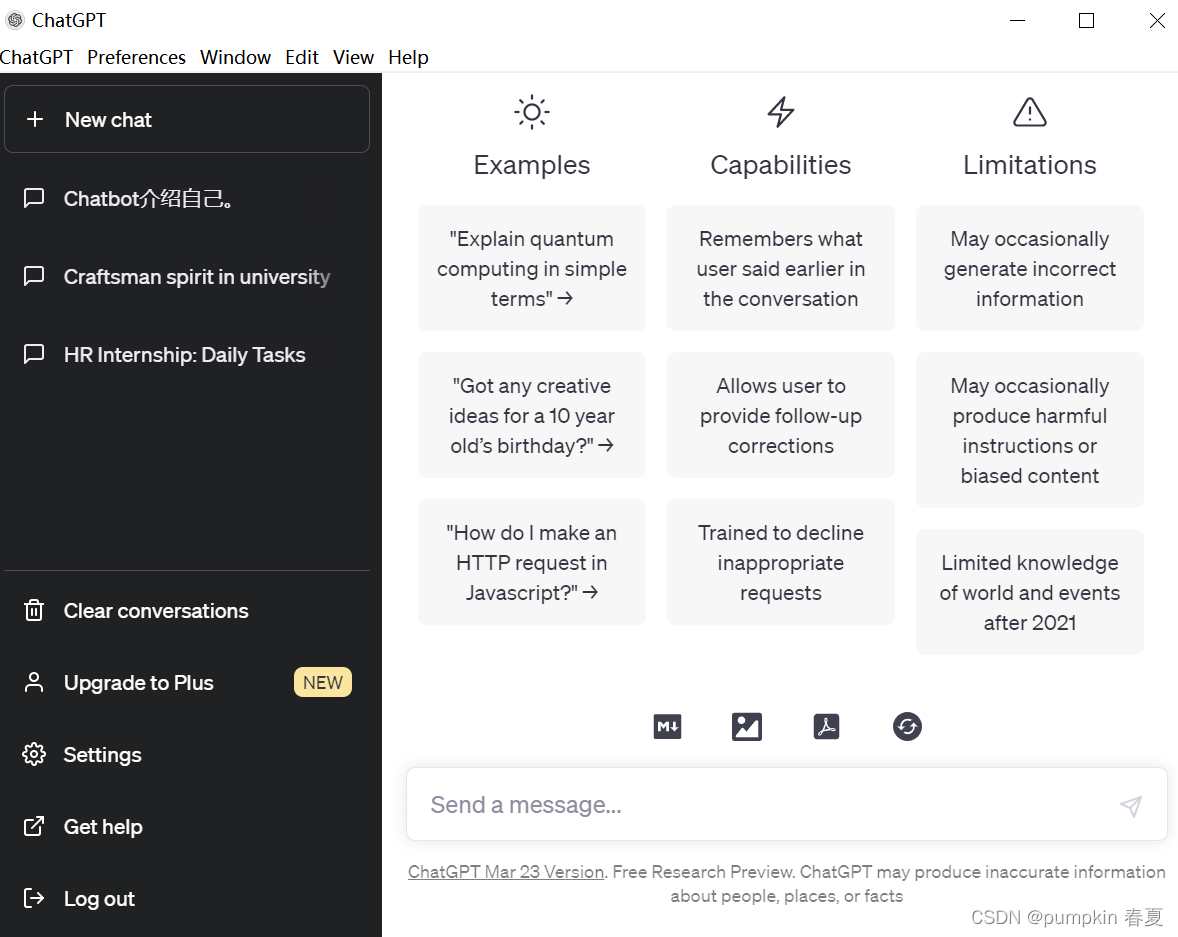

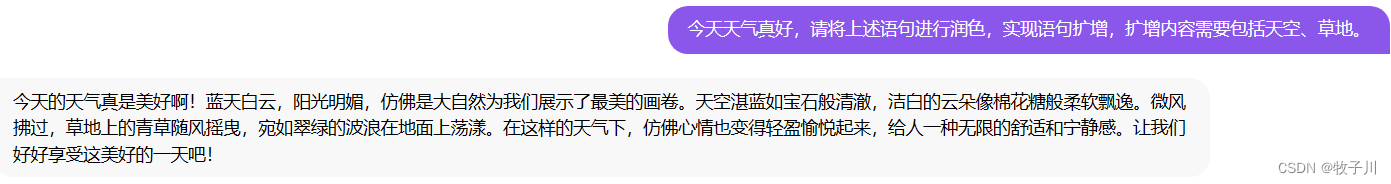

ChatGPT发展到目前,其实网上已经有大量资料了,博主做个收口,会出一个ChatGPT探索系列的文章,帮助大家深入了解ChatGPT的。整个系列文章会按照一下目标来完成:

- 理解ChatGPT的背景和应用领域;

- 学习GPT模型系列的发展历程和原理;

- 探究ChatGPT的训练、优化和应用方法;

- 分析ChatGPT在各领域的实际案例;

- 讨论人工智能伦理问题及ChatGPT的责任;

- 思考ChatGPT的未来发展趋势和挑战。

本次ChatGPT探索系列之一的主题是GPT模型系列的发展历程和原理。在本文中,我们将深入探讨GPT(Generative Pre-trained Transformer)模型系列的发展历程和原理,作为ChatGPT探索系列的一部分。GPT模型已经彻底改变了自然语言处理(NLP)的方式,允许生成的内容越来越难以区分是由人类还是AI生成的。

如果对ChatGPT相关资料感兴趣的同学,可以直接访问开源资料库:ChatGPT_Project

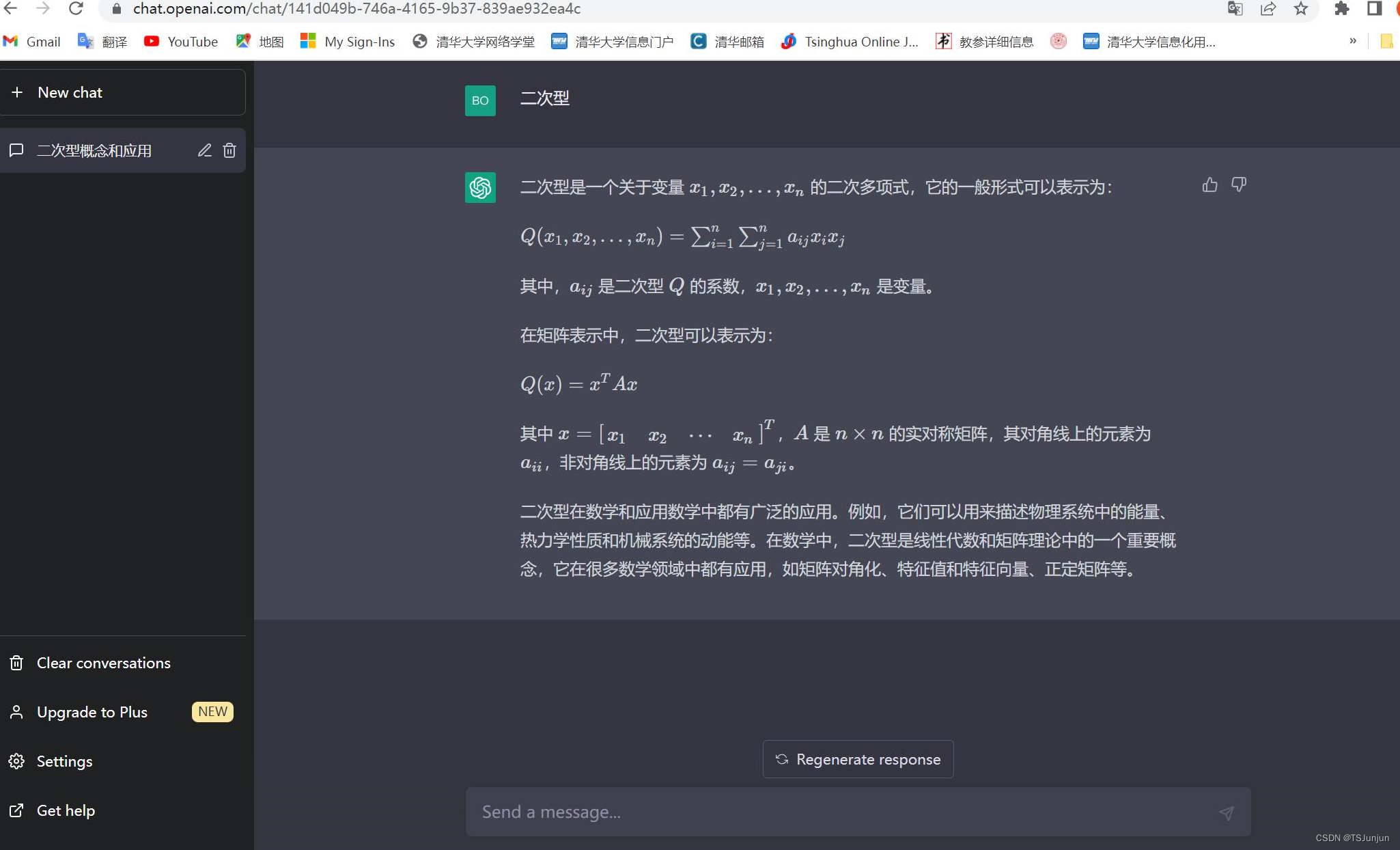

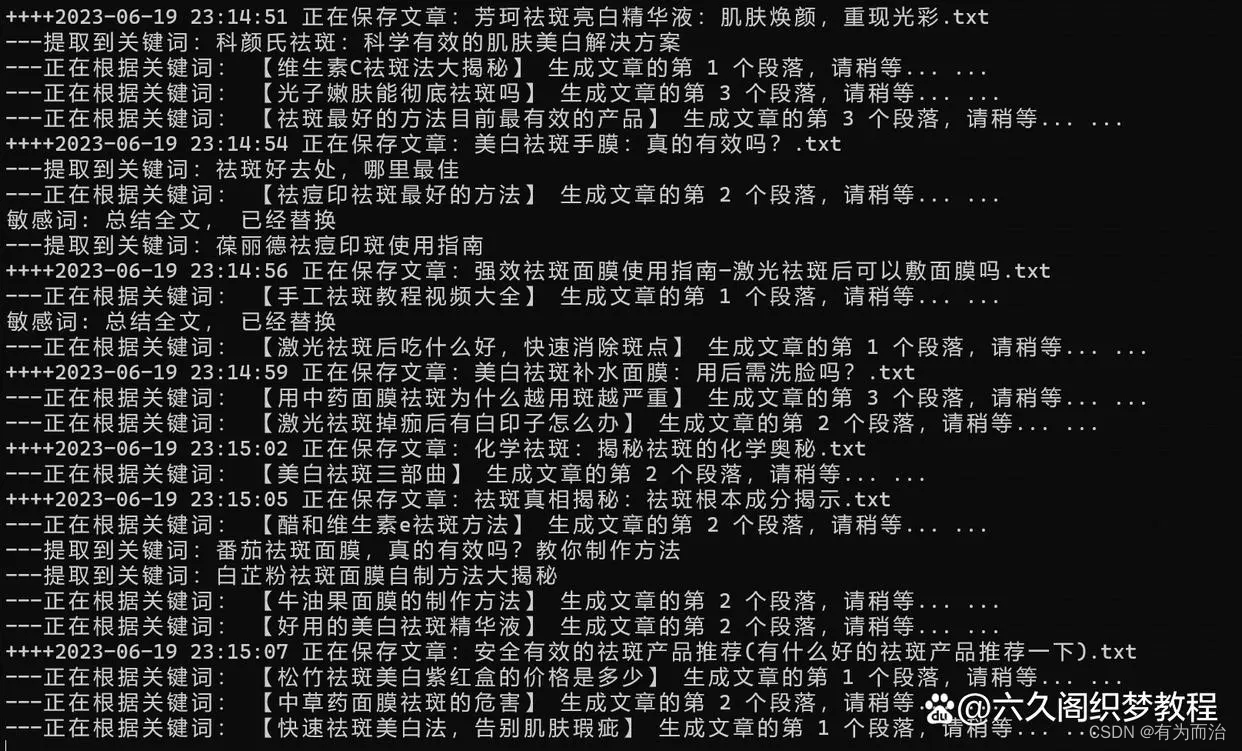

一、GPT的起源

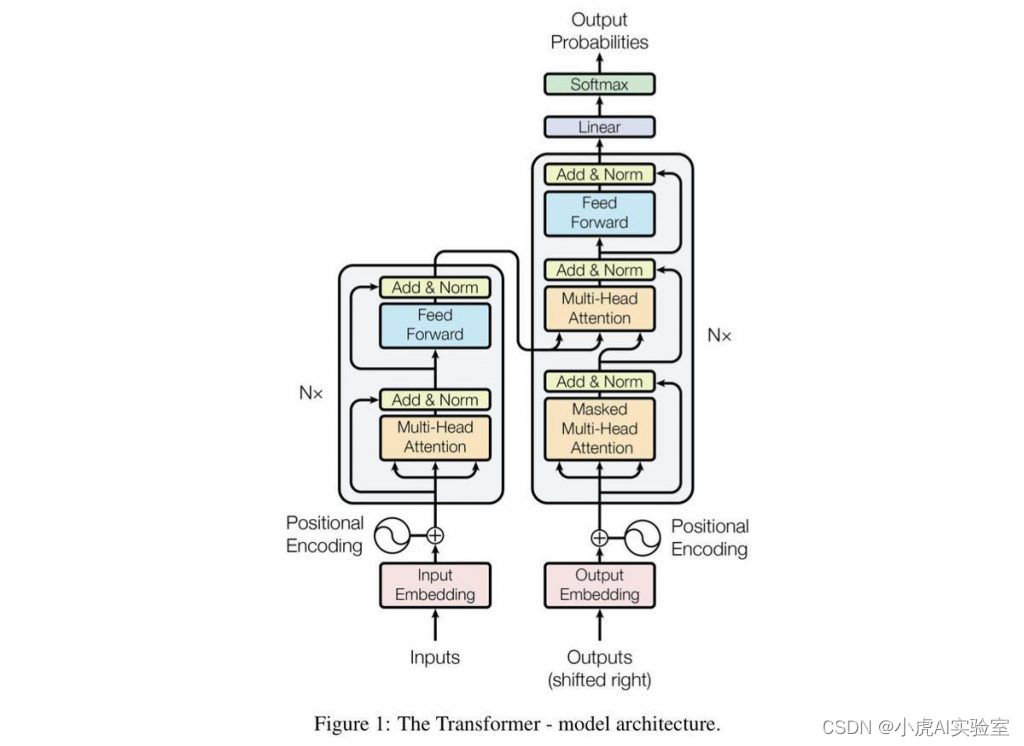

在深入探讨GPT模型的细节之前,了解它诞生的历史背景非常重要。2017年,谷歌的一组研究人员发布了一篇关于神经机器翻译的重要论文,名为“Attention is All You Need”。这篇论文引入了一种新的深度学习模型类型,称为Transformer,如上图所示,后来成为GPT系列的支柱。

与以前的模型相比,Transformer模型有几个优点,最显著的是能够处理长序列的文本。这使得它非常适合像语言建模这样的任务,其中模型被训练以预测在一个句子中出现给定单词或短语的可能性。

在Transformer论文发布后不久,OpenAI的研究人员开始研发一种新的语言模型,利用Transformer的强大能力。这个模型被称为GPT,即Generative Pre-trained Transformer。

GPT系列

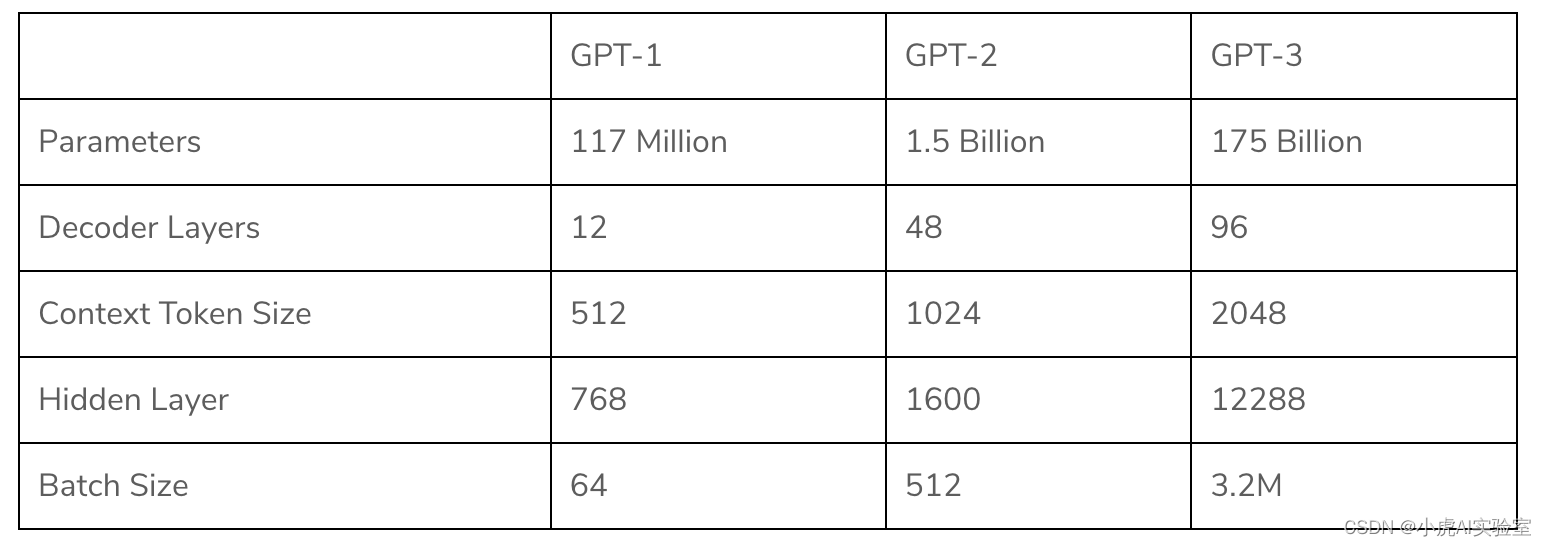

最初的GPT模型,GPT-1,于2018年6月发布。它被训练在包括维基百科在内的互联网上的大量文本语料库中,能够根据给定的提示生成连贯、符合语法规则的文本。然而,它也容易生成无意义或重复的文本,并且并不总是能够保持话题一致。

尽管存在这些局限性,GPT-1对NLP领域来说是一个重要的飞跃。它表明神经网络可以被训练生成在许多情况下难以区分是否为人类写作的文本。这是一个重大突破,引发了大量研究来改进GPT模型。

GPT模型的下一个版本,GPT-2,于2019年2月发布。该模型比前一个版本大得多,参数数量从GPT-1的117 million增加到15亿。它被训练在更大的文本语料库上,并能够生成比GPT-1更连贯、话题一致的文本。

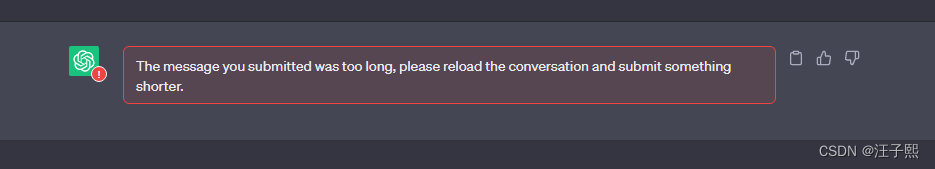

然而,由于对模型潜在的滥用(例如生成假新闻或宣传)的担忧,OpenAI决定不向公众发布GPT-2的完整版本。相反,他们发布了一个更小、功效较弱的版本,虽然仍然能够生成令人印象深刻的文本,但使用它进行恶意用途的可能性较小。

GPT-3,于2020年6月发布。它是迄今为止最大、最强大的GPT模型,拥有1750亿个参数。它被训练在互联网上的大量文本语料库上,并能够执行广泛的任务,包括语言翻译、问答和甚至编写计算机代码。

GPT-3被誉为NLP领域的一个重大突破,引发了一波激动人心和创新的浪潮。然而,它也引发了关于利用AI生成文本进行恶意用途(例如创建深度伪造视频或传播错误信息)的担忧。

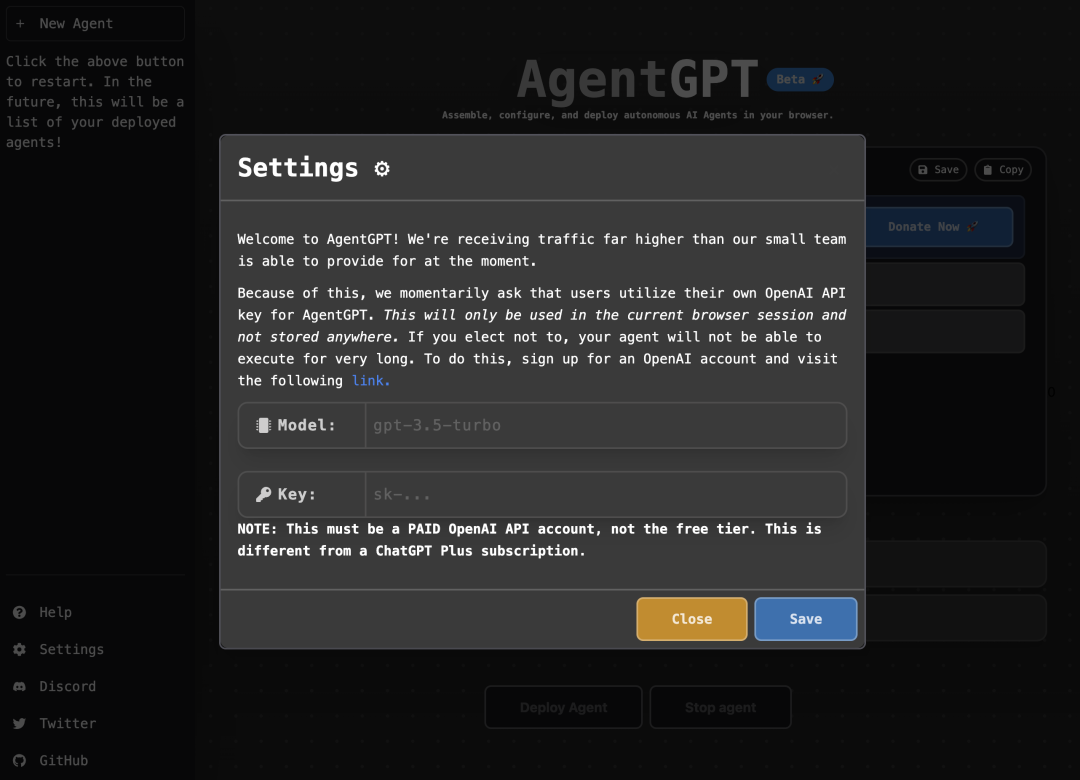

如上图所示GPT-1至GPT-3模型原理基本一致,但是模型参数飞速扩张。

GPT模型的最新版本是GPT-4,在本文中,我们不详细介绍了,GPT-4具体介绍可以看我写的另一篇博客:宇宙最强-GPT-4 横空出世:最先进、更安全、更有用。目前GPT-1至GPT-3都是开源的,因此对于模型的原理,本文主要聚焦在GPT-1、GPT-2、GPT-3。

二、GPT的原理

GPT(Generative Pre-trained Transformer)是一种神经网络模型,用于处理自然语言处理(NLP)任务。它通过训练来预测在一个句子中出现给定单词或短语的可能性,进而生成符合语法规则、连贯的文本。

在GPT模型中,核心是Transformer模型,通过一种叫做自注意力(self-attention)的机制来学习长序列之间的关系。自注意力允许模型在计算每个标记的表示时考虑到所有其他标记的表示,这使得模型能够在长序列中进行信息传递,从而更好地理解上下文和句子的结构。

除了自注意力机制外,GPT还包括一个叫做位置编码(position encoding)的技术,它在表示每个标记时考虑其在序列中的位置。这允许模型在序列中建立有序的关系,从而更好地理解序列中各个部分之间的关系。

最后,GPT还采用了一种叫做Masked Language Modeling(MLM)的技术来训练模型。在MLM中,模型被要求预测给定句子中一些标记的位置,这些标记被随机地遮盖住。这迫使模型不仅考虑到当前标记,还要考虑到整个句子的其他部分,从而更好地理解上下文。

下面我们将从自注意力、位置编码、MLM、预训练、微调、多任务学习六个方面详细介绍GPT的原理。

1. GPT原理:自注意

自注意力是GPT模型的核心,它是一种处理长序列的文本的机制。自注意力机制使得模型能够在计算每个标记的表示时考虑到所有其他标记的表示,这使得模型能够在长序列中进行信息传递,从而更好地理解上下文和句子的结构。

自注意力机制包含三个重要的步骤:查询(query)、键(key)和值(value)。对于每个标记,模型通过查询向量计算所有键向量的权重,以得出该标记的最终表示。这个过程可以用矩阵运算来表示,如下所示:

A t t e n t i o n ( Q , K , V ) = s o f t m a x ( Q K T d k ) V Attention(Q, K, V) = softmax(\frac{QK^T}{\sqrt{d_k}})V Attention(Q,K,V)=softmax(dkQKT)V

其中, Q Q Q是查询向量, K K K是键向量, V V V是值向量, d k d_k dk是向量的维度。通过将 Q Q Q与 K K K相乘,然后除以 d k d_k dk的平方根,可以计算出每个查询与每个键之间的相似度。这些相似度经过softmax函数,然后与值向量相乘,以得出最终的表示。

值得注意的是,自注意力机制允许模型根据文本中各个标记的相互关系来进行建模。它能够自动关注与当前标记相关的其他标记,而无需手动指定或预测。这使得模型能够在处理长序列文本时,准确地捕捉到文本的结构和语义。

2. GPT原理:位置编码

位置编码是GPT模型中另一个重要的组成部分。它通过在表示每个标记时考虑其在序列中的位置,来允许模型在序列中建立有序的关系,从而更好地理解序列中各个部分之间的关系。

具体来说,位置编码使用三角函数来表示每个标记的位置。对于序列中的每个标记 i i i,位置编码会将其表示为一个 d d d维向量,其中每个维度都被表示为以下形式的函数:

P E ( p o s , 2 i ) = s i n ( p o s / 1000 0 2 i / d ) PE_{(pos,2i)}=sin(pos/10000^{2i/d}) PE(pos,2i)=sin(pos/100002i/d)

P E ( p o s , 2 i + 1 ) = c o s ( p o s / 1000 0 2 i / d ) PE_{(pos,2i+1)}=cos(pos/10000^{2i/d}) PE(pos,2i+1)=cos(pos/100002i/d)

其中, p o s pos pos是标记在序列中的位置, i i i是向量中维度的索引, d d d是向量的维度。这个公式表明,对于每个位置和每个维度,位置编码会对该位置的表示添加一个周期性的偏移量。这个偏移量的幅度和周期会随着维度的变化而变化,使得每个维度都能够编码不同的周期性模式。

3. GPT原理:Masked Language Modeling

Masked Language Modeling(MLM)是GPT模型的另一个关键组成部分。在MLM中,模型被要求预测给定句子中一些标记的位置,这些标记被随机地遮盖住。这迫使模型不仅考虑到当前标记,还要考虑到整个句子的其他部分,从而更好地理解上下文。

具体来说,MLM训练使用了一个损失函数,该函数计算模型对被遮盖标记的预测与实际标记的差距。对于每个句子,模型会将其中一些标记遮盖住,然后预测这些被遮盖标记的内容。这使得模型需要根据上下文和语法规则,从句子中推断出被遮盖标记的内容。如果预测结果与实际标记不符,则会计算出损失并进行反向传播,以调整模型的参数。

MLM训练允许模型从大量的文本语料库中学习通用的语言知识,并将这些知识应用到其他NLP任务中。

4. GPT原理:预训练

GPT模型通过预训练来学习通用的语言知识,从而能够应用到各种NLP任务中。在预训练期间,模型通过阅读大量的文本语料库,学习通用的语言规则和知识,从而能够在NLP任务中进行更好的表现。

具体来说,GPT模型使用了一种叫做无监督学习的方法,该方法不需要手动注释或标记数据。在预训练期间,模型被要求根据给定的文本预测下一个标记的内容。这使得模型需要学习文本的语法规则、上下文信息和语义表示,从而更好地理解和生成文本。

预训练是GPT模型的核心,它使得模型能够具有通用性和可迁移性,能够在各种NLP任务中进行良好的表现。

5. GPT原理:微调

除了预训练外,微调也是GPT模型的重要组成部分。微调是指在特定的NLP任务中对预训练模型进行微调,从而适应特定任务的特征和需求。

具体来说,微调通常会涉及将模型的输出层更改为适应特定任务的输出格式。然后,模型将在特定的任务数据集上进行微调,以调整模型参数以适应该任务。微调使得模型能够在不同的NLP任务中进行适应性表现,从而提高了模型的应用价值和效率。

6. GPT原理:多任务学习

多任务学习是一种通过训练模型解决多个任务来提高模型效率的方法。GPT模型也可以通过多任务学习来进一步提高其表现和效率。

具体来说,多任务学习要求模型解决多个任务,如文本分类、语言推理、命名实体识别等,同时共享预训练过程中学到的通用语言知识。这使得模型能够在多个任务中进行并行处理,并共享训练数据和知识表示。多任务学习使得模型能够更好地利用预训练的语言知识,从而提高模型的效率和性能。

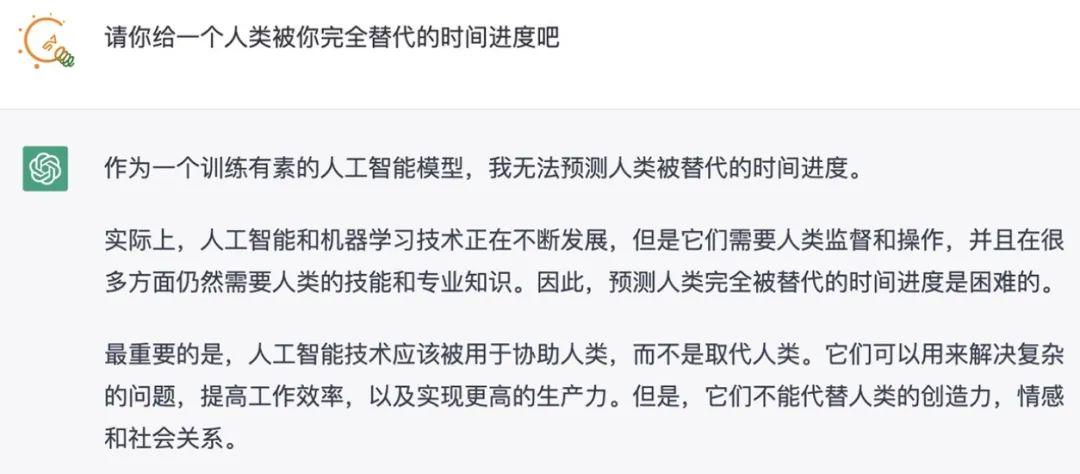

三、GPT模型的风险与挑战

随着GPT模型在NLP领域的广泛应用和发展,也带来了一些新的风险和挑战。其中最重要的问题之一是模型的可解释性和可信度。

首先,由于GPT模型具有非常强的学习能力和泛化能力,它可以在许多NLP任务中达到甚至超越人类水平的表现。但是,模型的高效性和黑盒特性也使得模型的决策过程和推理过程难以解释和理解。这给模型的应用带来了一些风险和挑战,如模型的隐私和安全问题。如果模型的决策和推理过程不能够被解释和理解,那么模型的可信度和可靠性就会受到质疑,这可能会导致一些重要的风险和问题。

其次,GPT模型的生成能力也可能带来一些风险和挑战。由于GPT模型具有很强的生成能力,它可以用于生成各种类型的文本,包括虚假新闻、仇恨言论等。这可能对社会和公共舆论产生负面影响。例如,模型可以被用于自动产生虚假新闻,从而影响公众的意见和决策。另外,由于模型的生成能力,也可能会带来一些道德和法律问题,例如模型生成的文本可能涉及侵犯他人隐私、诽谤、诈骗等行为。

第三,GPT模型还面临一些社会和伦理问题。由于模型的广泛应用和影响力,它可能会对人类社会和文化产生重要的影响。例如,模型可能会被用于过度监视和控制公众,从而侵犯人权和自由。另外,由于模型的算法和数据训练的偏见,也可能会导致模型在某些情况下产生歧视和不公平的结果。这些问题需要我们认真思考和解决,以确保AI技术的可持续性和道德性。

总结

在本文中主要介绍了GPT模型的发展历程和原理,以及GPT模型面临的一些挑战和风险。文章首先介绍了GPT模型的基本架构和组成部分,包括自注意力机制、位置编码和Masked Language Modeling等技术。然后,文章介绍了GPT模型的一些关键技术和应用,如预训练、微调和多任务学习。这些技术使得GPT模型能够在各种NLP任务中表现出色,并具有广泛的应用前景。

然而,GPT模型也面临的一些挑战和风险。其中最重要的问题之一是模型的可解释性和可信度。模型的高效性和黑盒特性也使得模型的决策过程和推理过程难以解释和理解,这给模型的应用带来了一些风险和挑战,如模型的隐私和安全问题。另外,GPT模型的生成能力也可能带来一些风险和挑战,例如虚假新闻和仇恨言论等。同时,GPT模型还面临一些社会和伦理问题,例如人权和自由问题,算法偏见和歧视问题等。

GPT模型是一种非常有前途的NLP模型,它已经在各种任务中表现出色,并具有广泛的应用前景。但是,我们也需要注意和解决其可能带来的问题和挑战,以确保其可持续性和可靠性。我们需要为GPT模型设定明确的目标和标准,以确保它能够为人类带来积极的影响,并且需要认真思考如何在利用GPT模型的同时,确保AI技术的可持续性和道德性。