数据的实时同步

在生产环境,有时会需要两台主机的特定目录实现实时同步。比如,将NFS共享目录的数据文件,自动实时同步到备份的服务器特定目录中。

数据的实时同步有两种方式:

1. 实时同步的技术

1.1 实现方法:

- inotify + rsync 方式实现数据同步

- sersync :金山公司周洋在 inotify 软件基础上进行开发的,功能更加强大

1.2 工作原理

- 要利用监控服务(inotify),监控同步数据服务器目录中信息的变化

- 发现目录中数据产生变化,就利用rsync服务推送到备份服务器上

1.3 inotify

异步的文件系统事件监控机制,利用事件驱动机制,而无须通过诸如cron等的轮询机制来获取事件,linux内核从2.6.13起支持 inotify,通过inotify可以监控文件系统中添加、删除,修改、移动等各种事件

2. 实现 inotify

2.1 内核支持

Linux支持inotify的内核最小版本为 2.6.13,参看man 7 inotify

查看当前内核是否加载inotify:

[root@centos8 ~]# grep -i inotify /boot/config-4.18.0-80.el8.x86_64

CONFIG_INOTIFY_USER=y

查看是否支持:

[root@centos8 ~]# ll /proc/sys/fs/inotify/

total 0

-rw-r--r-- 1 root root 0 Dec 23 10:06 max_queued_events

-rw-r--r-- 1 root root 0 Dec 23 10:06 max_user_instances

-rw-r--r-- 1 root root 0 Dec 23 10:06 max_user_watches

2.1.1 inotify内核参数说明:

- max_queued_events:inotify事件队列最大长度,如值太小会出现 Event Queue Overflow 错误,默认值:16384

- max_user_instances:每个用户创建inotify实例最大值,默认值:128

- max_user_watches:可以监视的文件数量(单进程),默认值:8192

2.2 inotify-tools工具

安装inotify-tools:基于epel源

[root@centos8 ~]# yum install inotify-tools

2.2.1 inotify-tools包主要工具:

- inotifywait: 在被监控的文件或目录上等待特定文件系统事件(open ,close,delete等)发生,常用于实时同步的目录监控

- inotifywatch:收集被监控的文件系统使用的统计数据,指文件系统事件发生的次数统计

2.2.2 inotifywait 命令常见选项

- -m, --monitor 始终保持事件监听

- -d, --daemon 以守护进程方式执行,和-m相似,配合-o使用

- -r, --recursive 递归监控目录数据信息变化

- -q, --quiet 输出少量事件信息

- –exclude 指定排除文件或目录,使用扩展的正则表达式匹配的模式实现

- –excludei 和exclude相似,不区分大小写

- -o, --outfile 打印事件到文件中,相当于标准正确输出,注意:使用绝对路径

- -s, --syslogOutput 发送错误到syslog相当于标准错误输出

- –timefmt 指定时间输出格式

- –format 指定的输出格式;即实际监控输出内容

- -e 指定监听指定的事件,如果省略,表示所有事件都进行监听

2.2.3 --timefmt 时间格式

- %Y 年份信息,包含世纪信息

- %y 年份信息,不包括世纪信息

- %m 显示月份,范围 01-12

- %d 每月的第几天,范围是 01-31

- %H 小时信息,使用 24小时制,范围 00-23

- %M 分钟,范围 00-59

范例:

--timefmt "%Y-%m-%d %H:%M"

2.2.4 --format 格式定义

- %T 输出时间格式中定义的时间格式信息,通过 --timefmt option 语法格式指定时间信息

- %w 事件出现时,监控文件或目录的名称信息

- %f 事件出现时,将显示监控目录下触发事件的文件或目录信息,否则为空

- %e 显示发生的事件信息,不同的事件默认用逗号分隔

- %Xe显示发生的事件信息,不同的事件指定用X进行分隔

2.2.5 inotifywait -e 选项指定的事件类型

- create 文件或目录创建

- delete 文件或目录被删除

- modify 文件或目录内容被写入

- attrib 文件或目录属性改变

- close_write 文件或目录关闭,在写入模式打开之后关闭的

- close_nowrite 文件或目录关闭,在只读模式打开之后关闭的

- close 文件或目录关闭,不管读或是写模式

- open 文件或目录被打开

- moved_to 文件或目录被移动到监控的目录中

- moved_from 文件或目录从监控的目录中被移动

- move 文件或目录不管移动到或是移出监控目录都触发事件

- access 文件或目录内容被读取

- delete_self 文件或目录被删除,目录本身被删除

- unmount 取消挂载

范例:使用inotifywait

#监控一次性事件

inotifywait /data#持续前台监控

inotifywait -mrq /data#持续后台监控,并记录日志

inotifywait -o /root/inotify.log -drq /data --timefmt "%Y-%m-%d %H:%M" --format "%T %w%f event: %e"#持续前台监控特定事件

inotifywait -mrq /data --timefmt "%F %H:%M" --format "%T %w%f event: %;e" -e

create,delete,moved_to,close_write,attrib

3. rsync

rsync 常用于做为 linux系统下的数据镜像备份工具,实现实现远程同步,支持本地复制,或者与其他SSH、rsync主机同步数据,支持增量备份,配合任务计划,rsync能实现定时或间隔同步,配合inotify或sersync,可以实现触发式的实时数据同步

3.1 rsync介绍

- 软件包:rsync,rsync-daemon(CentOS 8)

- 服务文件:/usr/lib/systemd/system/rsyncd.service

- 配置文件:/etc/rsyncd.conf

- 端口:873/tcp

3.2 rsync命令

3.2.1 rsync的三种工作模式

- 本地文件系统上实现同步。命令行语法格式为上述"Local"段的格式。

- 本地主机使用远程shell和远程主机通信。命令行语法格式为上述"Access via remote shell"段的格式。

- 本地主机通过网络套接字连接远程主机上的rsync daemon。命令行语法格式为上述"Access via rsync daemon"段的格式。

前两者的本质是通过本地或远程shell,而第3种方式则是让远程主机上运行rsyncd服务,使其监听在一个端口上,等待客户端的连接。

3.2.2 常见配置

-v:显示rsync过程中详细信息。可以使用"-vvvv"获取更详细信息。

-P:显示文件传输的进度信息。(实际上"-P"="--partial --progress",其中的"--progress"才是显示进度信息的)。

-n --dry-run :仅测试传输,而不实际传输。常和"-vvvv"配合使用来查看rsync是如何工作的。

-a --archive :归档模式,表示递归传输并保持文件属性。等同于"-rtopgDl"。

-r --recursive:递归到目录中去。

-t --times:保持mtime属性。强烈建议任何时候都加上"-t",否则目标文件mtime会设置为系统时间,导致下次更新:检查出mtime不同从而导致增量传输无效。

-o --owner:保持owner属性(属主)。

-g --group:保持group属性(属组)。

-p --perms:保持perms属性(权限,不包括特殊权限)。

-D :是"--device --specials"选项的组合,即也拷贝设备文件和特殊文件。

-l --links:如果文件是软链接文件,则拷贝软链接本身而非软链接所指向的对象

-z :传输时进行压缩提高效率

-R --relative:使用相对路径。意味着将命令行中指定的全路径而非路径最尾部的文件名发送给服务端,包括它们的属性。用法见下文示例。

--size-only :默认算法是检查文件大小和mtime不同的文件,使用此选项将只检查文件大小。

-u --update :仅在源mtime比目标已存在文件的mtime新时才拷贝。注意,该选项是接收端判断的,不会影响删除行为。

-d --dirs :以不递归的方式拷贝目录本身。默认递归时,如果源为"dir1/file1",则不会拷贝dir1目录,使用该选项将拷贝dir1但不拷贝file1。

--max-size :限制rsync传输的最大文件大小。可以使用单位后缀,还可以是一个小数值(例如:"--max-size=1.5m")

--min-size :限制rsync传输的最小文件大小。这可以用于禁止传输小文件或那些垃圾文件。

--exclude :指定排除规则来排除不需要传输的文件。

--delete :以SRC为主,对DEST进行同步。多则删之,少则补之。注意"--delete"是在接收端执行的,所以它是在:exclude/include规则生效之后才执行的。

-b --backup :对目标上已存在的文件做一个备份,备份的文件名后默认使用"~"做后缀。

--backup-dir:指定备份文件的保存路径。不指定时默认和待备份文件保存在同一目录下。

-e :指定所要使用的远程shell程序,默认为ssh。

--port :连接daemon时使用的端口号,默认为873端口。

--password-file:daemon模式时的密码文件,可以从中读取密码实现非交互式。注意,这不是远程

shell认证的密码,而是rsync模块认证的密码。

-W --whole-file:rsync将不再使用增量传输,而是全量传输。在网络带宽高于磁盘带宽时,该选项比增量传输更高效。

--existing :要求只更新目标端已存在的文件,目标端还不存在的文件不传输。注意,使用相对路径时如果上层目录不存在也不会传输。

--ignore-existing:要求只更新目标端不存在的文件。和"--existing"结合使用有特殊功能,见下文示例。

--remove-source-files:要求删除源端已经成功传输的文件

3.3 以独立服务方式运行rsync

#创建rsync服务器的配置文件

[root@centos7 ~]# vim /etc/rsyncd.conf

uid = root

gid = root

use chroot = no

max connections = 0

ignore errors

exclude = lost+found/

log file = /var/log/rsyncd.log

pid file = /var/run/rsyncd.pid

lock file = /var/run/rsyncd.lock

reverse lookup = no

hosts allow = 192.168.38.0/24 #要修改允许访问的ip,不然会报错

[backup]

path = /backup/

comment = backup

read only = no

auth users = rsyncuser

secrets file = /etc/rsync.pass#服务器端准备目录

[root@centos7 ~]# mkdir /backup #服务器端生成验证文件

[root@centos7 ~]# echo "rsyncuser:magedu" > /etc/rsync.pass

[root@centos7 ~]# chmod 600 /etc/rsync.pass#服务器端启动rsync服务

[root@centos7 ~]# rsync --daemon #可加入/etc/rc.d/rc.local实现开机启动

[root@centos7 ~]# systemctl start rsyncd #CentOS 7 以上版本#客户端配置密码文件

[root@centos7 ~]# echo "magedu" > /etc/rsync.pass

[root@centos7 ~]# chmod 600 /etc/rsync.pass#客户端测试同步数据

[root@centos7 ~]# rsync -avz --delete --password-file=/etc/rsync.pass rsyncuser@192.168.38.107::backup

receiving incremental file list

drwxr-xr-x 4,096 2019/12/23 10:46:08 .

-rw-r--r-- 5 2019/12/23 10:46:37 test.txtsent 20 bytes received 66 bytes 172.00 bytes/sec

total size is 5 speedup is 0.06

3.4 创建inotify_rsync.sh脚本

#!/bin/bash

SRC='/data/'

DEST='rsyncuser@rsync服务器IP::backup'

inotifywait -mrq --timefmt '%Y-%m-%d %H:%M' --format '%T %w %f' -e

create,delete,moved_to,close_write,attrib ${SRC} |while read DATE TIME DIR FILE;doFILEPATH=${DIR}${FILE}rsync -az --delete --password-file=/etc/rsync.pass $SRC $DEST && echo "At ${TIME} on ${DATE}, file $FILEPATH was backuped up via rsync" >> /var/log/changelist.log

done

3.5 实战案例:实现基于分布式的LAMP架构,并将NFS实时同步到备份服务器

上次已经实现基于nfs的lamp架构,现在要增加rsync服务器,实现nfs服务器的自动备份

服务器端是centos7服务器,客户端是nfs服务器

在nfs服务器(客户端)上:

#安装rsync包

[root@centos8 ~]# yum install rsync-daemon.noarch -y

[root@centos8 ~]# yum install inotify-tools -y#修改rsync配置文件

[root@centos8 ~]# vim /etc/rsyncd.conf

uid = root

gid = root

use chroot = no

max connections = 0

ignore errors

exclude = lost+found/

log file = /var/log/rsyncd.log

pid file = /var/run/rsyncd.pid

lock file = /var/run/rsyncd.lock

reverse lookup = no

hosts allow = 192.168.38.0/24

[backup]

path = /backup/

comment = backup

read only = no

auth users = rsyncuser

secrets file = /etc/rsync.pass#在服务器端生成验证文件

[root@centos7 ~]# echo "rsyncuser:magedu" > /etc/rsync.pass

[root@centos7 ~]# chmod 600 /etc/rsync.pass

#启动客户端服务

[root@centos7 ~]# systemctl enable --now rsyncd#客户端配置密码文件

[root@centos8 data]# echo "magedu" > /etc/rsync.pass

[root@centos8 data]# chmod 600 /etc/rsync.pass #此为必要项#编写inotify_rsync.sh脚本

[root@centos8 ~]# vim inotify_raync.sh #!/bin/bash

SRC='/data/wordpress'

DEST='rsyncuser@192.168.38.107::backup'

inotifywait -mrq --timefmt '%Y-%m-%d %H:%M' --format '%T %w %f' -e create,delete,moved_to,close_write,attrib ${SRC} | while read DATW TIME DIR FTLE;doFILEPATH=${DIR}${FILE}rsync -az --delete --password-file=/etc/rsync.pass $SRC $DEST && echo "At ${TIME} on ${DATE}, file $FILEPATH was backupde up via rsync" >> /var/log/changlist.logsleep 1m

done#运行脚本

[root@centos8 ~]# chmod +x inotify_raync.sh

[root@centos8 ~]# nohup ./inotify_raync.sh &

测试

访问http://wordpress服务器ip,上传图片,查看是否会自动同步到备份服务器

未上传前备份服务器目录结构:

[root@centos7 ~]# tree /backup/wordpress/

/backup/wordpress/

└── 2019└── 12├── e3dc45e4c3110dd6-1.jpg├── e3dc45e4c3110dd6.jpg└── timg.jpg2 directories, 3 files

上传后目录结构:

[root@centos7 ~]# tree /backup/wordpress/

/backup/wordpress/

└── 2019└── 12├── e3dc45e4c3110dd6-1.jpg├── e3dc45e4c3110dd6.jpg├── timg.jpg└── u19673307884292725140fm26gp0.jpg2 directories, 4 files

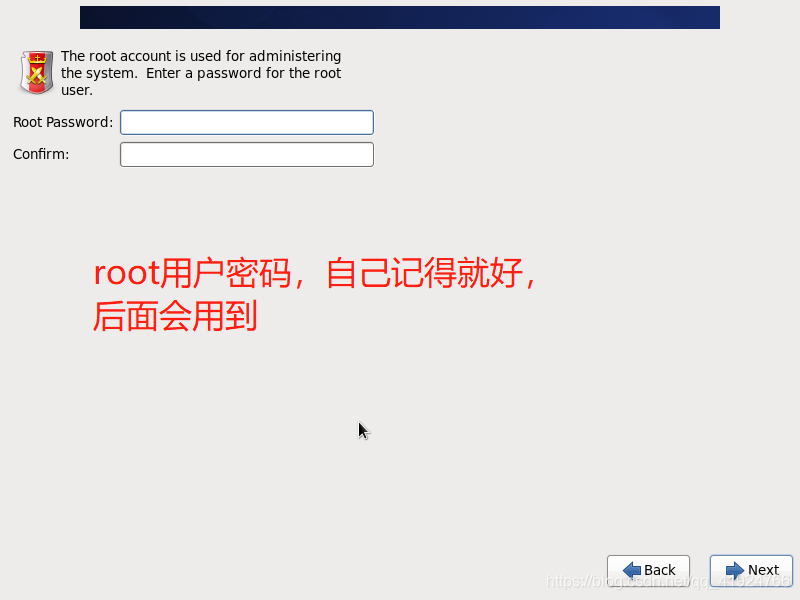

查看nfsinot脚本日志:

[root@centos8 ~]# cat /var/log/changlist.log

At 23:14 on , file /data/wordpress/2019/12/ was backupde up via rsync

At 23:14 on , file /data/wordpress/2019/12/ was backupde up via rsync

At 23:14 on , file /data/wordpress/2019/12/ was backupde up via rsync

自动备份成功