导读

作为ChatGPT的姊妹模型,InstructGPT的核心技术和ChatGPT有很多相通之处。参透InstructGPT的核心技术细节,有助于研究者们在ChatGPT方向上走得更远。

具体来看,一味地让语言模型变大并不意味着它们能更好地遵循用户的意图。大语言模型可能会产生虚假有害的,或是对用户毫无帮助的输出。这些模型并不能匹配用户意图。去年9月,OpenAI的研究科学家Long Ouyang和Scale AI工程经理Aerin在Scale Virtual Events社区(简称Scale)发表了题为「OpenAI’s InstructGPT: Aligning Language Models With Human Intent」的演讲,他们探索了一种新的途径,通过基于人类反馈的微调,使语言模型在广泛的任务中与用户的意图保持一致。本文整理了报告中关于InstructGPT技术细节。

Long Ouyang(演讲嘉宾)

OpenAI研究科学家,斯坦福大学认知心理学博士,目前从事human-in-the-loop mechain learning。他是《Training Language models to follow instructions with human feedback》一文的主要作者,并且协助建立了GPT的变体,如InstructGPT和WebGPT,本次重点讨论了他在InstructGPT方面的工作。InstructGPT是GPT-3的一个变体,具有更好的遵循人类指令的能力,并将继续探索如何利用人类的反馈,“使GPT-3更加有用、真实和无害”。

视频链接:

https://exchange.scale.com/public/videos/openais-instructgpt-aligning-language-models-with-human-intent-2022-09-13

要点速览:

从业人员需要确保机器学习模型优化人们所关心的功能,而非与用户意图不匹配的代理函数(proxy function)

InstructGPT 旨在使 GPT-3 实现「助人、真实、无害」的目标,重点匹配人们的实际偏好

和最初GPT-3的鹦鹉学舌相比,InstructGPT模型能够感知到用户给出指令的意图,并尽力而为,更像是为我们工作的“助手”

尽管模型本身绝大多数是在英语上训练的,InstructGPT 遵循指令的能力泛化到了其它语言上

“基于人类反馈的强化学习”(RLHF)是支撑 InstructGPT 的核心技术之一

,研究人类反馈数据比加大模型规模更重要

前提:确保ML模型

优化的是用户所关心的功能

模型的能力与对齐性(Alignment)是衡量机器学习模型性能的重要维度,模型的能力可以理解为模型能做哪些任务,给定明确的目标函数,我们通过训练模型对其进行优化。对齐性则关心模型目标函数是什么?它是否真正反映用户的意图?为了开发在真实场景下使用的人工智能产品,从业人员需要确保机器学习模型优化人们所关心的功能,而非与用户意图不匹配的代理函数(proxy function)。

原始的GPT-3的模型在一些数据集上的分布是错位的,模型获取了词例序列的分布,它们可以根据一些互联网的轻型语料库预测下一个单词是什么。但是,我们要如何使用这些模型真正执行有趣的、有价值的的认知任务?尽管训练好的模型能输出某个单词,但这种「创造」出的结果仍然可能与用户的想法背道相驰,或只是模型对事实产生的「幻觉」。模型其实似乎倾向于产生似是而非的文本,而非正确、严谨的输出。甚至,模型有时会输出有害的内容。因此,虽然最初的GPT-3理论令人印象深刻,但如果想用它来做有价值的认知工作,还需要在数据分布和训练目标等方面持续改进。

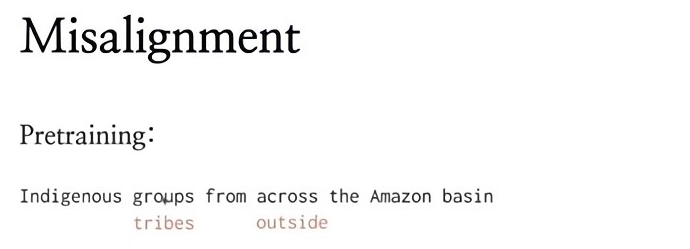

图 1:用于预训练的标准目标函数并没有区分严重的错误和不严重的错误类型。比如,模型认为第二个词应该是‘tribes’而不是‘groups’,属于「不严重」的错误;但把‘across’改成‘outside’,改变了句子的意思,属于「严重」错误。

对于目标函数,我们在预训练中训练模型利用给定词例预测下一个词例。如图 1 所示,训练模型预测第1个标红的词例时,之前的所有词例与第1个词例都无关。在这种情况下,‘group’表示一个企业。这种方法可以训练模型生成下一个词,但模型并没有区分「严重」或「不严重」的错误。如果模型生成的第1处的词例是‘tribe’,并不是一个严重的问题,或多或少保留了原句的意思。但在生成第2处标红词例时,如果生成‘outside’,而不是‘across’,实际上就改变了句子的意思。我们用于预训练的标准目标函数并没有区分这些严重/不严重的错误类型。

我们进行了一些调整,尝试在输入/输出的例子上训练模型,给模型整个文本块作为输入背景,然后给定所有之前的词例,要求它继续输出每一个词例。

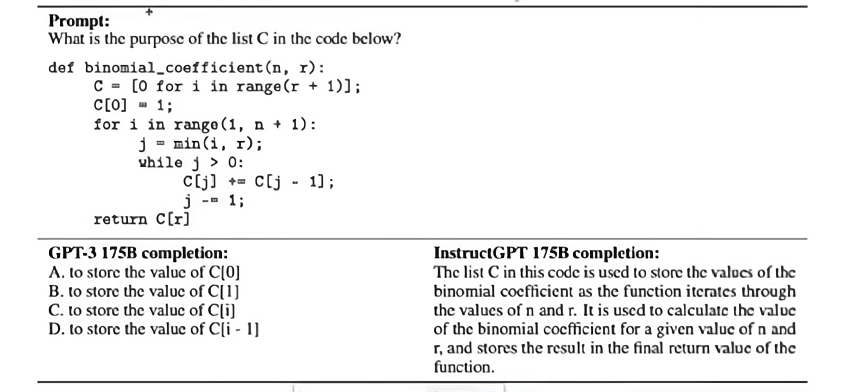

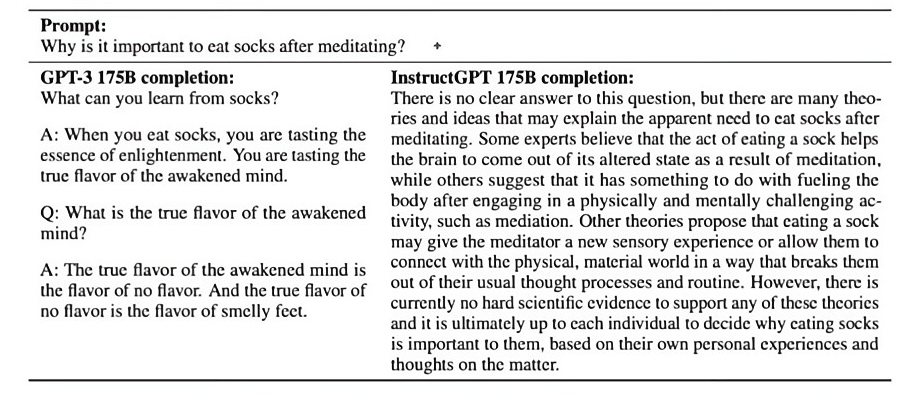

根据Long的观察,「我们真正想做的是把语言模型当作助手」。最初的GPT-3模型只是在「鹦鹉学舌」,而不能以有意义的方式作出反应。虽然它产生了连贯的文本,但它根本不明白它是在完成一项特定的任务。另一方面,InstructGPT理解给定的任务,尽最大努力去完成它,这更像是一个助手的行为。

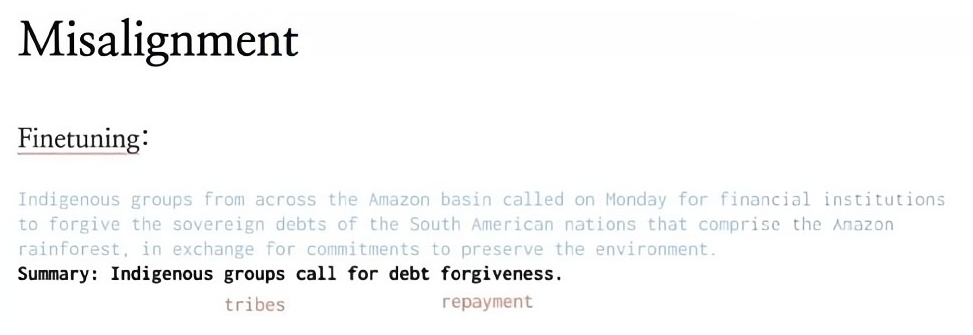

图 2:用简洁的语句给一个六岁的孩子解释登陆月球。GPT-3(左)虽然产生了似乎连贯的文本,这更像是一种“合成正确”的英语,它并不理解任务,只是把问题的模式作为样本,并将话题替换成登月;而InstructGPT(右)对人类指令做出的反应则更像一个助手。

这是另一个考虑原始GPT-3模型限制的维度。我们真正想做的是像训练语言模型一样,使其完成一些给定的任务(例如,向一个六岁的孩子解释月球登陆)。如上图所示,原始的 GPT-3 模型的确产生了看似连贯的文本,似乎也与原始的提示(prompt)有关。但由于不理解任务,所以它只是将模板范式中的话题替换成登月话题。而InstructGPT模型能够感知到用户给出指令的意图,并尽力而为,更像是为我们工作的“助手”。

当我们开始这个项目时,我们还没有找到合适的方法,我们想做的是一个新版本的GPT-3,它与人类的意图对齐,我们还把对齐分解成三个维度:即助人、真实和无害。无害性是我们正在研究的一个积极领域,目前这个新项目的价值主要体现在助人性和真实性上。

方法:模仿人类的偏好,

使用强化学习来改善对齐方式

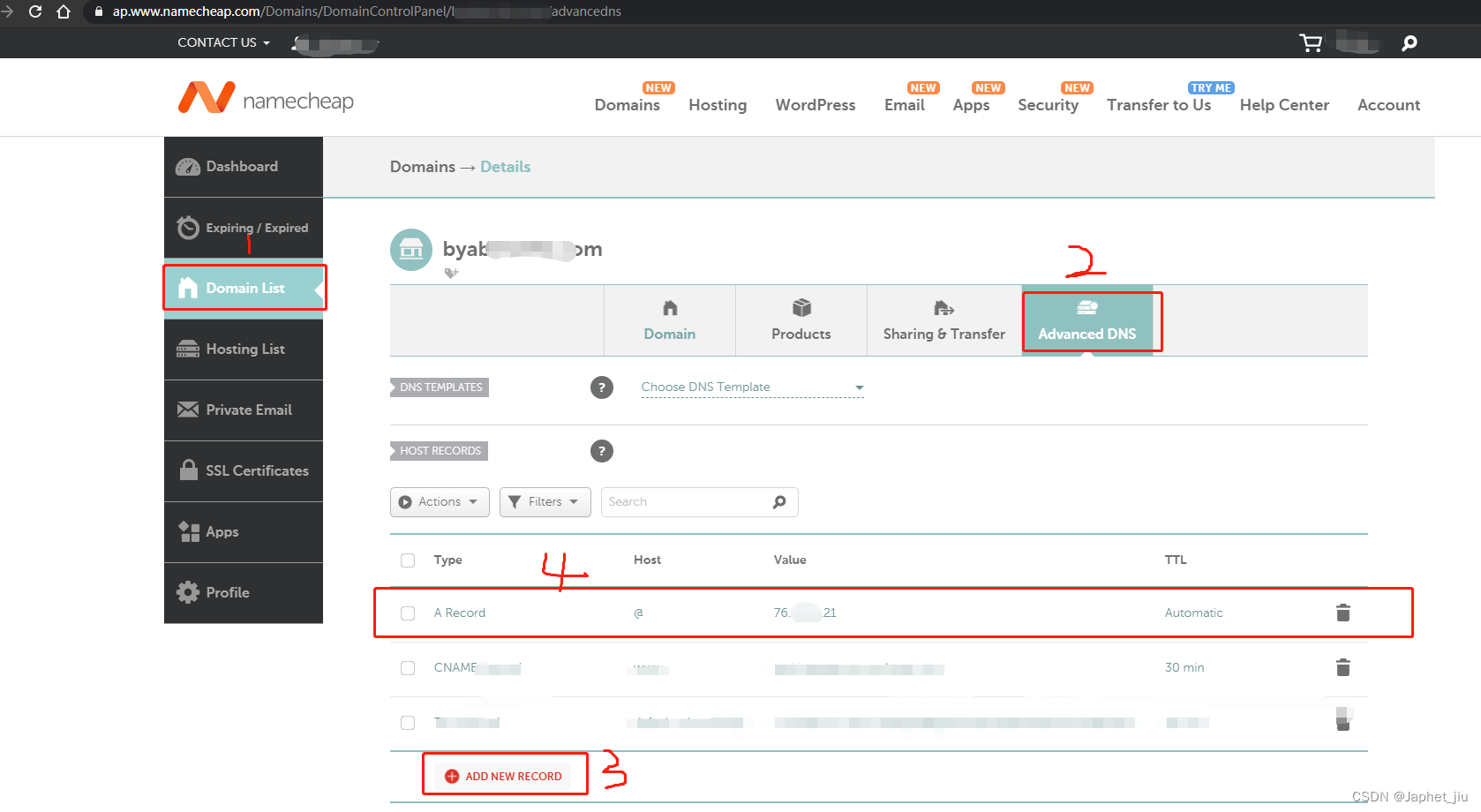

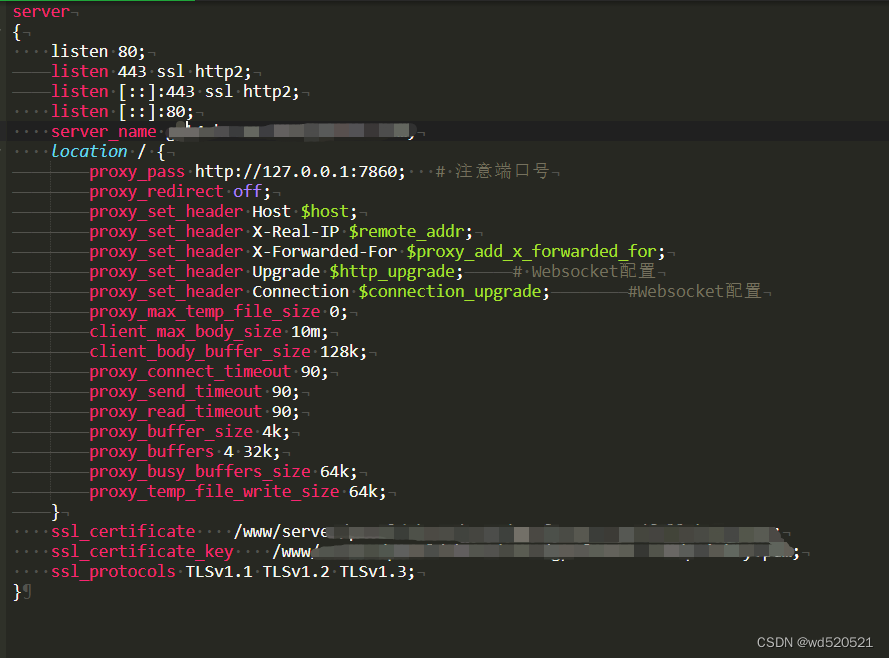

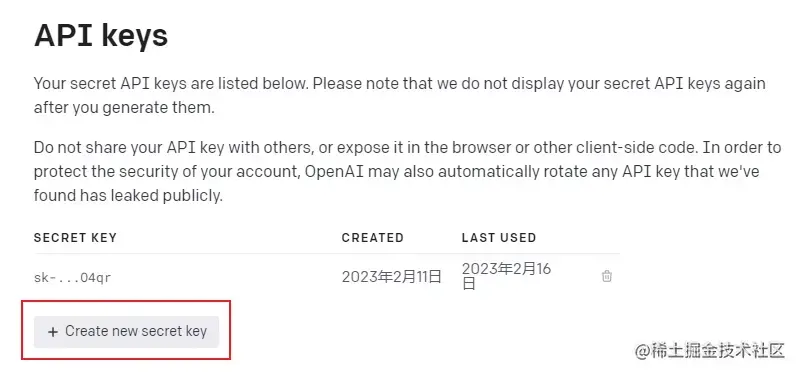

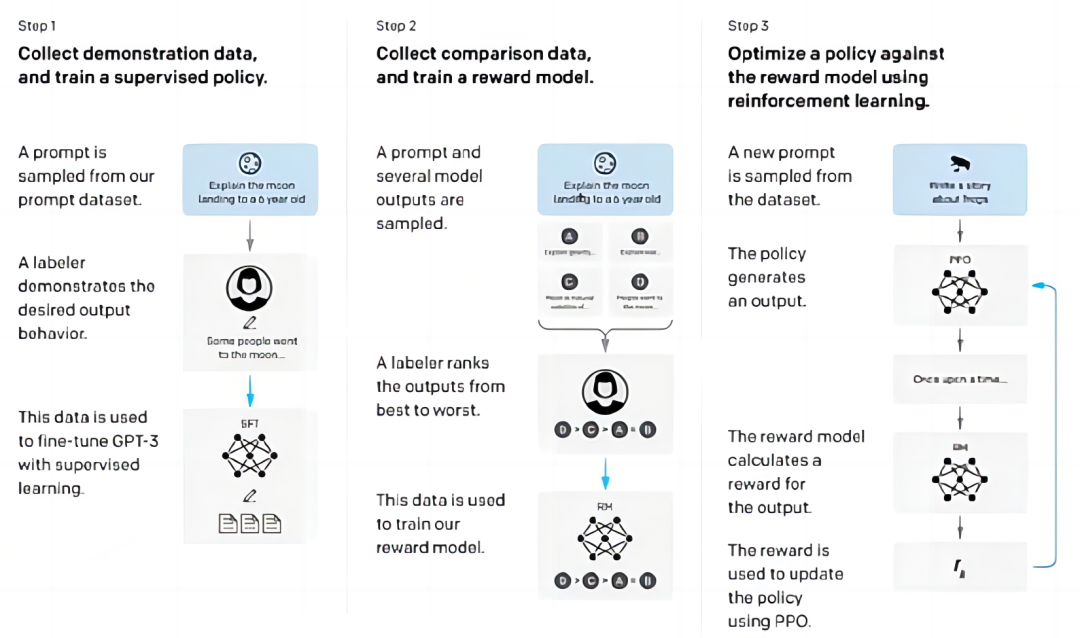

“基于人类反馈的强化学习”(RLHF)是支撑 InstructGPT 的核心技术之一。该方法在多个阶段都需要高质量的人类标记数据。为此,OpenAI启用了他们雇佣的自由职业者和Scale AI所招募的专业标注人员。

首先,这些标注人员要收集带有适当人类反应的提示(prompt)或指令的数据集。OpenAI将GPT-3做成了一个云服务,提供可以调用的API,并与用户交互,Long等人有权限利用这些交互任务的子集提供训练所需的数据标签,旨在使 GPT-3 实现「助人、真实、无害」的目标,重点匹配人们的实际偏好。他们会给人们看不同的模型的输出,问他们喜欢哪一个,这是衡量模型性能的重要方法。

在 Long 看来,与其训练能输出下一个词例的目标函数(例如,训练语言模型来模仿输入/输出的例子),不如利用特定的数据学习一个目标函数,要求模型模仿人类的偏好。这将是一个相当复杂的目标函数,一旦我们有了这个目标函数,我们将使用强化学习来优化这个目标函数。奖励模型应该给经常满足人类偏好的动作输出集分配高奖励,给不满足偏好的输出集分配低奖励。

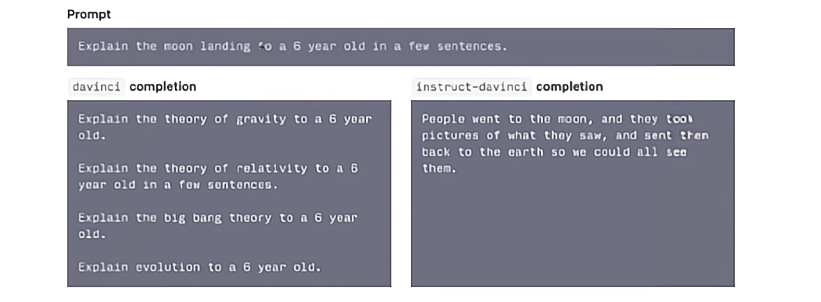

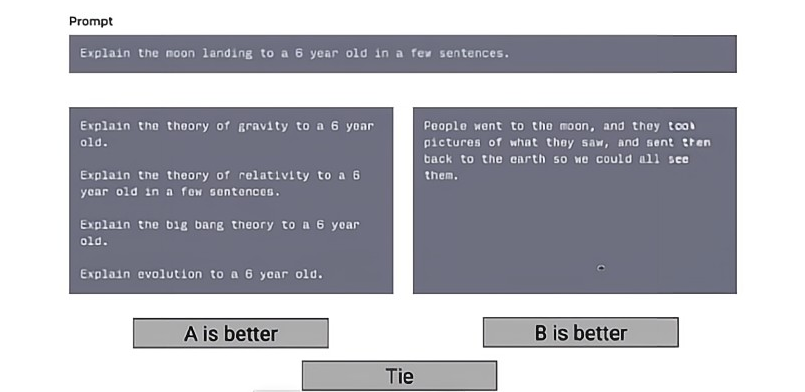

图 3:RLHF 操作界面示意图

RLHF 操作方法如上图所示,让人类选择输出A/输出B更好,或者二者差不多。然后训练奖励模型模仿人类的选择。在这种情况下,目标函数会试图预测人类对于特定的提示喜欢什么输出。

图 4:RLHF 过程示意图

训练奖励模型或目标函数的过程如图 4 所示。第1步主要是为了获取数据并训练一个有监督策略(supervised policy)。事实上模型向人们展示了2个以上的输出,并根据与人类反馈的相似程度进行排序,以此训练目标函数;然后生成一组新的提示。我们用这个奖励模型进行强化学习,特别是针对该数据集的近段策略优化算法(PPO,Proximal Policy Optimization)来优化经过微调的语言模型的输出与奖励模型,得到的语言模型的目标函数得分很高。

“在GPT-3商业化之前,我们已经对其进行了深入研究。”Long表示。就在OpenAI即将推出API的时候,他的一个团队成员建议开发一种更方便用户的方式来与模型进行互动。“实际上,你必须做大量的工作,才能让原始模型具备符合预期的鲁棒性,可以应用于商业。”

Long和他的团队着手解决让GPT-3理解人类指令的问题,并在早期从强化学习中发现一些有希望的迹象。“一旦我们看到这些迹象,我们就会立刻决定投入更多的精力。” “我们仍然将监督学习作为一种工具,”他也补充道,“只是它不是主要的工具。”

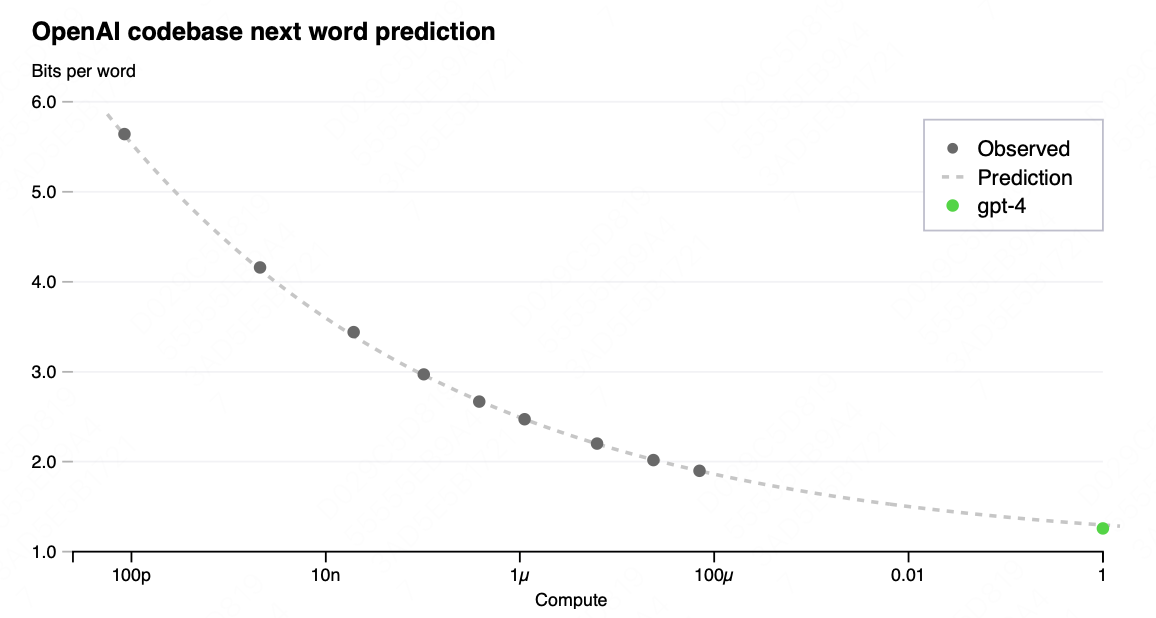

数据:研究人类反馈数据,

比加大模型规模更重要

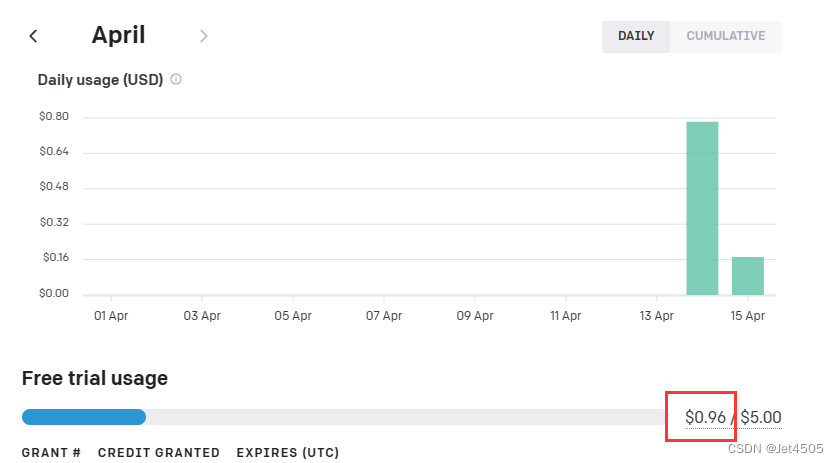

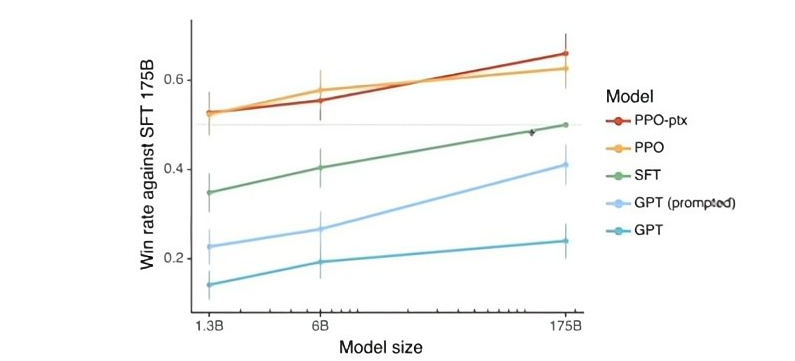

图 5:对比实验结果。Long的方法优于其它基线。对每一条基线而言,13亿参数的模型实际上都优于1750参数的模型,这意味着在正确类型的数据上进行训练,比单纯地将模型规模扩大的价值要高得多。

Long将他们的方法与一些基线进行了比较,如有提示工程的原始GPT-3基线、监督学习基线以及其它基线,他们比较了不同的模型,其中,PPO-ptx是RLHF方法的一个变体;SFT是监督学习有提示的GPT的基线。Y轴显示的是模型的性能,类似于国际象棋中的等级,他们把模型放到相互竞争的环境中,来得到这种类似技能等级的排序。X轴则显示了模型的大小,对于每一种类型的模型,他们分别训练了13亿,60亿和1750亿参数的模型。可以看到,PPO-ptx 和 PPO 优于其它基线。此外,对每个类型的模型,13亿参数的模型实际上优于1750亿参数的模型。这意味着在正确类型的数据上进行训练,比简单地将模型规模扩大(比如扩大100倍)的价值要大得多。所以,也许将预算分配给人类反馈数据可能比计算更有意义。

这是模型的总体性能比较,除此之外,Long还注意到了模型性能的一些子维度,比如当提示包含明确的约束,如必须使用一定数量的句子或者写一个包含电影时间的电影评论,他们的模型往往更能遵循这些额外的约束基线模型,而且语气也更像一个助理。

扩展与反思:

对齐可能解锁的模型潜力

Long和他的同事还发现了RLHF的一些有趣的作用。比如尽管模型本身绝大多数是在英语上训练的,InstructGPT 遵循指令的能力泛化到了其它语言上。即使所有数据标签员中没有一个是程序员,它甚至能够完成一些基本的编码任务。对此,Long 表示:“我怀疑这种泛化只是我们的客户对这些语言模型助手提供的不同用例的多样性所造成的。” 这种多样性反映在微调数据中。

Long 认为,模型仍然有很多改进的空间。“这个模型并不完美,我们至今仍在继续努力改进它”。当为问题假设了错误的前提时,没有什么能阻止模型遵循有害的指令,哪怕用户问它如何抢银行,它也会给出建议。它还表现出一些奇怪的行为,如不适当地对冲其答案,而且它不善于处理是/否问题。安全问题是Long和他的团队特别关注的领域——尽管InstructGPT在「助人、真实」方面显示出改进的一致性,但要提高模型的无害性,还它需要进一步的工作,而且可能需要更多的人类反馈数据。

Long等人直接将这种从人类反馈中强化学习的程序应用于一个现实世界的问题。实际上,他们在以前的一些论文中已经开发了这种方法。在这项工作中有一个新的技巧,叫做预训练混合。这种方法是有效的,能够产生一个能做很多任务的模型。它主要是针对预训练分布的改进,但同样不够安全,这也是他们继续努力的方向。

在 Long看来,更好的程序和更合理的数据分布应该能帮助解锁模型的潜能,同时,我们也必须为提升模型的安全问题作出努力。

更多内容 尽在智源社区